일반 소개

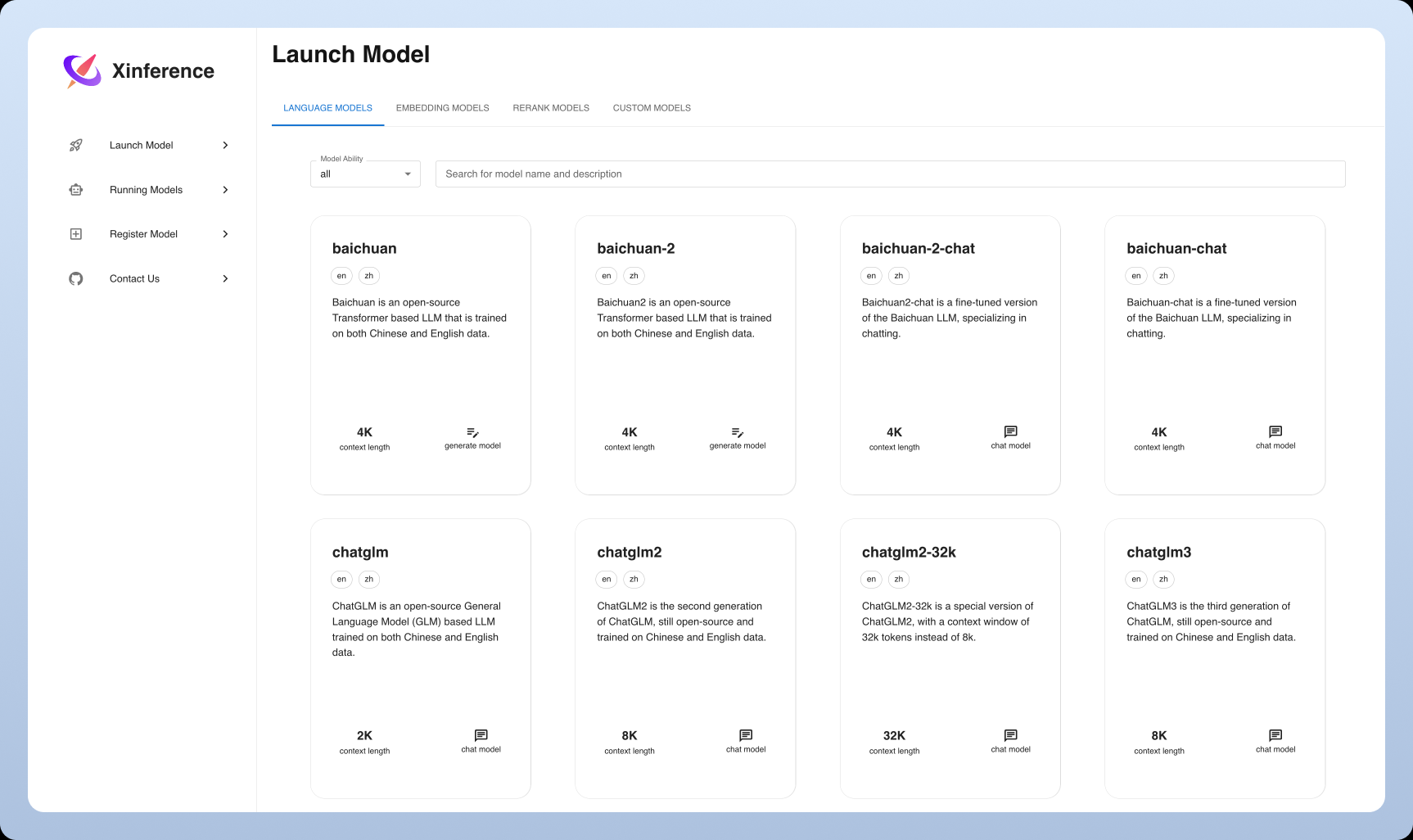

Xorbits Inference(줄여서 Xinference)는 언어 모델, 음성 인식 모델, 멀티모달 모델의 분산 배포 및 제공에 중점을 둔 강력하고 다재다능한 라이브러리입니다. 사용자는 단 한 번의 명령으로 자체 모델 또는 내장된 고급 모델을 손쉽게 배포하고 제공할 수 있습니다. 클라우드, 로컬 서버, 개인용 컴퓨터 등 어디에서든 Xorbits Inference는 효율적으로 실행됩니다. 이 라이브러리는 특히 연구자, 개발자, 데이터 과학자가 최첨단 AI 모델의 잠재력을 최대한 실현할 수 있도록 도와줍니다.

기능 목록

- 분산 배포분산 배포 시나리오를 지원하여 모델 추론 작업을 여러 디바이스 또는 머신에 원활하게 분산할 수 있습니다.

- 모델링 서비스대규모 언어 모델, 음성 인식 모델 및 멀티모달 모델을 제공하는 프로세스를 간소화합니다.

- 단일 명령으로 배포실험 환경과 프로덕션 환경 모두에 대해 단일 명령으로 모델을 배포하고 서비스합니다.

- 이기종 하드웨어 활용인텔리전스는 GPU와 CPU를 포함한 이기종 하드웨어를 활용하여 모델 추론 작업을 가속화합니다.

- 유연한 API 및 인터페이스모델과 상호 작용할 수 있는 여러 인터페이스를 제공하여 RPC, RESTful API(OpenAI API와 호환), CLI 및 WebUI를 지원합니다.

- 기본 제공 고급 모델사용자가 실험에 직접 사용할 수 있는 다양한 최신 오픈 소스 모델을 기본적으로 지원합니다.

도움말 사용

설치 프로세스

- 환경 준비파이썬 3.7 이상이 설치되어 있는지 확인합니다.

- Xorbits 추론 설치::

pip install xorbits-inference

- 설치 확인: 설치가 완료되면 다음 명령을 사용하여 설치가 완료되었는지 확인할 수 있습니다:

xinference --version

사용 가이드라인

배포 모델

- 모델 로드다음 명령을 사용하여 사전 학습된 모델을 로드합니다:

xinference load-model --model-name <模型名称>

예시:

xinference load-model --model-name gpt-3

- 서비스 시작: 모델을 로드한 후 서비스를 시작합니다:

xinference serve --model-name <模型名称>

예시:

xinference serve --model-name gpt-3

- API 호출하기서비스가 시작되면 RESTful API를 통해 호출할 수 있습니다:

curl -X POST http://localhost:8000/predict -d '{"input": "你好"}'

기본 제공 모델 사용

Xorbits Inference는 사용자가 직접 실험에 사용할 수 있는 다양한 고급 모델을 기본적으로 지원합니다. 예시:

- 언어 모델예: GPT-3, BERT 등

- 음성 인식 모델예: 딥스피치 등

- 멀티모달 모델예: CLIP 등

분산 배포

Xorbits Inference는 분산 배포를 지원하므로 사용자는 모델 추론 작업을 여러 기기나 머신에 원활하게 배포할 수 있습니다. 단계는 아래에 설명되어 있습니다:

- 분산 환경 구성각 노드에 Xorbits Inference를 설치하고 네트워크 연결을 구성합니다.

- 분산 서비스 시작마스터 노드에서 분산 서비스를 시작합니다:

xinference serve --distributed --nodes <节点列表>

예시:

xinference serve --distributed --nodes "node1,node2,node3"

- 분산 API 호출하기단일 노드 배포와 마찬가지로 RESTful API를 통해 호출됩니다:

curl -X POST http://<主节点IP>:8000/predict -d '{"input": "你好"}'

일반적인 문제

- 모델을 업데이트하려면 어떻게 하나요? 다음 명령을 사용하여 모델을 업데이트합니다:

xinference update-model --model-name <模型名称>

- 로그를 보려면 어떻게 하나요? 서비스 로그를 보려면 다음 명령을 사용하세요:

xinference logs --model-name <模型名称>© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...