SmolVLM은 이미지와 텍스트의 모든 조합에서 입력을 받아 텍스트 출력을 생성하는 매개변수 수가 20억 개에 달하는 소규모 멀티모달 모델입니다.

지난 7월 경량 언어 모델인 SmolLM을 출시한 데 이어, 이번 주에는 AI 앱 개발 플랫폼 허깅페이스가 경량과 고성능에 초점을 맞춘 경량 멀티모달 모델인 SmolVLM을 출시하여 소형 언어 모델 라인에 추가했습니다.

SmolVLM은 20억 개의 레퍼런스를 보유한 소형 멀티모달 모델로, 동급 최고의 성능(최첨단, SOTA)을 자랑하는 것으로 알려져 있습니다. 이미지와 텍스트의 모든 조합을 입력으로 받아들일 수 있지만 경량 모델로서 텍스트 출력만 생성하며, 이미지에 대한 질문에 답하거나 이미지의 내용을 설명하거나 여러 이미지를 기반으로 스토리를 전달하거나 순전히 언어 모델로 사용할 수 있는 것이 SmolVLM입니다. 개발팀에 따르면 SmolVLM은 멀티모달 작업을 잘 수행하면서도 기기에서 실행하기에 적합한 경량 아키텍처를 기반으로 합니다.

SmolVLM의 아키텍처는 이전에 소개한 허깅 페이스의 비전 모델인 IDEFICS 3을 기반으로 하며, 심지어 트랜스포머 구현 방식은 동일합니다. 하지만 허깅 페이스를 사용하는 것은 IDEFICS 몇 가지 개선이 이루어졌습니다. 첫째, 언어 모델의 핵심이 Llama 3.1 8B에서 SmolLM2 1.7B로 교체되었습니다. 둘째, SmolVLM은 픽셀 셔플 전략과 시각적 효과를 위한 더 큰 패치 등 고급 이미지 압축 기법을 사용합니다. 토큰 코딩을 사용하여 코딩 효율성이 향상되고 추론 속도가 빨라지며 메모리 사용량이 줄어듭니다.

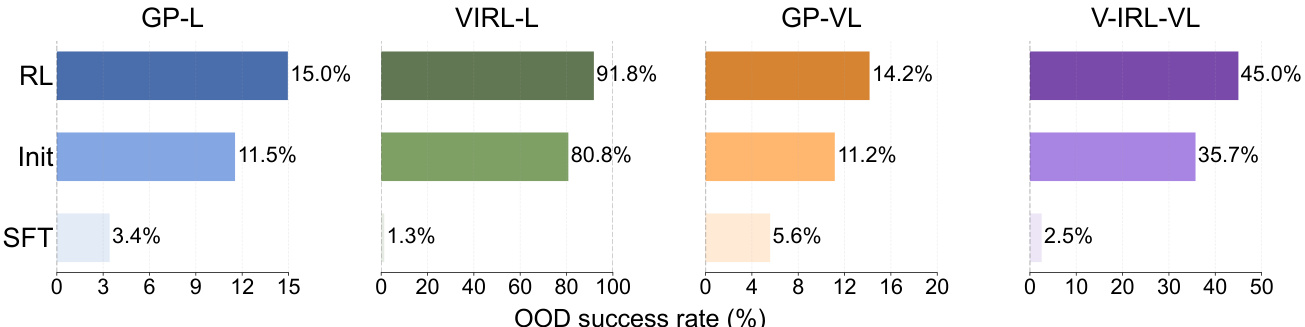

Hugging Face는 SmolVLM의 효율성과 메모리 사용량 이점을 강조하고 동등한 파라메트릭 모델과의 비교 테스트 데이터를 게시합니다. SmolVLM은 다중 모드 이해력, 추론, 수학 및 텍스트 이해력에서 InternVL2, PaliGemma, MM1.5, moondream 및 MiniCPM-V-2와 같은 모델보다 성능이 뛰어납니다. 또한 GPU 메모리 사용 효율성 측면에서도 대부분의 모델을 능가합니다. Alibaba의 Qwen2-V2와 비교했을 때, SmolVLM은 3.3~4.5배 빠른 사전 입력 처리량과 7.5~16배 높은 생성 처리량을 제공합니다.

허깅페이스는 미세 조정을 위한 SmolVLM-Base, 합성 데이터 세트에 기반한 미세 조정을 위한 SmolVLM-Synthetic, 최종 사용자 상호 작용을 위한 명령어 미세 조정 버전인 SmolVLM Instruct 등 세 가지 모델 버전의 SmolVLM 제품군을 출시했습니다. 모든 모델 체크포인트, 트레이닝 데이터세트, 트레이닝 방법 및 도구는 Apache 2.0을 기반으로 합니다.오픈 소스 라이선스.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...