일반 소개

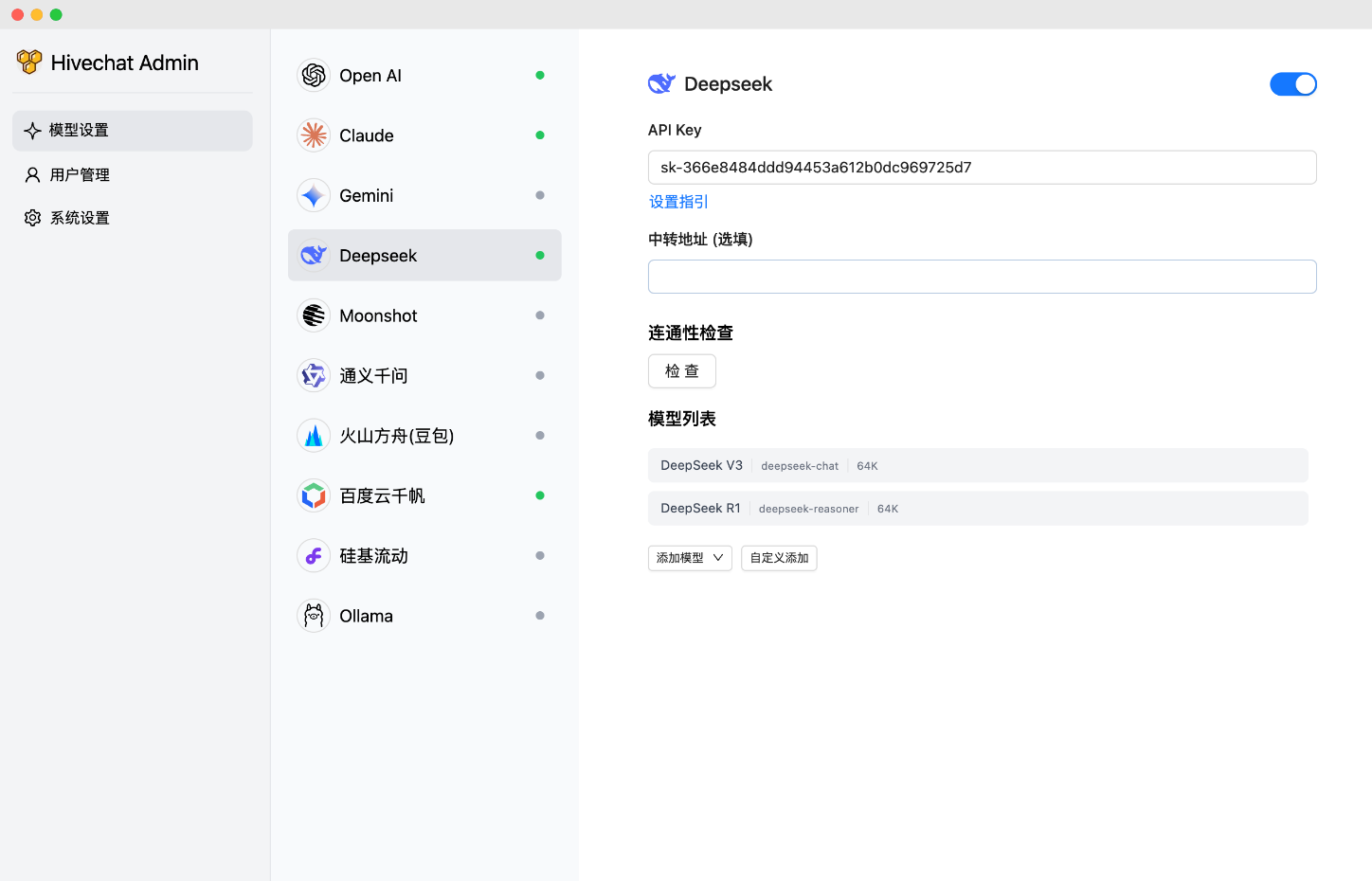

하이브챗은 중소규모 팀을 위한 AI 챗봇으로, 관리자가 여러 AI 모델(예: 딥서치, OpenAI, 클로드, 제미니)을 한 번에 구성하여 팀원들이 쉽게 사용할 수 있도록 지원합니다. 라텍스 및 마크다운 렌더링, 딥시크 추론 체인 표시, 이미지 이해, AI 에이전트 및 클라우드 데이터 저장소를 제공하며 10개의 대형 모델 제공업체를 지원합니다. 이 프로젝트는 Next.js, Tailwindcss, PostgreSQL 기술 스택을 사용하며 로컬로 배포하거나 Vercel 및 Docker를 통해 배포할 수 있습니다.

기능 목록

- 지원되는 AI 모델: 하이브챗은 딥시크, OpenAI, 클로드, 제미니, 문샷, 볼케이노 엔진 아크, 알리 바이리안(첸웬), 바이두 첸판, 올라마 등의 AI 모델을 지원합니다. 실리콘 플로우 글로벌화된 팀을 위한 국내 및 국제 주류 옵션을 포함한 10개의 대규모 모델 제공업체가 있습니다.

- 렌더링 및 표시: 기술 문서를 다루는 팀에게 편리한 LaTeX 및 마크다운 렌더링을 지원하며, DeepSeek 추론 체인 표시 기능은 사용자가 AI의 추론 과정을 이해하는 데 도움이 됩니다.

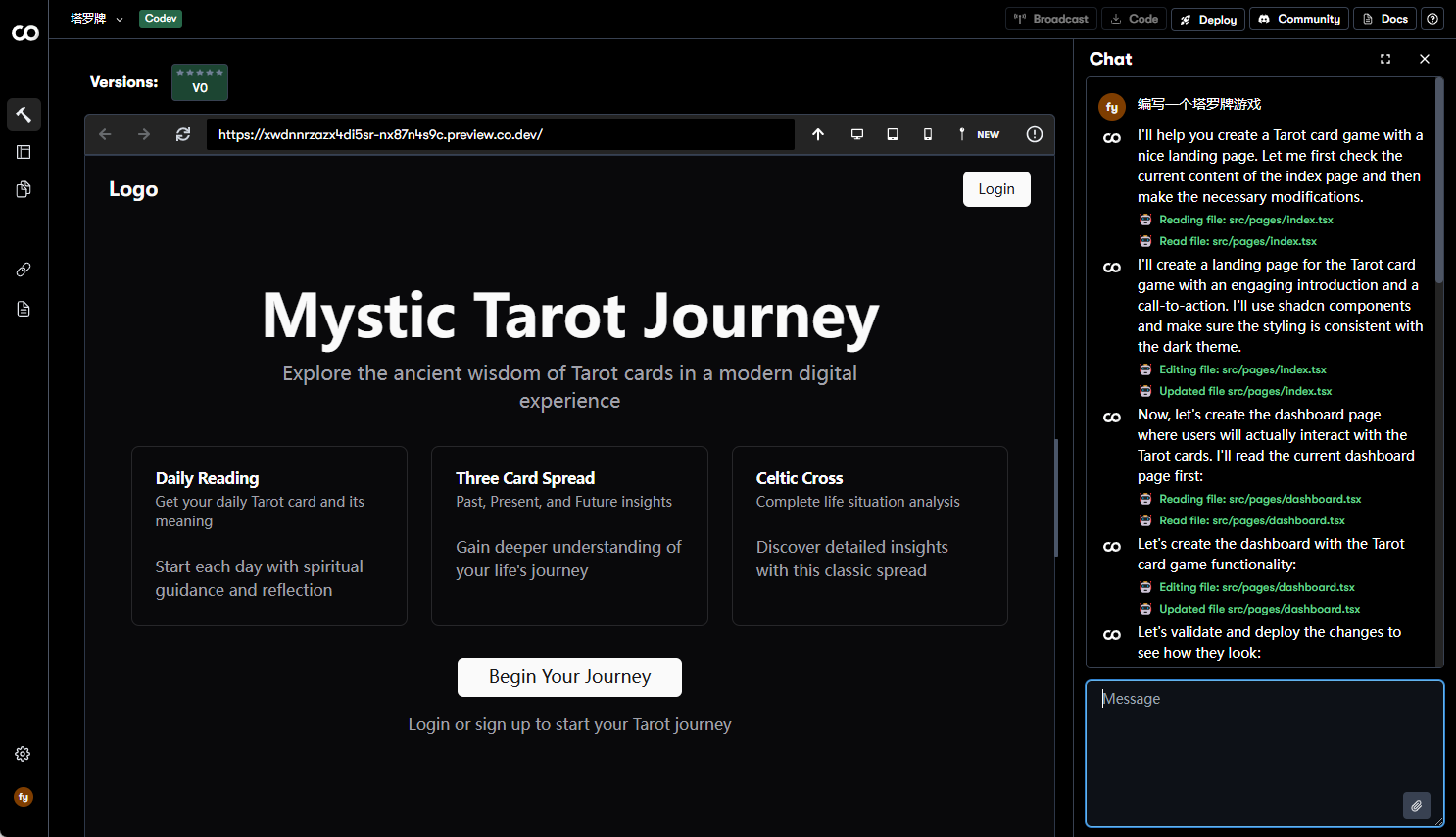

- 멀티미디어 지원: 이미지 이해 기능으로 시각 관련 작업을 처리하는 데 적합합니다.

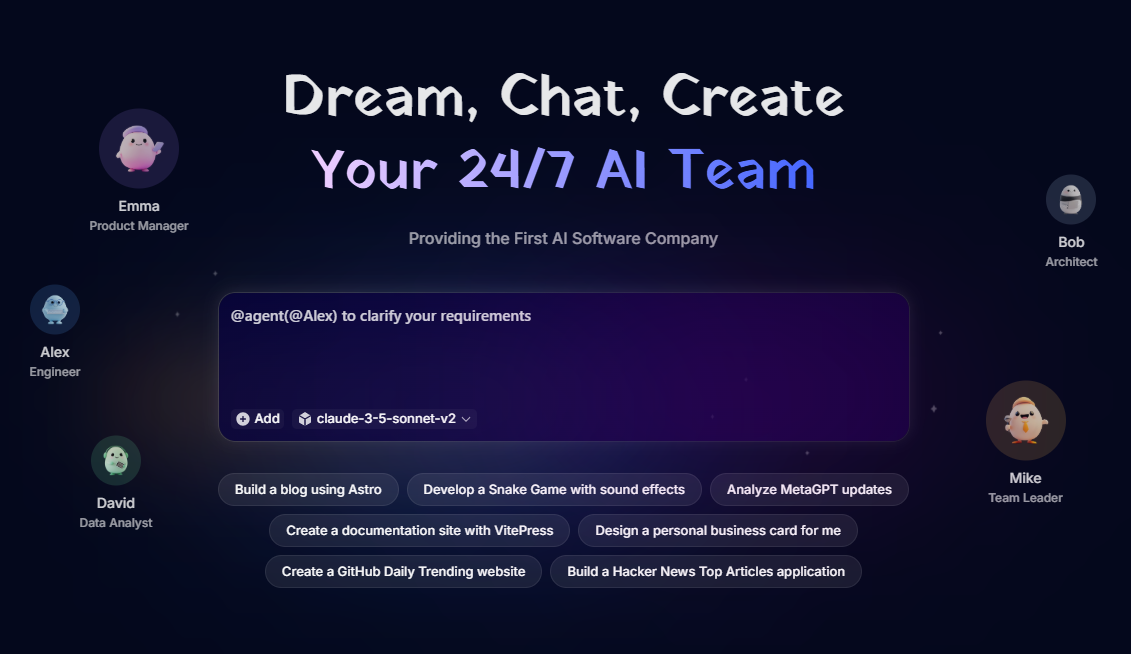

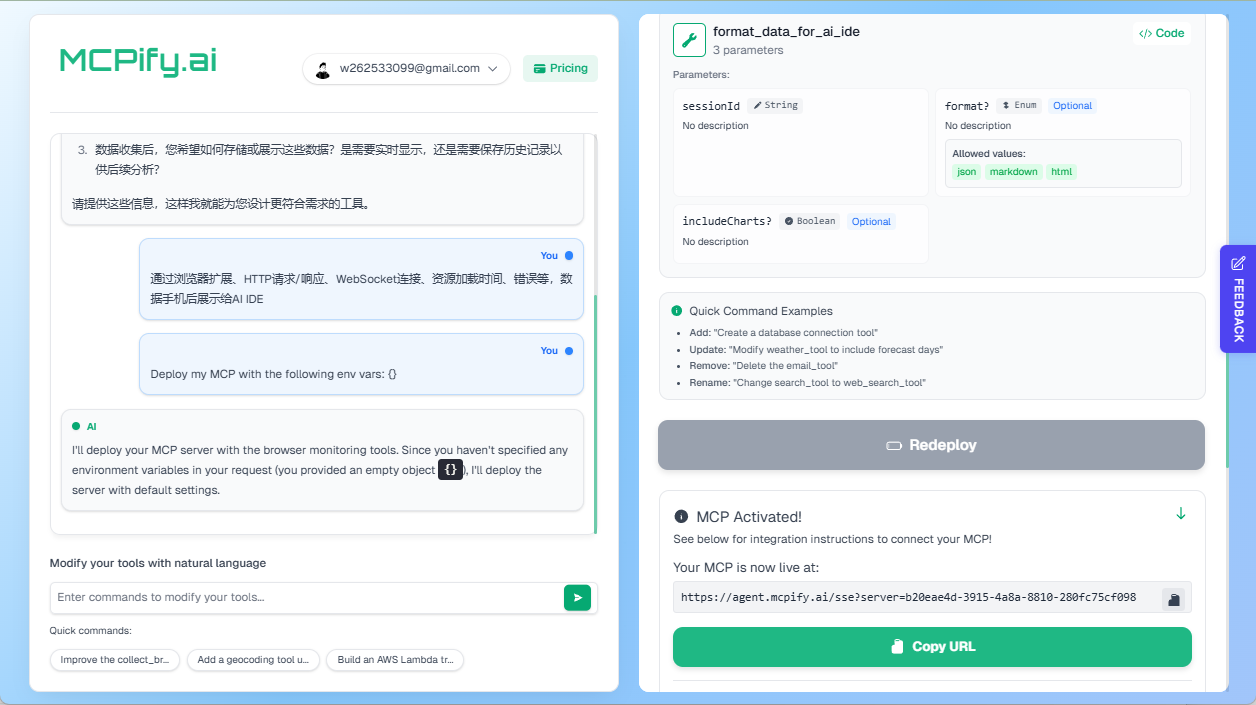

- AI 에이전트: 향상된 자동화 기능을 위해 AI 에이전트 기능을 통합합니다.

- 데이터 관리: 팀 데이터를 안전하고 영구적으로 보관할 수 있는 클라우드 데이터 저장소를 제공합니다.

도움말 사용

기술 스택 및 배포 옵션

HiveChat은 다음과 같은 최신 프런트엔드 및 백엔드 기술 스택을 사용합니다:

| skill | 설명 |

|---|---|

| Next.js | 의 서버 측 렌더링을 빌드하는 데 사용되는 React 어플라이언스 |

| Tailwindcss | 빠른 CSS 프레임워크 제공 |

| Auth.js | 사용자 인증 처리 |

| PostgreSQL | 데이터 저장소가 지원되는 관계형 데이터베이스 |

| 이슬비 ORM | 데이터베이스 운영 ORM 도구 |

| 앤트 디자인 | 사용자 경험을 향상시키는 UI 컴포넌트 라이브러리 |

배포 옵션에는 로컬 배포, Docker 배포, Vercel 배포가 있습니다:

- 로컬 배포사용자는 리포지토리를 복제하고, 리포지토리를 실행해야 합니다.

npm install종속성 설치.npm run initdb데이터베이스를 초기화합니다.npm run dev개발 환경 시작하기.npm run build노래로 응답npm run start프로덕션 환경에서 사용하세요. - 도커 배포리포지토리 복제, 실행

docker compose build노래로 응답docker compose up -d컨테이너화된 서비스를 시작할 수 있습니다. - 버셀 배포통해 Vercel 배포 링크 원클릭 배포를 위해서는 DATABASE_URL, AUTH_SECRET 및 ADMIN_CODE와 같은 환경 변수를 구성해야 합니다.

배포가 완료되면 관리자는 http://localhost:3000/setup(또는 실제 도메인/포트)를 방문하여 관리자 계정을 설정해야 합니다.

자세한 도움말

하이브챗을 빠르게 시작할 수 있도록 자세한 설치 및 사용 프로세스는 다음과 같습니다:

설치 프로세스

- 클론 창고::

- 터미널을 열고 다음 명령을 실행하여 GitHub 리포지토리를 복제합니다:

git clone https://github.com/HiveNexus/HiveChat.git cd HiveChat

- 터미널을 열고 다음 명령을 실행하여 GitHub 리포지토리를 복제합니다:

- 배포 방법 선택::

- 로컬 배포::

- Node.js 및 PostgreSQL이 설치되어 있는지 확인합니다.

- 움직여야 합니다.

npm install종속성을 설치합니다. - 구성

.env파일에서 다음 환경 변수를 설정합니다:DATABASE_URL=postgres://postgres:password@localhost/hivechat(실제 데이터베이스 연결로 대체해야 함, 예: 로컬 PostgreSQL).AUTH_SECRET사용openssl rand -base64 3232비트 무작위 문자열을 생성합니다.ADMIN_CODE관리자 인증 코드를 설정합니다(예는 다음과 같습니다).22113344로 설정된 경우 사용자 지정 값으로 대체하는 것이 좋습니다.NEXTAUTH_URL=http://127.0.0.1:3000(테스트 환경은 기본값을 유지할 수 있으며, 프로덕션 환경은 공식 도메인 이름으로 변경해야 함).

- 움직여야 합니다.

npm run initdb데이터베이스를 초기화합니다. - 개발 환경 실행

npm run dev프로덕션 환경 운영npm run build엠프레스npm run start.

- 도커 배포::

- Docker 및 Docker Compose가 설치되어 있는지 확인합니다.

- 움직여야 합니다.

docker compose build미러 이미지를 구축합니다. - 움직여야 합니다.

docker compose up -d컨테이너를 시작합니다. - 환경 변수 구성은 로컬 배포와 동일하며, 환경 변수는

docker-compose.yml에서 지정합니다.

- 버셀 배포::

- 인터뷰 Vercel 배포 링크.

- 메시지에 따라 DATABASE_URL, AUTH_SECRET 및 ADMIN_CODE를 구성합니다.

- 배포를 클릭하고 Vercel이 빌드를 완료할 때까지 기다립니다.

- 로컬 배포::

- 관리자 초기화::

- 배포가 완료되면 http://localhost:3000/setup(로컬 배포) 또는 실제 도메인 이름으로 이동하여 ADMIN_CODE를 입력하여 관리자 계정을 설정합니다.

사용법

- 관리자 작업::

- 로그인하여 관리자 대시보드로 이동하여 AI 모델 공급자(예: OpenAI API 키 등)를 구성할 수 있습니다.

- 사용자를 수동으로 추가하거나 등록을 활성화하여 모든 사용자 계정을 관리합니다.

- 팀 사용량 통계를 확인하고 모델 구성을 조정하여 성능을 최적화하세요.

- 일반 사용자 조작::

- 로그인하여 텍스트 입력 및 멀티미디어 업로드(예: 이미지)를 지원하는 채팅 인터페이스에 액세스합니다.

- 기술 토론을 위해 라텍스와 마크다운을 사용하여 채팅 형식을 지정하세요.

- 다른 AI 모델 선택(예 Deepseek 또는 클로드)와 대화를 나누고 딥서치 추론 체인을 확인하여 AI 의사 결정 과정을 이해할 수 있습니다.

- 데이터는 클라우드에 자동으로 저장되므로 언제든지 세션 기록을 확인할 수 있습니다.

- 주요 기능 작동::

- 그래픽 이해이미지를 업로드하면 AI가 콘텐츠를 분석하고 설명을 생성하여 제품 디자인 또는 데이터 분석 팀에 적합합니다.

- AI 에이전트설정을 통해 보고서 생성이나 자주 묻는 질문에 대한 답변과 같은 특정 작업을 자동화할 수 있습니다.

- 클라우드 데이터 스토리지모든 채팅과 설정은 클라우드에 저장되며 팀원들이 여러 기기에서 액세스할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...