AI 벤치마킹과 AI 연구소의 결과 발표 방식에 대한 논쟁이 점점 더 대중화되고 있습니다. AI 성능은 오랫동안 논란의 여지가 있는 방식으로 측정되고 보고되어 왔으며, 이제 이러한 막후 논쟁이 마침내 주목을 받고 있습니다.

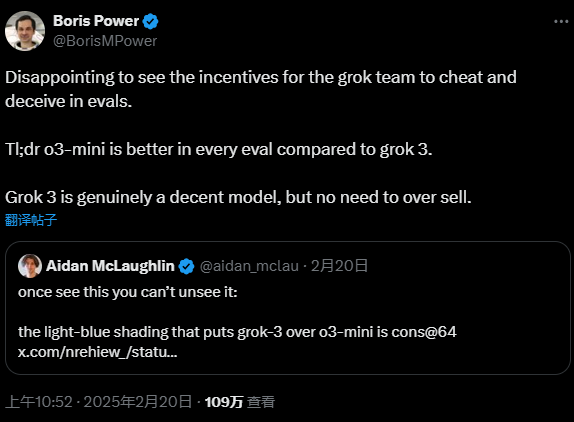

이번 주에 한 OpenAI 직원이 Elon Musk가 설립한 AI 회사인 xAI가 최신 AI 모델을 홍보하기 위해 잘못된 벤치마크 결과를 발표했다고 공개적으로 비난했습니다. Grok 3. xAI의 공동 창립자 중 한 명인 이고르 바부쉬킨은 이러한 비난에 즉각 대응하여 xAI의 접근 방식에는 아무런 문제가 없다고 주장했습니다. 공개적인 논쟁을 통해 AI 성능 평가의 투명성 문제가 다시금 수면 위로 떠오른 것은 분명합니다.

그러나 진실은 아마도 양측의 주장 사이 어딘가에 있을 것입니다. 기술 분야의 많은 분쟁과 마찬가지로 진실은 종종 표면 아래에 숨어 있으며 더 깊이 파고들고 면밀히 조사해야 합니다.

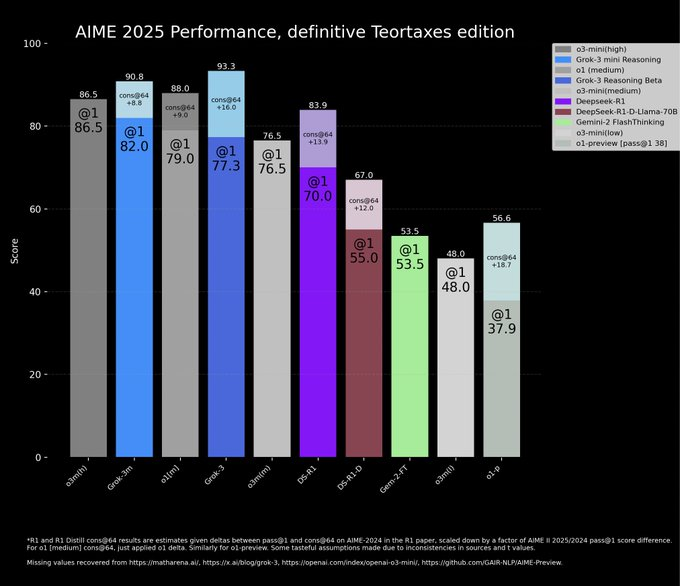

xAI는 공식 블로그에 올린 포스팅에서 AIME 2025 벤치마크에서 Grok 3의 우수한 성능을 보여주는 차트를 소개했습니다. AIME 2025는 최근 치러진 고난도 초청 수학 시험의 문제 모음으로, AI의 수학적 능력을 가늠하는 리트머스 시험으로 여겨집니다. 그러나 전문가들은 AI 벤치마크로서 AIME의 타당성에 대해 오랫동안 의문을 제기해 왔다는 점에 주목할 필요가 있습니다. 모델 역량을 입증하기 위해 논란이 많은 벤치마크를 선택한 xAI의 의도가 무엇인지 살펴보는 것은 흥미로울 수 있습니다. 그럼에도 불구하고 AIME 2025와 그 이전 버전은 여전히 AI 모델의 수학적 추론을 평가하는 데 널리 사용되고 있습니다.

xAI는 차트에서 Grok 3의 두 버전인 Grok 3 Reasoning Beta와 Grok 3 mini Reasoning이 AIME 2025 테스트에서 OpenAI의 현재 최신 모델인 o3-mini-high보다 성능이 뛰어났다고 주장했습니다. 그러나 OpenAI의 직원들은 X 플랫폼에서 xAI의 차트에 다음과 같은 중대한 결함이 있다고 빠르게 지적했습니다. 에 심각한 결함이 있다고 지적했습니다. 바로 '단점@64' 조건에서 o3-mini-high의 AIME 2025 테스트 점수가 누락되었다는 점입니다. 이렇게 데이터를 선별적으로 제시하는 것은 xAI의 의도에 대한 의문을 제기합니다.

"컨센서스@64가 정확히 무엇인가요?"라고 질문하실 수도 있습니다. 간단히 말해, "consensus@64"의 약자로 특별한 종류의 평가 방법입니다. 이 방식에서는 모델이 벤치마크 테스트의 각 질문에 대해 64번의 답변을 시도하고 가장 빈번한 답변이 최종 답변이 됩니다. 당연히 "cons@64" 메커니즘은 모델의 벤치마크 점수를 크게 향상시키는 경향이 있습니다. xAI는 그래프에서 "cons@64" 데이터를 의도적으로 생략하여 Grok 3가 다른 모델보다 성능이 뛰어난 것처럼 보일 수 있지만, 실제로는 그렇지 않을 수 있습니다. 이 "까다로운" 접근 방식은 공정한 게임이 아닐까요?

실제 데이터를 살펴보면, Grok 3 추론 베타 및 Grok 3 미니 추론 모두 실제로 "@1" 조건, 즉 모델이 벤치마크에서 처음 점수를 시도할 때 AIME 2025에서 o3-mini-high보다 낮은 점수를 기록했습니다. 심지어 Grok 3 추론 베타 점수는 OpenAI의 o1 모델("중간" 연산으로 설정)보다 약간 앞섰습니다. 그러나 이러한 종류의 데이터 비교에도 불구하고 xAI는 여전히 Grok 3를 "세계에서 가장 똑똑한 AI"라고 광고하고 있습니다. 이러한 홍보 전략은 엄밀한 과학적 증거에 기반한 것이 아니라 시장의 관심을 끌기 위한 마케팅 전략에 가깝습니다. AI 기술이 빠르게 변화하는 이 시기에 현실적인 기술 진보를 이루는 것이 더 중요할까요, 아니면 과장된 마케팅 과대 광고를 통해 미래를 선점하는 것이 더 중요할까요? 이는 AI 업계 전체가 진지하게 고민해야 할 질문일 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...

![ICLR 惊现[10,10,10,10]满分论文,ControlNet作者新作——IC-Light V2适配Flux](https://aisharenet.com/wp-content/uploads/2024/12/8989dba3bb6d866.png)