GPUStack: 대규모 언어 모델을 실행하고 LLM을 위한 공통 추론 서비스를 빠르게 통합하기 위해 GPU 클러스터를 관리합니다.

일반 소개

GPUStack은 대규모 언어 모델(LLM)을 실행하기 위해 설계된 오픈 소스 GPU 클러스터 관리 도구입니다. Apple MacBook, Windows PC, Linux 서버 등 다양한 하드웨어를 지원하며, 증가하는 컴퓨팅 수요에 맞춰 GPU와 노드 수를 쉽게 확장할 수 있습니다. GPUStack은 분산 추론 기능을 제공하고, 단일 노드 멀티 GPU 및 멀티 노드 추론과 서비스를 지원하며, OpenAI API와 호환되어 사용자 및 API 키 관리와 GPU 성능 및 사용률의 실시간 모니터링을 간소화합니다. OpenAI API와 호환되며, 사용자 및 API 키 관리를 간소화하고, GPU 성능과 사용률을 실시간으로 모니터링합니다. 경량 Python 패키지 설계로 종속성과 운영 오버헤드를 최소화하여 개발자와 연구자에게 이상적입니다.

기능 목록

- 다양한 하드웨어 지원: 애플 메탈, 엔비디아 쿠다, 어센드 캔, 무어 스레드 MUSA 등과 호환됩니다.

- 분산 추론: 단일 노드 멀티 GPU 및 멀티 노드 추론과 서비스를 지원합니다.

- 다중 추론 백엔드: llama-box(llama.cpp) 및 vLLM 지원.

- 경량 Python 패키지: 종속성 및 운영 오버헤드 최소화.

- OpenAI 호환 API: OpenAI 표준과 호환되는 API 서비스를 제공합니다.

- 사용자 및 API 키 관리: 사용자 및 API 키 관리를 간소화합니다.

- GPU 성능 모니터링: GPU 성능과 사용률을 실시간으로 모니터링합니다.

- 토큰 사용량 및 요금 모니터링: 토큰 사용량과 요금 제한을 효율적으로 관리합니다.

도움말 사용

설치 프로세스

Linux 또는 MacOS

- 터미널을 엽니다.

- 다음 명령을 실행하여 GPUStack을 설치합니다:

curl -sfL https://get.gpustack.ai | sh -s -

- 설치 후 GPUStack은 시스템d 또는 런치드 시스템에서 서비스로 실행됩니다.

Windows(컴퓨터)

- 관리자로 PowerShell을 실행합니다(PowerShell ISE 사용은 피하세요).

- 다음 명령을 실행하여 GPUStack을 설치합니다:

Invoke-Expression (Invoke-WebRequest -Uri "https://get.gpustack.ai" -UseBasicParsing).Content

사용 가이드라인

초기 설정

- GPUStack UI에 액세스: 브라우저에서 열기

http://myserver. - 기본 사용자 아이디 사용

admin와 로그인할 초기 비밀번호를 입력합니다. 초기 비밀번호를 얻는 방법:- Linux 또는 MacOS: 실행

cat /var/lib/gpustack/initial_admin_password. - Windows: 실행 중

Get-Content -Path "$env:APPDATA\gpustack\initial_admin_password" -Raw.

- Linux 또는 MacOS: 실행

API 키 만들기

- GPUStack UI에 로그인한 후 탐색 메뉴에서 "API 키"를 클릭합니다.

- "새 API 키" 버튼을 클릭하고 이름을 입력한 후 저장합니다.

- 생성된 API 키를 복사하여 올바르게 저장합니다(생성 시에만 표시됨).

API 사용

- 환경 변수 설정하기:

export GPUSTACK_API_KEY=myapikey

- curl을 사용하여 OpenAI 호환 API에 액세스하세요:

curl http://myserver/v1-openai/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $GPUSTACK_API_KEY" \

-d '{

"model": "llama3.2",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

],

"stream": true

}'

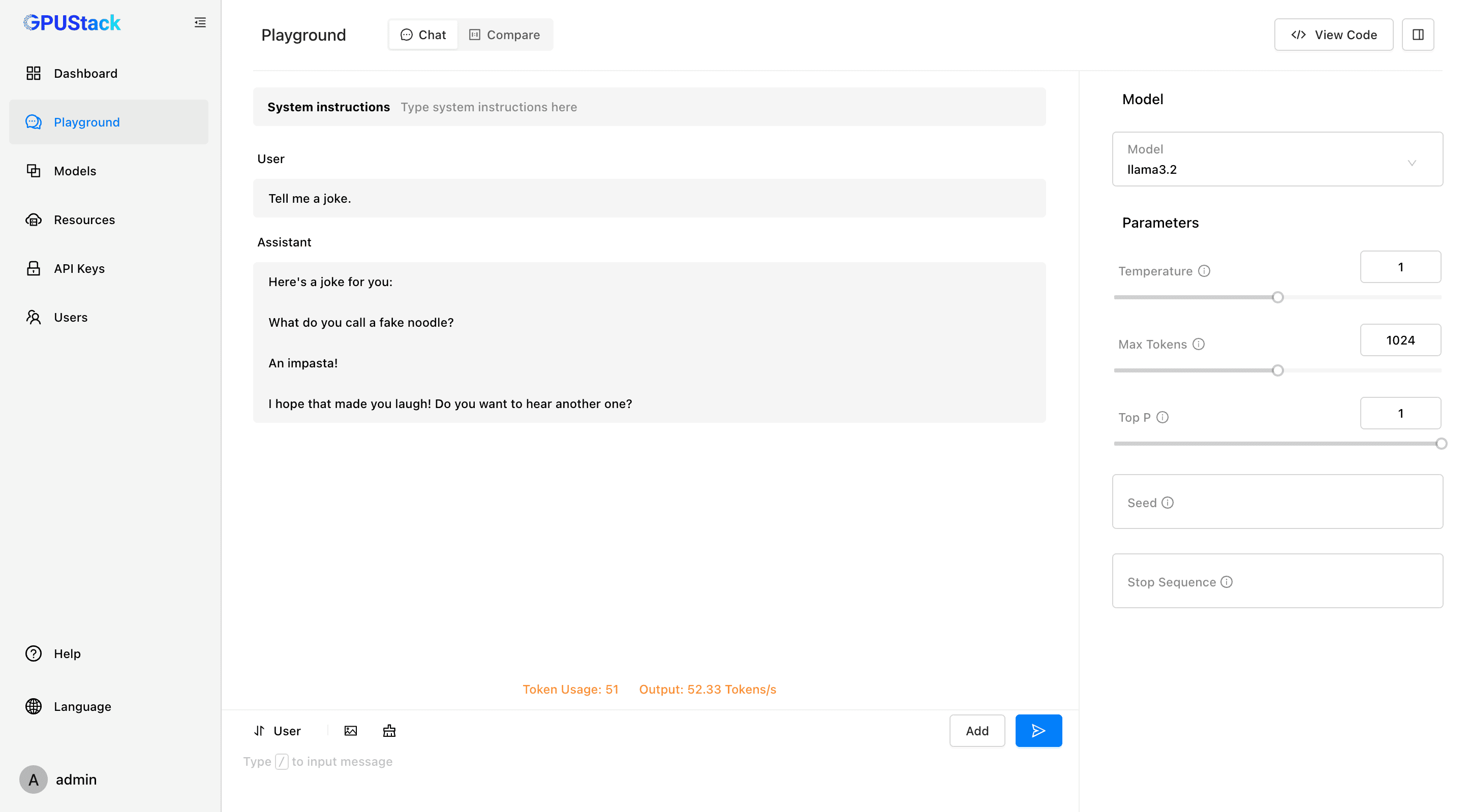

실행 및 채팅

- 터미널에서 다음 명령을 실행하여 llama3.2 모델과 채팅합니다:

gpustack chat llama3.2 "tell me a joke."

- GPUStack UI에서 "놀이터"를 클릭하여 상호 작용합니다.

모니터링 및 관리

- GPU 성능과 사용률을 실시간으로 모니터링하세요.

- 사용자 및 API 키를 관리하고 토큰 사용량과 요금을 추적하세요.

지원 모델 및 플랫폼

- 지원 모델: LLaMA, 미스트랄 7B, 믹스트랄 MoE, 팔콘, 바이촨, 이, 딥시크, 퀜, 파이, 그로크-1 등.

- 지원되는 멀티모달 모델: Llama3.2-Vision, Pixtral, Qwen2-VL, LLaVA, InternVL2 및 기타.

- 지원 플랫폼: macOS, Linux, Windows.

- 지원되는 가속기: 애플 메탈, 엔비디아 쿠다, 어센드 캔, 무어 스레드 무사, 향후 AMD ROCm, 인텔 원API, 퀄컴 AI 엔진도 지원할 계획입니다.

문서 및 커뮤니티

- 공식 문서: 방문 GPUStack 문서 전체 가이드와 API 설명서를 확인하세요.

- 기여 가이드: 읽기 기여 가이드라인 GPUStack에 기여할 수 있는 방법을 알아보세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...