지난 달 차세대 개방형 모델 출시에 이어 젬마 3 Google은 최근 양자화 인식 훈련(QAT)에 최적화된 새 버전으로 모델 생태계를 확장했습니다. Gemma 3는 이전에 다음 분야에서 사용되었습니다. BF16 정확도는 단일 하이엔드 GPU보다 낮습니다(예 NVIDIA H100QAT 버전은 모델의 메모리 요구 사항을 크게 줄이면서도 최고 품질의 출력을 유지하도록 설계되어 강력한 AI 모델을 더 많은 소비자급 하드웨어에서 실행할 수 있습니다. 또한 QAT 버전은 모델의 메모리 요구 사항을 크게 줄이면서도 가능한 최고 품질의 출력을 유지하도록 설계되어 강력한 AI 모델을 더 많은 소비자급 하드웨어에서 실행할 수 있습니다.

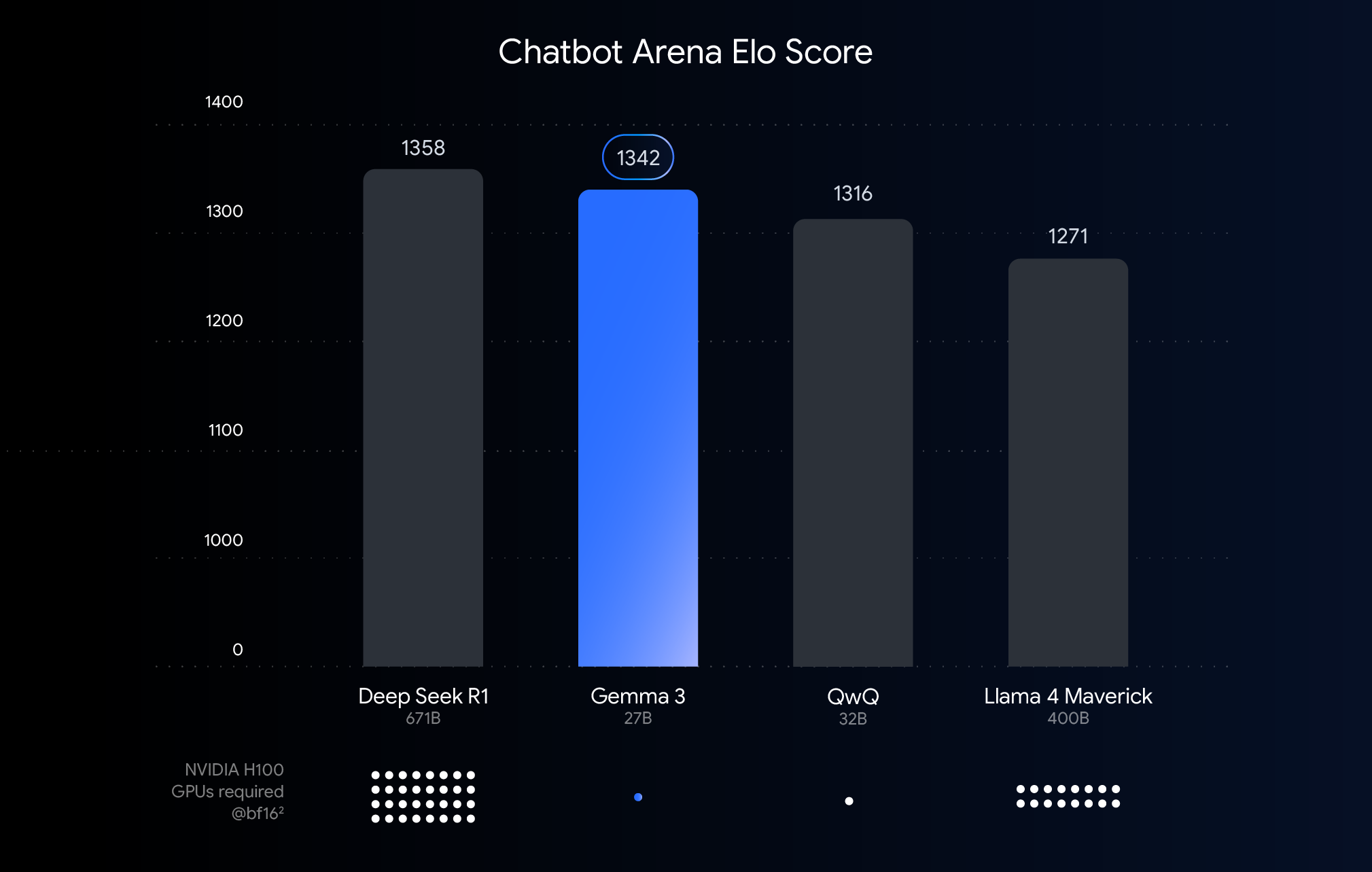

이 차트는 챗봇 아레나 엘로 점수를 기준으로 AI 모델의 순위를 매긴 것으로, 점수가 높을수록 사용자 선호도가 높음을 나타냅니다. 점들은 모델이 실행해야 하는 항목을 나타냅니다. NVIDIA H100 예상 GPU 수입니다.

성능, 정확도 및 정량화 임계값 이해하기

위 그래프는 최근에 출시된 대규모 언어 모델의 성능(Elo 점수)을 비교한 것입니다. 막대가 높을수록 인간 평가자가 수행한 익명의 나란히 비교에서 모델이 더 나은 성능을 보인다는 것을 의미합니다. 그래프의 아래쪽에는 성능에 대한 BF16 데이터 유형으로 각 모델을 실행하는 데 필요합니다. NVIDIA H100 GPU 예상 수.

옵션 BF16 16비트 정밀도로 저장된 모델 파라미터를 나타내는 많은 대규모 모델 추론에 일반적으로 사용되는 숫자 형식이기 때문에 비교했습니다. 통합된 BF16 설정에 따른 비교는 다른 하드웨어나 정량화와 같은 최적화 기술로 인해 도입된 변수를 제외하고 동일한 추론 구성에서 모델 자체의 고유한 기능을 평가하는 데 도움이 됩니다.

이 차트에서는 다음과 같이 사용한다는 점에 주목할 필요가 있습니다. BF16 가 공정한 비교를 할 수 있지만, 실제 대규모 모델의 배포에서는 하드웨어에 대한 엄청난 수요(예: 그래픽 프로세서 수)를 줄이기 위해 종종 FP8 및 기타 정밀도가 낮은 형식은 성능과 실현 가능성 사이에서 절충이 필요할 수 있습니다.

하드웨어 장벽 허물기: AI의 접근성 향상

Gemma 3는 클라우드 배포 및 연구 시나리오를 위한 하이엔드 하드웨어에서 잘 작동하지만, 사용자 피드백에 따르면 시장에서는 기존 하드웨어에서도 Gemma 3의 기능을 활용할 수 있기를 기대하고 있습니다. 강력한 AI 기술의 도입을 촉진하려면 데스크톱, 노트북, 심지어 모바일 기기에서 흔히 볼 수 있는 소비자급 GPU에서 효율적으로 실행할 수 있는 모델을 만들어야 합니다. 대규모 모델을 로컬에서 실행하면 데이터 프라이버시가 향상되고 네트워크 지연 시간이 줄어들며 오프라인 애플리케이션을 지원할 뿐만 아니라 사용자 맞춤화를 위한 더 많은 공간을 확보할 수 있습니다.

QAT 기술: 성능과 접근성 간의 균형을 맞추는 열쇠

양자화 기술은 이 목표를 달성하는 데 핵심적인 역할을 합니다. AI 모델링에서 양자화는 모델 저장 및 계산에 사용되는 숫자(즉, 모델 매개변수)의 정밀도를 낮추는 것을 목표로 합니다. 이는 이미지에 사용되는 색상 수를 줄여 이미지를 압축하는 것과 유사합니다. 숫자당 16비트를 사용하는 것과 비교하면(BF16), 양자화는 더 적은 비트(예: 8비트)를 사용할 수 있습니다(int8) 또는 4비트(int4).

입양 int4 즉, 각 숫자는 4비트로만 표현되며 데이터 크기는 BF16 4배 감소했습니다. 기존의 양자화 방법(예: 학습 후 양자화 PTQ)은 일반적으로 모델이 학습된 후에 수행되며, 구현하기는 쉽지만 성능이 크게 저하될 수 있습니다. Google에서 사용하는 QAT 기법은 다릅니다.

QAT는 모델 훈련 중에 정량화 단계를 도입하여 저정밀 작업을 시뮬레이션합니다. 이 접근 방식을 사용하면 모델이 훈련 중에도 저정밀 환경에 적응할 수 있으므로 이후 정량화 과정에서 정확도를 더 잘 유지할 수 있어 더 작고 빠른 모델을 만들 수 있습니다. 특히, 구글은 정량화되지 않은 체크포인트의 확률을 목표로 약 5,000단계의 QAT를 Gemma 3 모델에 적용했습니다. 이러한 방식으로 양자화 후 다음과 같은 결과를 얻었다고 합니다. Q4_0 모델의 예측력을 측정하는 척도인 퍼플리시티는 형식( llama.cpp (평가).

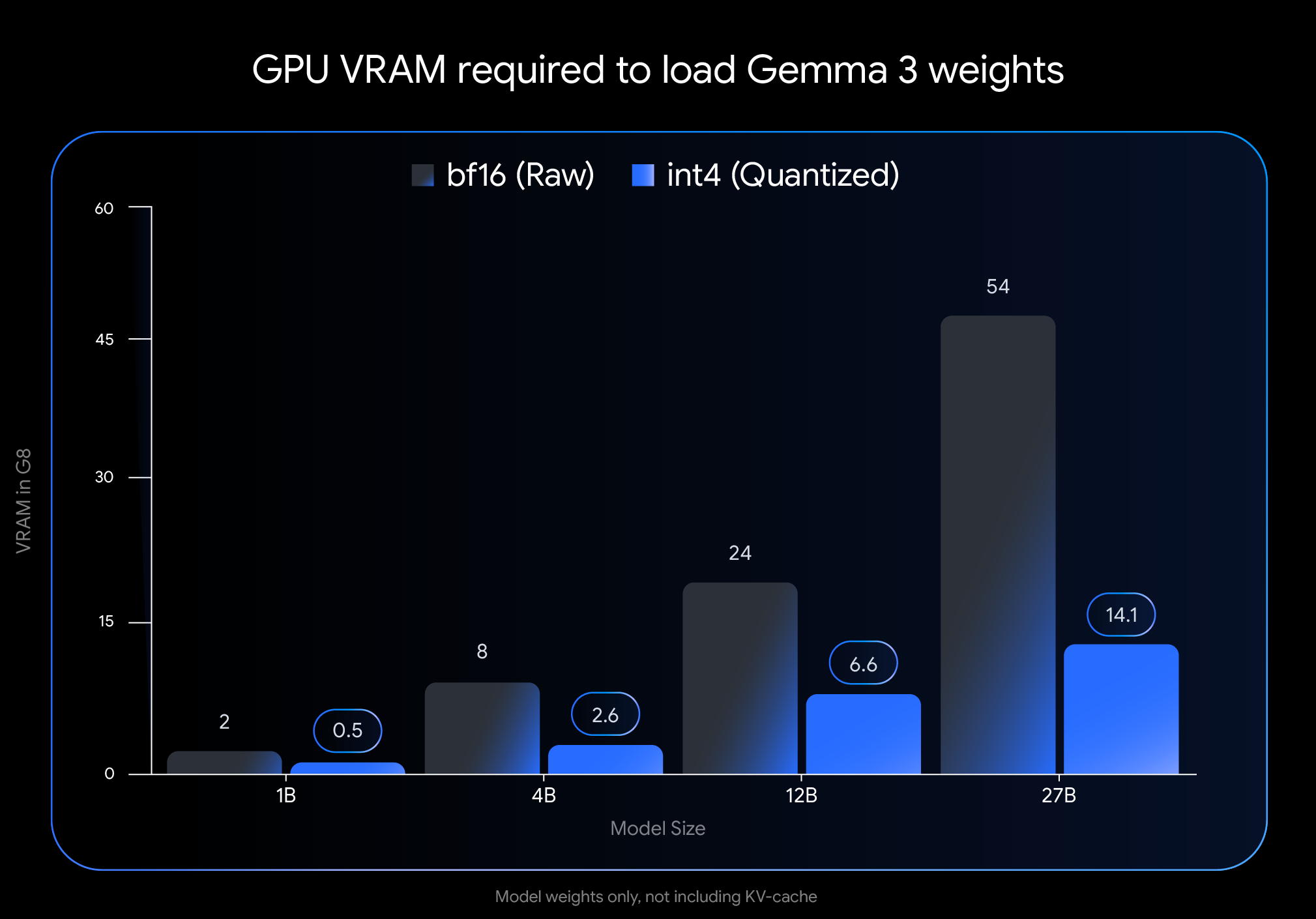

중요한 효과: VRAM 사용량 대폭 감소

int4 특히 모델 가중치를 로드하는 데 필요한 비디오 메모리(VRAM)의 양 측면에서 양자화의 영향은 상당합니다:

- 젬마 3 27B. 54GB부터 (

BF16)에서 14.1GB (int4) - Gemma 3 12B. 24GB부터 (

BF16) 감소 6.6GB (int4) - Gemma 3 4B. 8GB부터 (

BF16) 감소 2.6GB (int4) - 젬마 3 1B. 2GB부터 (

BF16)에서 0.5GB (int4)

주의. 이 데이터는 모델 가중치를 로드하는 데 필요한 VRAM만을 나타냅니다. 모델을 실행하려면 대화 컨텍스트 정보를 저장하는 KV 캐시를 위한 추가 VRAM도 필요하며, 그 크기는 컨텍스트 길이에 따라 달라집니다.

기기에서 Gemma 3를 실행하세요!

그래픽 메모리 요구 사항이 대폭 감소하여 널리 사용되는 일반 소비자용 하드웨어에서 더 크고 강력한 모델을 실행할 수 있습니다:

- 젬마 3 27B (

int4): 이제 단일 24GB VRAM 데스크톱 클래스에서 쉽게 실행할 수 있습니다.NVIDIA RTX 3090또는 이와 유사한 그래픽 카드를 사용하는 경우, 사용자는 로컬에서 Google의 가장 큰 젬마 3 변형을 실행할 수 있었습니다. - 젬마 3 12B (

int4): 8GB VRAM이 장착된 노트북 GPU에서 실행할 수 있는 기능(NVIDIA RTX 4060 Laptop GPU또한 휴대용 디바이스에도 강력한 AI 기능을 제공합니다. - 소형 모델(4B, 1B). 일부 모바일 장치를 포함하여 리소스가 제한된 시스템에 대한 접근성이 향상됩니다.

주요 도구와의 손쉬운 통합

사용자가 자신의 워크플로에서 이러한 모델을 더 쉽게 사용할 수 있도록 Google에서는 Hugging Face 노래로 응답 Kaggle 공식 int4 노래로 응답 Q4_0 정량화되지 않은 QAT 모델. 동시에 Google은 여러 인기 개발자 도구와 제휴하여 사용자가 QAT 기반 정량화된 체크포인트를 원활하게 사용해 볼 수 있도록 했습니다:

- Ollama. 간단한 명령으로 빠르게 실행할 수 있으며, 모든 Gemma 3 QAT 모델이 기본적으로 지원됩니다.

- LM 스튜디오. 사용자 친화적인 인터페이스를 제공하여 데스크탑에서 Gemma 3 QAT 모델을 쉽게 다운로드하고 실행할 수 있습니다.

- MLX. 활용

MLX프레임워크는 다음과 같습니다.Apple SiliconGemma 3 QAT 모델의 효율적이고 최적의 추론을 위한 - Gemma.cpp. CPU에서 효율적으로 추론하기 위한 Google의 전용 C++ 구현입니다.

- llama.cpp. 기존 워크플로에 쉽게 통합할 수 있도록 GGUF 형식의 QAT 모델을 기본적으로 지원합니다.

젬마버스 생태계의 더 많은 정량적 옵션

공식적으로 발표된 QAT 모델 외에도 활성 Gemmaverse 커뮤니티에서도 다양한 대안을 제시하고 있습니다. 이러한 방식은 일반적으로 훈련 후 정량화(PTQ) 기법을 사용하는데, 이 기법은 일반적으로 Bartowski, Unsloth, GGML 및 기타 커뮤니티 회원의 기여, 그리고 Hugging Face 사용 가능 이러한 커뮤니티 옵션을 살펴보면 사용자는 특정 요구 사항을 충족하기 위해 모델 크기, 속도 및 품질 간의 균형을 맞출 수 있는 더 넓은 범위의 선택권을 갖게 됩니다.

지금 시작하세요!

쉽게 접근할 수 있는 하드웨어에 최첨단 AI 성능을 제공하는 것은 AI 개발의 대중화를 위한 중요한 단계입니다. QAT를 통해 최적화된 Gemma 3 모델을 통해 사용자는 이제 자신의 데스크톱이나 노트북에서 최첨단 AI 기능을 활용할 수 있습니다. 이는 개발자와 연구자가 대규모 언어 모델을 탐색하는 데 있어 장벽을 낮출 뿐만 아니라 더욱 강력한 엣지 AI 애플리케이션의 잠재력을 보여줍니다.

정량적 모델을 탐색하고 구축을 시작하세요:

- PC에서 사용

Ollama실행 중입니다:https://ollama.com/library/gemma3 - 존재

Hugging Face노래로 응답Kaggle모델을 찾아보세요: - 모바일 기기에서 실행(

Google AI Edge):https://developers.googleblog.com/en/gemma-3-on-mobile-and-web-with-google-ai-edge/

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...