시스템 설계 원칙

DeepSeek-V3/R1 추론 서비스의 최적화 목표는 다음과 같습니다:처리량은 늘리고 지연 시간은 줄입니다.

이 두 가지 목표를 최적화하기 위해 DeepSeek는 노드 간 전문가 병렬 처리(EP)라는 솔루션을 사용합니다.

- 첫째, EP는 배치 크기를 크게 확장하여 GPU 매트릭스 계산의 효율성을 개선하고 처리량을 늘립니다.

- 둘째, EP는 전문가를 여러 GPU에 분산하여 지연 시간을 줄이고 각 GPU는 전문가 중 일부만 처리합니다(메모리 액세스 요구 사항 감소).

그러나 EP는 크게 두 가지 방식으로 시스템 복잡성을 증가시킵니다:

- EP는 노드 간 통신을 도입합니다. 처리량을 최적화하려면 통신과 계산이 겹치도록 적절한 계산 워크플로우를 설계해야 합니다.

- EP에는 여러 노드가 포함되므로 데이터 병렬 처리(DP) 자체와 서로 다른 DP 인스턴스 간의 로드 밸런싱이 필요합니다.

이 문서에서는 다음 사항에 중점을 둡니다. DeepSeek 이러한 문제를 해결하는 방법은 다음과 같습니다:

- EP를 사용하여 배치 크기를 확장합니다.

- 계산 뒤에 통신 지연을 숨기고

- 로드 밸런싱을 수행합니다.

대규모 노드 간 전문가 병렬 처리(EP)

DeepSeek-V3/R1의 전문가 수가 많기 때문에(레이어당 256명의 전문가 중 8명만 활성화됨) 모델의 희소성이 높기 때문에 총 배치 크기가 매우 커야 합니다. 이렇게 하면 전문가당 충분한 배치 크기가 보장되어 처리량이 증가하고 지연 시간이 단축됩니다. 대규모 교차 노드 EP는 매우 중요합니다.

딥시크는 사전 채우기-디코딩 분리 아키텍처를 채택하고 있으므로 사전 채우기 단계와 디코딩 단계에서 서로 다른 수준의 병렬 처리가 사용됩니다:

- 사전 채우기 단계 [라우팅 전문가 EP32, MLA/공유 전문가 DP32]각 배포 유닛은 4개의 노드에 걸쳐 있으며 32개의 중복 라우팅 전문가가 있으며, 각 GPU는 9개의 라우팅 전문가와 1개의 공유 전문가를 처리합니다.

- 디코딩 단계 [라우팅 전문가 EP144, MLA/공유 전문가 DP144]각 배포 유닛은 18개의 노드에 걸쳐 있으며 32개의 중복 경로 전문가가 있으며 각 GPU는 2개의 경로 전문가와 1개의 공유 전문가를 관리합니다.

컴퓨팅-통신 중첩

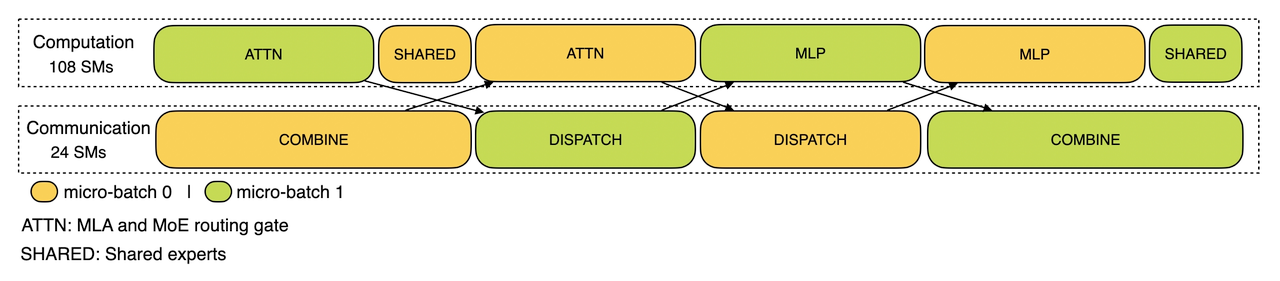

대규모 교차 노드 EP는 상당한 통신 오버헤드를 유발합니다. 이를 완화하기 위해 DeepSeek는 이중 배치 중첩 전략을 사용하여 요청 배치를 두 개의 마이크로 배치로 분할함으로써 통신 비용을 숨기고 전체 처리량을 개선합니다. 프리-팝업 단계에서 이 두 개의 마이크로 배치는 번갈아 실행되며, 한 마이크로 배치의 통신 비용은 다른 마이크로 배치의 계산 뒤에 숨겨집니다.

사전 채우기 단계 계산 - 통신 중첩

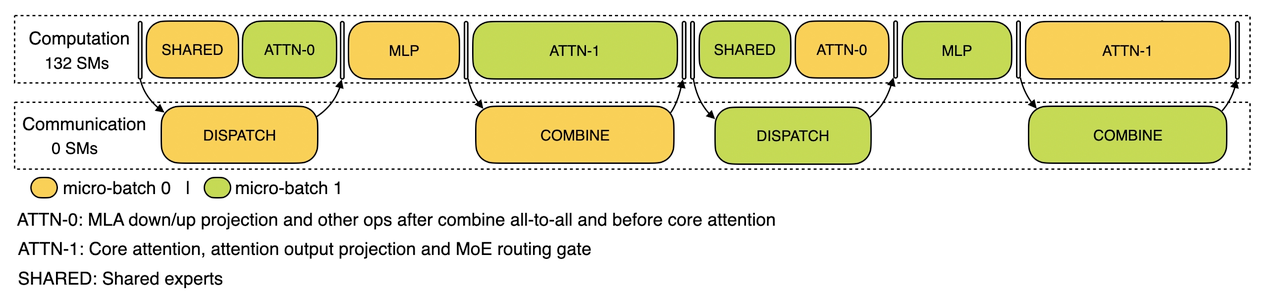

디코딩 단계에서는 여러 단계의 실행 시간이 고르지 않습니다. 따라서 딥시크는 주의 계층을 두 단계로 세분화하고 5단계 파이프라인을 사용해 계산과 통신의 중첩을 원활하게 처리합니다.

디코딩 단계에서의 전산-통신 중첩

DeepSeek의 계산-통신 중첩 메커니즘에 대한 자세한 내용은 다음을 참조하세요. https://github.com/deepseek-ai/profile-data.

최적의 로드 밸런싱 달성

대규모 병렬 처리(DP 및 EP 포함)는 하나의 GPU에 연산 또는 통신 과부하가 걸리면 성능 병목 현상이 발생하여 다른 GPU가 유휴 상태인 동안 전체 시스템 속도가 느려지는 주요 과제를 안고 있습니다. 딥시크는 리소스 활용을 극대화하기 위해 모든 GPU에서 컴퓨팅 및 통신 부하의 균형을 맞추기 위해 노력합니다.

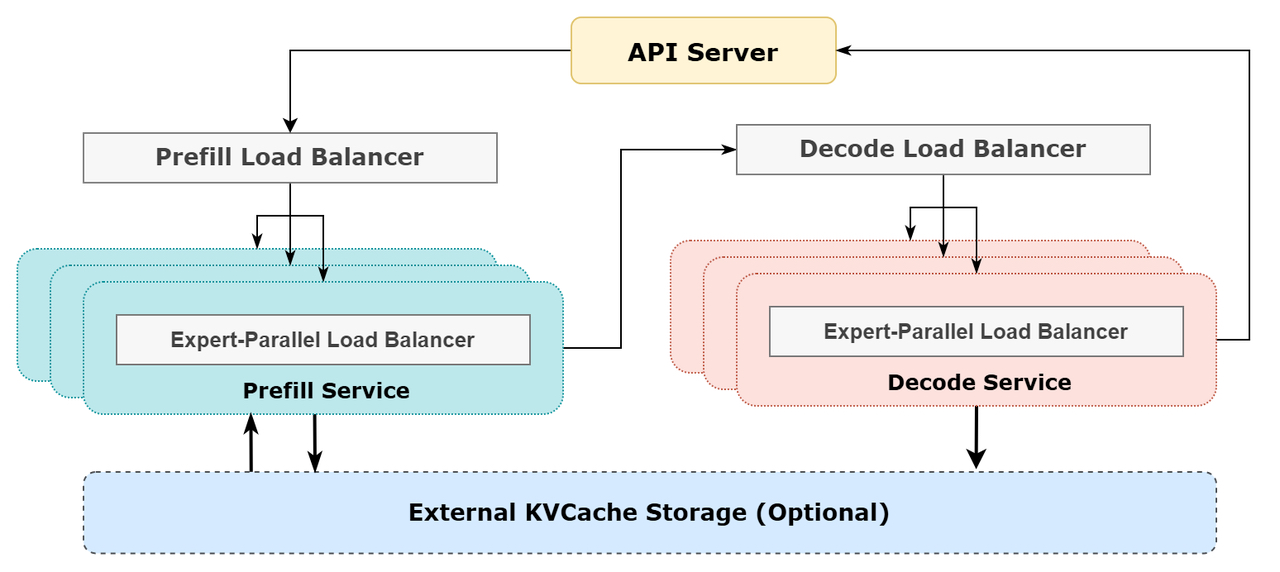

1. 미리 채워진 로드 밸런서

- 주요 문제: DP 인스턴스 간에 요청 수와 시퀀스 길이가 달라지면 핵심 관심도 계산 및 스케줄링 전송 부하가 불균형해집니다.

- 최적화 목표:

- GPU 간 핵심 관심 계산의 균형을 맞춥니다(핵심 관심 계산 로드 밸런싱).

- 각 GPU에 입력 균등화하기 토큰 숫자(전송 로드 밸런싱 예약)를 설정하여 특정 GPU에서 처리 시간이 길어지는 것을 방지합니다.

2. 로드 밸런서 디코딩

- 주요 문제: DP 인스턴스 간의 요청 수와 시퀀스 길이가 균일하지 않으면 코어 관심 계산(KVCache 사용량 관련) 및 스케줄링 전송 부하가 달라집니다.

- 최적화 목표:

- GPU 간 KVCache 사용량 균형 조정(코어 주의 컴퓨팅 로드 밸런싱).

- GPU당 요청 수를 분산합니다(스케줄링 전송 부하 분산).

3. 전문가 병렬 로드 밸런서

- 주요 문제: 특정 MoE 모델의 경우 본질적으로 전문가 부하가 많기 때문에 서로 다른 GPU 간에 전문가 계산 워크로드가 불균형하게 발생합니다.

- 최적화 목표:

- 각 GPU에서 전문가 계산의 균형을 맞춥니다(즉, 모든 GPU에서 최대 스케줄링 수신 부하를 최소화합니다).

딥시크 온라인 추론 시스템의 개략도

딥시크 온라인 추론 시스템의 개략도

딥서치 온라인 서비스 통계

모든 DeepSeek-V3/R1 추론 서비스는 H800 GPU에서 훈련과 일치하는 정확도로 제공됩니다. 특히 행렬 곱셈과 스케줄링 전송은 트레이닝과 일관된 FP8 포맷을 사용하며, 핵심 MLA 계산과 조합 전송은 최적의 서비스 성능을 보장하기 위해 BF16 포맷을 사용합니다.

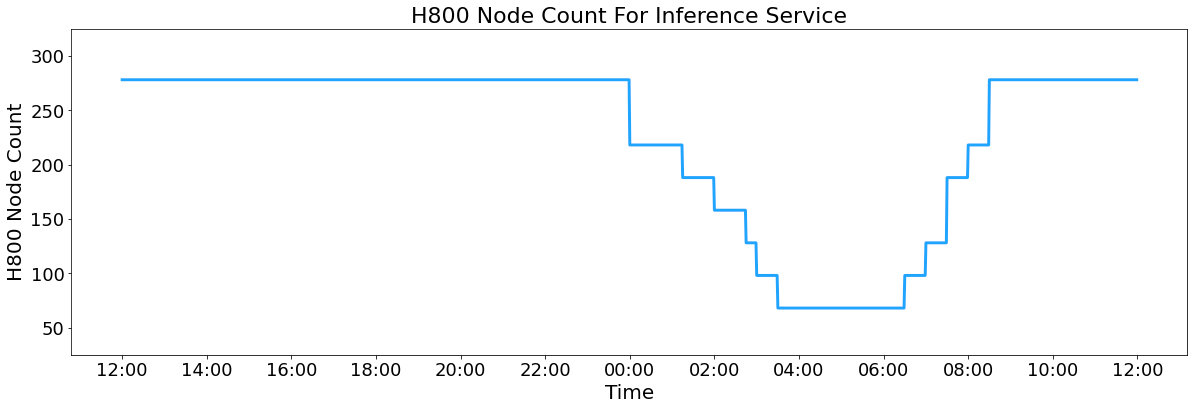

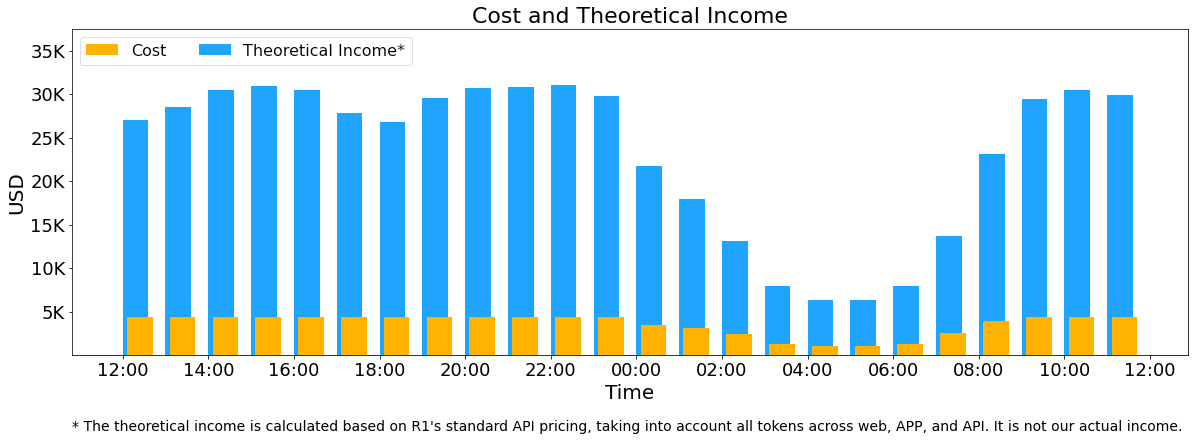

또한, 낮에는 서비스 부하가 높고 밤에는 부하가 낮기 때문에, 딥시크는 낮 시간대 피크 시간대에 모든 노드에 추론 서비스를 배포하는 메커니즘을 구현했습니다. 야간의 부하가 낮은 시간대에는 딥시크는 추론 노드를 줄이고 리소스를 연구와 훈련에 할당합니다. 지난 24시간 동안(2025년 2월 27일 오후 12시부터 2월 28일 오후 12시까지) V3 및 R1 추론 서비스의 최대 노드 사용량은 총 278개였으며, 평균 사용량은 226.75개(각각 8개의 H800 GPU 포함)였습니다. H800 GPU 한 대당 시간당 2달러의 임대 비용을 가정하면 일일 총 비용은 $87,072입니다.

H800 추론 서비스 노드 수

V3 및 R1의 24시간 통계 기간(2025년 2월 27일 정오 12시(UTC+8) ~ 2025년 2월 28일 정오 12시(UTC+8)) 동안입니다:

- 총 입력 토큰: 608B, 이 중 342B 토큰(56.3%)이 디스크의 KV 캐시에 도달했습니다.

- 총 출력 토큰: 168 B. 평균 출력 속도는 초당 20-22 토큰이며, 각 출력 토큰의 평균 kvcache 길이는 4,989 토큰입니다.

- 각 H800 노드는 사전 채우기 동안 평균 ~73.7k 토큰/초의 입력 처리량(캐시 히트 포함)을, 디코딩 동안 ~14.8k 토큰/초의 출력 처리량을 제공합니다.

위의 통계에는 웹, 앱 및 API의 모든 사용자 요청이 포함됩니다. 만약 모든 토큰이 DeepSeek-R1 일일 총 수익은 562,027달러이며, 가격(*) 청구 기준 비용 마진은 545%입니다.

() R1 가격: 입력 토큰(캐시 히트)의 경우 $0.14/M, 입력 토큰(캐시 미스)의 경우 $0.55/M, 출력 토큰의 경우 $2.19/M입니다.

그러나 다음과 같은 이유로 딥시크의 실제 수익은 훨씬 낮습니다:

- DeepSeek-V3는 R1보다 훨씬 저렴한 가격으로 책정되었습니다.

- 일부 서비스만 유료입니다(웹 및 앱 액세스는 계속 무료입니다).

- 야간 할인은 사용량이 적은 시간대에 자동으로 적용됩니다.

비용 및 이론적 수익

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...