일반 소개

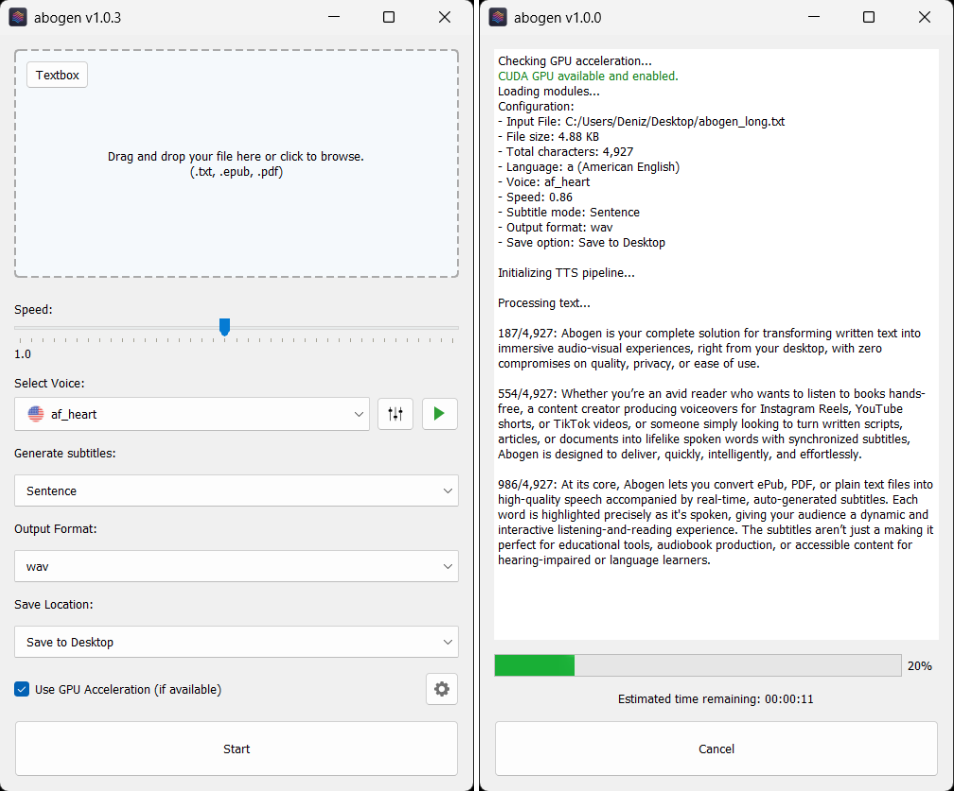

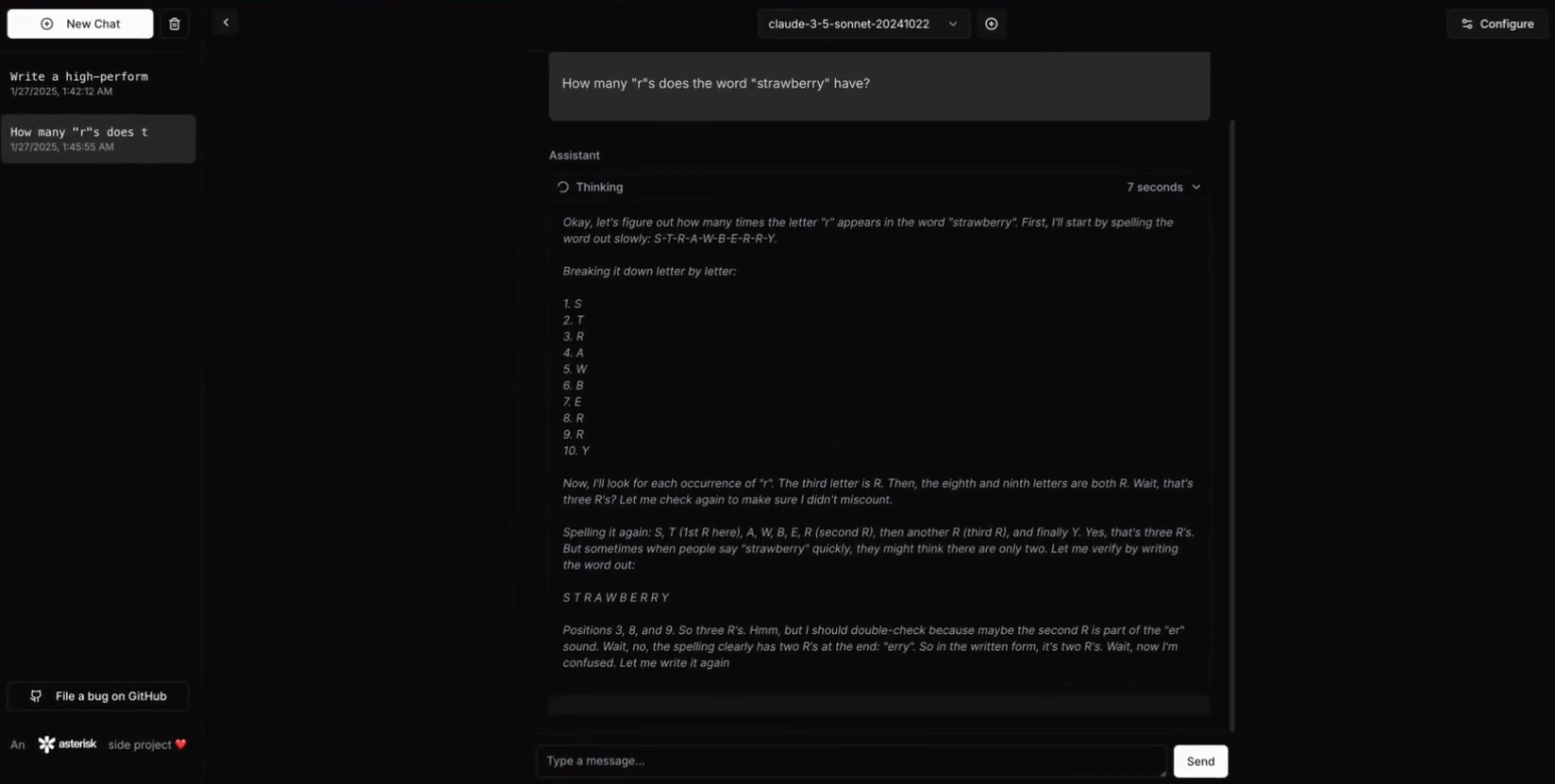

딥클라우드는 고성능 대규모 언어 모델(LLM) 추론 API이자 채팅 인터페이스로, 딥시크 R1의 연쇄 추론(CoT) 기능을 다음과 통합합니다. 인류학Claude 모델 창의성 및 코드 생성 기능. 이 프로젝트는 OpenAI o1보다 훨씬 뛰어난 성능을 발휘합니다, DeepSeek R1과 Claude Sonnet 3.5를 통합하여 두 모델의 강점을 활용하면서 API 키와 데이터를 완벽하게 제어할 수 있는 통합 인터페이스를 제공합니다. 지연 시간 없는 응답, 엔드투엔드 보안, 높은 구성 가능성, 오픈 소스 코드 기반 등이 DeepClaude의 특징입니다. 사용자는 자신의 API 키를 직접 관리할 수 있어 데이터 프라이버시와 보안을 보장합니다. 무엇보다도 DeepClaude는 완전 무료이며 오픈 소스입니다.

DeepClaude는 추론에 R1을 사용한 다음 Claude가 결과를 출력하도록 합니다.

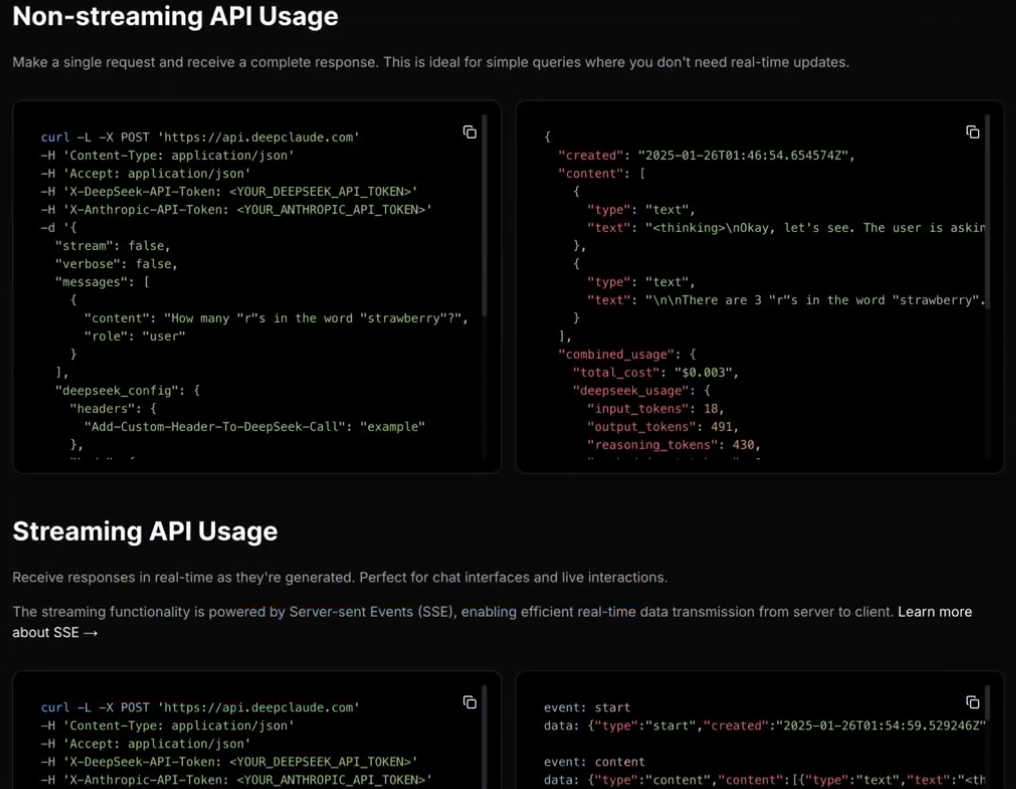

딥클라우드는 고성능 LLM 추론 API도 제공합니다.

기능 목록

- 제로 레이턴시 응답고성능 Rust API를 통한 즉각적인 응답.

- 비공개 및 보안데이터 프라이버시를 보장하기 위한 로컬 API 키 관리.

- 고도의 구성 가능성사용자는 필요에 따라 API 및 인터페이스의 여러 측면을 사용자 지정할 수 있습니다.

- 오픈 소스무료 오픈 소스 코드 기반으로 사용자가 자유롭게 기여, 수정 및 배포할 수 있습니다.

- 듀얼 AI 기능클로드 소네트 3.5의 창의성 및 코드 생성 능력과 딥시크 R1의 추론 능력을 결합한 제품입니다.

- 호스팅된 BYOK API완벽한 제어를 위해 사용자 고유의 API 키를 사용하여 관리합니다.

도움말 사용

설치 프로세스

- 사전 조건::

- 녹 1.75 이상

- DeepSeek API 키

- 인트로픽 API 키

- 클론 창고::

git clone https://github.com/getAsterisk/deepclaude.git

cd deepclaude

- 프로젝트 빌드::

cargo build --release

- 구성 파일프로젝트 루트 디렉터리에 생성

config.toml문서화:

[server]

host = "127.0.0.1"

port = 3000

[pricing]

# 配置定价选项

- 운영 서비스::

cargo run --release

사용 가이드라인

- API 사용::

- 기본 예제::

import requests url = "http://127.0.0.1:3000/api" payload = { "model": "claude", "prompt": "Hello, how can I help you today?" } response = requests.post(url, json=payload) print(response.json())- 스트리밍 응답 예시::

import requests url = "http://127.0.0.1:3000/api/stream" payload = { "model": "claude", "prompt": "Tell me a story." } response = requests.post(url, json=payload, stream=True) for line in response.iter_lines(): if line: print(line.decode('utf-8')) - 자체 호스팅::

- 구성 옵션사용자는

config.toml구성 옵션을 사용하여 API 및 인터페이스의 측면을 사용자 지정할 수 있습니다.

- 구성 옵션사용자는

- 안전::

- 로컬 API 키 관리: API 키와 데이터의 개인정보 보호를 보장합니다.

- 엔드투엔드 암호화: 데이터 전송의 보안을 보호합니다.

- 헌신::

- 기여 가이드라인풀 리퀘스트를 제출하거나 이슈를 보고하여 코드를 기여하고 프로젝트를 개선할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...