发现一篇好玩的论文《Thoughts Are All Over the Place: On the Underthinking of o1-Like LLMs》,主题是分析o1 类推理模型 思考路径频繁切换、思维缺乏聚焦,简称为“思考不足”(underthinking),同时给出缓解方法。这篇文章同时解答了推理模型到底又没在在思考,希望读者找到自己的答案。

一、 背景:

近年来,以OpenAI的o1模型为代表的大语言模型(LLMs)在复杂推理任务中展现出卓越能力,其通过扩展推理过程中的计算量,模拟了人类的深度思考。然而,现有研究对LLMs的思考深度提出了质疑:这些模型是否真的在深入思考?

为了回答这个问题,本文作者提出了“思考不足”(underthinking)的概念,并对其进行了系统分析。作者认为,思考不足是指o1类LLMs在解决复杂问题时,过早放弃有希望的推理路径,导致思考深度不足,最终影响模型性能。这种现象在数学难题中尤为突出。

二、 思考与研究方法:

为了深入探究思考不足现象,作者进行了以下研究:

1. 定义与观察思考不足现象

- 定义思考: 作者将“思考”定义为模型在推理过程中产生的中间认知步骤,并使用“alternatively”等术语作为思考切换的标志。

- 示例: 在图2中,作者展示了一个包含25个思考步骤的模型输出示例,并将其与过度思考的输出进行了对比。

- 实验设计:

- 测试集: 作者选择了三个具有挑战性的测试集:

- MATH500: 包含来自高中数学竞赛的题目,难度从1到5不等。

- GPQA Diamond: 包含物理、化学和生物领域的研究生水平多选题。

- AIME2024: 来自美国数学邀请赛的题目,涵盖代数、计数、几何、数论和概率等多个领域。

- 模型选择: 作者选择了两个具有可见长链式思考的o1类开源模型:QwQ-32B-Preview 和 DeepSeek-R1-671B,并使用 DeepSeek-R1-Preview 作为补充,以展示R1系列模型的发展。

- 测试集: 作者选择了三个具有挑战性的测试集:

2. 分析思考不足的表现形式

- 思考切换频率与问题难度:

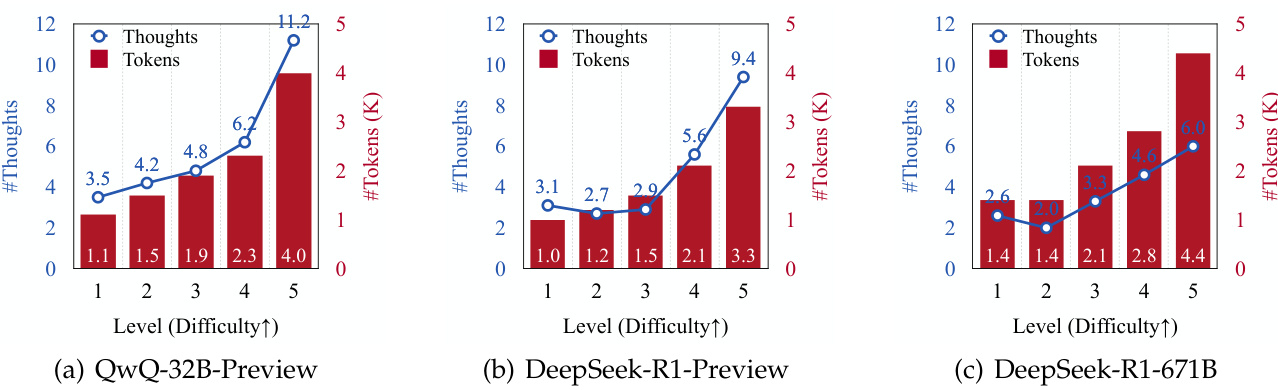

- 作者发现,随着问题难度的增加,所有模型生成的推理思考数量和生成的token数量均有所增加(见图3)。

- 这表明o1类LLMs能够动态调整推理过程以应对更复杂的问题。

- 思考切换与错误响应:

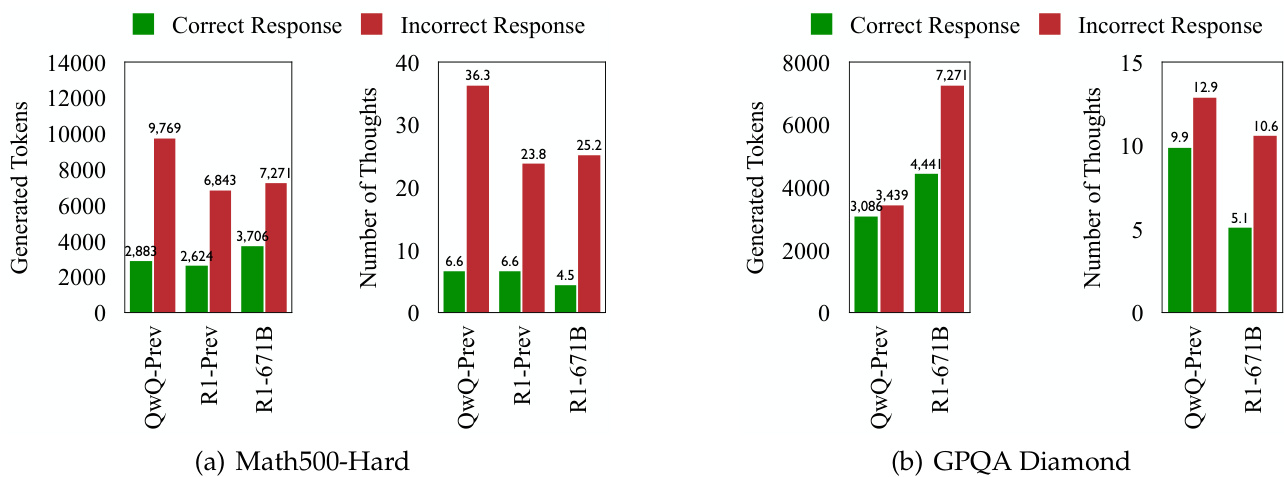

- 在所有测试集中,o1类LLMs在生成错误答案时表现出更频繁的思考切换(见图1和图4)。

- 这表明,尽管模型旨在动态调整认知过程以解决问题,但更频繁的思考切换并不一定带来更高的准确性。

3. 深入探究思考不足的本质

- 评估思考的正确性:

- 作者使用两个基于Llama和Qwen的模型(DeepSeek-R1-Distill-Llama-70B 和 DeepSeek-R1-Distill-Qwen-32B)来评估每个思考步骤是否正确。

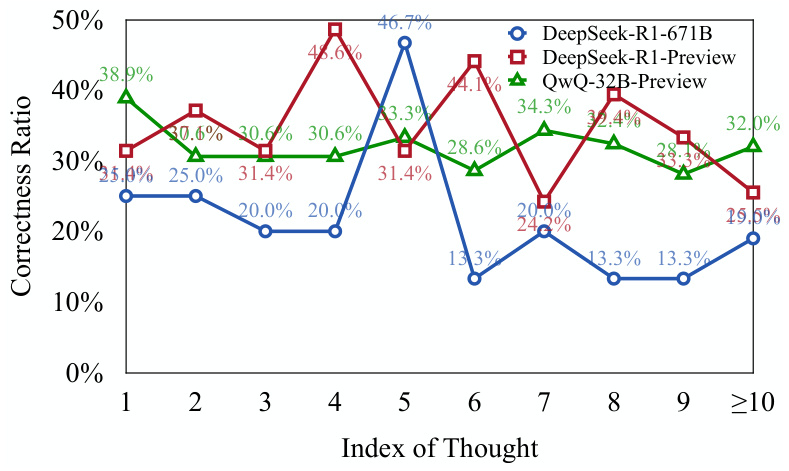

- 结果表明,在错误响应中,早期思考步骤中有相当一部分是正确的,但未被充分探索(见图5)。

- 这表明模型在面对复杂问题时,倾向于过早放弃有希望的推理路径,导致思考深度不足。

- 思考正确性分布:

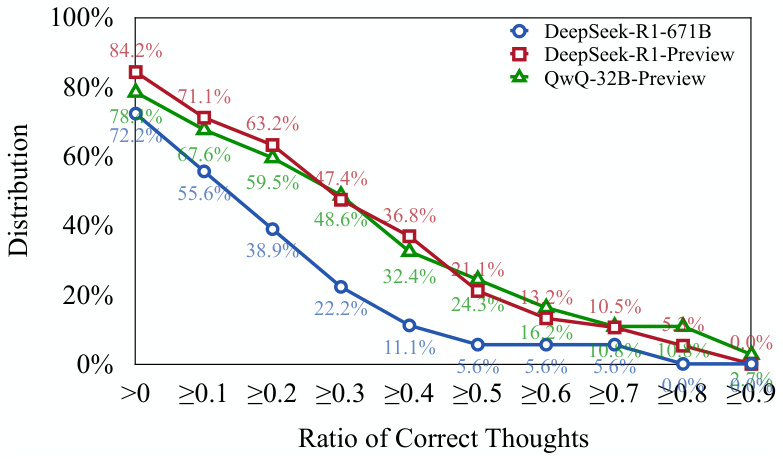

- 作者发现,超过70%的错误响应中至少包含一个正确的思考步骤(见图6)。

- 这进一步支持了上述观点:o1类模型能够启动正确的推理路径,但可能难以继续这些路径以得出正确结论。

4. 量化思考不足:提出新的评估指标

- 思考不足指标(UT):

- 该指标通过衡量生成错误响应时token的效率来量化思考不足的程度。

- 具体来说,UT指标计算的是在错误响应中,从开始到第一个正确思考的token数量占总token数量的比例。

- UT值越高,表示思考不足程度越高,即模型在错误响应中生成的token中,有更大比例未能有效贡献于生成正确的思考。

5. 思考不足对模型性能的影响:

- 作者发现,思考不足现象在不同数据集和任务中表现不同:

- 在MATH500-Hard和GPQA Diamond数据集上,DeepSeek-R1-671B模型虽然准确率更高,但UT值也更高,表明其错误响应中存在更多的思考不足。

- 在AIME2024测试集上,DeepSeek-R1-671B模型不仅准确率更高,而且UT值更低,表明其推理过程更加专注和高效。

三、 重要结论:

- 思考不足是o1类LLMs在复杂问题上表现不佳的重要因素。 频繁的思考切换导致模型无法深入探索有希望的推理路径,最终影响其准确性。

- 思考不足现象与问题难度和模型能力有关。 更难的问题会加剧思考不足,而更强大的模型并不总是能减少思考不足。

- 思考不足与过度思考不同。 过度思考是指模型在简单问题上浪费计算资源,而思考不足则是指模型在复杂问题上过早放弃有希望的推理路径。

- 思考不足指标(UT)可以有效量化思考不足的程度。 该指标为评估o1类LLMs的推理效率提供了新的视角。

四、 应对策略:

为了缓解思考不足问题,作者提出了一种带有思考切换惩罚的解码策略(TIP):

- 核心思想: 在解码过程中,对与思考切换相关的token施加惩罚,鼓励模型在切换到新思考之前,更深入地探索当前思考。

- 实验结果: TIP策略在所有测试集上均提高了QwQ-32B-Preview模型的准确性,证明了其在缓解思考不足问题上的有效性。

五、 未来展望:

作者建议未来研究方向包括:

- 开发自适应机制,使模型能够自我调节思考切换。

- 进一步改进o1类LLMs的推理效率。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...