综合介绍

II-Researcher 是 Intelligent-Internet 团队开发的一款开源人工智能研究工具,托管于 GitHub。它专为深度搜索和复杂推理设计,能通过智能网页搜索和多步骤分析回答复杂问题。项目于 2025 年 3 月 27 日发布,支持多种搜索和抓取工具(如 Tavily、SerpAPI、Firecrawl),并整合 LiteLLM 调用不同 AI 模型。用户可以免费获取代码,自行部署或修改,适合研究人员、开发者等需要高效信息处理的人群。它的核心在于开源、可配置和异步操作,提供透明的研究支持。

功能列表

- 智能网页搜索:通过 Tavily 和 SerpAPI 获取准确信息。

- 网页抓取与提取:支持 Firecrawl、Browser、BS4 等多种工具提取内容。

- 多步骤推理:能拆解问题,逐步推理出答案。

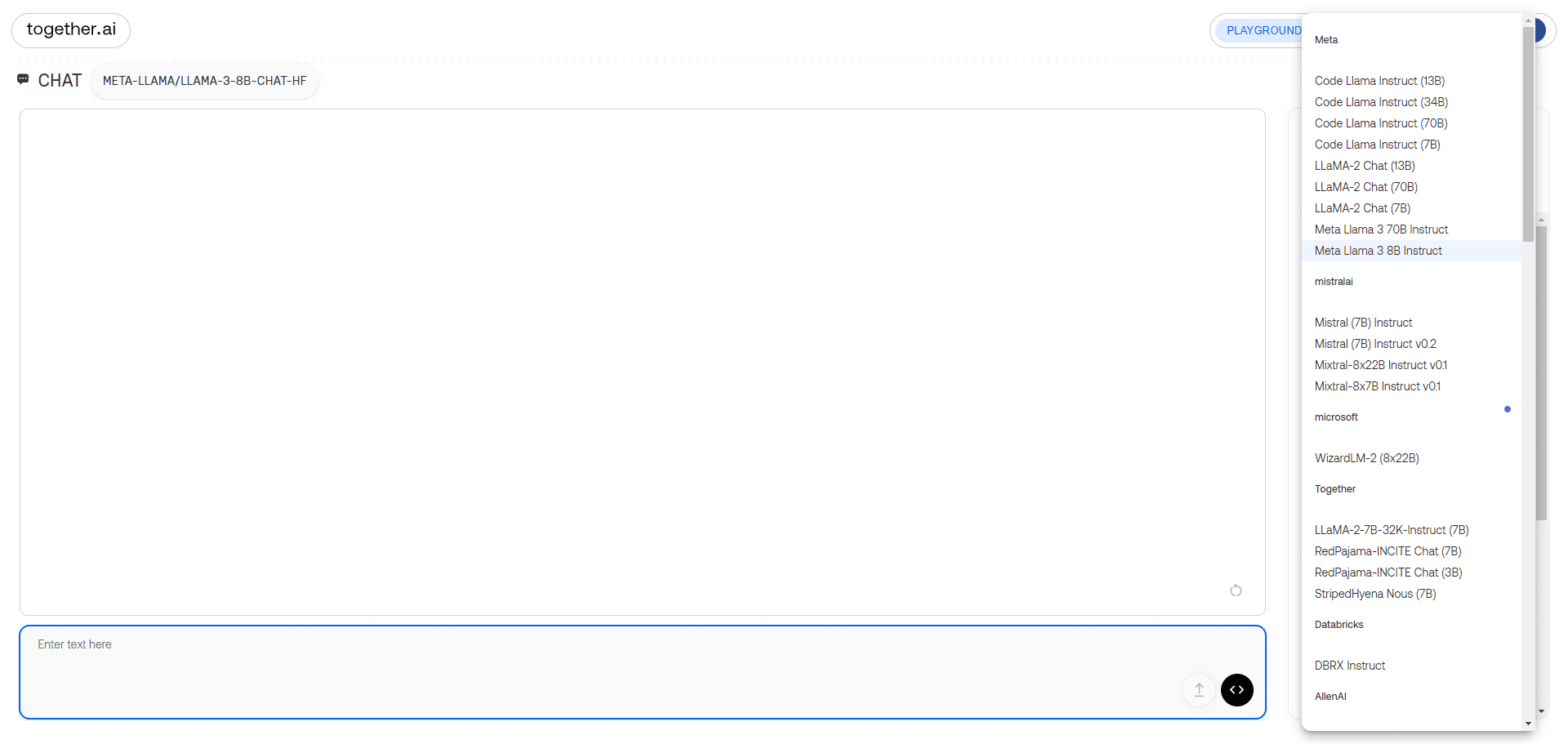

- 可配置模型:支持调整不同任务的 LLM(如 GPT-4o、DeepSeek)。

- 异步操作:提升搜索和处理的效率。

- 生成详细答案:提供带参考的综合报告。

- 自定义管道:用户可调整搜索和推理流程。

使用帮助

安装流程

要使用 II-Researcher,需要安装并配置环境。以下是具体步骤:

- 克隆代码库

在终端输入以下命令下载代码:

git clone https://github.com/Intelligent-Internet/ii-researcher.git

cd ii-researcher

- 安装依赖

项目需要 Python 3.7+。运行以下命令安装依赖:

pip install -e .

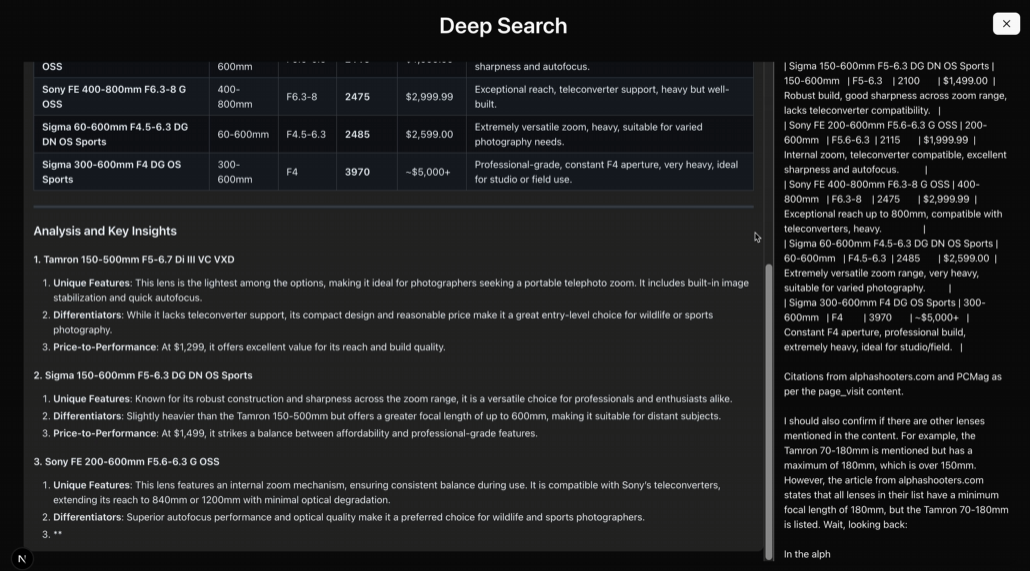

- 设置环境变量

配置必要的 API 密钥和参数。例如:

export OPENAI_API_KEY="your-openai-api-key"

export TAVILY_API_KEY="your-tavily-api-key"

export SEARCH_PROVIDER="tavily"

export SCRAPER_PROVIDER="firecrawl"

可选配置(用于压缩或推理):

export USE_LLM_COMPRESSOR="TRUE"

export FAST_LLM="gemini-lite"

export STRATEGIC_LLM="gpt-4o"

export R_TEMPERATURE="0.2"

- 运行 LiteLLM 本地模型服务器

安装 LiteLLM:

pip install litellm

创建配置文件 litellm_config.yaml:

model_list:

- model_name: gpt-4o

litellm_params:

model: gpt-4o

api_key: ${OPENAI_API_KEY}

- model_name: r1

litellm_params:

model: deepseek-reasoner

api_key: ${OPENAI_API_KEY}

litellm_settings:

drop_params: true

启动服务器:

litellm --config litellm_config.yaml

默认运行在 http://localhost:4000。

- Docker 部署(可选)

配置环境变量后,运行:

docker compose up --build -d

服务地址:

- 前端:

http://localhost:3000 - 后端 API:

http://localhost:8000 - LiteLLM:

http://localhost:4000

主要功能操作

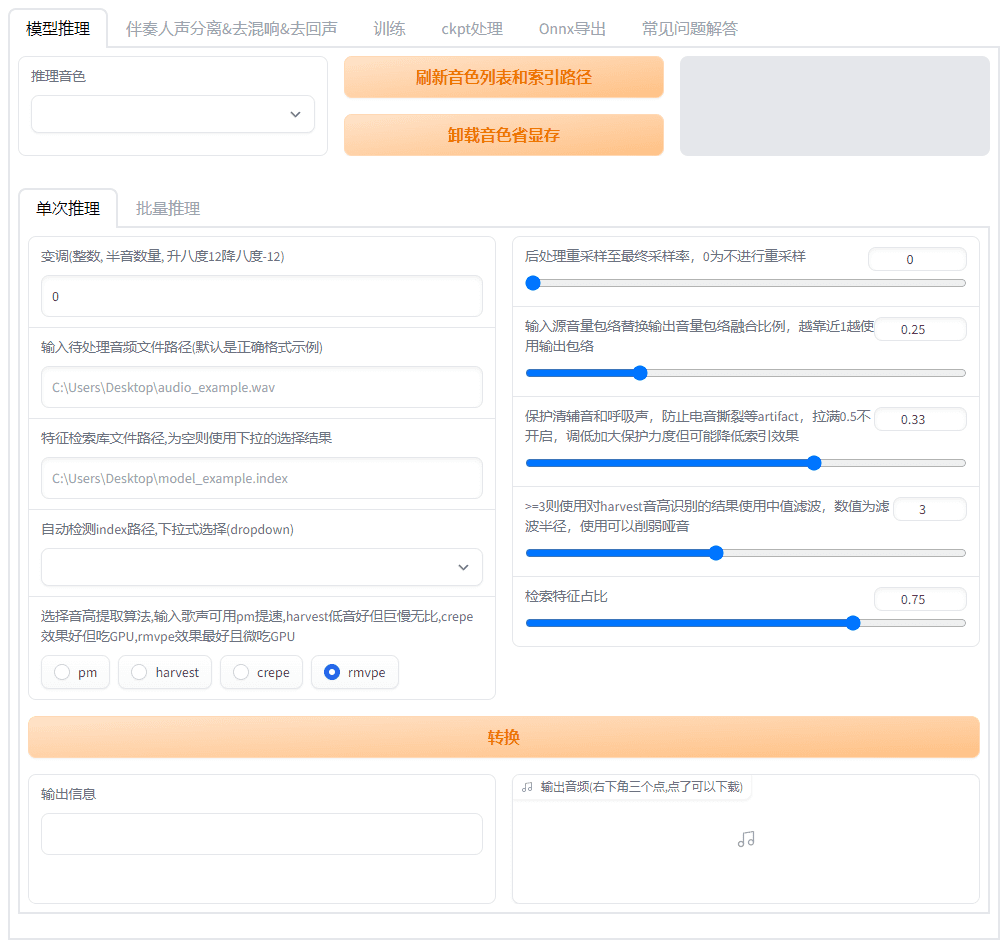

智能深度搜索

- 操作步骤:

- 通过命令行运行:

python cli.py --question "AI如何改善教育质量?"

- 系统调用 Tavily 或 SerpAPI 搜索,返回结果。

- 功能说明:支持多来源搜索,适合复杂问题。

多步骤推理

- 操作步骤:

- 使用推理模式:

python cli.py --question "AI在教育中的优缺点" --use-reasoning --stream

- 系统逐步分析并输出结论。

- 功能说明:能处理需要逻辑推导的任务。

网页抓取

- 操作步骤:

- 配置

SCRAPER_PROVIDER="firecrawl"和 API 密钥。 - 运行搜索任务,自动抓取网页内容。

- 功能说明:支持多种抓取工具,确保内容全面。

Web 界面使用

- 操作步骤:

- 启动后端 API:

python api.py

- 进入

frontend文件夹,安装并运行前端:

npm install

npm run dev

- 访问

http://localhost:3000,输入问题。

- 功能说明:提供图形化界面,操作更直观。

注意事项

- 需要稳定的网络连接以访问 API。

- 硬件要求:基本功能需 8GB 内存,大模型推理建议 16GB+ 和 GPU。

- 日志检查:用

docker compose logs -f查看运行状态。 - 超时配置:搜索默认超时 300 秒,可调整

SEARCH_PROCESS_TIMEOUT。

通过这些步骤,用户可以轻松部署并使用 II-Researcher,完成从搜索到推理的完整流程。

应用场景

- 学术研究

研究人员可以用它搜索文献,分析数据,生成报告。 - 技术开发

开发者可基于框架开发定制化搜索工具。 - 教育辅助

学生可以用它整理资料,解答问题。 - 市场分析

企业可利用它收集行业信息,生成趋势分析。

QA

- II-Researcher 免费吗?

是的,它是开源项目,用户可免费使用代码。 - 需要编程基础吗?

需要基本的 Python 操作知识,但文档详细,初学者也能上手。 - 支持中文吗?

支持,配置合适的模型和搜索工具即可处理中文任务。 - 最低硬件要求是什么?

8GB 内存可运行基本功能,建议 16GB+ 和 GPU 用于大型任务。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...