综合介绍

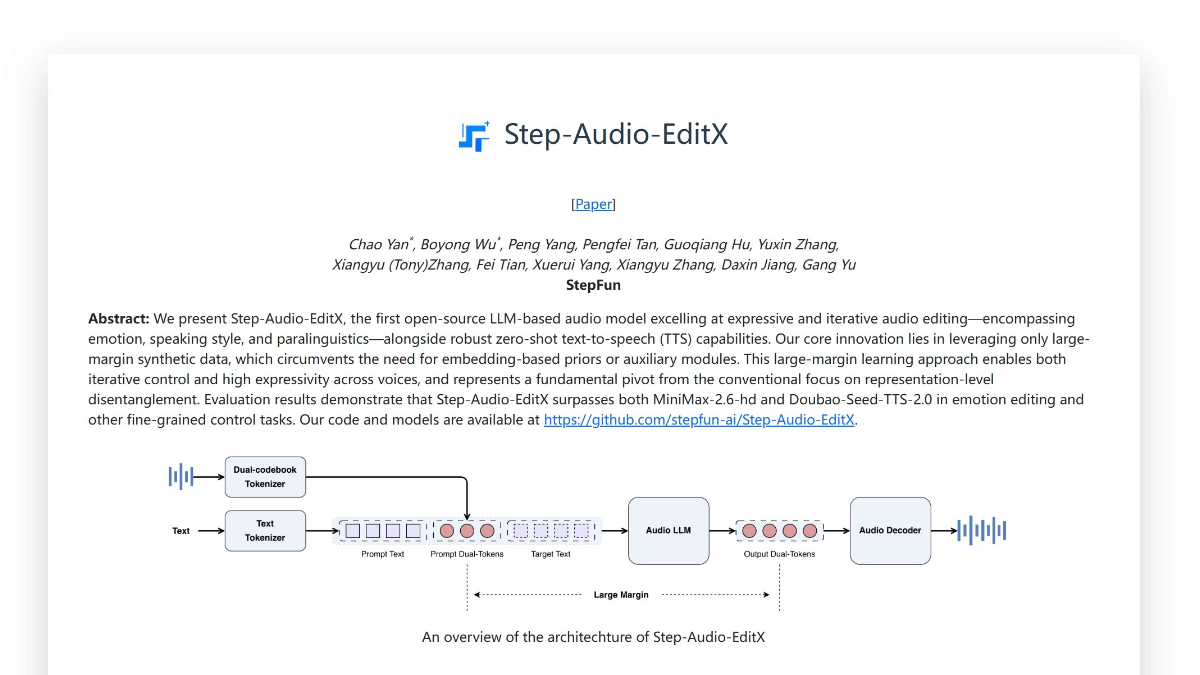

Diffbot LLM推理服务器是一个创新的大规模语言模型系统,它基于LLama模型架构进行了特殊优化和改进。该项目最大的特点是将实时知识图谱(Knowledge Graph)与检索增强生成(RAG)技术相结合,创造了独特的GraphRAG系统。它不仅能够实时提取和处理网页信息,还可以进行精确的事实引用和知识检索。系统提供了两个版本的模型:基于Llama 3.1的8B参数模型(diffbot-small)和基于Llama 3.3的70B参数模型(diffbot-small-xl)。在MMLU-Pro等权威基准测试中,该系统展现出优秀的性能,特别是在实时数据处理方面的表现超越了包括GPT-4和ChatGPT等主流模型。项目完全开源,支持本地部署和云端API调用,为开发者提供了灵活的使用方式。

体验地址:https://diffy.chat/

功能列表

- 实时网页URL内容提取和总结功能

- 基于知识图谱的精确事实检索和引用

- 支持Diffbot知识图谱查询语言(DQL)

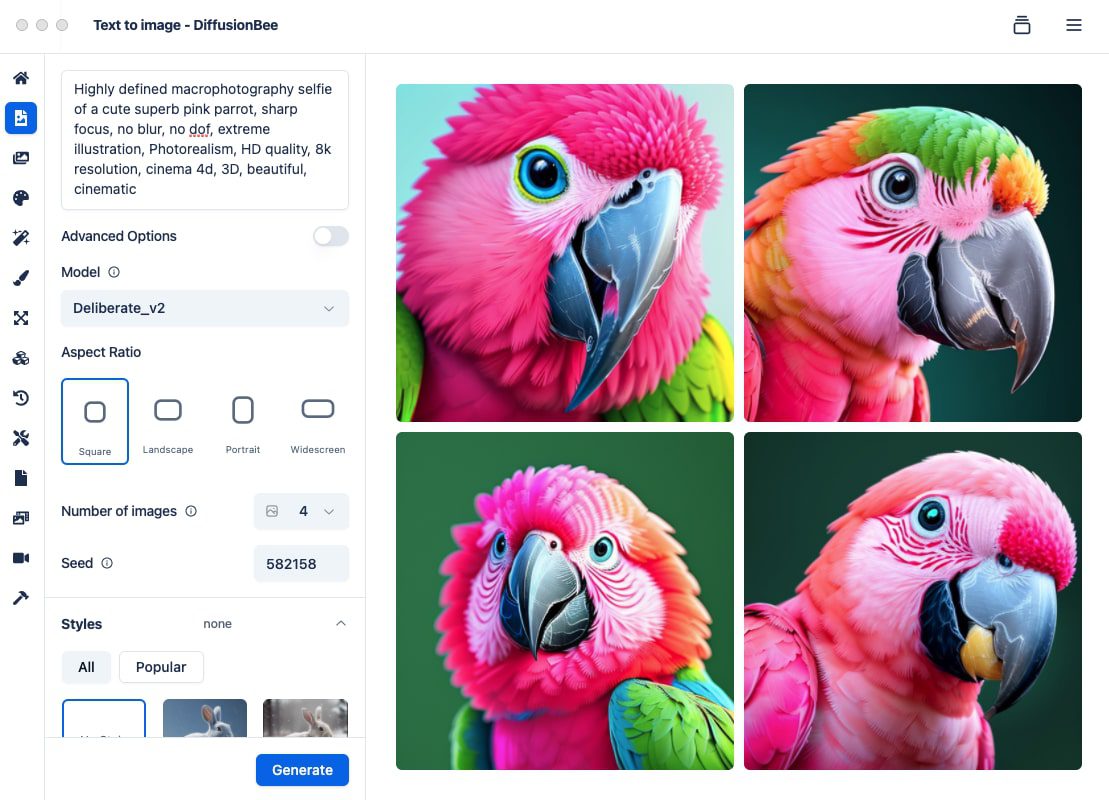

- 图像理解和描述能力

- 集成JavaScript解释器的代码运算功能

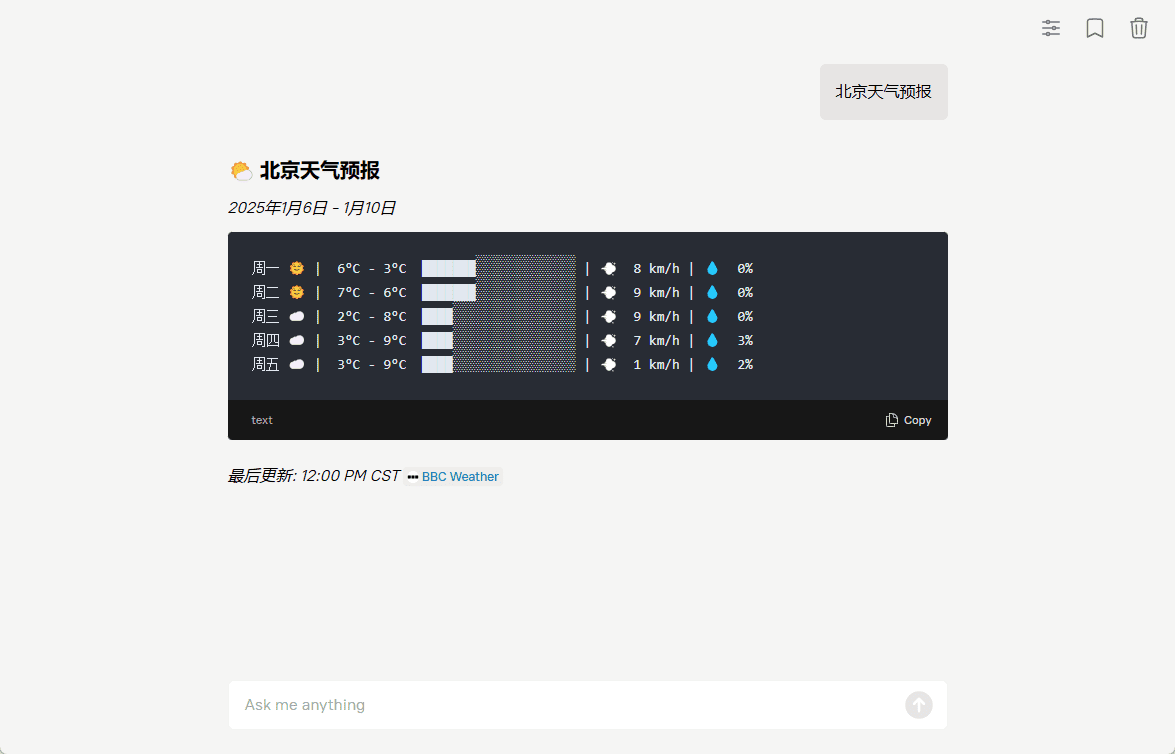

- ASCII艺术天气预报生成

- 支持Docker容器化部署

- 提供REST API接口服务

- 支持自定义工具扩展

- 支持多种硬件配置部署选项

使用帮助

1. 部署方式选择

系统提供两种使用方式:本地部署和云端API调用。

本地部署流程:

- 硬件要求确认:

- diffbot-small模型:最低需要Nvidia A100 40G显卡

- diffbot-small-xl模型:最低需要2个Nvidia H100 80G显卡(FP8格式)

- Docker部署步骤:

# 1. 拉取Docker镜像

docker pull docker.io/diffbot/diffbot-llm-inference:latest

# 2. 运行Docker容器(模型会自动从HuggingFace下载)

docker run --runtime nvidia --gpus all -p 8001:8001 --ipc=host \

-e VLLM_OPTIONS="--model diffbot/Llama-3.1-Diffbot-Small-2412 --served-model-name diffbot-small --enable-prefix-caching" \

docker.io/diffbot/diffbot-llm-inference:latest

云端API调用:

- 获取访问凭证:

- 访问 https://app.diffbot.com/get-started 注册并获取免费的开发者token

- Python代码示例:

from openai import OpenAI

client = OpenAI(

base_url = "https://llm.diffbot.com/rag/v1",

api_key = "你的diffbot_token"

)

# 创建对话请求

completion = client.chat.completions.create(

model="diffbot-xl-small",

temperature=0,

messages=[

{

"role": "user",

"content": "你的问题"

}

]

)

print(completion)

2. 核心功能使用说明

- 网页内容提取:

- 系统可以实时处理任何网页URL

- 自动提取关键信息并生成摘要

- 保持原始源引用的完整性

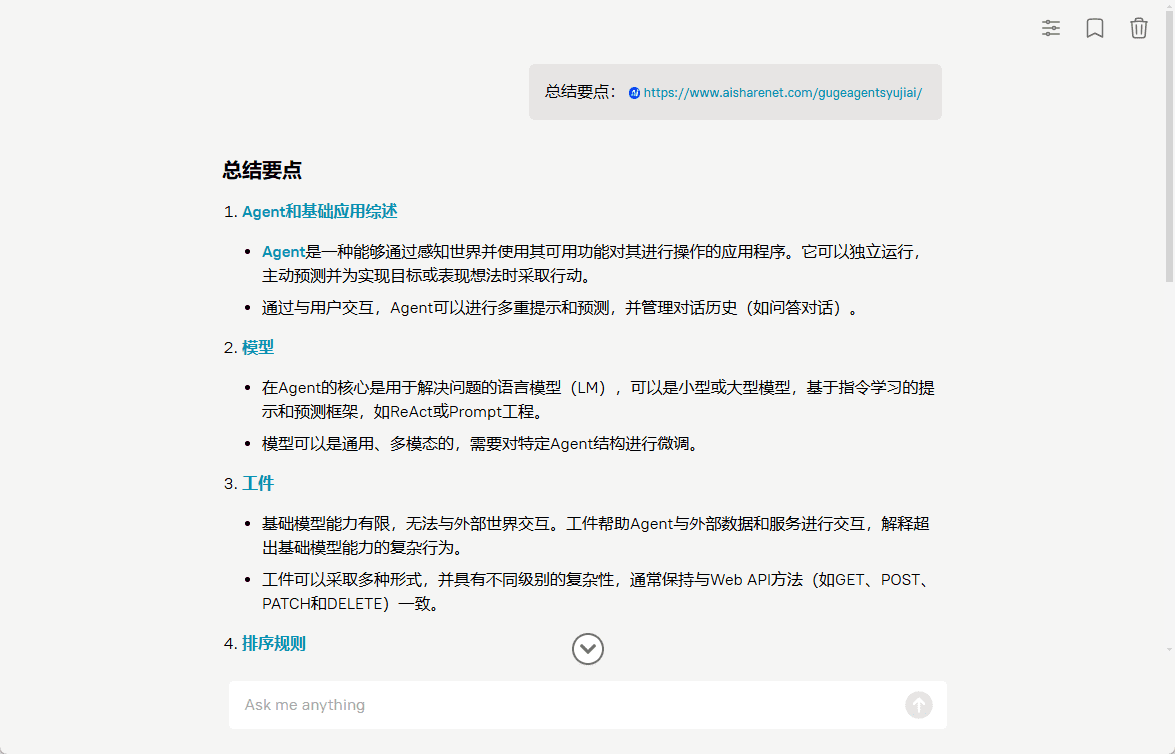

- 知识图谱查询:

- 使用Diffbot查询语言(DQL)进行精确检索

- 支持复杂的知识关系查询

- 实时更新的知识库访问

- 图像处理能力:

- 支持图像理解和描述

- 可以结合文本生成相关的图像分析

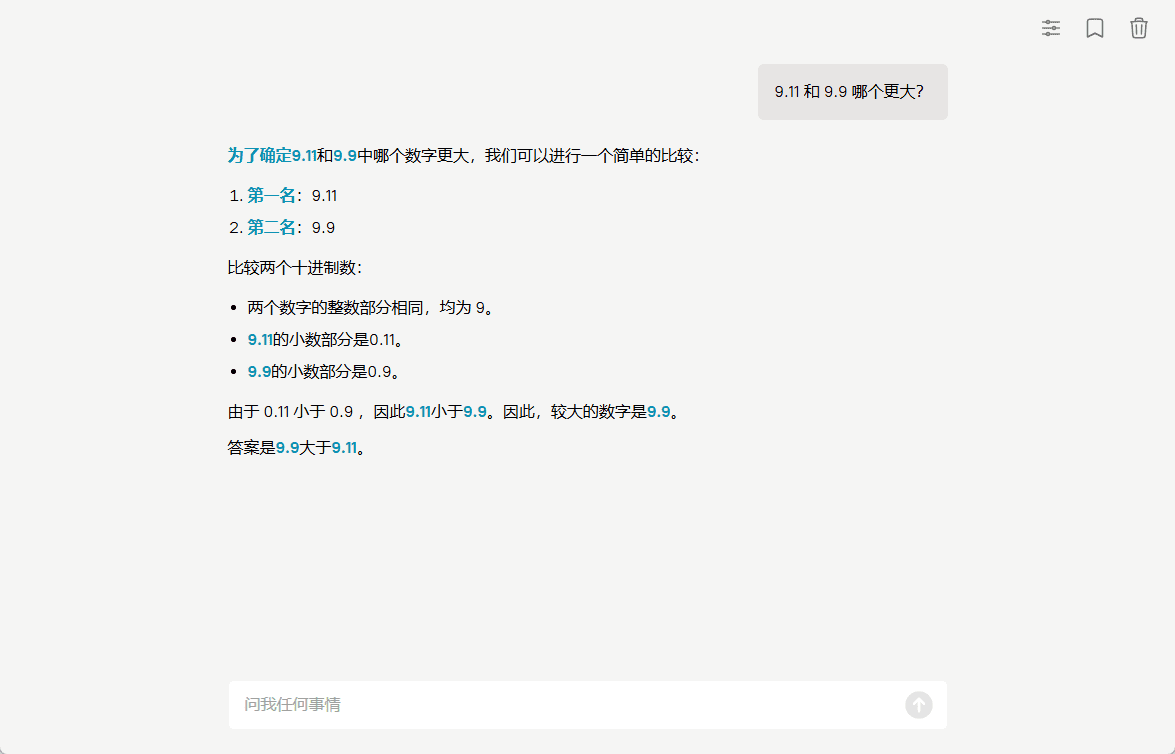

- 代码解释功能:

- 内置JavaScript解释器

- 支持实时数学计算

- 可进行简单的程序逻辑处理

3. 自定义工具扩展

如需扩展新功能,可参考项目中的add_tool_to_diffbot_llm_inference.md文档,按步骤添加自定义工具。

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...