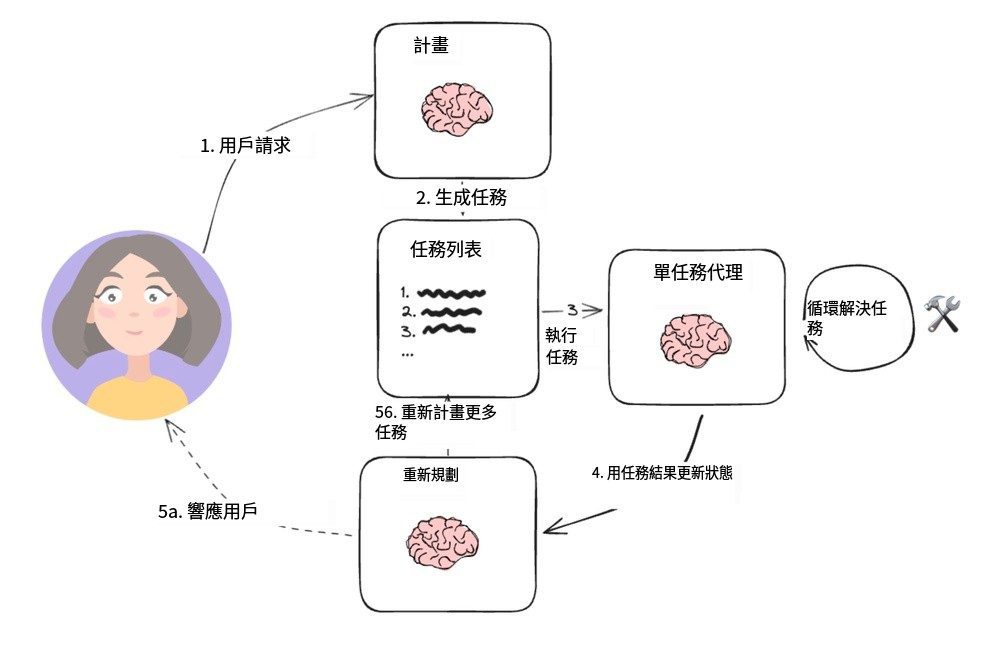

比RAG(检索增强生成)快40倍的CAG(缓存增强生成)。CAG彻底改变了知识获取方式:不再是实时检索外部数据,而是预先将所有知识加载到模型上下文中。这就像是把一个巨大的图书馆浓缩成了一本随身携带的工具书,需要时直接翻阅即可。CAG的实现原理也很优雅:

- 首先对文档进行预处理,确保能装进 LLM 的上下文窗口

- 然后将处理好的内容编码进 Key-Value 缓存

- 最后把这个缓存存储在内存或硬盘中,以备随时调用

实验结果令人信服:在 HotPotQA 和 SQuAD 等基准数据集上,CAG 不仅速度快了40倍,准确率和连贯性也有显著提升。这归功于它能全局把握上下文,不会出现检索错误或数据不完整的问题。

从实际应用看,这项技术在医疗诊断、金融分析、客户服务等领域都大有可为。它让 AI 系统既能保持高性能,又避免了复杂架构带来的维护负担。

说到底,CAG 的革新在于:它把“随用随取”变成了“带着走”,这不仅提升了效率,更为 AI 落地打开了新的可能性。这或许就是下一代 AI 架构的标配。

参考文献:

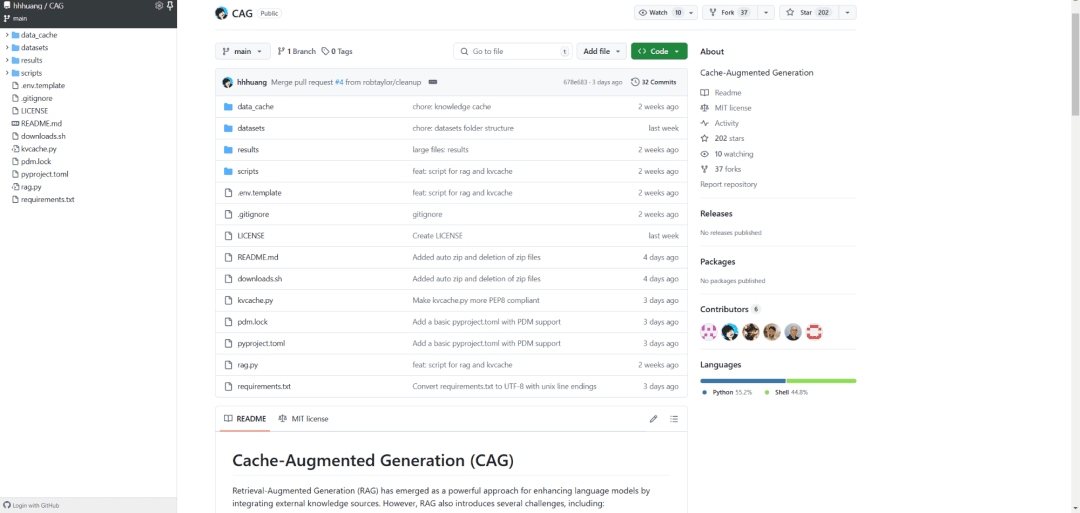

[1] https://github.com/hhhuang/CAG

[2] https://arxiv.org/abs/2412.15605

[3] Long-context LLMs Struggle with Long In-context Learning:https://arxiv.org/pdf/2404.02060v2

© 版权声明

文章版权归 AI分享圈 所有,未经允许请勿转载。

相关文章

暂无评论...