ByteDance и другие выпустили первую 1,58-битную модель квантования FLUX с уменьшением параметров на 99,51 TP3T, что сравнимо с прецизионной FLUX!

Анализ выделений

- 1,58-бит FLUXПервым будет FLUX визуально Трансформатор параметров (всего 11,9 млрд) уменьшается на 99,5% до 1,58-битной модели квантования, что устраняет необходимость полагаться на данные изображения и значительно снижает требования к хранению.

- Разработано эффективное линейное ядро, оптимизированное для 1,58-битных вычислений, что позволило добиться значительного сокращения памяти и ускорения вывода.

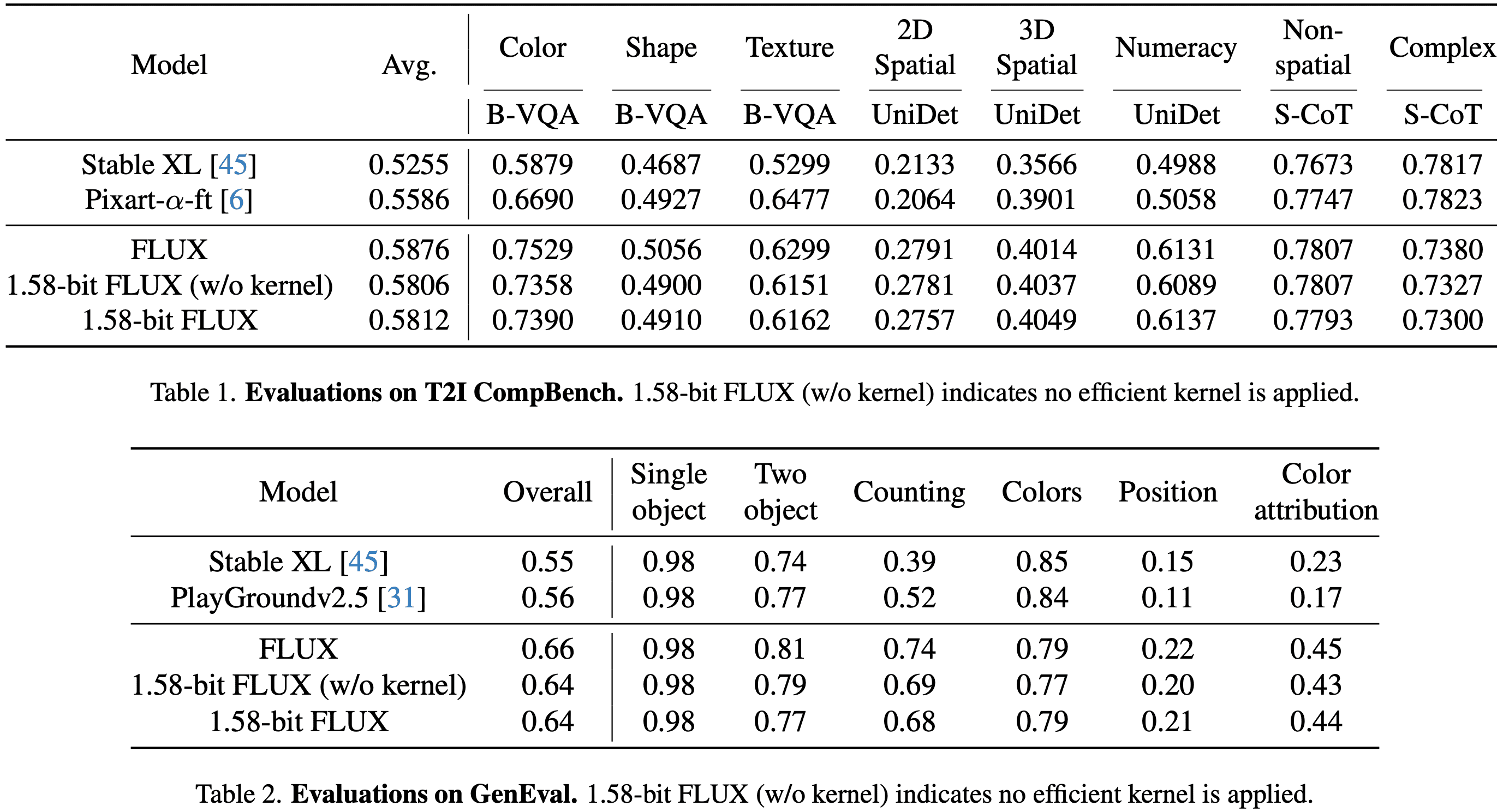

- доказать 1,58-бит FLUX В сложном бенчмарке T2I производительность была сопоставима с полной точностью модели FLUX.

Краткое содержание

Проблемы решены

- Существующие модели преобразования текста в изображение (T2I), такие как DALLE 3 и Stable Diffusion 3, имеют огромное количество параметров и требуют много памяти для вывода, что затрудняет их развертывание на устройствах с ограниченными ресурсами (например, мобильных устройствах).

- В данной работе рассматривается возможность использования квантования с очень малым количеством бит (1,58 бит) в моделях T2I для снижения требований к хранению и памяти при одновременном повышении эффективности выводов.

Предлагаемая программа

- В качестве объекта квантования была выбрана модель FLUX.1-dev, и ее веса были сжаты до 1,58 бита (со значениями, ограниченными {-1, 0, +1}) методом квантования после обучения без доступа к данным изображения.

- Разработка специализированных ядер для оптимизации операций с младшими битами для дальнейшего повышения эффективности вычислений.

Применяемые технологии

- Количественное определение веса 1,58 бит: Чрезвычайно низкая битизация достигается за счет сжатия весов линейного слоя модели до 1,58 бита с помощью метода, аналогичного BitNet b1.58, и хранения весов в виде 2-битных знаковых целых чисел.

- Неконтролируемые количественные методы: опирается исключительно на механизм самоконтроля самой модели FLUX.1-dev и не нуждается в использовании схем смешанной точности или дополнительных обучающих данных.

- Индивидуальное ядро: Ядро выводов, оптимизированное для выполнения малоразрядных операций, что позволяет сократить потребление памяти и задержку выводов.

перфоратор

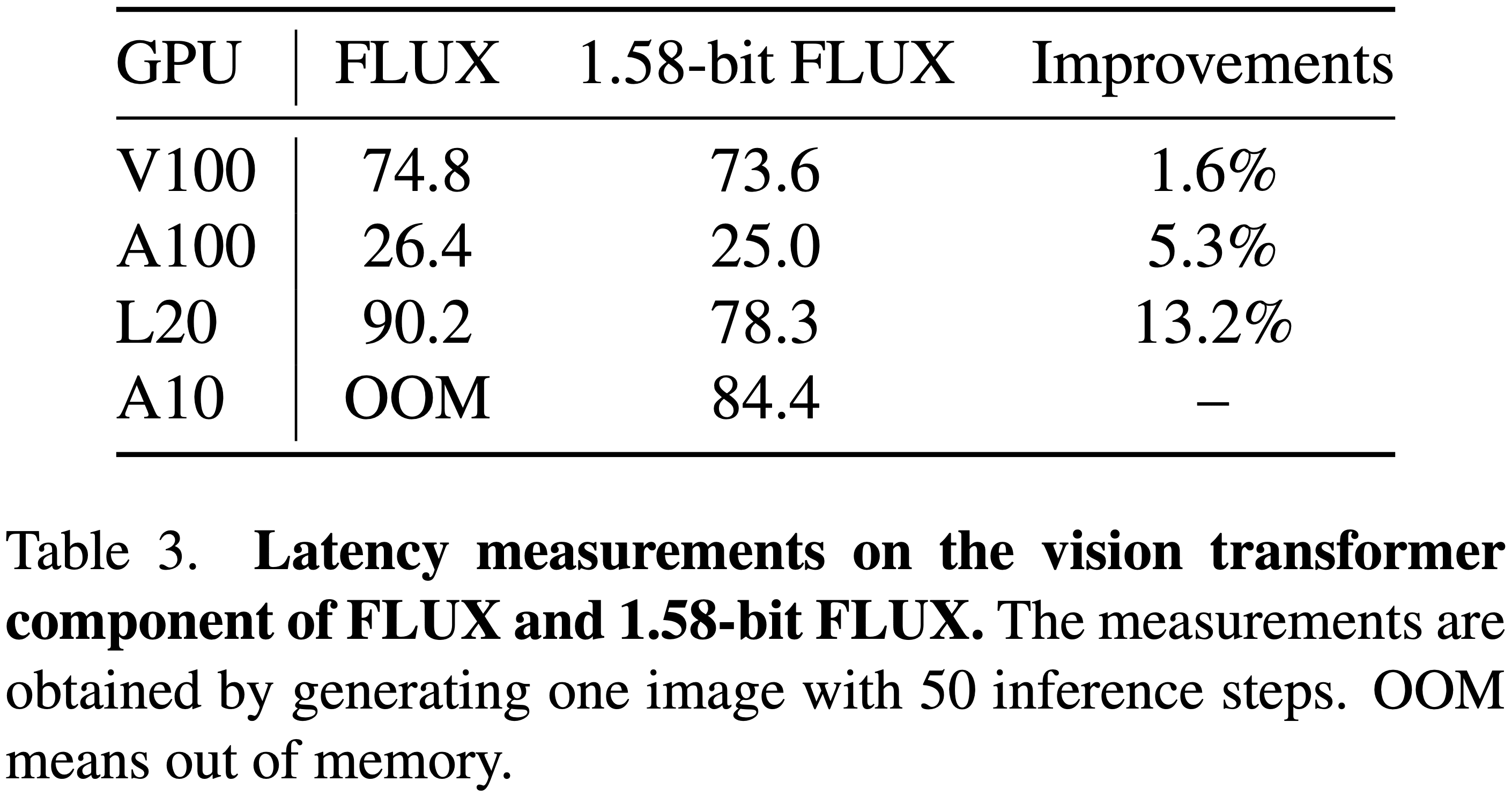

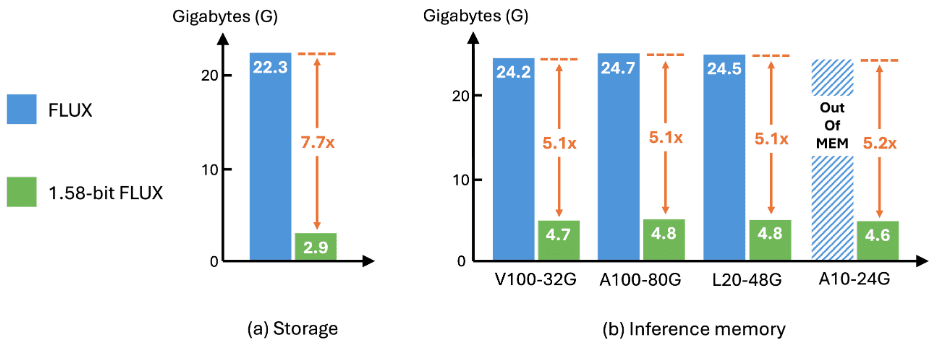

- Эффективность хранения: Требования к хранению модели уменьшены на 7,7×, сжатие с 16 бит до 2 бит.

- Эффективность рассуждений: Использование памяти во время вычислений сократилось на 5,1×, а задержка вычислений значительно улучшилась.

- Создание качества: На бенчмарках GenEval и T2I Compbench качество генерации практически не уступает качеству генерации FLUX с полной точностью, что подтверждает эффективность и полезность схемы.

Результаты

устанавливать

количественная оценка: Количественная оценка проводилась с использованием калиброванного набора данных, состоящего из подсказок из набора данных Parti-1k и обучающего набора T2I CompBench, в общей сложности 7 232 подсказки. Весь процесс полностью независим от данных изображения, и никаких дополнительных наборов данных не требуется. Количественная оценка сжимает все веса линейных слоев FluxTransformerBlock и FluxSingleTransformerBlock в FLUX до 1,58 бита, что составляет 99,5% от общего числа параметров модели.

оценка: Оценка FLUX и 1,58-битного FLUX на наборе данных GenEval и наборе данных для проверки T2I CompBench после официального процесса генерации изображений.

- Набор данных GenEval: Содержит 553 подсказки, каждая из которых генерирует 4 изображения.

- T2I CompBench Validation SetОценка проводилась по 8 категориям с 300 подсказками в каждой категории, каждая подсказка генерировала 10 изображений, что в общей сложности составило 24 000 изображений для оценки.

- Все изображения получены с разрешением 1024 × 1024 для FLUX и 1,58-битного FLUX.

в конце концов

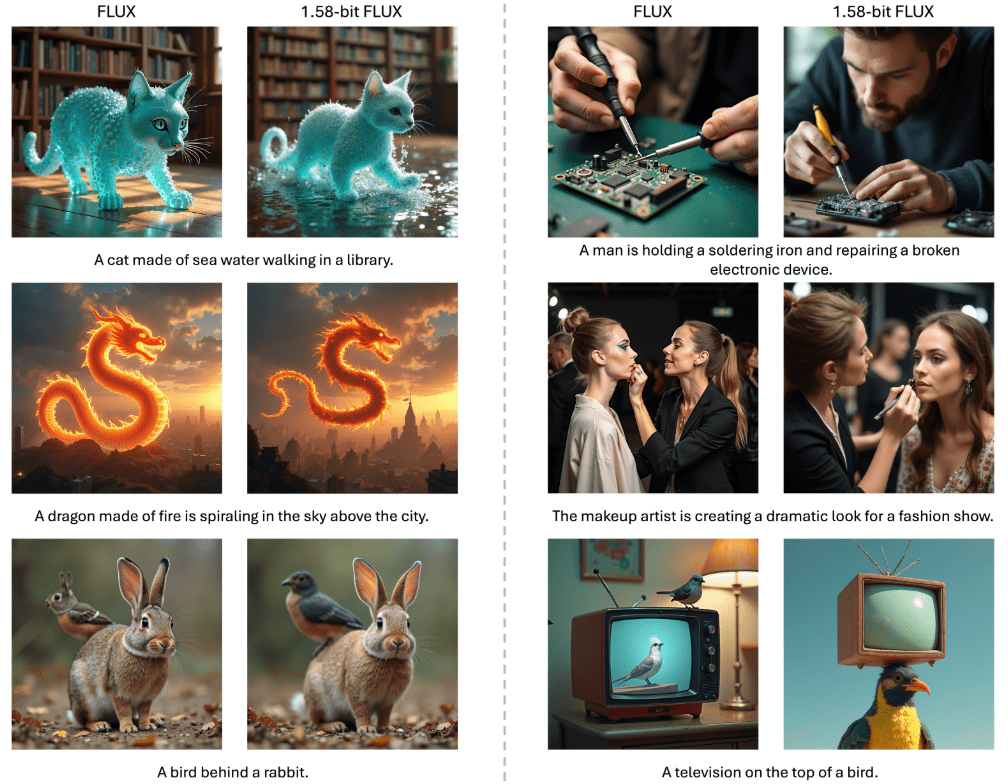

спектакли: Производительность 1,58-битного FLUX сравнима с производительностью FLUX с полной точностью в бенчмарках T2I Compbench и GenEval, как показано в таблицах 1 и 2. Изменения производительности минимальны до и после применения пользовательского линейного ядра, что еще раз подтверждает точность реализации.

эффективностьКак показано на рисунке 2 ниже, 1,58-битный FLUX обеспечивает значительные улучшения в хранении моделей и памяти для выводов. С точки зрения задержки вычислений, как показано в Таблице 3, улучшение особенно значительно на низкопроизводительных, но легко развертываемых GPU, таких как L20 и A10.

Заключение и обсуждение

В данной работе представлены 1,58-бит FLUXВ случае 99.5% параметр Transformer был квантован до 1,58 бита, а следующие улучшения были достигнуты за счет настройки вычислительного ядра:

- Снижение требований к хранению: Сокращение потребностей в хранении моделей в 7,7 раза.

- Снижение памяти на умозаключения: Сокращение использования памяти для выводов более чем в 5,1 раза.

Несмотря на эти эффекты сжатия, 1,58-битный FLUX показал сопоставимую с полноточечной моделью производительность в бенчмарках T2I, сохранив при этом высокое визуальное качество. Есть надежда, что 1,58-бит FLUX Уметь мотивировать сообщества на разработку моделей, более подходящих для мобильных устройств.

Текущие ограничения

Ограничения на повышение скорости

- Хотя 1,58-битный FLUX уменьшает размер модели и потребление памяти, его улучшение задержки ограничено из-за отсутствия квантования значений активации и более продвинутых оптимизаций ядра.

- Учитывая достигнутые на данный момент результаты, можно надеяться, что сообщество будет мотивировано на разработку собственных реализаций ядра для 1,58-битной модели.

Об ограничениях визуального качества

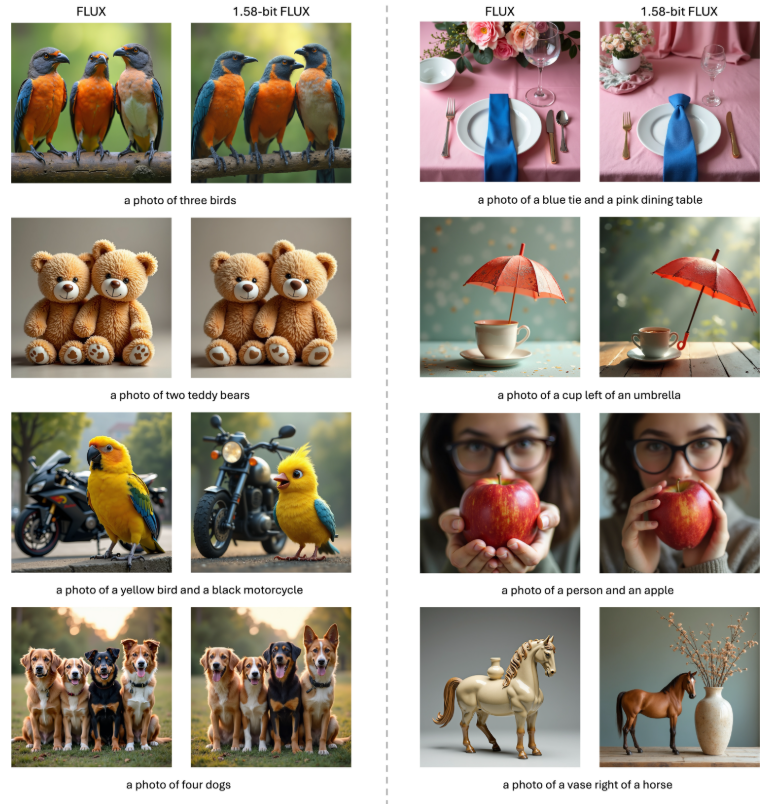

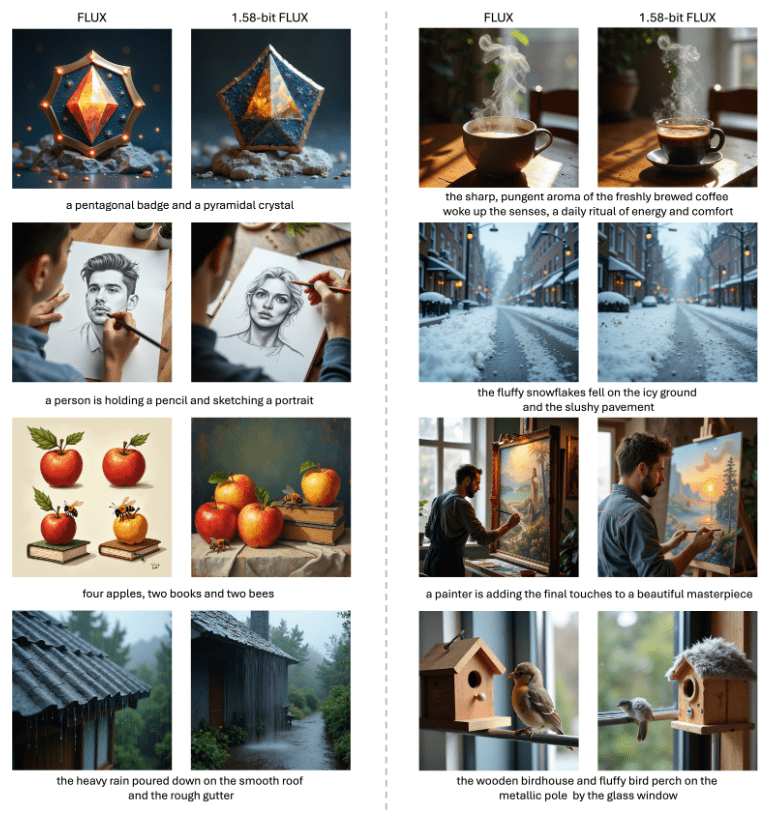

- Как показано на рисунках 1, 3 и 4 ниже, 1,58-битный FLUX создает яркие и реалистичные изображения, полностью соответствующие текстовым подсказкам, но все же отстает от оригинальной модели FLUX при воспроизведении деталей сверхвысокого разрешения.

- В будущих исследованиях планируется устранить этот пробел.

- Визуальное сравнение FLUX с 1,58-битным FLUX. 1,58-битный FLUX демонстрирует качество генерации, сравнимое с FLUX с 1,58-битным квантованием, где 99,5% параметров визуального трансформатора 11,9B ограничены значением +1, -1 или 0. Для согласованности все изображения в каждом сравнении генерировались с использованием одного и того же входа скрытого шума. 1,58-битный FLUX использует пользовательское 1,58-битное ядро. Для согласованности все изображения в каждом сравнении были сгенерированы с использованием одного и того же потенциально шумного входа. 1.58-битный FLUX использует пользовательское 1,58-битное ядро.

Коды выводов и весовые коэффициенты выпускаются: https://github.com/Chenglin-Yang/1.58bit.flux

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...

![ICLR 惊现[10,10,10,10]满分论文,ControlNet作者新作——IC-Light V2适配Flux](https://aisharenet.com/wp-content/uploads/2024/12/8989dba3bb6d866.png)