XRAG: инструмент визуальной оценки для оптимизации систем генерации улучшенных поисковых запросов

Общее введение

XRAG (eXamining the Core) - это система бенчмаркинга, предназначенная для оценки базовых компонентов передовых систем расширения поиска (RAG). Благодаря профилированию и анализу каждого основного модуля XRAG позволяет понять, как различные конфигурации и компоненты влияют на общую производительность системы RAG. Система поддерживает множество методов поиска и метрик оценки и призвана помочь исследователям и разработчикам оптимизировать и улучшить все аспекты систем RAG.

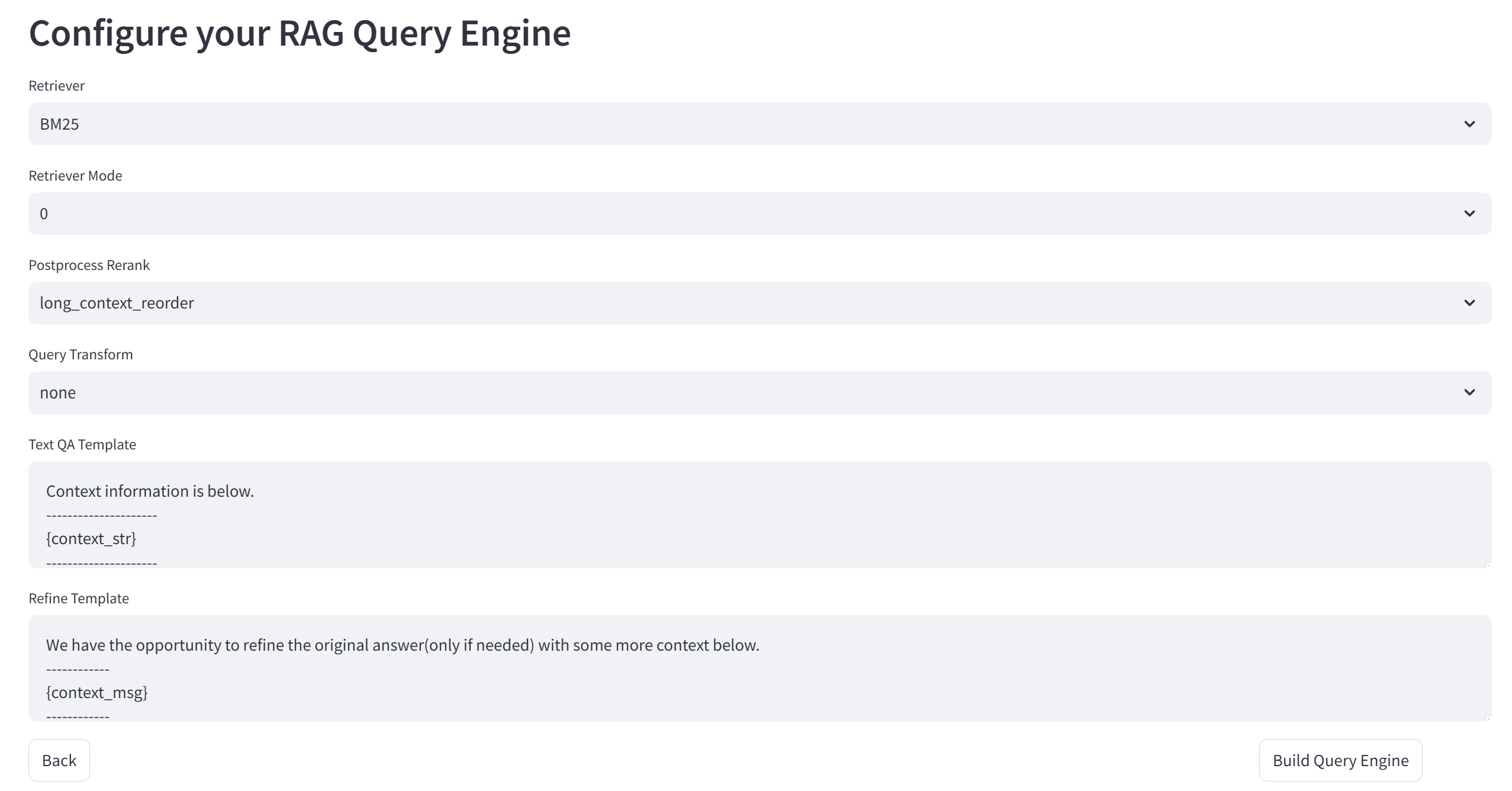

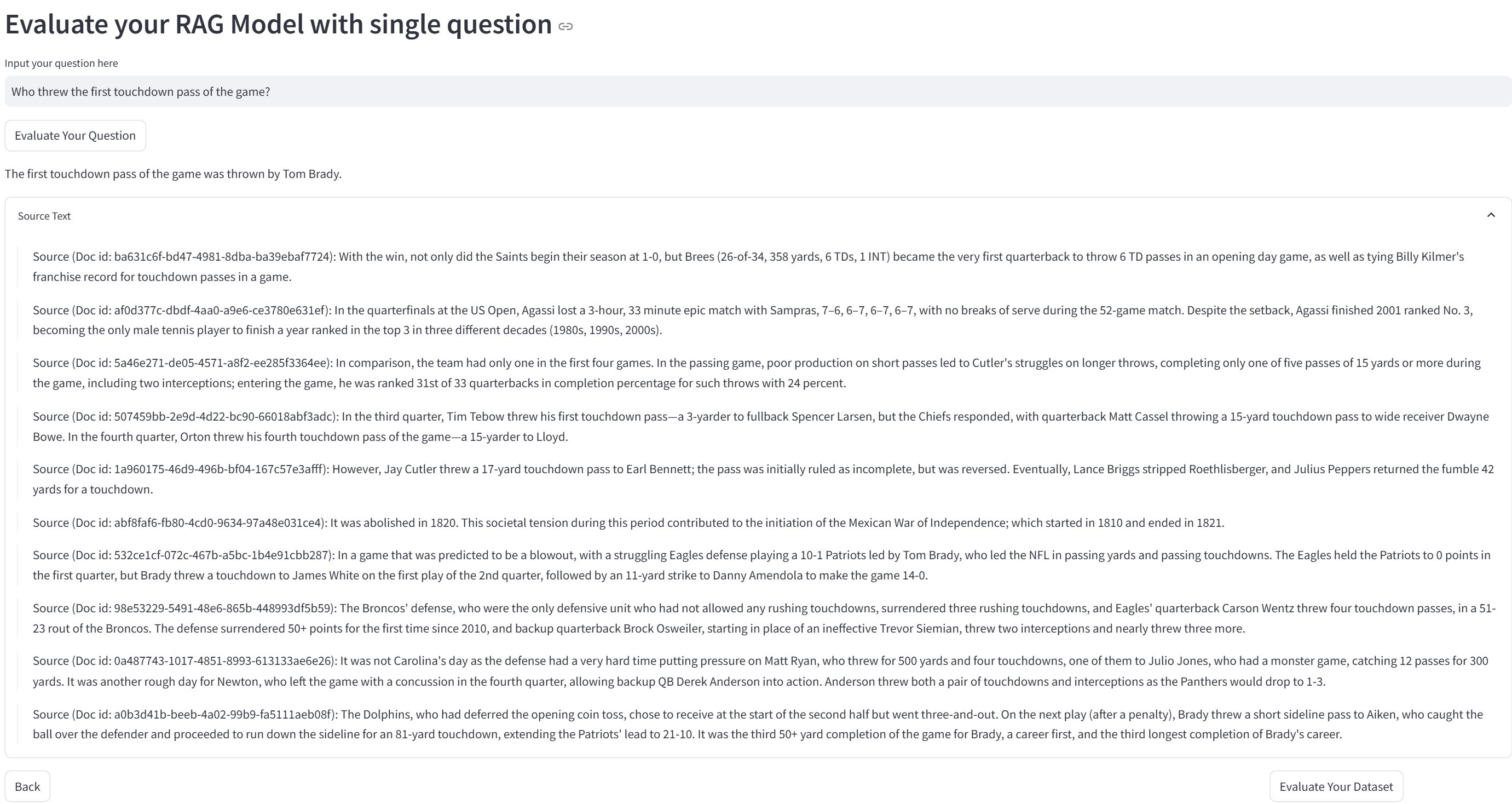

XRAG поддерживает комплексный бенчмарк и инструментарий для оценки RAG, охватывающий более 50+ тестовых метрик, комплексную оценку RAG и оптимизацию точек отказа, поддерживает сравнение 4 типов модулей Advanced RAG (Query Reconstruction, Advanced Retrieval, Question and Answer Models и Post-Processing), интегрирует множество конкретных реализаций в рамках модулей и поддерживает OpenAI Big Model API. XRAG версии 1.0 также предоставляет простой демонстрационный веб-интерфейс, легкую интерактивную загрузку данных и унифицированный стандартный формат, а также интегрирует методы обнаружения сбоев и оптимизации RAG. Статья и код теперь с открытым исходным кодом.

Список функций

- Система комплексной оценки: Поддержка многомерных оценок, включая оценки на основе LLM, углубленные оценки и традиционные показатели.

- Гибкая архитектура: Модульная конструкция для поддержки различных методов поиска и индивидуальных стратегий поиска.

- Поддержка нескольких ЛЛМ: Бесшовная интеграция с моделями OpenAI и поддержка собственных моделей (например, Qwen, LLaMA и т.д.).

- Богатый набор показателей оценки:: Включает традиционные метрики (F1, EM, MRR и т.д.) и метрики на основе LLM (правдивость, релевантность и т.д.).

- Дополнительные методы поиска: Поддержка BM25, векторного семантического поиска, поиска по древовидной структуре и других методов поиска.

- удобный интерфейс: Предоставляет интерфейс командной строки и веб-интерфейс для поддержки интерактивной оценки и визуализации.

Использование помощи

Процесс установки

- склад клонов::

git clone https://github.com/DocAILab/XRAG.git

cd XRAG

- Установка зависимостей::

pip install -r requirements.txt

- Конфигурационная среда: Модифицируется по мере необходимости

config.tomlфайл для настройки параметров модели и параметров API.

Руководство по использованию

- Запуск веб-интерфейса::

xrag-cli webui

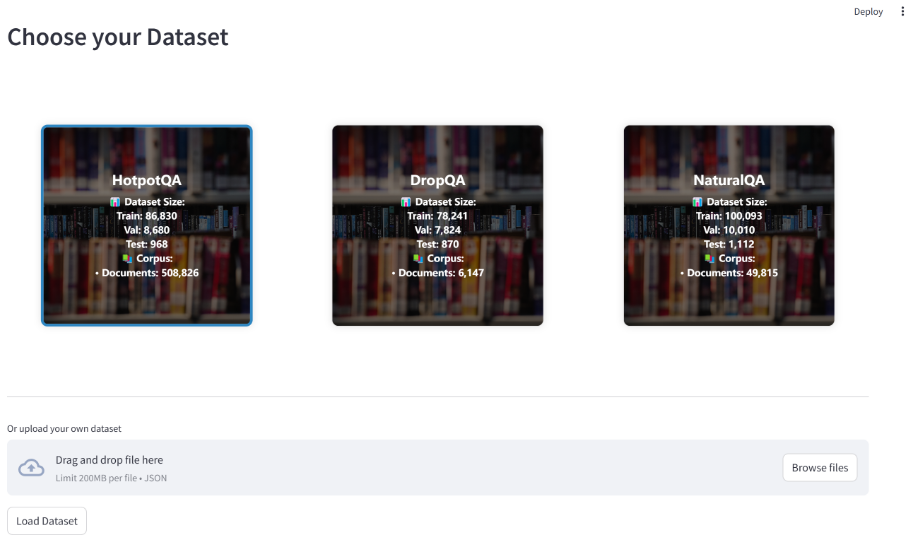

Загрузка и настройка наборов данных через веб-интерфейс с поддержкой нескольких эталонных наборов данных (например, HotpotQA, DropQA, NaturalQA).

- Оперативная оценка: Запустите оценку с помощью инструмента командной строки:

xrag-cli evaluate --dataset <dataset_path> --config <config_path>

По результатам оценки создаются подробные отчеты и графики визуализации.

- Индивидуальные стратегии поиска: Модификация

src/xragкод каталога для добавления или корректировки стратегий поиска и моделей оценки.

Основные функции

- Загрузка и настройка наборов данных: Загрузите набор данных через веб-интерфейс и настройте его необходимым образом.

- Оценочные прогоны: Выберите показатели оценки и методы поиска, запустите оценку и просмотрите результаты.

- Анализ результатов: Анализ результатов оценки и оптимизация работы системы с помощью созданных отчетов и визуальных диаграмм.

Система Ollama Framework: эффективное локализованное обоснование поиска в XRAG

Ollama играет важную роль в системе локализованных поисковых выводов XRAG-Ollama. Являясь простым в использовании фреймворком с открытым исходным кодом для запуска локальных больших моделей, Ollama предоставляет XRAG мощные возможности локализованного поиска, позволяя XRAG использовать все преимущества генерации улучшений поиска.

Зачем локализовать развертывание XRAG?

- Снижение внешнего риска: Использование локального развертывания снижает зависимость от внешних сервисов и уменьшает потенциальные риски, связанные с нестабильной работой сторонних сервисов или утечкой данных.

- Доступность в режиме офлайн: Локализованная система RAG не зависит от подключения к Интернету и может нормально работать даже в случае отключения сети, обеспечивая непрерывность и стабильность обслуживания.

- Автономное управление даннымиЛокальное развертывание дает пользователям полный контроль над тем, как хранятся, управляются и обрабатываются данные, например, путем встраивания частных данных в локальные векторные базы данных, обеспечивая обработку данных в соответствии с собственными стандартами безопасности и бизнес-требованиями организации.

- Конфиденциальность и безопасность данных: Работа системы RAG в локальной среде позволяет избежать риска компрометации конфиденциальных данных при передаче их по сети и гарантирует, что данные всегда находятся под локальным контролем. Это особенно важно для организаций, работающих с конфиденциальной информацией.

Почему именно Ollama?

Ollama - это легкий, расширяемый фреймворк для создания и запуска крупномасштабных языковых моделей (LLM) на локальной машине. Он предоставляет простой API для создания, запуска и управления моделями, а также библиотеку готовых моделей, которые могут быть легко использованы в различных приложениях. Он не только поддерживает широкий спектр моделей, таких как DeepSeek, Llama 3.3, Phi 3, Mistral, Gemma 2 и т. д., но и способен использовать преимущества современных аппаратных ускоренных вычислений, обеспечивая высокопроизводительную поддержку выводов для XRAG. Кроме того, Ollama поддерживает квантование моделей, что позволяет значительно снизить требования к графической памяти. Например, 4-битное квантование сжимает весовые параметры с точностью FP16 до 4-битной целочисленной точности, что значительно уменьшает объем веса модели и графической памяти, необходимой для вывода. Это позволяет запускать большие модели на обычном домашнем компьютере.

В сочетании с Ollama XRAG позволяет эффективно запускать крупномасштабные языковые модели локально, не прибегая к сложным конфигурациям среды и большим объемам вычислительных ресурсов, что значительно снижает затраты на развертывание и эксплуатацию. В то же время решение для локального развертывания дает разработчикам полный контроль над обработкой данных, поддерживая всю цепочку настройки от очистки исходных данных, векторной обработки (например, создание частной базы знаний с помощью ChromaDB) до конечной реализации приложения. Архитектура локального развертывания на основе инфраструктуры, естественно, способна работать в автономном режиме, что не только обеспечивает непрерывность обслуживания, но и отвечает жестким требованиям к надежности системы в специальных средах (например, в засекреченных сетях и т. д.).

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...