Маленькая модель, большая мощь: QwQ-32B с параметрами 1/20 для борьбы с полнокровным DeepSeek-R1

В последнее время в области ИИ наблюдаются впечатляющие успехи, особенно в улучшении способности к рассуждениям больших языковых моделей (LLM). Среди них Reinforcement Learning (RL) становится ключевой технологией, позволяющей преодолеть узкое место в производительности традиционных моделей. Многие исследования подтвердили, что RL может значительно повысить способность моделей к рассуждениям. Например, модель DeepSeek R1 достигла глубокого мышления и сложных рассуждений благодаря интеграции данных холодного старта и многоступенчатого обучения, достигнув лидирующего уровня на тот момент.

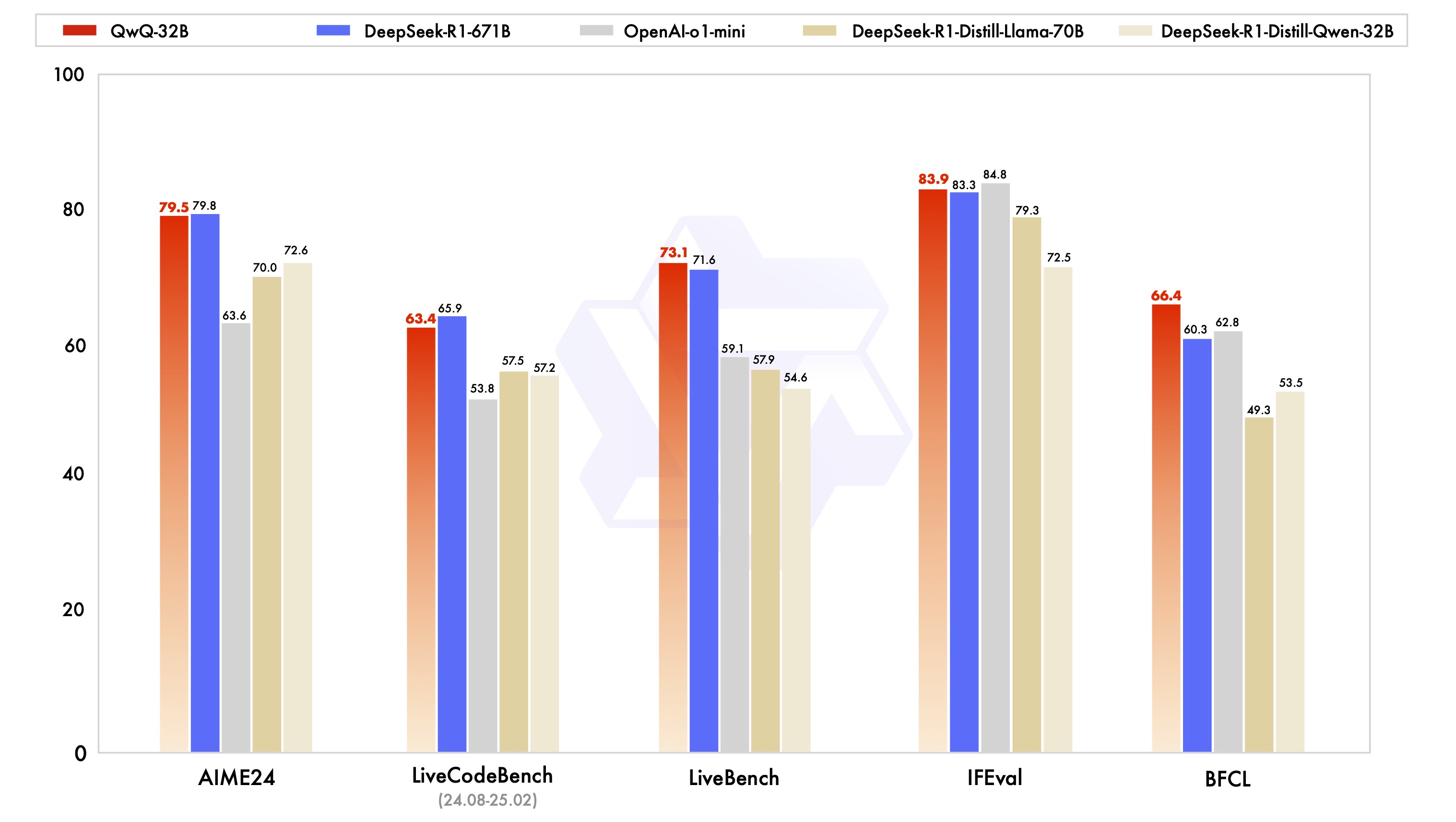

На этом фоне AliCloud выпустила модель QwQ-32B, которая вновь привлекла внимание индустрии. Эта модель с 32 миллиардами параметров сопоставима по производительности с DeepSeek-R1 модель, которая имеет большое количество параметров - 671 миллиард (37 миллиардов активированных параметров). Выдающаяся производительность QwQ-32B является убедительной демонстрацией эффективности обучения с подкреплением в улучшении интеллекта мощных базовых моделей, предварительно обученных на массивных знаниях о мире.

Более того, компания Aliyun включила в модель рассуждений QwQ-32B возможности, связанные с агентами, что позволяет ему не только критически мыслить, но и использовать инструменты и корректировать процесс рассуждений на основе обратной связи с окружающей средой. Эти технологические достижения демонстрируют преобразующий потенциал технологии RL и прокладывают путь к общему искусственному интеллекту (AGI).

В настоящее время QwQ-32B выпущен на платформах Hugging Face и ModelScope под протоколом Apache 2.0 с открытым исходным кодом, и пользователи могут получить к нему доступ через Чат с друзьями Опыт.

Введение

QwQ - это модель умозаключений из семейства моделей "Qwen". По сравнению с традиционными моделями тонкой настройки инструкций, модели QwQ обладают более сильными способностями к мышлению и рассуждениям и показывают значительный прирост производительности в задачах, требующих более низкого уровня, особенно при решении сложных головоломок. qwQ-32B, как модель умозаключений среднего размера, имеет производительность сопоставима с такими продвинутыми моделями умозаключений, как DeepSeek-R1 и o1-mini.

Особенности модели.

- типология: Причинные языковые модели

- этап обученияПредварительное и последующее обучение, включая контролируемую настройку и обучение с подкреплением.

- построить: Структура трансформеров с позиционным кодированием RoPE, функцией активации SwiGLU, нормализацией RMSNorm и смещением УГ внимания Смещение механизма внимания

- шкала параметров: 32,5 миллиарда долларов (32,5B)

- Размеры параметров не встроенного слоя: 31 миллиард долларов (31.0B)

- этаж: 64

- Начальники отдела внимания (GQA): 40 на стороне запросов и 8 на стороне ключей/значений.

- Длина контекста: Полная версия 131 072 жетоны

принимать к сведению: Для наилучшего восприятия обязательно обратитесь к Руководство по использованию Модель QwQ будет развернута позже.

Пользователи могут использовать Демоверсия Переживите опыт или пройдите через QwenChat Чтобы получить доступ к модели QwQ, не забудьте открыть Thinking (QwQ).

Для получения более подробной информации, пожалуйста, обратитесь к Репозитории GitHub слишком официальный документ.

Производительность

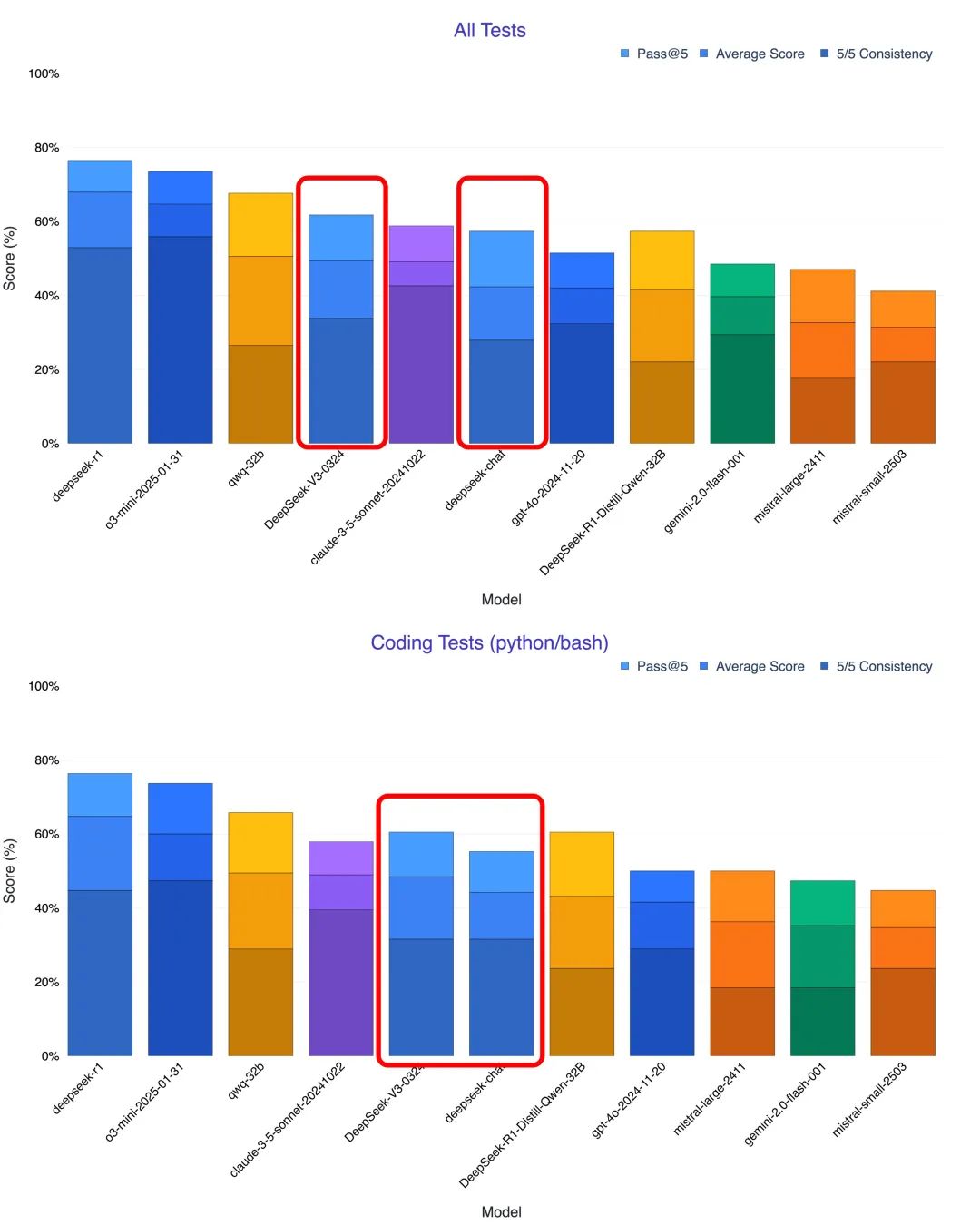

Модель QwQ-32B была оценена в серии эталонных тестов, призванных дать полное представление о ее возможностях в математических рассуждениях, написании кода и решении общих задач. На диаграмме ниже показана производительность QwQ-32B по сравнению с другими ведущими моделями, включая DeepSeek-R1-Distilled-Qwen-32B, DeepSeek-R1-Distilled-Llama-70B, o1-mini и оригинальный DeepSeek-R1.

Судя по результатам, QwQ-32B демонстрирует схожую или даже лучшую производительность по сравнению с топовыми моделями в нескольких ключевых бенчмарках. Особенно примечательно, что QwQ-32B сохраняет конкурентоспособность по сравнению с DeepSeek-R1, которая имеет гораздо большее количество параметров, чем QwQ-32B, что еще раз доказывает большой потенциал обучения с подкреплением в улучшении производительности модели.

Обучение с применением подкрепления

Выдающаяся производительность QwQ-32B во многом обусловлена технологией Reinforcement Learning (RL), лежащей в его основе. Проще говоря, обучение с подкреплением - это метод, который заставляет модель учиться принимать оптимальные решения в заданной среде с помощью механизмов вознаграждения или наказания. В отличие от традиционного контролируемого обучения, Reinforcement Learning не опирается на большие объемы маркированных данных, а взаимодействует с окружающей средой и учится методом проб и ошибок, в конечном итоге осваивая стратегии, необходимые для выполнения задачи.

Во время обучения QwQ-32B исследовательская группа Aliyun внедрила метод расширения обучения с подкреплением, основанный на вознаграждении за результат, начиная с контрольной точки холодного старта. На начальном этапе они сосредоточились на расширении RL для задач по математике и коду. Вместо того чтобы полагаться на традиционные модели вознаграждения, команда использовала верификатор точности для математических вопросов, чтобы убедиться в правильности окончательных ответов, и сервер выполнения кода, чтобы оценить, успешно ли сгенерированный код прошел заданные тестовые примеры.

По мере обучения производительность модели как в математической области, так и в области кода постоянно улучшалась. После первого этапа исследовательская группа добавила этап обучения RL для общих возможностей. В этой фазе обучения использовались сигналы вознаграждения из общей модели вознаграждения и ряд валидаторов, основанных на правилах. Результаты эксперимента показали, что небольшое количество этапов обучения RL может эффективно улучшить общие возможности модели с точки зрения соблюдения инструкций, согласования предпочтений человека и производительности агента, не вызывая значительного снижения производительности в математических и кодовых возможностях.

Вот статья о том, почему Qwen-2.5-3B обладает прекрасными способностями к рассуждению:Как большие модели становятся "умнее"? Стэнфордский университет раскрывает ключ к самосовершенствованию: четыре вида когнитивного поведения

Рекомендации по использованию

Для оптимальной работы рекомендуется использовать следующие настройки:

- Заставляя модели думать о выходе:: Убедитесь, что модели моделируются с помощью

<think>\nчтобы избежать генерации пустого мыслительного содержимого, что может снизить качество вывода. Если вы используетеapply_chat_templateи установитьadd_generation_prompt=TrueЭто выполняется автоматически. Однако обратите внимание, что это может привести к тому, что ответ будет отсутствовать в начале<think>Маркировка, что вполне нормально. - Параметры выборки:

- пользоваться

Temperature=0.6ответить пениемTopP=0.95Вместо Greedy decoding, чтобы избежать бесконечных повторений. - пользоваться

TopKОт 20 до 40, чтобы отсеять редкие Токен появляются, сохраняя при этом разнообразие генерируемых результатов.

- пользоваться

- Стандартизированные форматы вывода: При сравнительном анализе рекомендуется использовать подсказку Prompt, чтобы стандартизировать вывод модели.

- математическая задача: В подсказке добавьте "Please reason step by step, and put your final answer within \boxed{}. " (Please reason step by step, and put your final answer within \boxed{}.

- вопрос с несколькими вариантами ответов: Добавьте следующую структуру JSON в подсказку, чтобы стандартизировать ответ: "Пожалуйста, покажите ваш выбор в

answerполе только с буквой выбора, например.\"answer\": \"C\". " (Пожалуйста, добавьте следующее кanswerПоле отображает ваш выбор и содержит только букву выбора, например\"answer\": \"C\").

- Обработка длинных вводов: Для входов с более чем 32 768 маркерами включите YaRN методы, позволяющие улучшить способность модели эффективно отражать информацию о длинных последовательностях.

Для поддерживаемых фреймворков можно добавить следующее в config.json файл, чтобы включить YaRN:

{

...,

"rope_scaling": {

"factor": 4.0,

"original_max_position_embeddings": 32768,

"type": "yarn"

}

}

Для развертывания рекомендуется использовать vLLM. Если вы не знакомы с vLLM, обратитесь к разделу официальный документ чтобы получить информацию об использовании. В настоящее время vLLM поддерживает только статические YARN, что означает, что коэффициент масштабирования остается постоянным при изменении длины входных данных.Это может повлиять на производительность модели при работе с короткими текстами. Поэтому рекомендуется добавлять длинные контексты только тогда, когда их нужно обработать rope_scaling Конфигурация.

Как использовать QwQ-32B (Использование QwQ-32B)

Следующий краткий пример показывает, как использовать модель QwQ-32B с помощью Hugging Face Transformers и AliCloud DashScope API.

via Трансформеры с обнимающимися лицами.

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/QwQ-32B"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "How many r's are in the word \"strawberry\""

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(response)

Через API AliCloud DashScope.

from openai import OpenAI

import os

# Initialize OpenAI client

client = OpenAI(

# If the environment variable is not configured, replace with your API Key: api_key="sk-xxx"

# How to get an API Key:https://help.aliyun.com/zh/model-studio/developer-reference/get-api-key

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1"

)

reasoning_content = ""

content = ""

is_answering = False

completion = client.chat.completions.create(

model="qwq-32b",

messages=[

{"role": "user", "content": "Which is larger, 9.9 or 9.11?"}

],

stream=True,

# Uncomment the following line to return token usage in the last chunk

# stream_options={

# "include_usage": True

# }

)

print("\n" + "=" * 20 + "reasoning content" + "=" * 20 + "\n")

for chunk in completion:

# If chunk.choices is empty, print usage

if not chunk.choices:

print("\nUsage:")

print(chunk.usage)

else:

delta = chunk.choices[0].delta

# Print reasoning content

if hasattr(delta, 'reasoning_content') and delta.reasoning_content is not None:

print(delta.reasoning_content, end='', flush=True)

reasoning_content += delta.reasoning_content

else:

if delta.content != "" and is_answering is False:

print("\n" + "=" * 20 + "content" + "=" * 20 + "\n")

is_answering = True

# Print content

print(delta.content, end='', flush=True)

content += delta.content

Будущая работа

Выпуск QwQ-32B знаменует собой первый, но критически важный шаг в расширении возможностей обучения с подкреплением (RL) для улучшения рассуждений с помощью семейства моделей Qwen. Благодаря этому исследованию компания Aliyun не только увидела огромный потенциал для расширенного применения обучения с подкреплением, но и осознала неиспользованный потенциал предварительно обученных языковых моделей.

Заглядывая в будущее, Aliyun уверенно смотрит на разработку следующего поколения моделей "Тысячи вопросов". Они считают, что сочетание более надежной базовой модели с методами обучения с усилением на базе масштабных вычислительных ресурсов ускорит достижение конечной цели - общего искусственного интеллекта (AGI). Кроме того, AliCloud активно изучает возможности более глубокого слияния агентов и RL для обеспечения более дальних возможностей рассуждений и стремится к раскрытию большего интеллекта за счет масштабирования в точке вывода.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...