X-Dyna: референс портрета видео Поза поколения видео, чтобы заставить фотографии Мисси танцевать

Общее введение

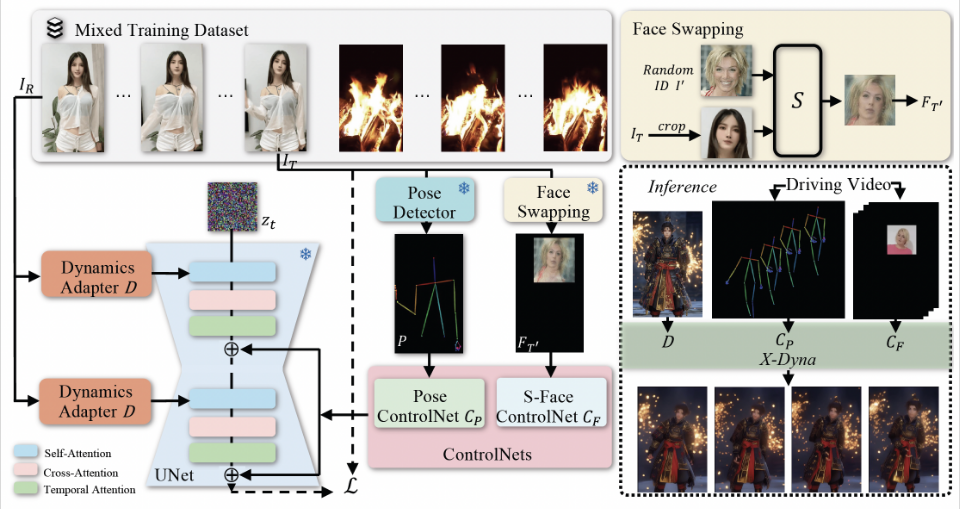

X-Dyna - это проект с открытым исходным кодом, разработанный компанией ByteDance для создания динамических портретных анимаций с помощью техники диффузии с нулевой выборкой. Проект использует мимику и движения тела в видеоролике для анимирования отдельных портретных изображений, создавая реалистичные и контекстно-зависимые анимации. x-Dyna повышает живость и детализацию портретных видеоанимаций, внедряя модуль динамического адаптера, который плавно интегрирует внешний контекст опорного изображения в пространственное внимание опорной сети диффузии.

Похожие рекомендации:StableAnimator: генерирует высококачественную видеоанимацию, сохраняющую черты персонажа. , иDisPose: генерирование видео с точным контролем человеческих поз, создание танцующих дам , иMOFA Video: технология адаптации поля движения преобразует неподвижные изображения в видео

Список функций

- Генерация динамической портретной анимации: создание реалистичной динамической портретной анимации с использованием мимики и движений тела в видеозаписи с диска.

- Метод диффузии с нулевой выборкой: генерирует высококачественные анимации без предварительного обучения.

- Модуль динамического адаптера: интеграция контекста опорного изображения для повышения детализации и живости анимации.

- Передача выражения лица: захват выражения лица с помощью локального модуля управления для точной передачи выражения.

- Коды оценки: Предоставьте различные метрики оценки (например, DTFVD, Face-Cos, Face-Det, FID и т. д.) для оценки качества анимации.

- Открытый исходный код и модели: полный код вывода и предварительно обученные модели предоставляются для простоты использования и вторичной разработки.

Использование помощи

Процесс установки

- Хранилище проектов клонирования:

git clone https://github.com/bytedance/X-Dyna.git

cd X-Dyna

- Установите зависимость:

pip install -r requirements.txt

- Установите среду PyTorch 2.0:

bash env_torch2_install.sh

Использование

- Подготовьте входное изображение и приводное видео:

- Входное изображение: одно портретное изображение.

- Drive Video: видео, содержащее мимику и движения тела цели.

- Запустите код вывода, чтобы сгенерировать анимацию:

python inference_xdyna.py --input_image path_to_image --driving_video path_to_video

- Оцените качество созданной анимации:

- Качество созданных анимаций оценивалось с помощью предоставленного кода оценки и набора данных.

python evaluate.py --generated_video path_to_generated_video --metrics DTFVD,Face-Cos,Face-Det,FID

Подробный порядок работы функций

- Генерация динамической анимации портрета::

- Выберите в качестве исходного материала статичное портретное изображение.

- Выберите видео с диска, на котором запечатлены движения и выражения лица объекта.

- Запустите код вывода для создания динамической анимации портрета.

- передача выражения лица::

- Запечатлейте выражения лиц на видеороликах с дисками с помощью модуля локального управления.

- Перенесите запечатленное выражение лица на входное изображение для точной анимации выражения.

- Модуль динамического адаптера::

- Модуль динамического адаптера легко интегрирует внешний контекст эталонного изображения в пространственное внимание диффузной магистральной сети.

- Таким образом, созданная анимация сохраняет больше деталей и живости.

- Код оценки::

- Для оценки качества созданных анимаций предусмотрены различные метрики (например, DTFVD, Face-Cos, Face-Det, FID и т. д.).

- Пользователи могут полностью оценить созданные анимации на основе этих показателей.

- Открытый исходный код и моделирование::

- Проект предоставляет полный код вывода и предварительно обученные модели, которые могут быть легко использованы пользователями для вторичной разработки и индивидуальных приложений.

Часто задаваемые вопросы.

- Анимация не плавная: постарайтесь увеличить

num_mixили корректировкиddim_steps. - несоответствие в выражении лица: Убедитесь, что выбор

best_frameсоответствует кадру в видеозаписи диска, который наиболее похож по выражению на исходное изображение.

Продвинутое использование.

- оптимизировать производительность: Скорость генерации может быть улучшена за счет сокращения количества шагов вывода при использовании модели LCM LoRA.

- Пользовательские модели: Если у вас есть особые потребности, вы можете изменить или расширить модель в соответствии с указаниями в README.

Следуя этим шагам, пользователи смогут легко начать работу с X-Dyna для создания высококачественных динамических портретных анимаций, а также полностью оценить и оптимизировать созданные анимации.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...