WritingBench: бенчмаркинговый инструмент оценки для проверки способности к написанию больших моделей

Общее введение

WritingBench - это проект с открытым исходным кодом, разработанный командой X-PLUG и размещенный на GitHub. Это инструмент, специально разработанный для проверки способности к написанию больших моделей, предоставляющий 1239 реальных письменных заданий. Эти задания охватывают 6 основных доменов и 100 поддоменов, сочетая требования к стилю, форматированию и объему, в среднем 1546 слов на задание. Проект создает задания путем комбинации генерации моделей и ручной оптимизации, чтобы обеспечить разнообразие и полезность. Каждое задание имеет 5 специфических критериев оценки, которые могут быть оценены либо большой моделью, либо специальной моделью оценки. Код и данные WritingBench являются свободными и открытыми и подходят для разработчиков, чтобы оптимизировать возможности большой модели. Обратите внимание, что проект не предоставляет requirements.txt файл, пользователям необходимо настроить свое собственное окружение.

Список функций

- Предлагает 1239 аутентичных письменных заданий в шести областях: наука, бизнес, право, литература, образование и маркетинг.

- Поддерживая 100 сегментов, задания приближены к реальным потребностям.

- Создайте 5 динамических критериев оценки для каждого задания, чтобы оценить качество письма.

- Поддерживает как автоматическую оценку больших моделей, так и оценку специализированных судейских моделей.

- Включает в себя различные справочные материалы, такие как финансовые отчеты или юридические шаблоны.

- Предоставляется открытый исходный код, наборы данных и сценарии оценки, которые могут быть свободно загружены и изменены пользователем.

Использование помощи

WritingBench - это проект с открытым исходным кодом на GitHub, и пользователи могут посетить сайт https://github.com/X-PLUG/WritingBench для поиска ресурсов. Он не требует использования онлайн-сервиса, просто загрузите его и запустите локально. Ниже приводится подробное руководство по шагам и функциям:

Доступ к ресурсам проекта

- Откройте браузер и введите https://github.com/X-PLUG/WritingBench.

- Нажмите зеленую кнопку "Code" в правом верхнем углу и выберите "Download ZIP", чтобы загрузить его, или клонируйте его с помощью команды Git:

git clone https://github.com/X-PLUG/WritingBench.git

- Распакуйте файлы в локальную папку, содержащую код, данные и документацию.

Подготовка среды выполнения

WritingBench недоступен requirements.txt файл, поэтому вам нужно будет установить окружение Python и зависимые библиотеки вручную. Это можно сделать следующим образом:

- Убедитесь, что установлен Python 3.8 или более поздней версии, набрав в терминале

python --versionПроверьте. - Перейдите в папку с проектом:

cd WritingBench

- Установите основные библиотеки зависимостей. Официально не все зависимости перечислены в явном виде, но следующие библиотеки считаются необходимыми, исходя из их функциональности:

pip install torch(для судейских моделей может потребоваться поддержка GPU).pip install transformers(для больших модельных операций).pip install requests(может использоваться для обработки данных).- Другие библиотеки, которые могут понадобиться, могут быть установлены дополнительно в зависимости от сообщения об ошибке.

- Если используется выделенная модель суждения, необходимо установить PyTorch и CUDA, конкретную версию см. на сайте https://pytorch.org/get-started/locally/.

Описание структуры проекта

После загрузки структура каталогов выглядит следующим образом:

evaluate_benchmark.py: Оценочные сценарии.prompt.py: Шаблон совета.evaluator/: Оцените каталог интерфейсов.critic.py: Выделенный интерфейс модели суждения.llm.py: Интерфейсы оценки больших моделей.benchmark_query/: Каталог данных миссии.benchmark_all.jsonl: Полный набор данных 1239 задач.requirement/: Подмножество, классифицированное по стилю, формату и длине.

Использование данных письменных заданий

- показать (билет)

benchmark_query/benchmark_all.jsonlПросмотрите 1239 заданий. - Каждое задание включает в себя описание, домены и справочные материалы. Например, "Напишите резюме в 500 слов для финансового отчета за 3 квартал 2023 года".

- Генерируйте ответы с помощью вашей большой модели и примера кода:

from your_model import Model

task = "为2023年Q3财务报告写500字总结"

model = Model()

response = model.generate(task)

with open("response.txt", "w") as f:

f.write(response)

Инструменты оперативной оценки

WritingBench поддерживает два типа оценки:

Крупный модельный скоринг

- компилятор

evaluator/llm.pyНиже приведен пример конфигурации API, которую вы можете добавить:

self.api_key = "your_api_key_here"

self.url = "Your API endpoint"

self.model = "Your model name"

- Запустите сценарий оценки:

python evaluate_benchmark.py --evaluator llm --query_criteria_file benchmark_query/benchmark_all.jsonl --input_file response.txt --output_file scores.jsonl

- На выходе получаются оценки и обоснования для каждого из пяти критериев оценки.

Оценки по специализированной модели суждений

- Загрузите модель суждения с сайта https://huggingface.co/AQuarterMile/WritingBench-Critic-Model-Qwen-7B.

- Поместите модель в локальный путь, отредактируйте

evaluator/critic.py::

self.model = LLM(model="path/to/critic_model", tensor_parallel_size=1)

- Оперативная оценка:

python evaluate_benchmark.py --evaluator critic --query_criteria_file benchmark_query/benchmark_all.jsonl --input_file response.txt --output_file scores.jsonl

- На выходе выводится оценка (0-10) по каждому критерию.

Настройка заданий и оценок

- существовать

benchmark_query/Добавьте новый JSON-файл к описанию задания и материалам. - модификации

prompt.pyили оценочные сценарии для корректировки критериев оценки. - После тестирования вы можете загрузить его на GitHub и поделиться им.

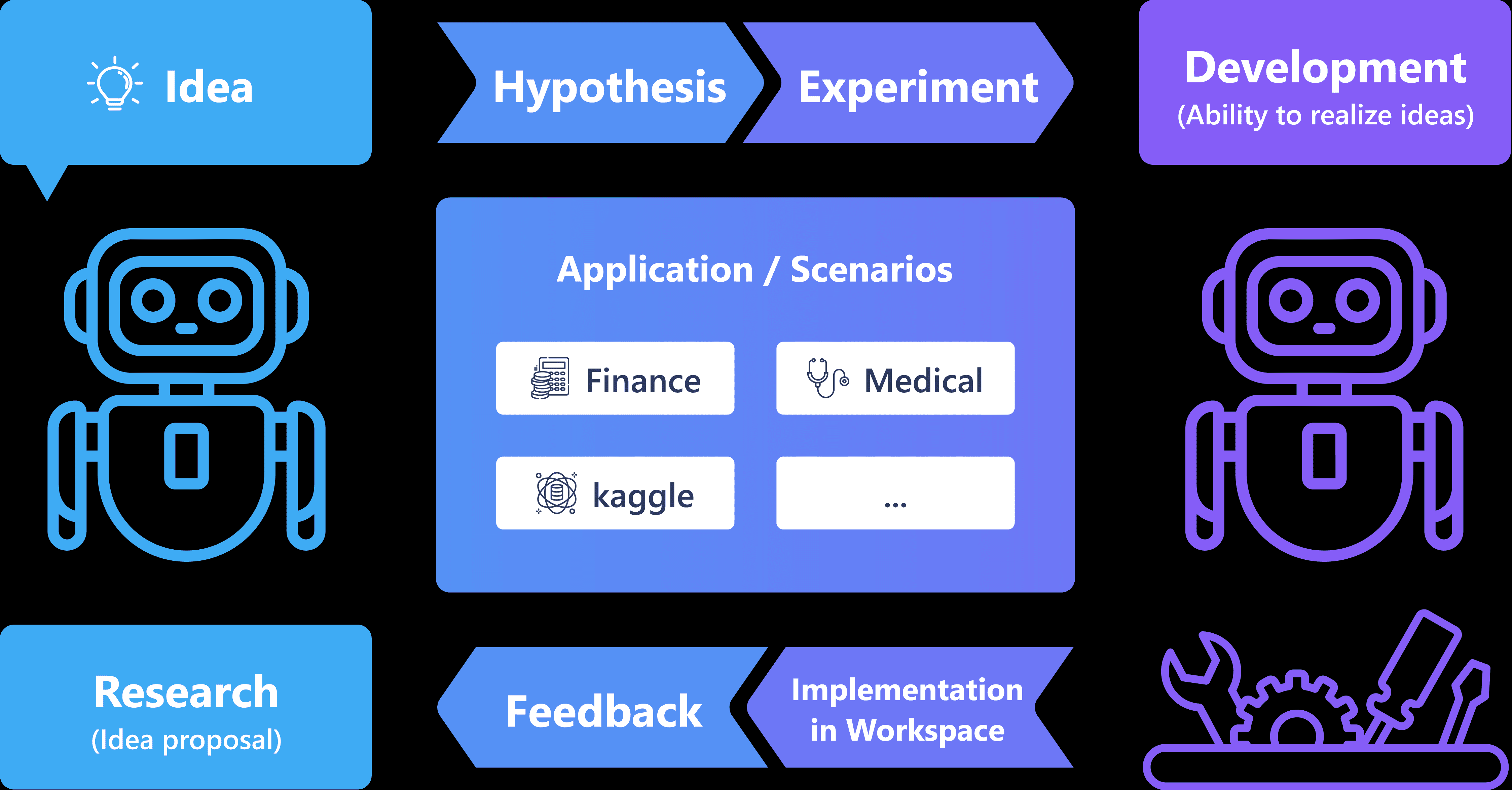

Процесс генерации данных

Задания создаются следующими способами:

- Большая модель генерирует начальные задания из 6 основных доменов и 100 поддоменов.

- Оптимизируйте задачи с помощью корректировки стилей, требований к форматированию и т. д.

- 30 этикеток для сбора материалов из открытых источников.

- 5 экспертов проверяют задания и материалы на актуальность.

Эти шаги помогут пользователям быстро освоить WritingBench, протестировать и оптимизировать возможности написания больших моделей.

сценарий применения

- разработка модели

Разработчики используют WritingBench для проверки работы модели в научных статьях или рекламных текстах, а также для устранения недостатков. - Образовательные исследования

Исследователи анализируют способность больших моделей генерировать учебные материалы или корректировать эссе. - письменная помощь

Пользователи вдохновляют на творчество с помощью данных о задачах или проверяют качество статей с помощью инструмента оценки.

QA

- Почему нет файла requirements.txt?

Официально он не доступен, вероятно, чтобы дать пользователям возможность гибко настраивать зависимости в соответствии с их моделью и окружением. - Нужна ли мне сеть?

Нет необходимости, просто загрузите и запустите локально, но для загрузки моделей или зависимостей требуется подключение к Интернету. - Как получается модель суждения?

Загружено с сайта https://huggingface.co/AQuarterMile/WritingBench-Critic-Model-Qwen-7B.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...