Windows Native Deployment of WeChat Intelligent Chatbot Based on DeepSeek-R1

Добрый Новый год! Приветствую всех вас! В последнее время круг моих друзей DeepSeek-R1 Я уверен, что вы все слышали о DeepSeek, нашей отечественной модели с открытым исходным кодом! Я уверен, что вы слышали о нашей отечественной модели с открытым исходным кодом - DeepSeek. В Интернете было довольно много уроков о том, как локально развернуть DeepSeek-R1, сегодня давайте сделаем что-то другое, в сочетании с практическими примерами, рука об руку, чтобы взять вас, чтобы играть вокруг DeepSeek-R1, увидеть, насколько мощным он действительно является! Первый шаг - это использование DeepSeek-R1 для развертывания новой системы в локальной среде!

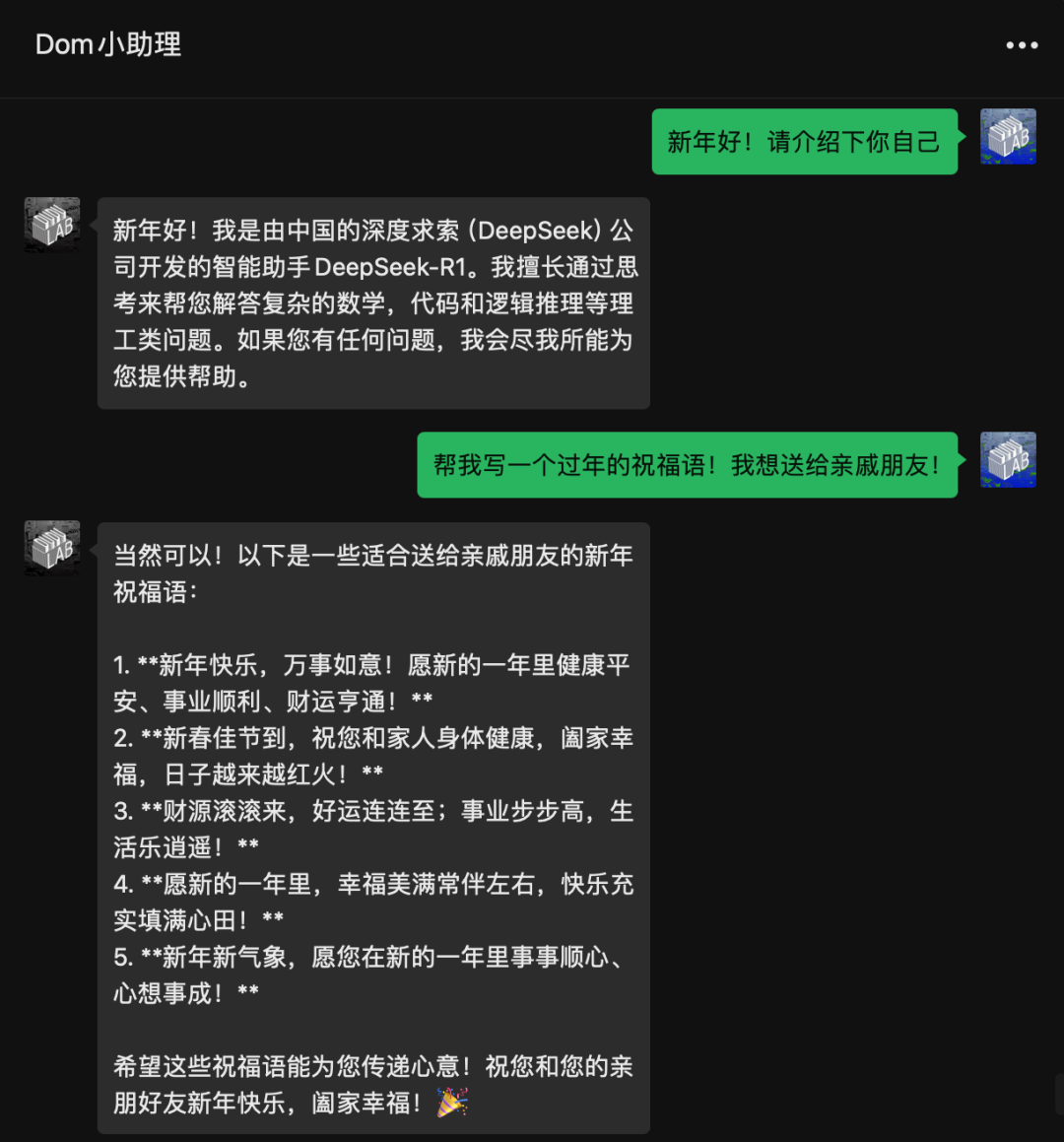

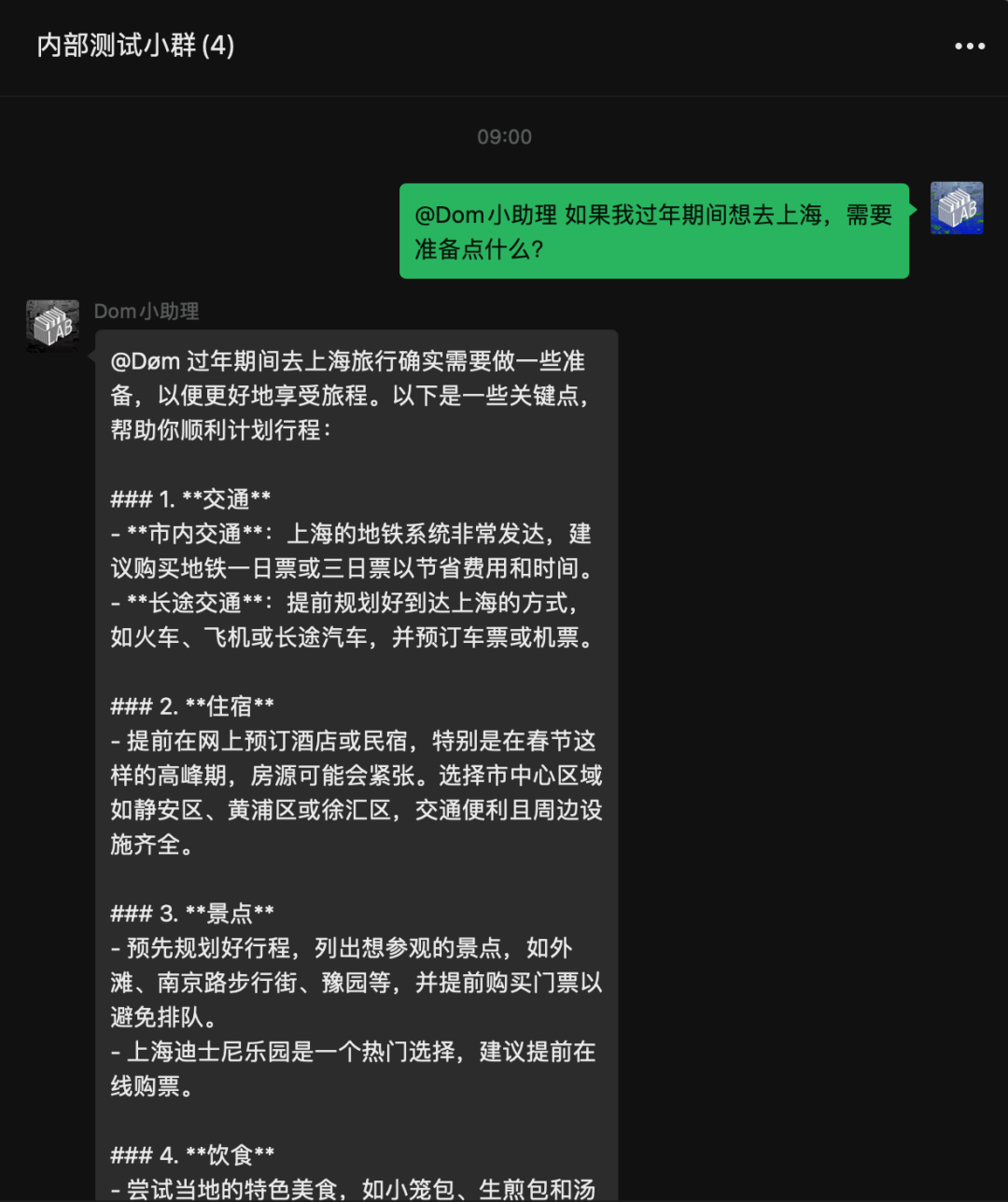

В этом выпуске рассказывается о том, как использовать локальный DeepSeekR1 для доступа к WeChat, чтобы сделать интеллектуальный чатбот WeChat! Этапы реализации разделены на три основные части: локальное развертывание Ollama, доступ к WeChat, изменение конфигурации.

Вот эффект от доступа! Все локализовано! Нет необходимости обращаться к api DeepSeek.

Весь процесс не сложен и занимает около 10 минут. Я вложил в него всю сложность работы, так что все, что вам нужно сделать, - это скачать его, просто установить и запустить!

Локальное развертывание DeepSeek-R1

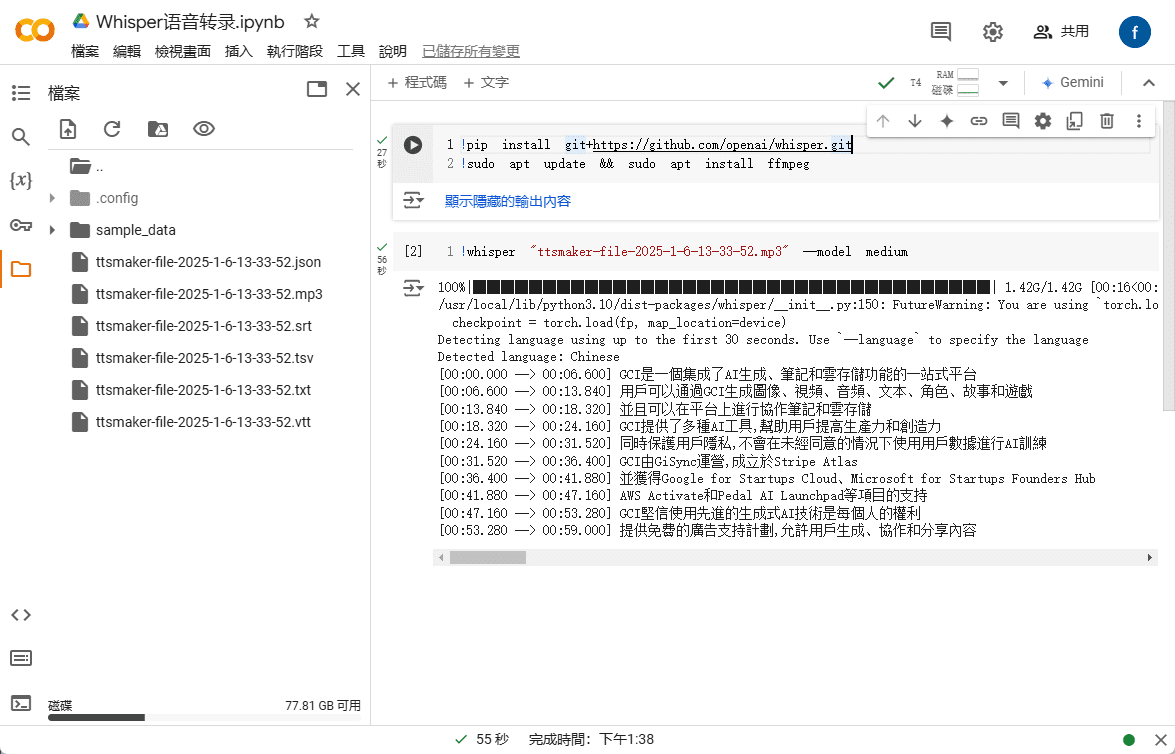

Сначала вам нужно установить DeepSeek-R1 локально. Если у вас не получается установить DeepSeek-R1 локально, перейдите к следующему шагу:Развертывание модели DeepSeek-R1 с открытым исходным кодом в режиме онлайн с использованием бесплатных мощностей GPU

Следует отметить, что 1.5B, 7B, 8B и так далее - это "дистиллированные" версии Qwen/llama, улучшенные с помощью рассуждений R1, а не настоящие R1, вы можете просто понять, что это не чистокровный R1, и опыт представляет собой смесь Qwen2.5-1.5B или llama+R1. Полнообъемная версия 671B - это настоящая R1, конечно, наша обычная потребительская видеокарта не в состоянии воспринять полнообъемную версию 671B, поэтому сначала используйте дистиллированную версию для игры.

Установка Ollama

Здесь мы используем инструмент Ollama, который я положил на свой сетевой диск, или вы можете скачать его с официального сайта.

официальный сайт

https://ollama.com/

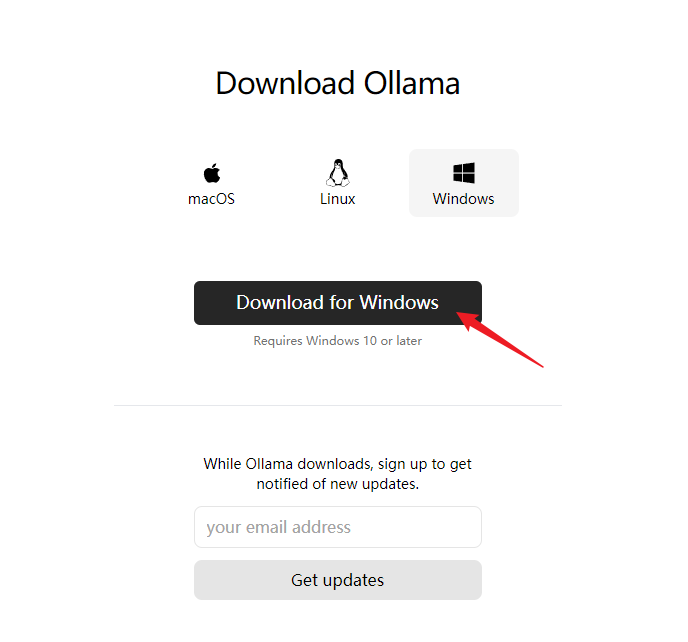

Скачать версию для windows (здесь следует сказать, что в настоящее время из-за ограничений WeChat, доступ к WeChat, только поддержка платформы windows)

Настройка путей установки и модели

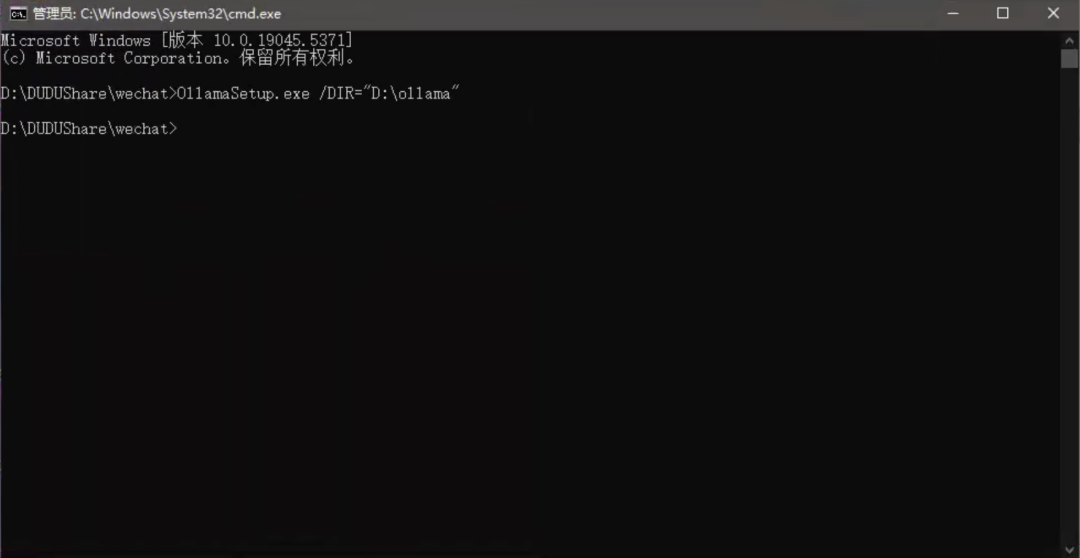

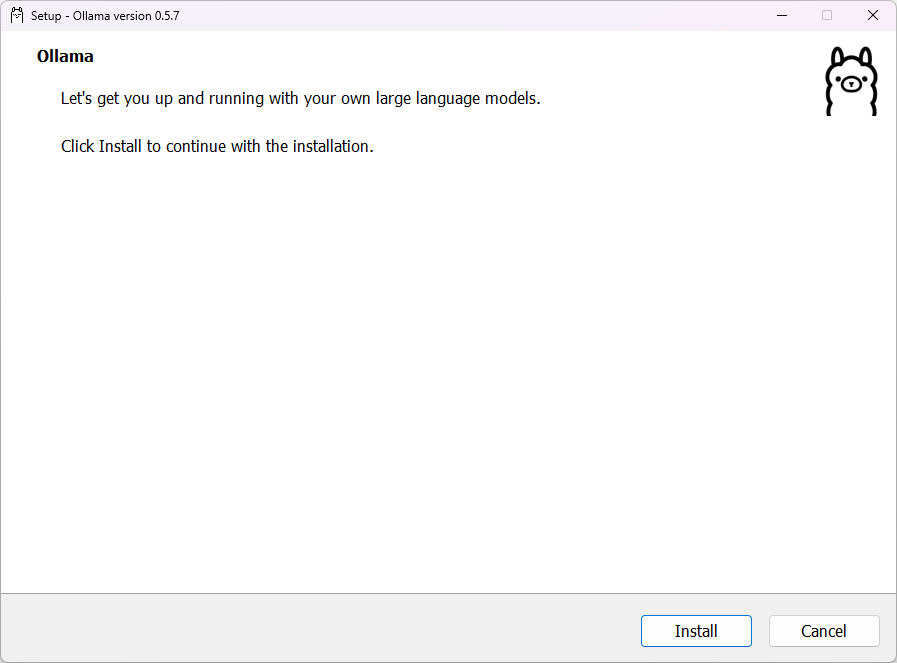

Откройте программу установки для установки, по умолчанию она устанавливается на диск C. Вы можете сделать это, набрав в командной строке плюс/DIR=чтобы указать путь установки.

OllamaSetup.exe /DIR="D:ollama"

Если вы уже установили Ollama на диск C, но хотите изменить каталог установки.

Установите этот путь наOllamaПереместите папку в каталог, в который вы хотите установить

C:Users你的用户名AppDataLocalProgramsOllama

например

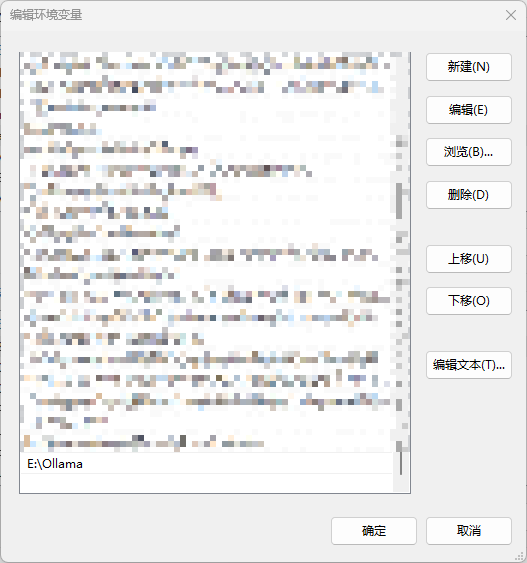

E:Ollama

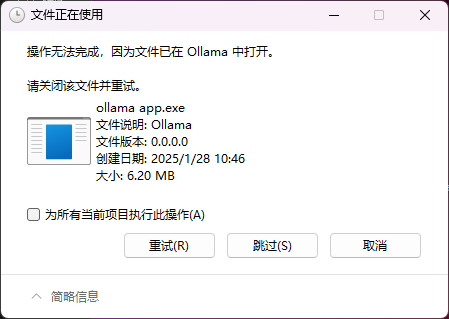

При перемещении вы можете столкнуться со следующей проблемой, связанной с тем, что после установкиOllamaОн уже запущен по умолчанию.

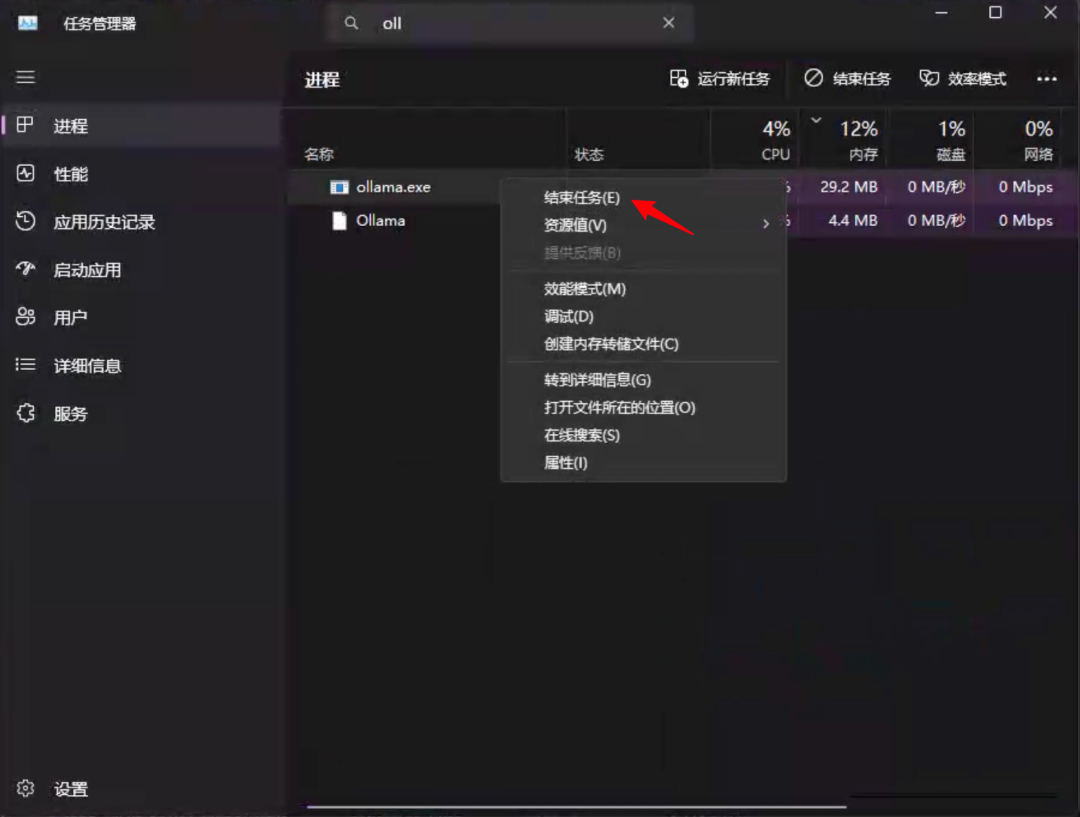

Его нужно найти в диспетчере задачOllamaответить пениемollama.exeДля обоих процессов щелкните правой кнопкой мыши结束任务. Сначала его нужно закрытьOllamaповторное закрытиеollama.exe.

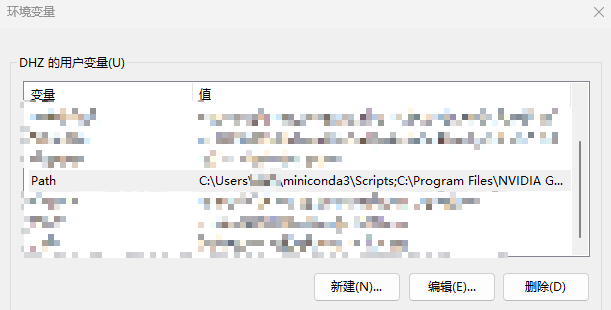

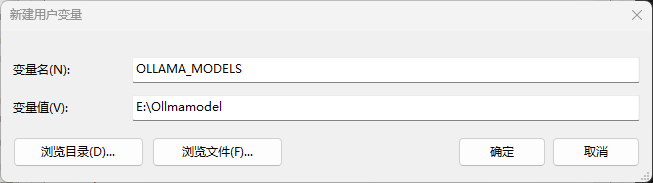

Затем необходимо изменить переменные окружения

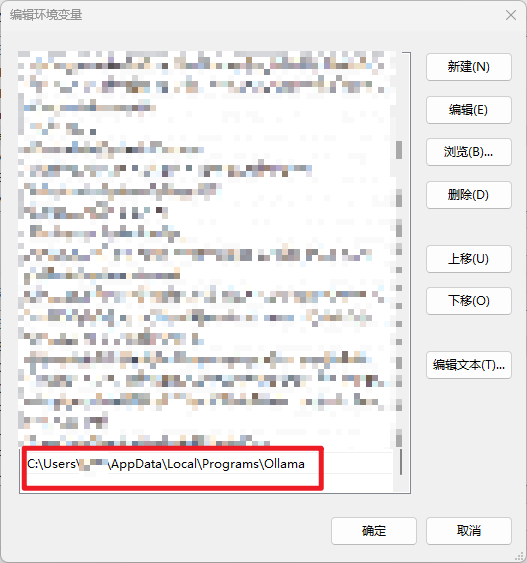

Откройте Настройки-Дополнительные системные настройки-Переменные окружения-Найти путь, дважды щелкните, чтобы изменить.

Найдите его на диске C.Ollamaтропы

Перейдите в указанную вами директорию

Добавьте новую пользовательскую переменнуюOLLAMA_MODELSЭто место, где хранится загруженная модель, если вы его не зададите, то по умолчанию она будет находиться в папке пользователя на диске C.

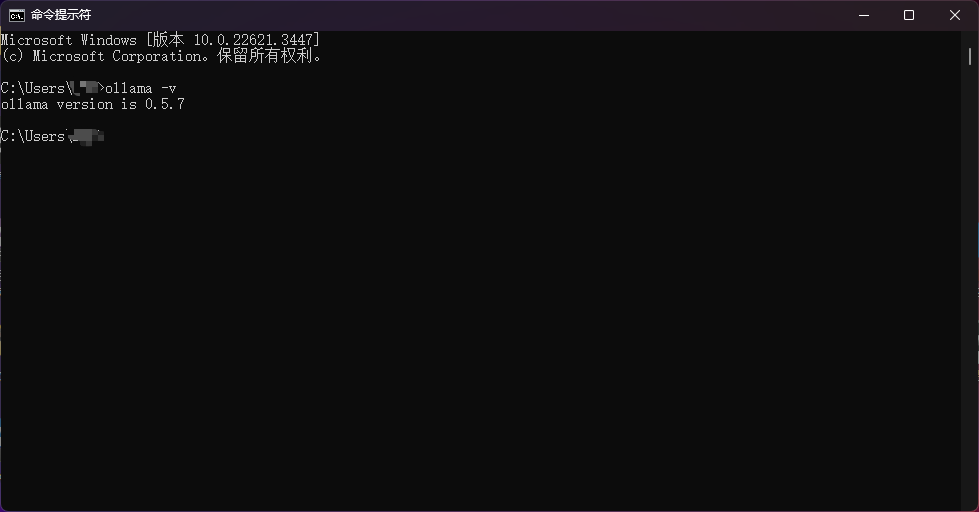

После того как все вышеперечисленное будет установлено, в командной строке введитеollama -vУбедитесь, что все получилось.

Скачать модели

https://ollama.com/library/deepseek-r1:1.5b

Перейдите на страницу, чтобы увидеть все модели, доступные в настоящее время для R1

Вот соответствующая видеопамять, необходимая для запуска модели.

- deepseek-r1:1.5b - 1-2 г видеопамяти

- deepseek-r1:7b - 6-8 Гб графической памяти

- deepseek-r1:8b - 8 Гб видеопамяти

- deepseek-r1:14b - 10-12 Гб видеопамяти

- deepseek-r1:32b - 24G-48 видеопамяти

- deepseek-r1:70b - 96G-128 видеопамяти

- deepseek-r1:671b - требуется 496 ГБ видеопамяти или больше!

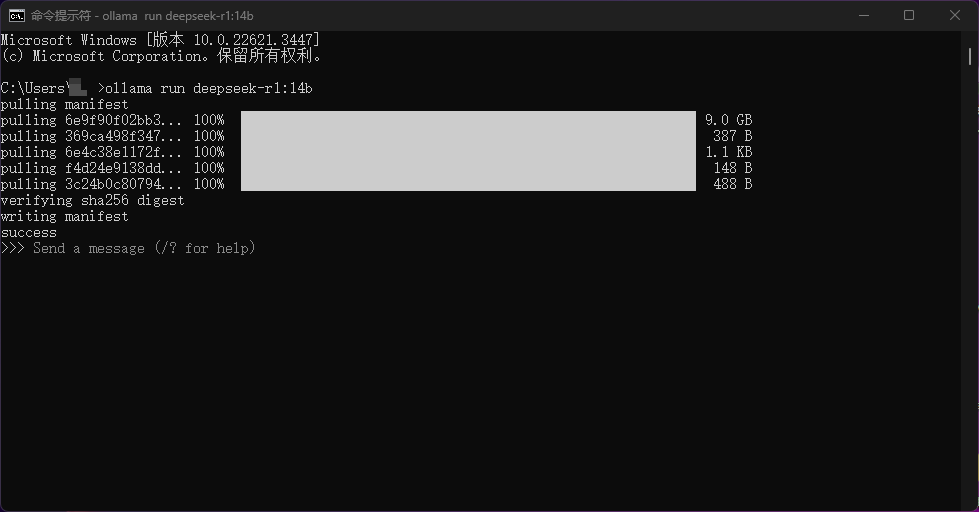

Выберите соответствующую модель в соответствии с конфигурацией вашего компьютера, вставьте команду в командную строку и выполните ее, модель будет загружена автоматически. Например, я выполнил следующееollama run deepseek-r1:14b

Я также подготовил 1.5B модель и 14B модель в веб-каталоге, если у вас нет хорошего соединения с интернетом, вы можете напрямую распаковать модель в ваш путь к модели и запустить ее, нет необходимости использовать ее снова!ollamaСкачать.

Разверните BOT для доступа к WeChat

Выполнив этот шаг, вы приблизились к успеху! Остальные шаги очень просты!

Нам нужно использоватьNGCBotЭтот проект, направленный на то, чтобы поставить местныйDeepSeekДоступ к WeChat

Адрес проекта:

https://github.com/ngc660sec/NGCBot

Оригинальный проект поддерживает доступ к api таких платформ, как Xunfei Starfire, kimi, gpt, deepseek и так далее.Но для локального доступа DeepSeek не поддерживается, я внес следующие изменения в оригинальный проект с открытым исходным кодом!Приглашаем вас принять участие в обслуживании!

- Поддержка местного deepseek

- Щит думаю

- Контекстная поддержка диалога

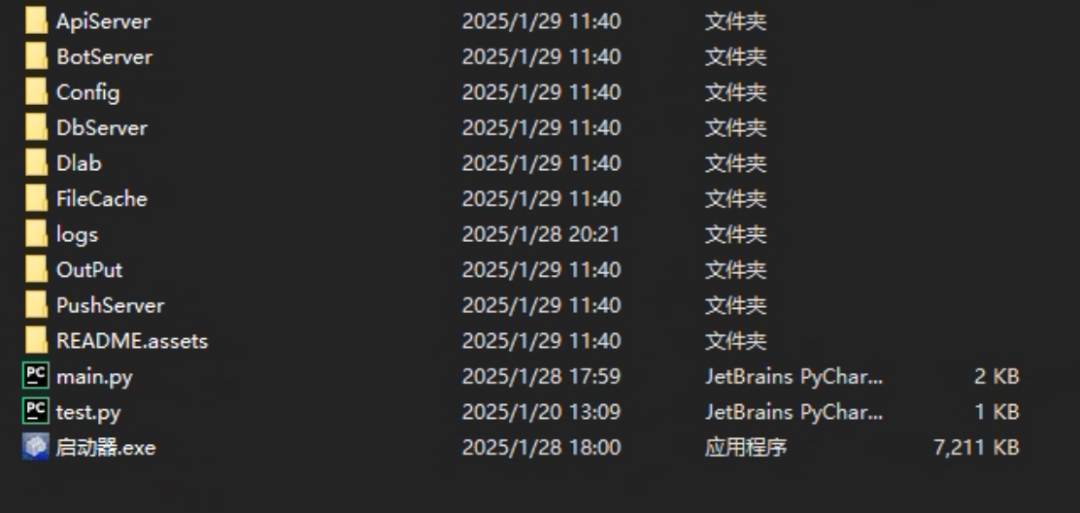

Поместите нетбук вNGCBot.zipРаспаковка

Распакуйте и дважды щелкните пусковую установку, чтобы открыть проект

Проект автоматически откроет ваш WeChat, который в этот момент выдаст запрос:只支持64位微信или当前微信版本不支持

Это связано с тем, что версия WeChat, установленная на наших компьютерах, слишком новая.NGCBotНеобходимо установить определенную версию.

Установите подготовленную мной версию WeChat и снова откройтеNGCBotПроект, проведите пальцем по экрану, чтобы войти в WeChat, готово!

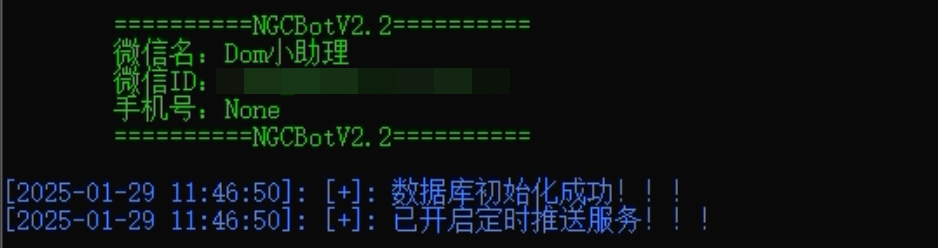

Если на экране инициатора появляется следующее сообщение, это означает, что служба была успешно инициализирована.

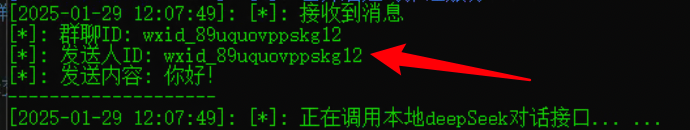

В этот момент мы отправляем сообщение вошедшему в WeChat пользователю, чтобы проверить его.

Готово!

Изменение конфигурации BOT

Нет, робот готов! Не надо так радоваться! Есть кое-что еще, что вам нужно знать.NGCBotнастройки конфигурации!

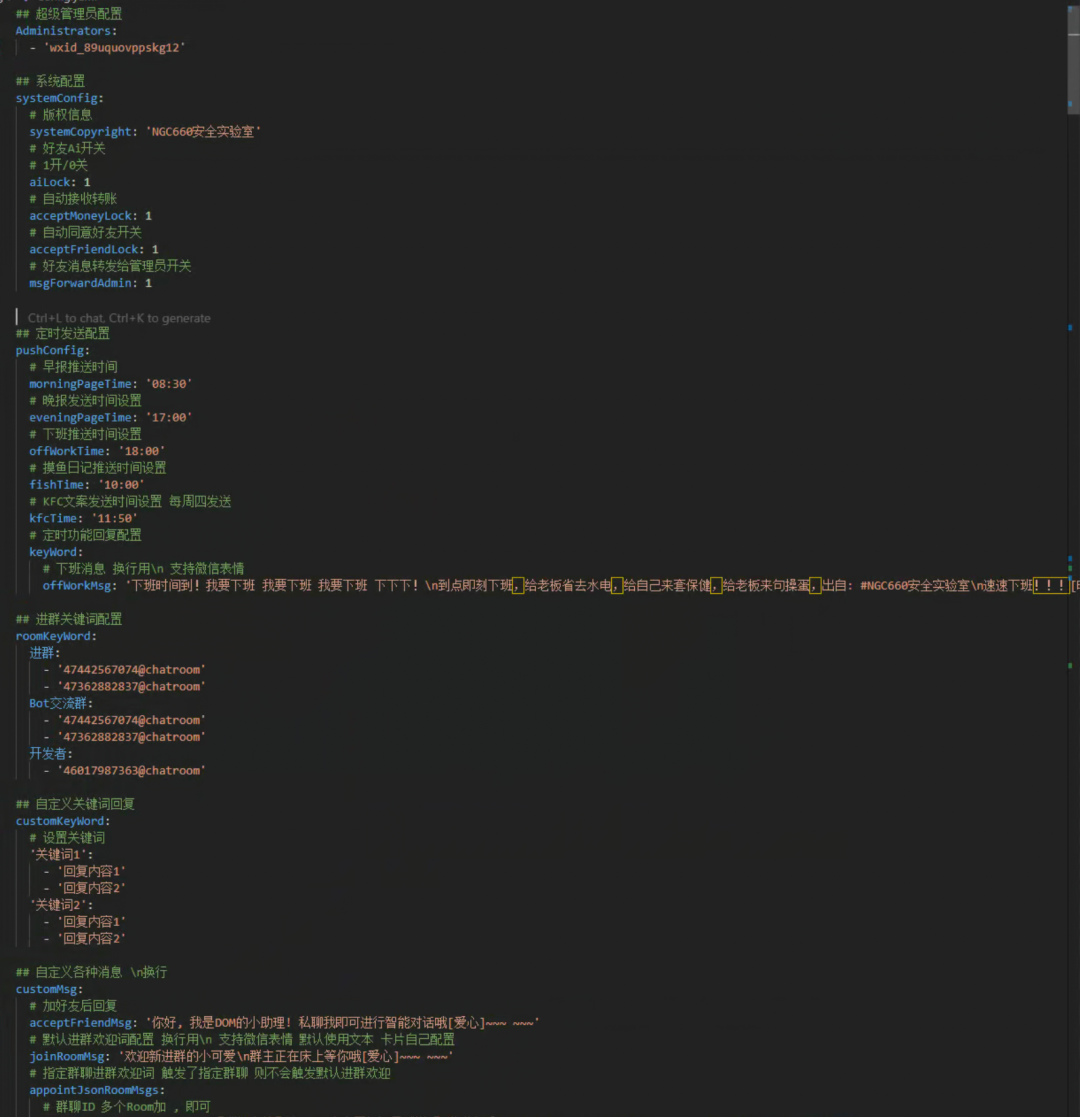

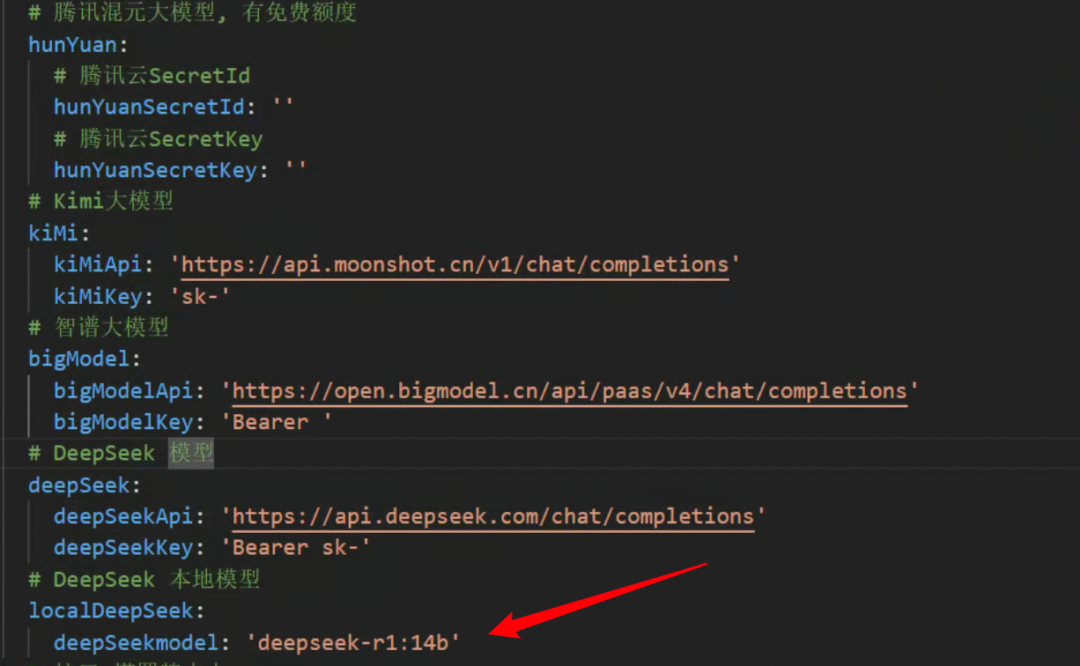

показать (билет)NGCBotв корневом каталоге проекта.Config/Config.yamlгазеты

Здесь описаны только две необходимые настройки, остальные вы можете посмотреть в официальной документации.

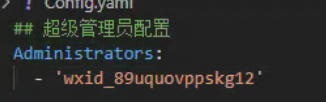

Первая - это модификация超级管理员配置Здесь введите id вашего другого Weibo, администратора Weibo.

Идентификатор можно получить, скопировав любое сообщение, отправленное боту с другого микросигнала, на этот микросигнал.

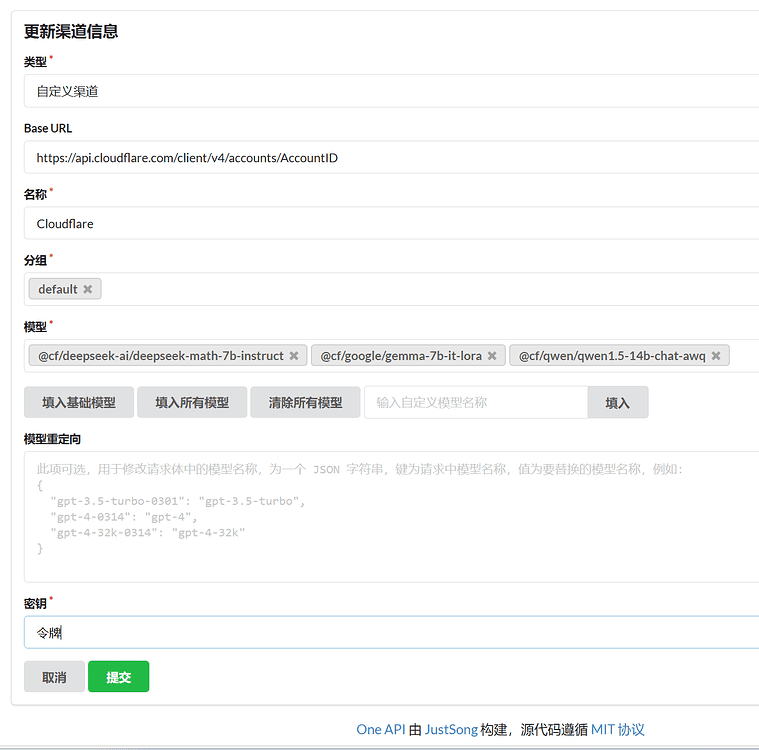

Второе место - это модификацияlocalDeepSeekнижеdeepSeekmodelИмя модели в

Здесь указывается, какую модель вы установили с помощью ollama.

После выполнения описанных выше шагов, поздравляем, у вас есть локальная версия чатбота DeepSeek-R1 microsoft.

вопросы

- В: Можно ли получить доступ к MAC?

- О: Нет.

NGCBotПроект поддерживает только windows, но Ollama может быть развернута. - В: Нужно ли мне постоянно быть подключенным к WeChat? Не могу ли я отключить его?

- О: Да, это эквивалентно входу в windows-версию WeChat, мобильный телефон может нормально общаться, но он, конечно, не может нормально работать после выключения компьютера. Если вы хотите работать непрерывно, рекомендуется развернуть его на облачном сервере.

- Вопрос: Это то же самое, что и предыдущий

chatgpt-on-wechatВ чем разница? - О: Протоколы разные, и некоторое время назад микроблоггинг охватил

chatgpt-on-wechatиспользуемый интерфейс, так что в настоящее время этот основанный на крючкеNGCBotПроект по-прежнему очень стабилен.

Приобретение интеграционного пакета

Версия лаборатории Тутси:

Кварк: https://pan.quark.cn/s/bc26b60912da

Baidu:https://pan.baidu.com/s/1QKFWV1tMti9s4m9K_HAPFg?pwd=428a

написать в конце

Год назад я получил личное сообщение, в котором говорилосьchatgpt-on-wechatЭтот интерфейс проекта был заблокирован официальными представителями WeChat и предназначался для объединения сCOZEПоделиться.NGCBotЭтот проект, хахаха, как раз то, что нужноDeepSeek-R1По всем правилам! И так. ...COZE давайте пока отложим на потом! Всех с Новым годом, а я пошел есть пельмени .....

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...