Утечка документов Microsoft: только 8B для GPT-4o-mini и 100B для o1-mini?

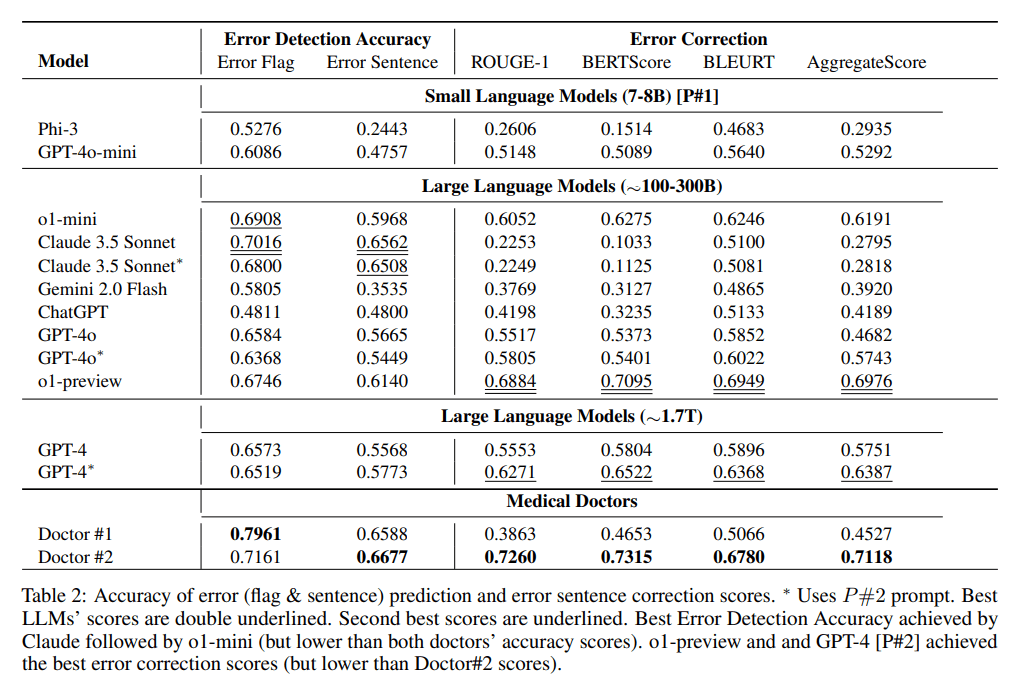

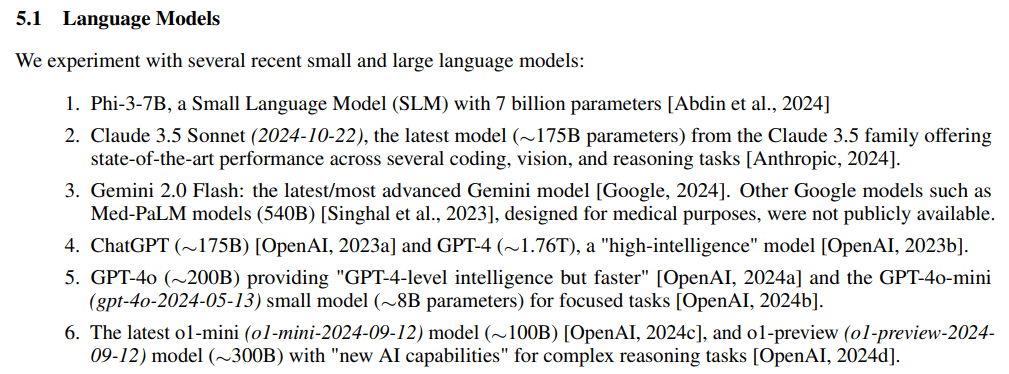

Продолжается дискуссия о размерах параметров основных закрытых LLM, и в последние 2 дня 2024 года появилась статья от Microsoft оВыявление и исправление врачебных ошибок в клинических записяхпредположениеэкспериментэталонВ исследовании MEDEC случайно и прямо упущен масштаб их параметров:o1-preview, GPT-4.ГПТ-4о иКлод 3.5 Сонет.

Бумажный адрес: https://arxiv.org/pdf/2412.19260v1

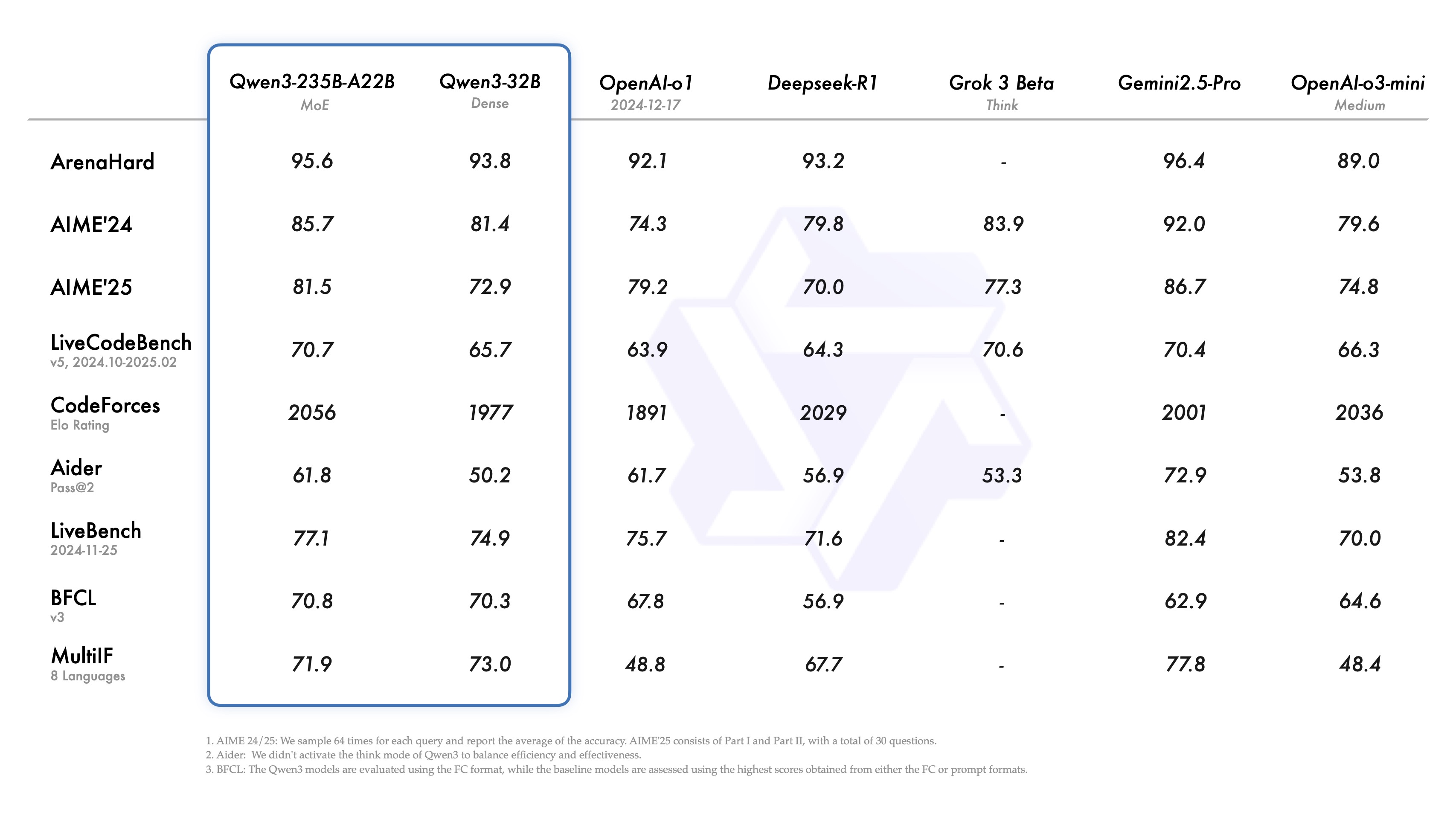

Экспериментальная часть эксперимента также разделена на 3 блока больших шкал параметров модели:7-8B, ~100-300B, ~1.7Tно (не)GPT-4o-miniПопасть в первый слот, имея всего 8B, немного невероятно.

резюме

- Клод 3.5 Сонет (2024-10-22), ~175B

- ChatGPT, ~175B

- GPT-4, приблизительно 1,76 Т

- GPT-4o, ~200B

- GPT-4o-mini (gpt-4o-2024-05-13) только 8B

- Последние o1-mini (o1-mini-2024-09-12) всего 100B

- o1-preview (o1-preview-2024-09-12) ~ 300B

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...