Продукты Microsoft Azure+Copilot+AI PC полностью поддерживают модели DeepSeek R1

30 января 2025 года компания Microsoft сообщила, что модель R1 компании DeepSeek теперь доступна на ее платформе облачных вычислений Azure и в инструментах GitHub для разработчиков в целом. Microsoft также сообщила, что клиенты вскоре смогут использовать модель R1 от DeepSeek на своих Второй пилот + Запустите модель R1 локально на компьютере.

Как мы уже упоминали ранее, copilot будет постепенно использовать и другие крупные модели, помимо OpenAI:

В последнее время компания Microsoft все чаще появляется в новостях, и одним из самых заметных событий стало то, чтоКопилот GitHub является бесплатным и открытым!Пусть и в меньшем количестве (2 000 в месяц для завершения кода и 50 в месяц для разговоров в чате), но это, по крайней мере, знаковое событие, и модель была расширена с первоначального единственного GPT 4o до o1 Клод ответить пением Близнецы и многие другие модели.

На самом деле это означает, что Microsoft отходит от опоры на технологию OpenAI, которая в некотором смысле уже не является лучшей моделью и, боюсь, уже не является самой экономически эффективной.

В результате недавнего deepseek Более мощное влияние в мире, ряд привлекательных новых функций продолжают появляться в сети, но также вызвали жизнь и смерть конкуренции между Китаем и США в области искусственного интеллекта, Microsoft, чтобы сделать copilot лучше поддержка китайского языка, готовы использовать deepseek's R1 модель в copilot.

Генеральный директор Microsoft Индиан Наделла также подчеркнул, что модели DeepSeek R1 теперь доступны через ИИ-платформу Microsoft Azure AI Foundry и GitHub, а вскоре их можно будет запускать на компьютерах Copilot+. Наделла отметил, что в DeepSeek "есть несколько реальных инноваций" и что стоимость ИИ имеет тенденцию к снижению: "Закон масштабирования накладывается на предварительное обучение и вычисления времени вывода. За прошедшие годы мы наблюдали значительное повышение эффективности обучения и вывода ИИ. В области вычислений мы обычно наблюдаем более чем 2-кратное улучшение соотношения цена/производительность на поколение аппаратного обеспечения и более чем 10-кратное улучшение соотношения цена/производительность на поколение моделей".

Мы рады этому.

copilot for Microsoft 365 - это собственный плагин copilot для office 365 (word, excel, ppt, OneNote, teams и т. д.), который может генерировать контент на основе других файлов в word, генерировать формулы и вычисления в excel, создавать презентации на основе других файлов в PPT. Вы также можете создавать презентации на основе других документов в PPT, организовывать заметки и генерировать дополнительные заметки в OneNote, подводить итоги встреч в командах и многое другое.

Связанное чтение 1: "Запуск оптимизированных для дистилляции моделей DeepSeek R1 локально на ПК Copilot+".

ИИ переходит на периферию, и компьютеры Copilot+ лидируют в этом направлении. В то время как Azure AI Foundry запускает облачную версию DeepSeek R1 (см. соответствующее чтение2), мы выводим версию DeepSeek-R1, оптимизированную для работы с NPU, непосредственно на ПК Copilot+. Первые адаптации будут сделаны для платформы Qualcomm Snapdragon X, а затем появится поддержка таких платформ, как Intel Core Ultra 200V. Первый релиз DeepSeek-R1-Distill-Qwen-1.5B будет доступен на AI Toolkit, а за ним последуют версии 7B и 14B. Эти оптимизированные модели позволят разработчикам создавать и внедрять приложения ИИ, которые будут эффективно работать на устройстве, используя все преимущества мощности NPU в ПК Copilot+.

Нейронный процессор Copilot+ PC обеспечивает высокоэффективный механизм вывода моделей, открывая новую парадигму для генеративного ИИ, позволяющую не только работать по требованию, но и создавать полунепрерывные сервисы. Это позволяет разработчикам создавать проактивный непрерывный опыт с мощными механизмами вывода. Благодаря использованию технологий проекта Phi Silica мы добились эффективности вычислений - минимизации времени работы от батареи и потребления системных ресурсов, обеспечивая при этом конкурентоспособное время отклика на первый токен и пропускную способность. В оптимизированной для NPU модели DeepSeek используется ряд ключевых технологий проекта, включая: модель модульная конструкция для оптимального баланса производительности и эффективности, методы квантования с низкой разрядностью и стратегия отображения Transformer на NPU. Кроме того, мы используем Windows Copilot Runtime (WCR) для масштабирования в экосистеме Windows через формат ONNX QDQ.

Испытайте это прямо сейчас!

Во-первых... Давайте быстро начнем.

Чтобы испытать DeepSeek на компьютерах Copilot+, просто загрузите расширение VS Code для AI Toolkit. Оптимизированные модели DeepSeek в формате ONNX QDQ скоро будут доступны в репозитории моделей AI Toolkit и будут браться непосредственно из Azure AI Foundry. Нажмите кнопку "Загрузить" для локальной загрузки. После загрузки просто откройте Playground, загрузите модель "deepseek_r1_1_5" и начните экспериментировать с подсказками.

Помимо модели ONNX, оптимизированной для Copilot+ PC, вы также можете использовать модель ONNX для Copilot+ PC, нажав на кнопку "DeepSeek R1"Попробуй войти". Игровая площадка", чтобы ознакомиться с оригинальной моделью, размещенной в облаке Azure Foundry.

Инструментарий AI Toolkit является важной частью рабочего процесса разработчиков, поддерживая эксперименты с моделями и готовность к развертыванию. С помощью этой игровой площадки вы можете легко тестировать модели DeepSeek в Azure AI Foundry для локального развертывания.

Оптимизация на уровне кристалла

Оптимизированная для дистилляции модель Qwen 1.5B содержит токенизатор, слой встраивания, модель обработки контекста, модель итерации токенов, заголовок языковой модели и модуль детокенизатора.

Мы используем 4-битное квантование чанков для слоя встраивания и заголовка языковой модели и выполняем эти операции, требующие большого объема памяти, на центральном процессоре. Сосредоточив основные ресурсы оптимизации NPU на вычислительно интенсивном модуле Transformer, содержащем обработку контекста и итерацию Token, мы используем квантование по каналам int4 и выборочную обработку со смешанной точностью для весов, в то время как значения активации используют точность int16.

Хотя в релизе DeepSeek Qwen 1.5B есть версия int4, она не может быть напрямую адаптирована к NPU из-за наличия динамических форм и поведения ввода - их необходимо оптимизировать для совместимости и оптимальной эффективности. Кроме того, мы используемONNX QDQформат для поддержки масштабирования различных типов NPU в экосистеме Windows. Мы оптимизируем расположение операторов между CPU и NPU для достижения оптимального баланса между энергопотреблением и скоростью.

Для достижения двойных целей - малого объема памяти и быстрого вывода (аналогично схеме Phi Silica) - мы сделали два ключевых улучшения: во-первых, мы используем дизайн со скользящим окном, который обеспечивает сверхбыстрое время отклика на первый Token и поддержку длинного контекста, даже если аппаратный стек не поддерживает динамический тензор; во-вторых, мы используем 4-битную схему квантования QuaRot, которая использует все преимущества обработки с малой разрядностью. QuaRot устраняет промахи в весах и значениях активации с помощью хадамардова вращения, что облегчает квантование модели. По сравнению с существующими методами, такими как GPTQ, QuaRot значительно повышает точность квантования, особенно в сценариях с низкой гранулярностью, таких как квантование по каналам. Сочетание квантования с малой шириной битов и аппаратных оптимизаций, таких как дизайн скользящего окна, позволяет модели достичь поведенческих свойств большой модели при компактном объеме памяти. В результате этих оптимизаций модель достигает времени отклика на первый токен 130 мс и пропускной способности 16 токенов/сек в сценариях с короткими репликами (<64 токенов).

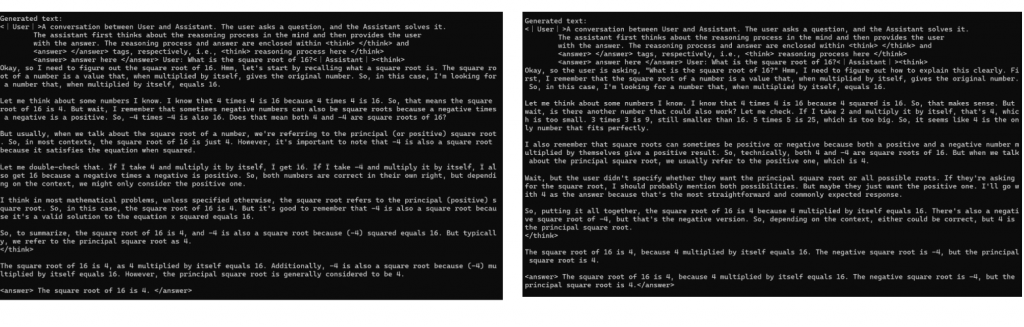

Мы демонстрируем тонкие различия между ответом оригинальной модели и ответом количественной модели на следующем примере, в котором достигается оптимизация энергоэффективности при сохранении высокой производительности:

Рис. 1: Качественное сравнение. Примеры оригинальной модели (слева) и оптимизированной модели NPU (справа), реагирующих на одни и те же сигналы, включая демонстрацию способности модели к рассуждению. Оптимизированная модель сохраняет модель рассуждений оригинальной модели и приходит к тому же выводу, демонстрируя тем самым, что она сохраняет способность к рассуждениям оригинальной модели.

Благодаря превосходной скорости и энергоэффективности моделей DeepSeek R1, оптимизированных для работы с NPU, пользователи смогут взаимодействовать с этими революционными моделями локально и полностью автономно.

Связанное чтение 2: "DeepSeek R1 теперь доступен на Azure AI Foundry и GitHub

DeepSeek R1 уже доступен Azure AI Foundry и каталоге моделей GitHub, присоединившись к разнообразному портфелю из более чем 1800 моделей, включающему передовые, открытые, отраслевые и ориентированные на конкретные задачи модели ИИ. Являясь частью Azure AI Foundry, DeepSeek R1 доступен через надежную, масштабируемую и готовую к использованию на предприятии платформу, которая позволяет организациям легко интегрировать передовые технологии ИИ, соблюдая SLA, безопасность и обещания ответственного ИИ - все это подкреплено надежностью и инновациями Microsoft. Все это подкреплено надежностью и инновациями Microsoft.

Ускорение процесса обоснования ИИ для разработчиков Azure AI Foundry

ИИ-рассуждения набирают популярность с огромной скоростью, меняя способы применения передового интеллекта разработчиками и предприятиями. Как объясняет DeepSeek, R1 предоставляет мощные и экономически эффективные модели, которые позволяют большему числу пользователей получить доступ к самым передовым возможностям ИИ при минимальных инвестициях в инфраструктуру.

Основное преимущество использования DeepSeek R1 или других моделей в Azure AI Foundry - это скорость, с которой разработчики могут экспериментировать, проводить итерации и внедрять ИИ в свои рабочие процессы. Благодаря встроенным инструментам оценки моделей разработчики могут быстро сравнивать результаты, оценивать показатели производительности и масштабировать приложения, основанные на ИИ. Такой быстрый доступ, немыслимый всего несколько месяцев назад, лежит в основе нашего видения Azure AI Foundry: собрать лучшие модели ИИ в одном месте, ускорить инновации и раскрыть новые возможности для организаций по всему миру.

Разработка с использованием доверенного искусственного интеллекта

Мы стремимся помочь нашим клиентам быстро создавать готовые к производству приложения искусственного интеллекта, поддерживая при этом самые высокие стандарты безопасности. deepSeek R1 прошел строгое "тестирование красной команды" и оценку безопасности, включая автоматическую оценку поведения моделей и всесторонний анализ безопасности для снижения потенциальных рисков. Встроенная фильтрация контента включена по умолчанию с гибкими возможностями отказа от нее через Azure AI Content Security. Кроме того, система оценки безопасности помогает заказчикам эффективно тестировать приложения перед развертыванием. Эти меры защиты позволяют Azure AI Foundry предоставлять организациям безопасную, совместимую и ответственную среду для развертывания решений ИИ.

Как использовать DeepSeek в каталоге моделей

- Если у вас нет подписки на Azure, теперь вы можетеЗарегистрируйтесь для получения учетной записи Azure

- Поиск DeepSeek R1 в каталоге моделей

- Откройте карточку модели в каталоге моделей Azure AI Foundry

- Нажмите "Развернуть", чтобы получить API-интерфейс и ключ и получить доступ к тестовой площадке.

- Через 1 минуту вы попадете на страницу развертывания, где будет указан API и ключ, попробуйте ввести запрос в тестовой среде

- API и ключ можно использовать с нескольких клиентов

Начните прямо сейчас

DeepSeek R1 теперь доступен через бессерверную конечную точку в каталоге моделей Azure AI Foundry.Получите доступ к Azure AI Foundry уже сегодня и выберите модель DeepSeek.

Изучите другие ресурсы и получите пошаговое руководство по беспрепятственной интеграции DeepSeek R1 в ваше приложение на GitHub. Читайте Модели GitHub Заметка в блоге.

Скоро: клиенты смогут работать локально на компьютерах Copilot+, используя легкую модель DeepSeek R1. Подробнее Разработчик Windows Заметка в блоге.

Продолжая расширять каталог моделей Azure AI Foundry, мы с нетерпением ждем возможности увидеть, как разработчики и предприятия используют DeepSeek R1 для решения реальных задач и создания революционного опыта. Мы стремимся предоставить наиболее полный портфель моделей ИИ, чтобы обеспечить организациям любого размера доступ к передовым инструментам для инноваций и успеха".

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...