VideoMind: видео по временной метке, позиционирование контента и проект с открытым исходным кодом Q&A

Общее введение

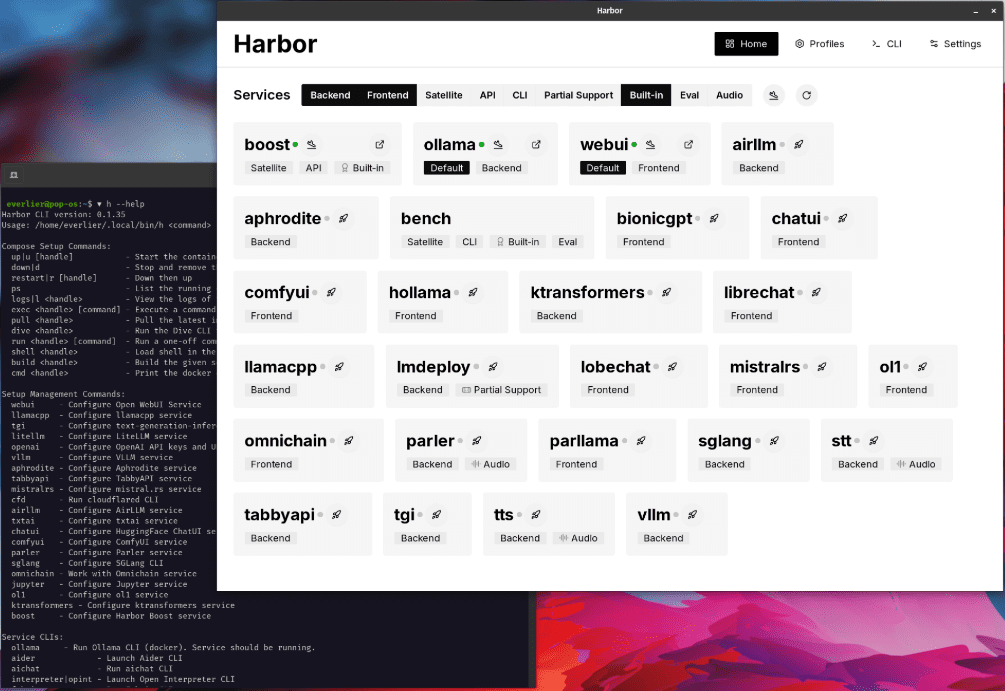

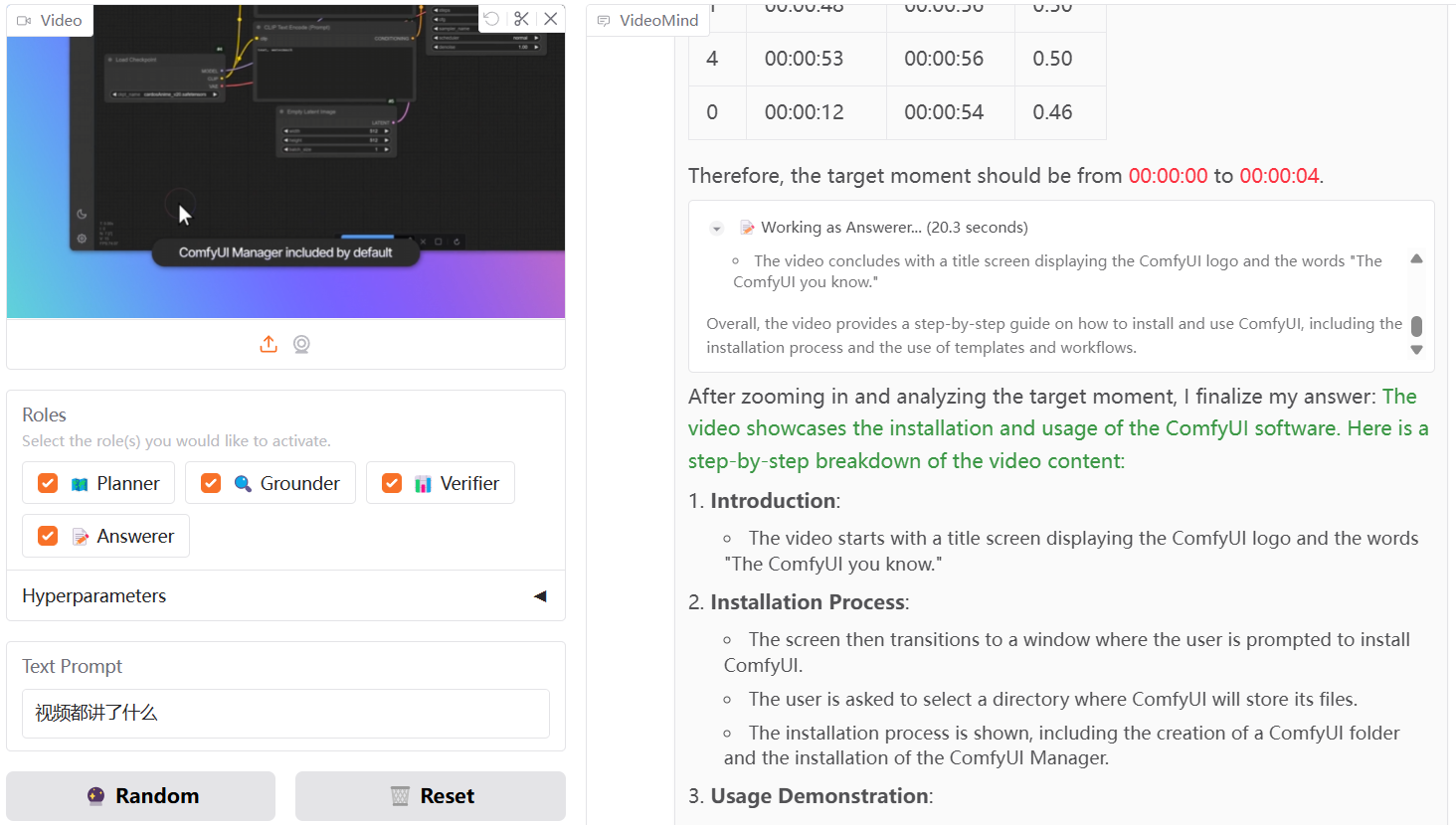

VideoMind - это мультимодальный ИИ-инструмент с открытым исходным кодом, который предназначен для создания выводов, вопросов и ответов и резюме для длинных видео. Он был разработан Йе Лю из Гонконгского политехнического университета и командой из Show Lab Национального университета Сингапура. Инструмент имитирует то, как человек понимает видео, разбивая задачу на этапы, такие как планирование, позиционирование, проверка и ответ, чтобы решить проблему шаг за шагом. Основной технологией является Chain-of-LoRA, которая переключает роли через базовую модель, что является эффективным и ресурсосберегающим решением.VideoMind официально выпускает код, модель и набор данных 21 марта 2024 года, а технический отчет обновляется 17 марта 2025 года.VideoMind доступен на GitHub или через GitHub. Пользователи могут получить доступ к ресурсам через GitHub или Hugging Face.

Проект не извлекает аудио в текст, чтобы понять содержание, а чисто графически и по временной метке точно понять содержание видео, может быть использован для автоматической настройки видео, сценариев обучения, очень практично!

Опыт работы: https://huggingface.co/spaces/yeliudev/VideoMind-2B

Список функций

- Временной таргетинг длинных видео: найдите в видео временной отрезок, который соответствует вопросу.

- Функция Video Q&A: извлечение точных ответов из видео на основе вопросов пользователя.

- Создание краткого обзора видео: выделите ключевой контент видео для создания краткого обзора.

- Мультимодальная система агентов: включает планировщиков, локаторов, валидаторов и респондентов, которые сотрудничают при выполнении задач.

- Технология Chain-of-LoRA: многофункциональность одной модели и снижение потребления ресурсов.

- Поддержка различных аппаратных средств: работает на графических процессорах NVIDIA или NPU Ascend.

- Эффективная поддержка обучения: интеграция DeepSpeed, LoRA, FlashAttention2 и других технологий.

- Онлайн-демонстрация: быстрое знакомство с функциональностью через интерфейс Gradio.

Использование помощи

VideoMind - это проект с открытым исходным кодом, для его использования пользователям необходимо загрузить код и настроить среду. Ниже представлено подробное руководство по установке и использованию функций.

Процесс установки

- Репозиторий клонированного кода

Выполните следующую команду в терминале, чтобы загрузить исходный код VideoMind:

git clone https://github.com/yeliudev/VideoMind.git

Перейдите в каталог проектов:

cd VideoMind

- Настройка среды Python

Создайте виртуальную среду с помощью conda (рекомендуется Python 3.12):

conda create -n videomind python=3.12 -y

conda activate videomind

- Установка зависимых библиотек

Выполните следующую команду для установки необходимых зависимостей:

pip install -r requirements.txt

Для эффективного обучения установите DeepSpeed:

pip install deepspeed

- Скачать модели и наборы данных

- Посетите сайт https://huggingface.co/collections/yeliudev/videomind-67dd41f42c57f0e7433afb36, чтобы загрузить предварительно обученные модели (например.

VideoMind-2B), распакуйте его вmodelsПапка. - Наборы данных доступны на сайте https://huggingface.co/datasets/yeliudev/VideoMind-Dataset下载 и включают 27 наборов видеоданных и VideoMind-SFT (481K обучающих данных), размещенных в

dataКаталог.

- тестовая установка

Запустите сценарий тестирования, чтобы убедиться, что среда создана правильно:

python test.py

Основные функции

1. Позиционирование по времени видео в длинной форме

- Подготовьте видео: Поместите видеофайл в

data/videosКаталог, поддержка MP4, AVI и других форматов. - Выполнить команду::

python run_grounding.py --video_path data/videos/sample.mp4 --query "找到讨论AI的部分"

- Вывод результатов: Возвращает диапазон времени, например, "00:05:12 - 00:07:34".

2. Видеовикторина

- Вопросы ввода: Новый

query.txtНапишите вопросы, например, "Кто главный герой видео?". . - выполнить команду::

python run_qa.py --video_path data/videos/sample.mp4 --query_file query.txt

- Получить ответы: Терминал выводит результаты, например, "Главный герой - Ли Минг".

3. Формирование краткого видеоматериала

- Выполнить команду::

python run_summary.py --video_path data/videos/sample.mp4

- Посмотреть краткое содержание: Результаты сохраняются в формате

summary.txtНапример, "Видеоролик знакомит с лекцией по науке и технике".

Функциональное управление

Технология "цепь Лора

- VideoMind использует одну модель для переключения ролей через адаптеры LoRA. Файлы конфигурации доступны в

config/lora.yamlРегулируемыйrankЭффект усиления параметров:

lora:

rank: 16

Онлайн-демонстрация

- Локальная установка не требуется, поэтому вы можете посетить сайт https://huggingface.co/spaces/yeliudev/VideoMind-2B, загрузить видео и задать свой вопрос, чтобы ознакомиться с функциональностью напрямую. Для получения дополнительной информации см.

docs/DEMO.md.

Модели обучения

- Подготовьте данные: Использование

VideoMind-SFTили 27 других наборов данных, помещенных вdataКаталог. - обучение грунтовке: Беги:

python train.py --dataset data/VideoMind-SFT --model models/VideoMind-2B

- Мониторинг обучения: Поддержка Tensorboard или Wandb для просмотра прогресса, для настройки см.

docs/TRAIN.md.

предостережение

- Если видеофайл слишком большой, рекомендуется обрабатывать его по сегментам, чтобы избежать переполнения памяти.

- Пользователям Ascend NPU необходимо установить драйвер Ascend и добавить параметры при запуске.

--device ascend. - Дополнительную информацию о вводе в эксплуатацию см.

docs/EVAL.mdВ том числе рекомендации по бенчмаркингу.

Выполнив эти действия, пользователи смогут быстро установить и использовать VideoMind для работы с длинными видеозаписями.

сценарий применения

- Анализ содержания видеоматериалов

С помощью VideoMind пользователи могут анализировать длинные видеоролики на YouTube, находить ключевые клипы или составлять резюме, чтобы сэкономить время просмотра. - Образование и исследования

Студенты и исследователи, работающие с видеозаписями лекций, могут спросить: "Какие алгоритмы были рассмотрены?" и получить ответы, более эффективно организуя записи. - Аудит содержания

Администраторы платформ используют его для проверки соответствия видеоконтента требованиям, например, для проверки нежелательных клипов.

QA

- Какой длины видео может обрабатывать VideoMind?

В зависимости от аппаратного обеспечения, 16 ГБ оперативной памяти могут справиться с часом видео, а 32 ГБ - с более длительным контентом. - В чем разница между онлайн-демонстрацией и локальным развертыванием?

Онлайн-версия не требует установки, но имеет ограниченную функциональность; локальная версия поддерживает индивидуальное обучение и крупномасштабную обработку. - Как используются наборы данных?

Для обучения и оценки использовалось 27 наборов данных, а для оптимизации моделей использовался VideoMind-SFT, как описано на сайте https://huggingface.co/datasets/yeliudev/VideoMind-Dataset.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...