UltraLight Digital Human: ультралегкий цифровой человек с открытым исходным кодом, работающий в реальном времени, с установкой в один клик

Общее введение

Ultralight Digital Human - это проект с открытым исходным кодом, целью которого является разработка сверхлегкой цифровой модели человека, способной работать в режиме реального времени на мобильных устройствах. Проект обеспечивает плавную работу на мобильных устройствах за счет оптимизации алгоритмов и структуры моделей для различных сценариев, таких как социальные приложения, игры и виртуальная реальность. Пользователи смогут легко обучать и внедрять свои собственные цифровые модели человека, чтобы наслаждаться персонализированным и захватывающим опытом.

Что касается того, что он отлично работает на мобильных, просто измените количество каналов в этой текущей модели на чуть меньшее и используйте wenet для аудиофункций, и все будет в порядке.

Список функций

- работа в режиме реального времениМодели могут работать в режиме реального времени на мобильных устройствах и являются отзывчивыми.

- Легкая конструкция: Оптимизированная структура модели для мобильных устройств с ограниченными ресурсами.

- проект с открытым исходным кодомКод и модель полностью открыты и могут свободно модифицироваться и использоваться пользователями.

- многосценарное приложение: Подходит для различных сценариев, таких как социальные приложения, игры, виртуальная реальность и многое другое.

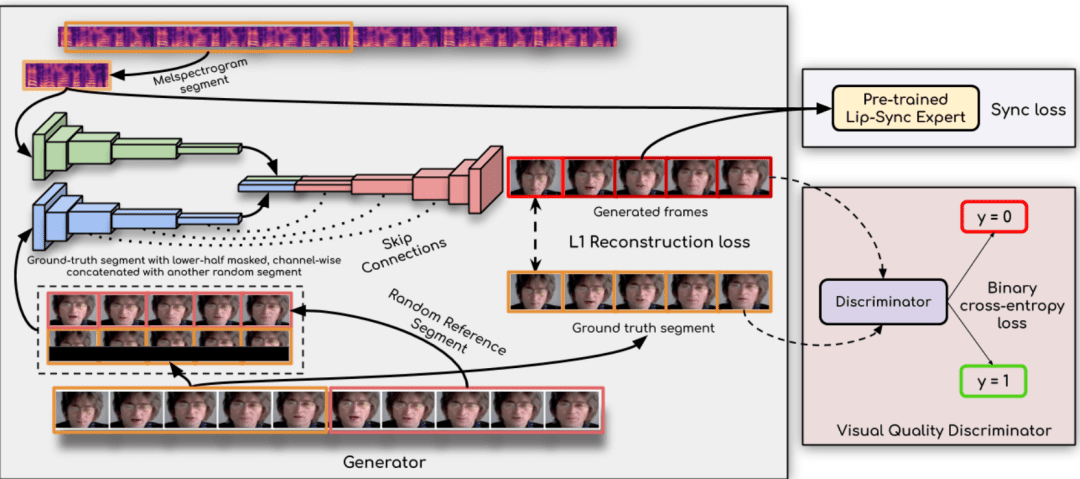

- Извлечение аудио признаков: Поддерживает схемы извлечения звуковых признаков wenet и hubert.

- синхронная сеть: Улучшенная синхронизация губ с помощью технологии syncnet.

- Подробное руководство: Подробные учебные материалы и руководства по использованию помогут пользователям быстро освоиться.

Использование помощи

Процесс установки

- Подготовка к защите окружающей среды::

- Установите Python 3.10 и выше.

- Установите PyTorch 1.13.1 и другие зависимости:

conda create -n dh python=3.10 conda activate dh conda install pytorch==1.13.1 torchvision==0.14.1 torchaudio==0.13.1 pytorch-cuda=11.7 -c pytorch -c nvidia conda install mkl=2024.0 pip install opencv-python transformers numpy==1.23.5 soundfile librosa onnxruntime

- Загрузить файлы модели::

- Скачайте файл wenet encoder.onnx по следующей ссылке и поместите его в папку

data_utils/Каталог: ссылка для скачивания

- Скачайте файл wenet encoder.onnx по следующей ссылке и поместите его в папку

Процесс использования

- Подготовьте видео::

- Подготовьте 3-5-минутный видеоролик, убедившись, что в каждом кадре есть полная экспозиция лица, а звук чистый и без шумов.

- Поместите видео в новую папку.

- Извлечение звуковых характеристик::

- Используйте следующие команды для извлечения звуковых характеристик:

cd data_utils python process.py YOUR_VIDEO_PATH --asr hubert

- Используйте следующие команды для извлечения звуковых характеристик:

- Модели обучения::

- Обучите модель syncnet для получения лучших результатов:

cd .. python syncnet.py --save_dir ./syncnet_ckpt/ --dataset_dir ./data_dir/ --asr hubert - Обучите цифровую модель человека, используя контрольную точку с наименьшими потерями:

python train.py --dataset_dir ./data_dir/ --save_dir ./checkpoint/ --asr hubert --use_syncnet --syncnet_checkpoint syncnet_ckpt

- Обучите модель syncnet для получения лучших результатов:

- вывод::

- Извлечение характеристик тестового звука:

python extract_test_audio.py YOUR_TEST_AUDIO_PATH --asr hubert - Бегущие рассуждения:

python inference.py --dataset ./data_dir/ --audio_feat ./your_test_audio_hu.npy --save_path ./output.mp4 --checkpoint ./checkpoint/best_model.pth

- Извлечение характеристик тестового звука:

предостережение

- Убедитесь, что частота кадров видео соответствует выбранной схеме извлечения звуковых признаков: 20 кадров в секунду для wenet и 25 кадров в секунду для hubert.

- В процессе обучения и вывода результатов регулярно отслеживается значение потерь модели и выбирается оптимальная контрольная точка для обучения.

Пакет интеграции Monkey One Click

https://pan.baidu.com/s/19DcRlR0kJVg4bLb7snUrBQ?pwd=tct1

Для вашего практического удобства я объединил и изложил вышеописанный процесс (Включает модельные веса и тестовые примеры):

Вам просто нужно подурачиться:

шаг 0: Установите зависимости:

conda create -n udh python=3.10 conda activate udh pip install -r requirements.txt

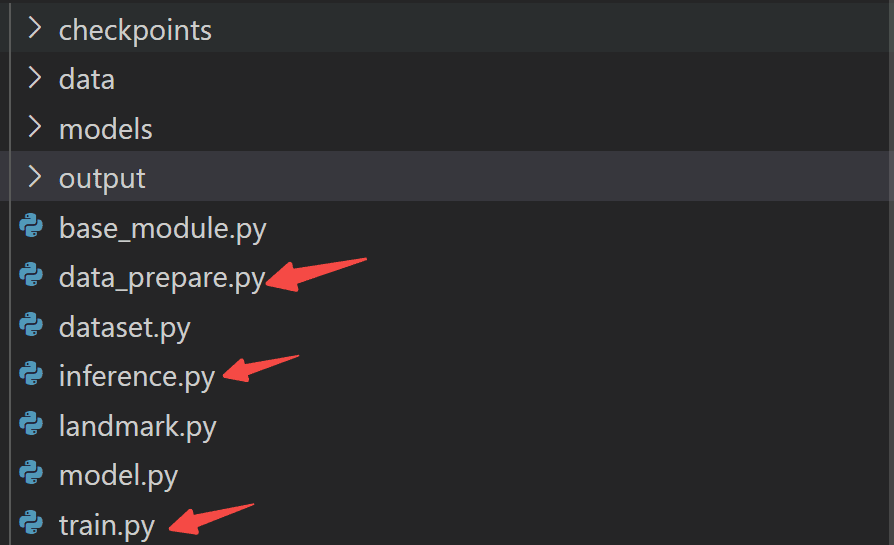

шаг 1: подготовка данных:

python data_prepare.py

ШАГ 2: Обучение модели:

python train.py

ЭТАП 3: Моделирование рассуждений:

python inference.py

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...