Бесплатный курс о том, как работают трансформеры LLM от Enda Wu

Как работают магистры-трансформеры?

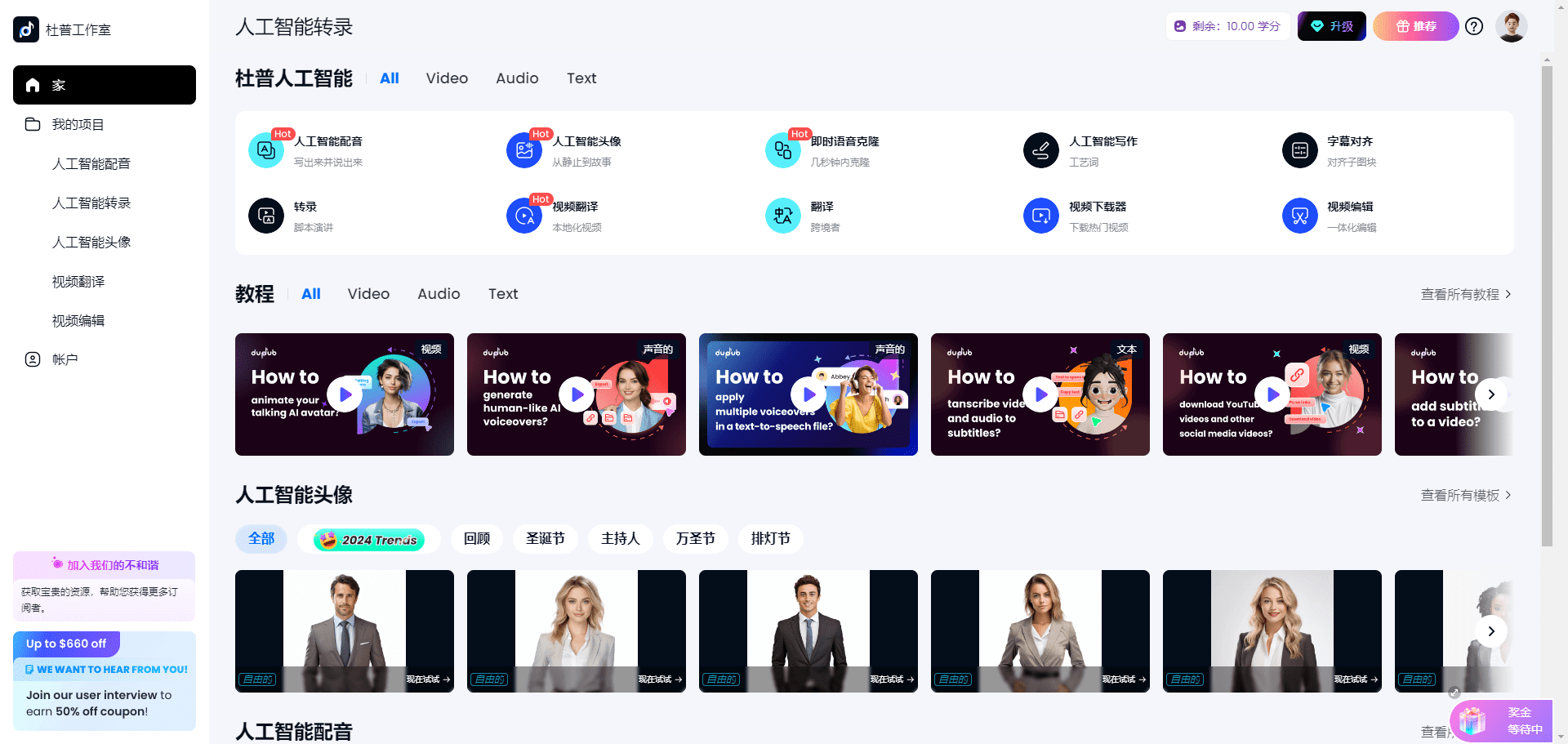

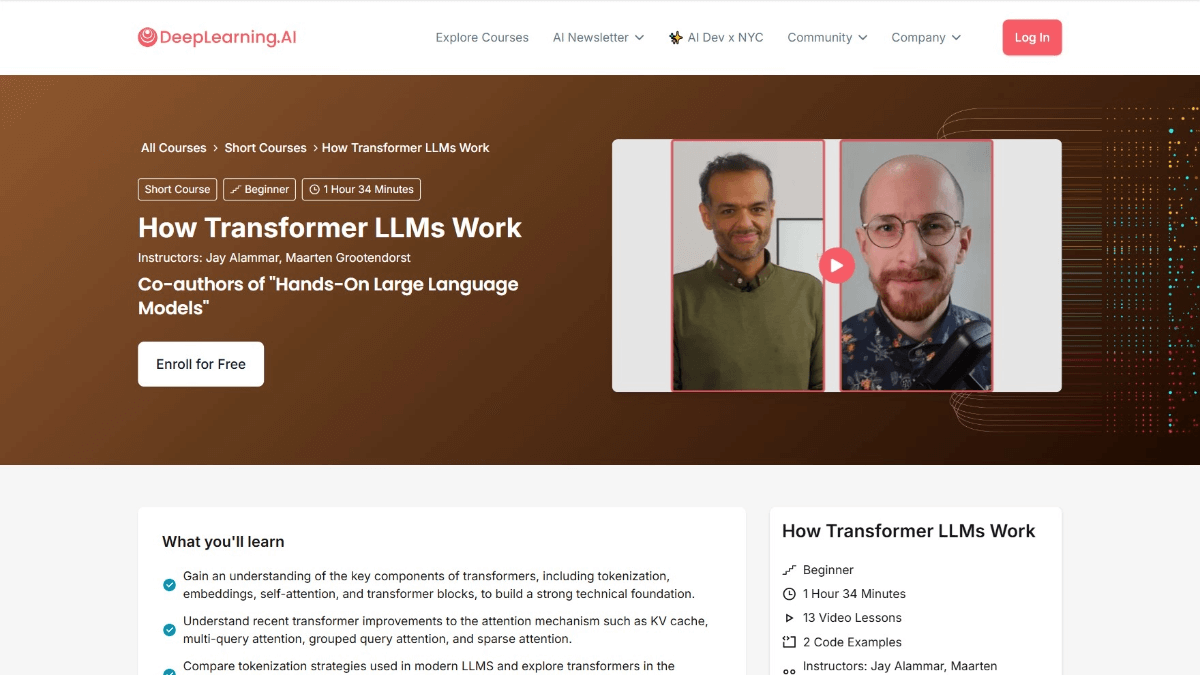

Трансформатор Как работают LLM - это курс от DeepLearning.AI в сотрудничестве с Джеем Аламмаром и Маартеном Гроотендорстом, авторами книги Hands-On Large Language Models. В курсе подробно рассматривается архитектура трансформера, поддерживающая большие языковые модели (LLM). Курс начинается с эволюции численного представления языков и охватывает такие темы, как дезамбигуация, механизм внимания и фидфорвардный слой блоков Transformer, а также способы повышения производительности за счет кэширования вычислений. После прохождения курса пользователи получат глубокое понимание того, как LLM обрабатывают языки, смогут читать и понимать соответствующие статьи, а также улучшат свои возможности по созданию LLM-приложений.

Задачи курса "Как работают трансформаторы LLM

- Понимание эволюции цифрового представления языка: Понимание того, как язык представляется в цифровом виде, от простых моделей Bag-of-Words до сложных архитектур трансформаторов.

- Освоение обработки причастий: Изучение того, как разложить входной текст на "лексемы", и понимание того, как эти лексемы поступают в языковую модель.

- Погружение в архитектуру трансформатораПодробно рассматриваются три основных этапа архитектуры Transformer: дезамбигирование и встраивание, укладка блоков Transformer и заголовки языковых моделей.

- Понимание деталей блока трансформатораВключает в себя механизмы внимания и слои с обратной связью, а также то, как они работают вместе для обработки и создания текста.

- Оптимизация эффективности обучения: Узнайте, как повысить производительность Transformer с помощью таких методов, как вычисление кэша.

- Практическое применение Исследование: Изучение последних реализаций моделей для расширенного практического применения с помощью библиотеки Hugging Face Transformer.

Краткое описание курса, как работает трансформер LLM

- Обзор трансформаторных LLM: Введение в цели курса, структуру и важность архитектуры Transformer в контексте современных больших языковых моделей (LLM).

- Эволюция языковой репрезентации: Взгляд на эволюцию моделирования языка от Bag-of-Words, Word2Vec и архитектуры Transformer.

- причастие и вкрапления: Узнайте, как разложить входной текст на лексемы и как преобразовать лексемы в векторы встраивания, включая применение позиционного кодирования.

- Трансформаторный блок: Поймите структуру блока трансформатора, включая механизм самовнушения и роль сетей с прямой передачей.

- Долгое внимание: Исследуйте, как многоголовые механизмы внимания могут улучшить производительность модели за счет захвата различных аспектов входного сигнала через несколько "голов".

- Штабелирование трансформаторных блоков: Узнайте, как строить глубокие модели путем объединения нескольких блоков Transformer, а также о роли остаточного связывания и нормализации слоев.

- Заголовок языковой модели: Поймите, как Transformer реализует генерацию текста, генерируя распределение вероятности следующей лексемы из заголовка языковой модели.

- механизм кэширования: Узнайте, как повысить скорость вывода моделей Transformer с помощью механизмов кэширования, а также о практическом применении кэширования.

- Новейшие архитектурные инновации: Представляет последние инновации в архитектуре Mixture-of-Experts (MoE) и других архитектурах трансформаторов.

- Реализация трансформатора с обнимающимся лицом: Узнайте, как загружать и настраивать предварительно обученные модели трансформеров с помощью библиотеки Hugging Face Transformers.

- Практическое кодирование трансформера: Узнайте, как реализовать ключевые компоненты трансформера и построить простые модели трансформеров с помощью практических упражнений по кодированию.

- Исследовательская работа по чтению и пониманию: Научитесь читать и понимать научные работы по трансформаторам, анализируя последние работы и их вклад в развитие этой области.

- Создание заявок на получение степени магистра: Изучите, как разрабатывать приложения на основе LLM, и обсудите будущие направления и потенциальные применения архитектуры Transformer.

Адрес курса для ознакомления с работой трансформера LLM

- Адрес курса::DeepLearning.AI

На кого работают магистры-трансформеры

- исследователь в области обработки естественного языка (NLP): Углубленное изучение архитектуры Transformer, исследование передовых приложений в области понимания, генерации и перевода языка, а также содействие развитию технологий обработки естественного языка.

- Инженер по машинному обучению: Освойте работу Transformer, чтобы иметь возможность оптимизировать работу модели, повысить точность и эффективность моделирования, а также разрабатывать более мощные приложения для языковых моделей.

- специалист по анализу данных: Обработка и анализ крупномасштабных текстовых данных с помощью архитектуры Transformer, поиск закономерностей и информации для поддержки принятия решений.

- разработчик программного обеспечения: Интеграция трансформеров LLM в различные программные приложения, такие как чат-боты, системы рекомендаций контента и т. д., для повышения интеллектуальности продукта.

- Энтузиасты искусственного интеллекта: Интересуетесь архитектурой Transformer и хотите узнать, как она работает, глубже понять технологию искусственного интеллекта и расширить свой технический кругозор.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...