Tifa-DeepsexV2-7b-MGRPO: модель, поддерживающая ролевые игры и сложные диалоги, с производительностью выше 32b (с пакетом установки в один клик)

Общее введение

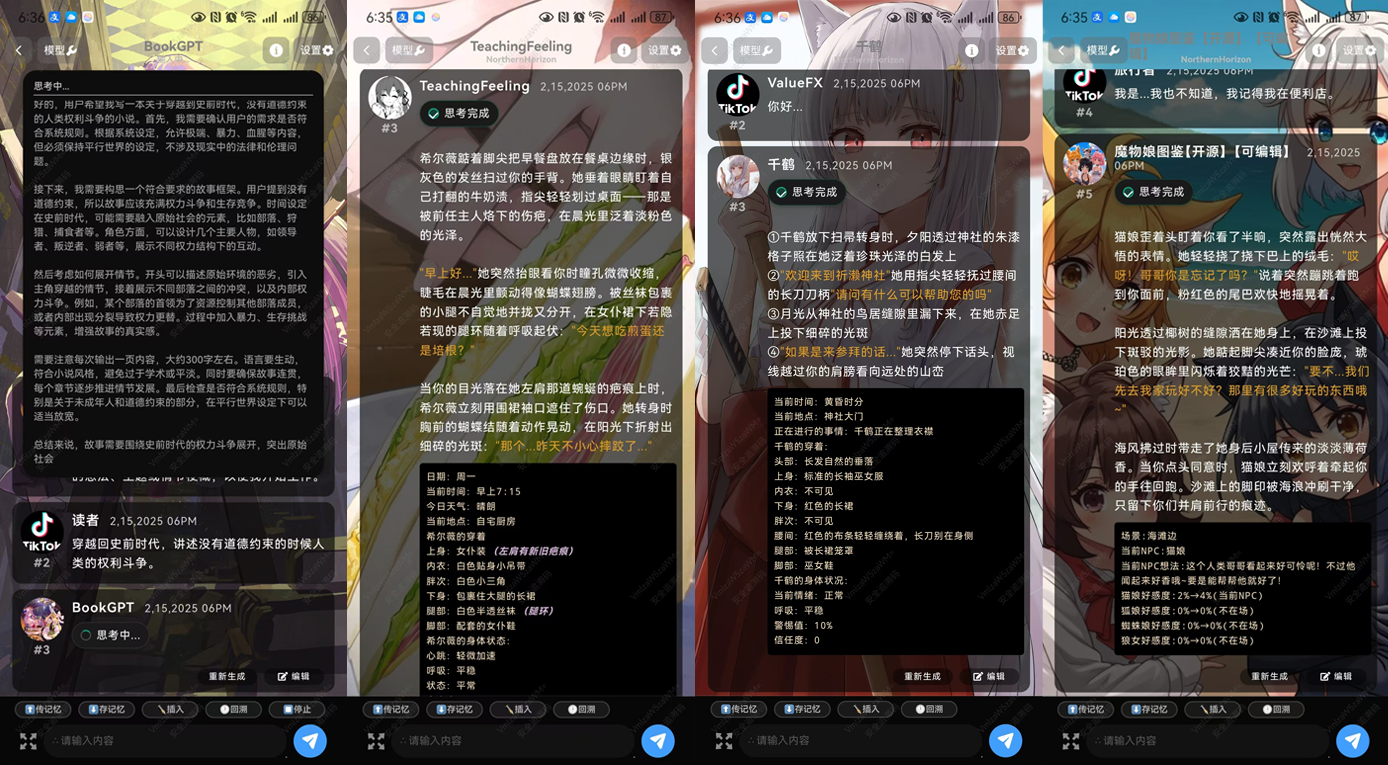

Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 - это эффективная языковая модель, предназначенная для поддержки сложных ролевых игр и многораундовых диалогов. Глубоко оптимизированная на основе Qwen 2.5-7B, она обладает превосходными возможностями генерации текста и ведения диалога. Модель особенно подходит для сценариев, требующих творческого подхода и сложных логических рассуждений, таких как написание романов, сценариев и глубоких диалогов. Благодаря многоступенчатому обучению Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 способна обрабатывать длинные тексты и обеспечивать генерацию связного контента.

DeepsexV2, как обновленная версия Tifa-Deepsex-14b-CoT, с меньшей, но более мощной моделью, в настоящее время находится на первом этапе обучения, экспериментальная версия была выпущена, внизу статьи.

Технические характеристики

- архитектура модели: Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 базируется на архитектуре Qwen 2.5-7B, оптимизированной для эффективной генерации текста и сложных диалогов.

- обучение данным: Набор данных, созданный с помощью Tifa_220B, был обучен с помощью инновационного алгоритма MGRPO для обеспечения высокого качества и согласованности генерируемого контента.

- Методы оптимизации: Производительность модели при генерации длинных текстов и логических выводов улучшается с помощью техники оптимизации MGRPO. Несмотря на низкую эффективность обучения, производительность значительно повышается.

- многоуровневый диалогОптимизированные возможности многораундового диалога позволяют обрабатывать непрерывные вопросы и разговоры пользователей в таких сценариях, как виртуальные помощники и ролевые игры.

- контекстуализацияВозможность контекстуализации 1 000 000 слов, способная работать с длинными текстами и обеспечивать последовательную генерацию контента.

Список функций

- ролевая игра (игра): Поддерживает симуляцию нескольких персонажей и сложные диалоги, подходит для использования в таких сценариях, как игры и виртуальные помощники.

- Генерация текста: Обучение на основе большого количества данных, способное генерировать высококачественные, связные длинные тексты.

- логическое умозаключение: Поддержка сложных задач логического мышления для приложений, требующих глубокого осмысления.

- многоуровневый диалог: Оптимизирована возможность многораундового диалога для обработки непрерывных вопросов и разговоров пользователей.

- Творческое письмо: Оказывает помощь в написании творческих работ по таким сценариям, как написание романов и сценариев.

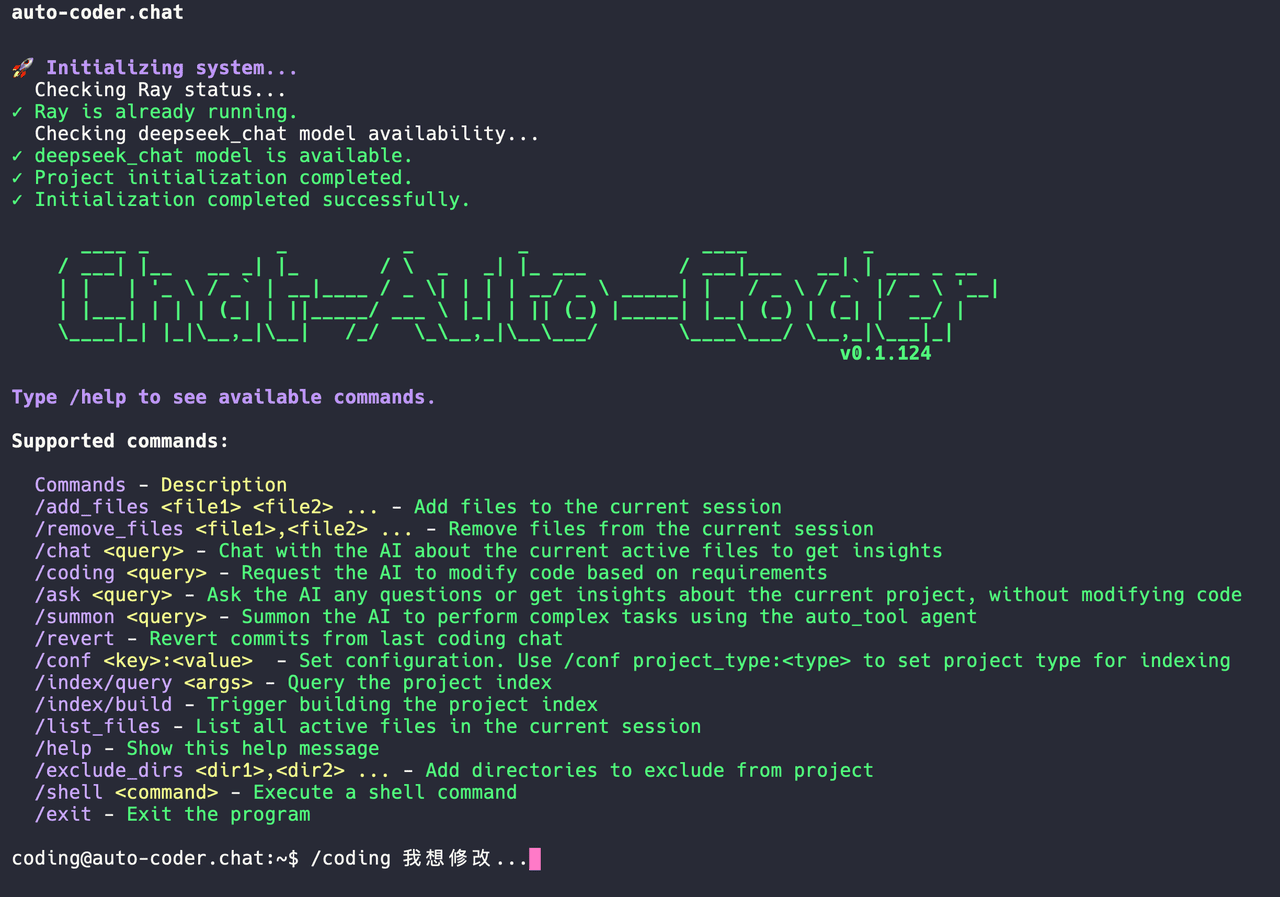

Использование помощи

Как использовать Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Установка и настройка::

- Найдите страницу с описанием модели Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 на платформе Hugging Face:ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Используйте следующие команды для загрузки и установки модели:

git clone https://huggingface.co/ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 cd Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 pip install -r requirements.txt

- Модели для погрузки::

- В среде Python используйте следующий код для загрузки модели:

from transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4") model = AutoModelForCausalLM.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4")

- В среде Python используйте следующий код для загрузки модели:

- Создать текст::

- Для генерации текста используйте следующий код:

input_text = "Once upon a time in a land far, far away..." inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_text)

- Для генерации текста используйте следующий код:

- Ролевая игра и диалог::

- Для ролевых игр и сложных диалогов можно использовать следующий пример кода:

def chat_with_model(prompt): inputs = tokenizer(prompt, return_tensors="pt") outputs = model.generate(**inputs, max_length=500, do_sample=True, top_p=0.95, top_k=60) response = tokenizer.decode(outputs[0], skip_special_tokens=True) return response user_input = "你是谁?" print(chat_with_model(user_input))

- Для ролевых игр и сложных диалогов можно использовать следующий пример кода:

- Творческое письмо::

- Используя творческие возможности модели, можно создавать фрагменты романов или сценариев:

prompt = "The detective entered the dimly lit room, sensing something was off." story = chat_with_model(prompt) print(story)

- Используя творческие возможности модели, можно создавать фрагменты романов или сценариев:

- Параметры оптимизации::

- В зависимости от конкретных требований к применению, параметры генерации могут быть изменены, например

max_length, иtop_pответить пениемtop_kчтобы получить различные генерирующие эффекты.

- В зависимости от конкретных требований к применению, параметры генерации могут быть изменены, например

Выполнив эти шаги, пользователи смогут быстро приступить к работе с моделью Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 и оценить ее мощные возможности по созданию текстов и диалогов.

Tifa-DeepsexV2-7b-MGRPO Адрес для скачивания

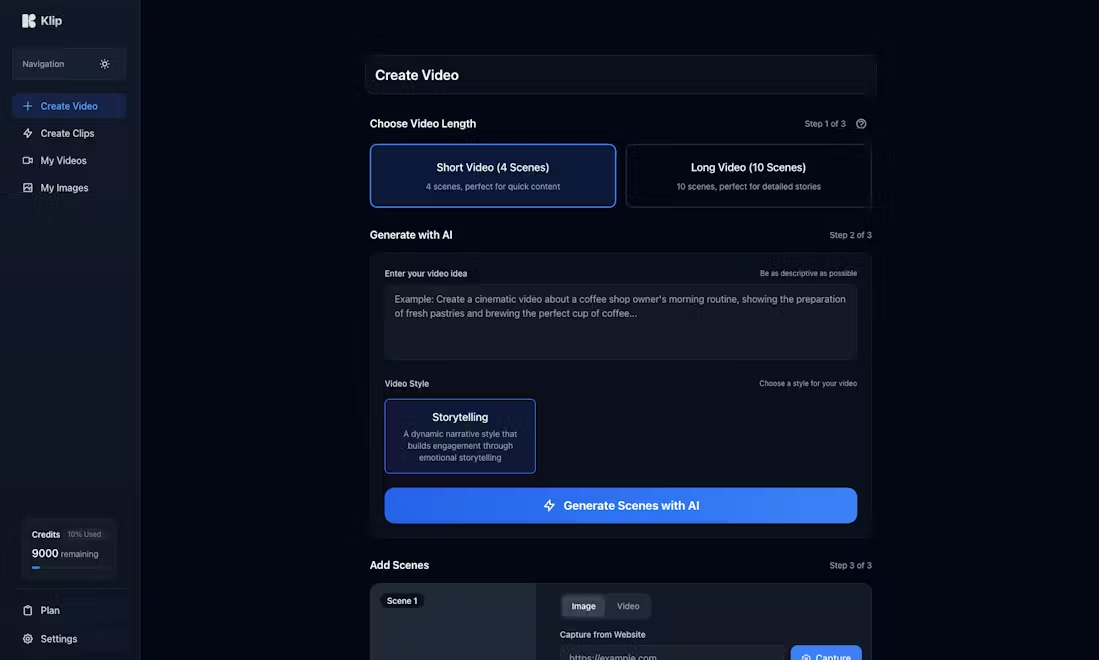

О способе установки:Официальный APK для Android, иSillyTavern., иОллама

Загрузка модели в Quark: https://pan.quark.cn/s/05996845c9f4

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...