TANGO: инструмент для создания видео портретов с координированными жестами и полным телом цифрового человека

Общее введение

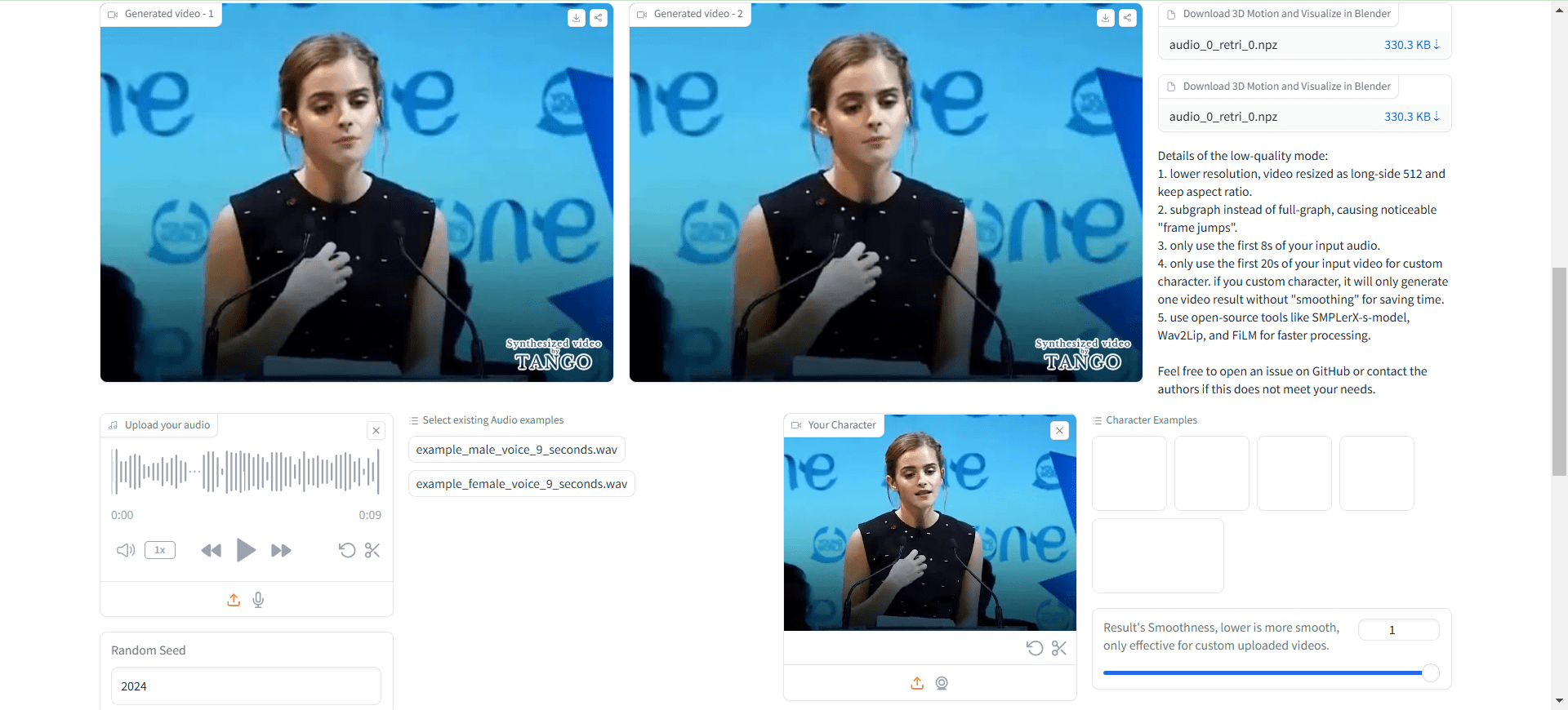

TANGO (Co-Speech Gesture Video Reenactment with Hierarchical Audio-Motion Embedding and Diffusion Interpolation) - это совместная разработка Токийского университета и CyberAgent AI Labs с открытым исходным кодом. фреймворк для совместного создания видеороликов с жестами и речью. Проект использует иерархическое пространство встраивания аудио-движений и диффузионную интерполяцию для автоматического создания естественных, плавных и синхронизированных видео с жестами персонажей на основе входной речи. TANGO достигает высокого качества генерации жестов и действий с помощью инновационного метода поиска графа действий, который сначала извлекает эталонный видеоклип, наиболее близко соответствующий целевой речи в неявном иерархическом пространстве встраивания аудио-движений, а затем использует диффузионную модель для интерполяции действий. генерация действий. Этот проект не только развивает исследования в области взаимодействия человека и компьютера на основе ИИ, но и обеспечивает важную техническую поддержку для таких приложений, как виртуальные якоря и цифровые люди.

Текущий TANGO с открытым исходным кодом поддерживает только аудио длительностью до 8 с, поэтому перед использованием необходимо выполнить сегментацию аудиофайла!

Работайте с инструментом Voice Lip Sync для создания полного проекта цифрового человека: Sync ,Wav2Lip Ultralight Digital Human. Полный рабочий процесс: Ultralight Digital Human для контрапункта, TANGO для генерации движений тела, FaceFusion для изменения лиц, идеально!

Опыт работы в Интернете: https://huggingface.co/spaces/H-Liu1997/TANGO

Список функций

- Высокоточная синхронизация жестов: точная синхронизация любого звука с жестами на видео.

- Поддержка нескольких языков: Работает с различными языками и звуками, включая CGI-лица и синтезированные звуки.

- Открытый исходный код и свобода: код полностью публичен, и пользователи могут свободно использовать и изменять его.

- Интерактивная демонстрация: предоставляет онлайн-демонстрацию, в которую пользователи могут загружать видео- и аудиофайлы для ознакомления.

- Модели предварительного обучения: Предоставляются различные модели предварительного обучения, которые пользователи могут использовать непосредственно или для вторичного обучения.

- Полный обучающий код: включает обучающий код для дискриминатора синхронизации жестов и модели TANGO.

Использование помощи

1. конфигурация окружающей среды

1.1 Основные требования:

- Версия Python: 3.9.20

- Версия CUDA: 11.8

- Дисковое пространство: не менее 35 ГБ (для хранения моделей и предварительно рассчитанных диаграмм)

1.2 Этапы установки:

# 克隆项目仓库

git clone https://github.com/CyberAgentAILab/TANGO.git

cd TANGO

git clone https://github.com/justinjohn0306/Wav2Lip.git

git clone https://github.com/dajes/frame-interpolation-pytorch.git

# 创建虚拟环境(可选)

conda create -n tango python==3.9.20

conda activate tango

# 安装依赖

pip install -r ./pre-requirements.txt

pip install -r ./requirements.txt

2. Поток использования

2.1 Быстрый старт:

- Запустите сценарий рассуждений:

python app.py

При первом запуске система автоматически загружает необходимые файлы контрольных точек и предварительно рассчитанные диаграммы. Для создания примерно 8-секундного видео требуется около 3 минут времени.

2.2 Создание пользовательских ролей:

- Если вам нужно создать фигурку для нового персонажа:

python create_graph.py

Помимо прочего, проект по умолчанию генерирует видео с водяными знаками TANGO, как на рисунке ниже:

По сути, это вызов локального ffmpeg, который компонует исходное видео и изображение с водяным знаком в новое видео.

Если вам не нужен водяной знак, вы можете изменитьapp.pyСредний:

gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0", , watermark="./datasets/watermark.png") # 修改为 gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0")

Доступ не с локального хоста, требуются модификации:

demo.launch(server_name="0.0.0.0", server_port=7860)

Откройте его снова, чтобы обнаружить отсутствие водяного знака на загруженном видео.

Полученное видео не содержит звука, поэтому его нужно синтезировать вручную.

/usr/bin/ffmpeg -i outputs/gradio/test_0/xxx.mp4 -i gen_audio.wav -c:v libx264 -c:a aac result_wav.mp4

Можно заметить: с движениями тела все в порядке, а вот форма рта совершенно неправильная.

Это не так. Ультралегкий цифровой человек И он пригодился?

Процесс использования

- Доступ к локальному серверу: открыть в браузере

http://localhost:3000. - Загрузить видео и аудио: Загрузите аудио- и видеофайлы, которые необходимо синхронизировать, в поле ввода.

- Выполните синхронизацию жестов: нажмите кнопку "Синхронизация", и система автоматически выполнит синхронизацию жестов.

- Просмотр и загрузка результатов: После завершения синхронизации вы можете просмотреть результаты и загрузить синхронизированные видеофайлы.

- Используйте интерактивную демонстрацию: загрузите видео- и аудиофайлы на страницу демонстрации, чтобы увидеть эффект синхронизации жестов в реальном времени.

- Управление проектами: просмотр и управление всеми загруженными проектами на странице "Мои проекты" с поддержкой контроля версий и совместной работы.

Дополнительные возможности

- Интеллектуальная синхронизация жестов: улучшите представление видеоконтента с помощью интеллектуальной синхронизации жестов, обеспечиваемой искусственным интеллектом.

- Поддержка нескольких языков: выбирайте различные языки и голоса в соответствии с потребностями вашего проекта.

- Разработка под заказ: поскольку TANGO имеет открытый исходный код, пользователи могут развивать его в соответствии со своими потребностями.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...