SVLS: SadTalker улучшен для создания цифровых людей на основе портретного видео

Общее введение

SadTalker-Video-Lip-Sync - это инструмент для синтеза губ в видео, основанный на реализации SadTalkers. Проект генерирует формы губ с помощью голоса и использует настраиваемое улучшение областей лица для улучшения четкости сгенерированных форм губ. Проект также использует алгоритм кадровой интерполяции DAIN для заполнения кадров в сгенерированном видео, чтобы сделать переход губ более плавным, реалистичным и естественным. Пользователи могут быстро генерировать высококачественные видеоролики с формами губ с помощью простых операций командной строки, которые подходят для различных задач видеопроизводства и редактирования.

SadTalker оригинал

SadTalker Enhanced

Список функций

- Создание губ на основе речи: Движение губ в видео через аудиофайл.

- Увеличение площади лица: Настраиваемое улучшение изображения губ или всего лица для повышения четкости видео.

- Вставка рамки DAIN: Используйте алгоритмы глубокого обучения для создания патчей на кадрах видео, чтобы улучшить плавность видео.

- Многочисленные возможности усовершенствования: Поддерживает три режима: без улучшения, с улучшением губ и с полным улучшением лица.

- Модель предварительного обучения: Предоставьте пользователям множество предварительно обученных моделей, чтобы они могли быстро приступить к работе.

- Простая работа с командной строкой: Легко настраивается и запускается с помощью параметров командной строки.

Использование помощи

Подготовка к защите окружающей среды

- Установите необходимые зависимости:

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txt

- Если вам нужно использовать модель DAIN для заполнения рамок, вам также необходимо установить Paddle:

python -m pip install paddlepaddle-gpu==2.3.2.post112 -f https://www.paddlepaddle.org.cn/whl/linux/mkl/avx/stable.html

Структура проекта

checkpoints: хранить предварительно обученные моделиdian_output: Хранит выходы для вставки кадров DAINexamples: Образцы аудио- и видеофайловresults: Генерировать результатыsrc: Исходный кодsync_show: Демонстрация эффекта синтезаthird_part: Библиотеки сторонних разработчиковinference.py: Сценарий рассужденияREADME.md: Документ описания проекта

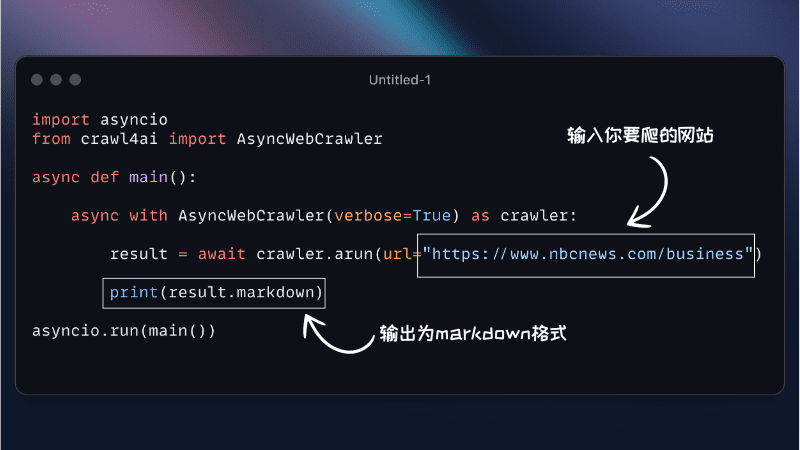

моделируемое рассуждение

Для вывода модели используйте следующую команду:

python inference.py --driven_audio <audio.wav> --source_video <video.mp4> --enhancer <none, lip, face> --use_DAIN --time_step 0.5

--driven_audio: Входные аудиофайлы--source_video: Входной видеофайл--enhancer: Расширенный режим (нет, губы, лицо)--use_DAIN: Использовать ли кадры DAIN--time_step: Интерполированная частота кадров (по умолчанию 0,5, т.е. 25 кадров в секунду -> 50 кадров в секунду)

эффект синтеза

Созданные видеоэффекты показаны в ./sync_show Каталог:

original.mp4: Оригинальное видеоsync_none.mp4: Эффекты синтеза без каких-либо улучшенийnone_dain_50fps.mp4: Преобразование 25 кадров в 50 кадров в секунду с помощью только модели DAINlip_dain_50fps.mp4: Улучшения в области губ + модель DAIN для добавления 25 кадров в секунду к 50 кадрам в секундуface_dain_50fps.mp4: Увеличение площади всего лица + модель DAIN для увеличения 25 кадров в секунду до 50 кадров в секунду

Модель предварительного обучения

Путь загрузки предварительно обученной модели:

- Baidu.com:ссылка (на веб-сайте) Код для извлечения: klfv

- Google Диск:ссылка (на веб-сайте)

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...