STAR: ИИ-модель улучшения пространственного времени для повышения резкости разрешения видео

Общее введение

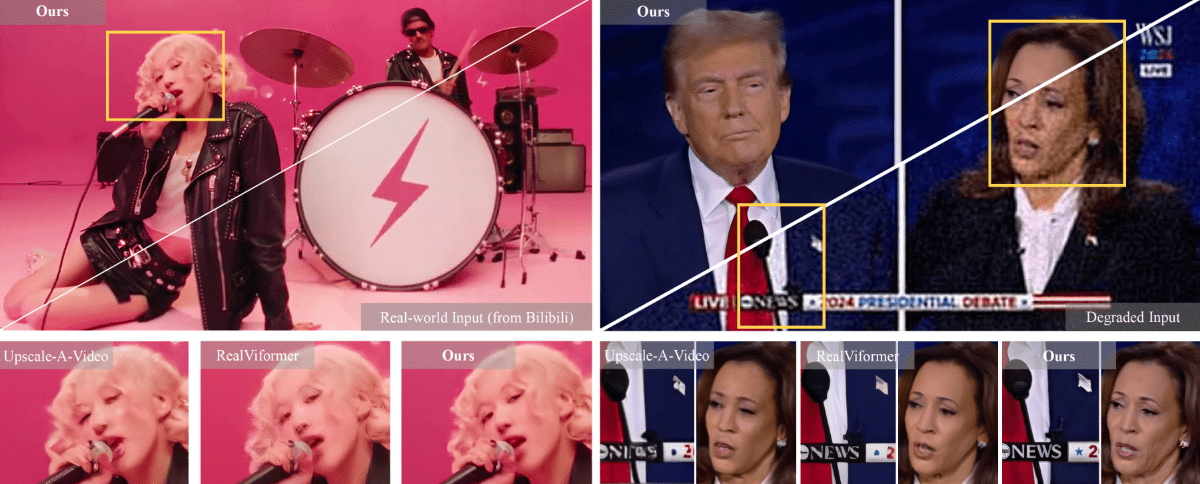

STAR (Spatial-Temporal Augmentation with Text-to-Video Models) - это инновационная система сверхразрешения видео, разработанная совместно Нанкинским университетом, ByteDance и Юго-Западным университетом. Проект посвящен решению ключевых проблем обработки видео с суперразрешением в реальном мире и позволяет добиться высококачественного улучшения видеокадров путем объединения априорных знаний о моделях диффузии текста и видео (T2V). Отличительная особенность модели STAR заключается в ее способности одновременно поддерживать точность пространственных деталей и временную согласованность, что зачастую трудно совместить с традиционными подходами на основе GAN. Проект предусматривает две версии реализации: легкую и тяжелую модели обработки для снижения качества на базе I2VGen-XL и тяжелую модель обработки для снижения качества на базе CogVideoX-5B, которые способны адаптироваться к потребностям улучшения видео в различных сценариях.

Список функций

- Поддержка восстановления со сверхвысоким разрешением для многих типов обработки ухудшения качества видео (легких и тяжелых)

- Автоматизированная генерация слов для подсказок, поддержка создания описания видео с помощью таких инструментов, как Pllava

- Предоставление онлайновой демонстрационной платформы (HuggingFace Spaces)

- Поддержка обработки входного видеосигнала с разрешением 720x480

- Предоставьте полный код для вывода и предварительно обученные модели

- Интеграция модуля улучшения локальной информации (LIEM) для улучшения качества детальной реконструкции экрана

- Поддержка пакетной обработки видео

- Обеспечивает гибкие возможности взвешивания моделей

Использование помощи

1. конфигурация окружающей среды

Сначала вам нужно настроить среду выполнения следующим образом:

- Клонируйте репозиторий кода:

git clone https://github.com/NJU-PCALab/STAR.git

cd STAR

- Создайте и активируйте среду conda:

conda create -n star python=3.10

conda activate star

pip install -r requirements.txt

sudo apt-get update && apt-get install ffmpeg libsm6 libxext6 -y

2. Выбор и загрузка модели

STAR предлагает две версии модели:

- Модель на основе I2VGen-XL:

- light_deg.pt: для обработки видео с деградацией света

- heavy_deg.pt: для обработки видео с сильной деградацией

- Модель на базе CogVideoX-5B:

- Специально разработано для работы с сильно ухудшенным видео.

- Поддерживается только входное разрешение 720x480

Загрузите соответствующие модельные веса с сайта HuggingFace и поместите их вpretrained_weight/Каталог.

3. Поток обработки видео

- Подготовьте тестовые данные:

- Поместите обрабатываемое видео в

input/video/каталог (на жестком диске компьютера) - Подготовка слов для подсказки (три варианта):

- непроизнесённое слово

- Автоматически генерируется с помощью Pllava

- Ручное написание описаний к видео

- Поместите обрабатываемое видео в

- Настройте параметры обработки:

- модификации

video_super_resolution/scripts/inference_sr.shКонфигурация пути в- video_folder_path: путь к входному видео

- txt_file_path: путь к файлу запроса

- model_path: путь к весу модели

- save_dir: путь сохранения выходных данных

- модификации

- Начните рассуждать:

bash video_super_resolution/scripts/inference_sr.sh

Примечание: Если вы столкнулись с проблемой переполнения памяти (OOM), вы можете добавить новый файл вinference_sr.shсредний минор (в музыке)frame_lengthПараметры.

4. Специальная конфигурация модели CogVideoX-5B

При использовании модели CogVideoX-5B необходимо выполнить дополнительные действия:

- Создайте специальную среду:

conda create -n star_cog python=3.10

conda activate star_cog

cd cogvideox-based/sat

pip install -r requirements.txt

- Загрузите дополнительные зависимости:

- Необходимо загрузить VAE и T5 Encoder

- обновление

cogvideox-based/sat/configs/cogvideox_5b/cogvideox_5b_infer_sr.yamlКонфигурация пути в - Замена файла transformer.py

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...