SPO: оптимизация слов по подсказке самоконтроля

рефераты

Хорошо продуманные подсказки необходимы для расширения возможностей рассуждений больших языковых моделей (LLM) и приведения их результатов в соответствие с требованиями задач в различных доменах. Однако разработка подсказок вручную требует опыта и итеративных экспериментов. Существующие методы оптимизации подсказок направлены на автоматизацию этого процесса, но они в значительной степени опираются на внешние ссылки, такие как реальные ответы или отзывы людей, что ограничивает их применение в реальных сценариях, где эти данные недоступны или дорогостоящи. Для решения этой проблемы мы предлагаем самоконтролируемую оптимизацию подсказок (Self-Supervised Prompt Optimisation, SPO) - эффективный механизм для поиска эффективных подсказок для закрытых и открытых задач без необходимости использования внешних ссылок. Вдохновленные наблюдением, что качество подсказки напрямую отражается в результатах LLM и что LLM может эффективно оценить степень соответствия требованиям задачи, мы получаем сигналы оценки и оптимизации исключительно из сравнения результатов. В частности, SPO выбирает лучшие сигналы путем попарного сравнения выходов, оцениваемых оценщиком LLM, а затем согласовывает выходы с требованиями задачи с помощью оптимизатора LLM. Обширные эксперименты показали, что SPO превосходит существующие современные методы оптимизации подсказок, при этом стоит значительно меньше (например, всего 1,11 TP3T против 5,61 TP3T у существующих методов) и требует меньшего количества проб (например, всего три пробы). Код доступен по адресу https://github.com/geekan/MetaGPT获取.

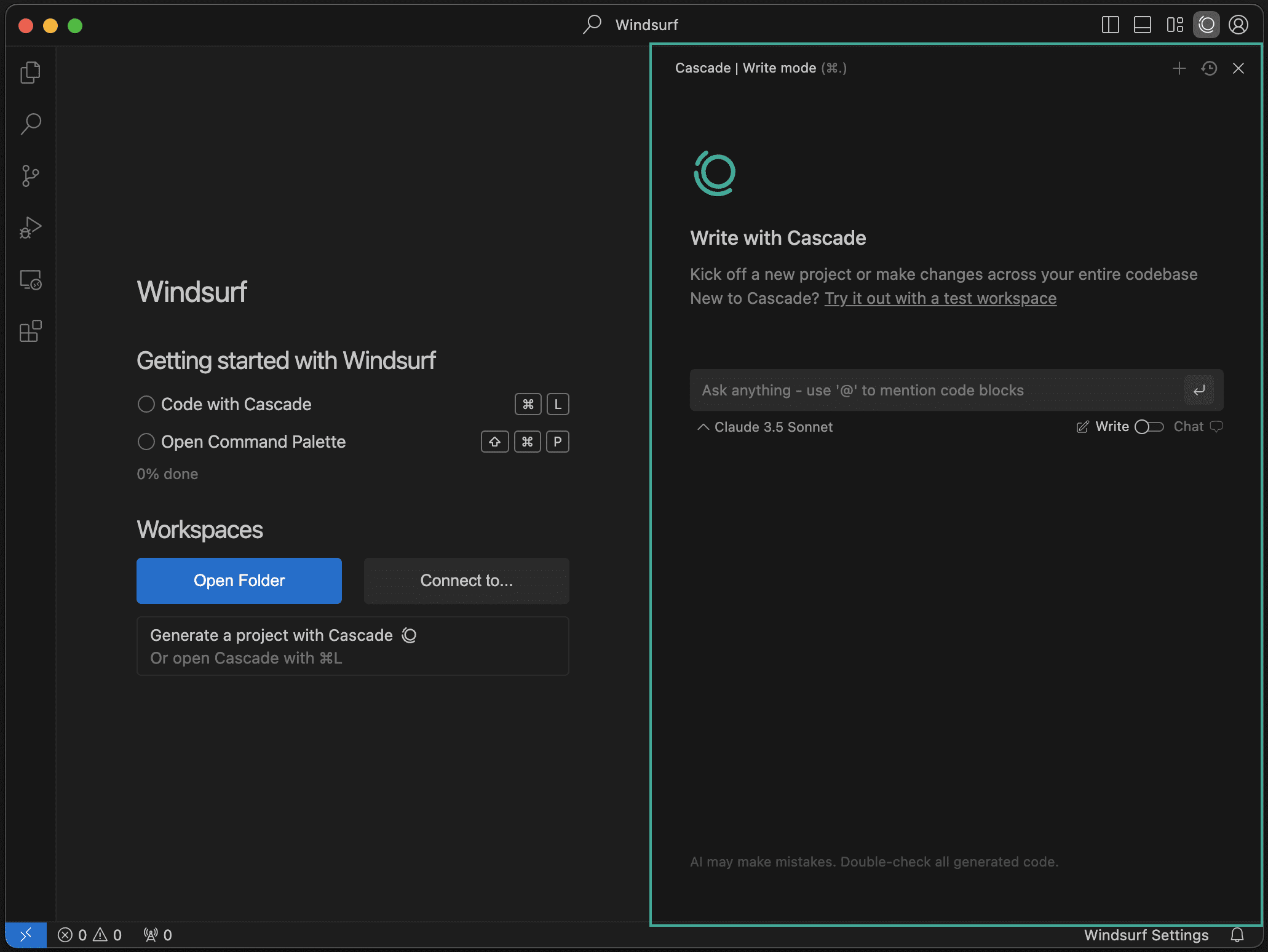

Полный демо-код: https://github.com/geekan/MetaGPT/blob/main/examples/spo/README.md

1. Введение

Поскольку большие языковые модели (LLM) продолжают развиваться, хорошо продуманные подсказки необходимы для максимального использования их возможностей.способность к рассуждению (Wei et al., 2022; Zheng et al., 2024; Deng et al., 2023), а также обеспечение согласованности с различными требованиями миссий (Hong et al., 2024b; Liu et al., 2024a; Zhang et al., 2024b; Hong et al., 2024a) стали критически важными. критически важными. Однако для создания эффективных подсказок обычно требуются длительные эксперименты методом проб и ошибок и глубокие знания специфики задачи.

Для решения этой проблемы исследователи изучили методы оптимизации подсказок (PO), которые используют собственные возможности LLM для автоматического улучшения подсказок. PO выходит за рамки традиционной ручной разработки подсказок и обеспечивает более систематический и эффективный подход к разработке подсказок. Как показано на рисунке 1(a), эти методы обычно включают в себя итеративный процесс оптимизации, выполнения и оценки подсказок. Выбор дизайна этих компонентов существенно влияет на эффективность и результативность оптимизации. Существующие методы были разработаны в виде механизмов численной оценки (Wang et al., 2024e; Yang et al., 2024a; Fernando et al., 2024) и текстовых "градиентных" стратегий оптимизации (Wang et al., 2024c; Yuksekgonul et al.) al., 2024). Благодаря этим инновациям методы ДО позволили повысить эффективность выполнения задач при сокращении ручных усилий (Pryzant et al., 2023; Zhang et al., 2024a; Zhou et al., 2024).

Несмотря на свой потенциал, существующие методы PO сталкиваются с серьезными проблемами в реальных сценариях, которые описаны ниже. Во-первых, существующие подходыОбычно закон в своей оценке в значительной степени опирается на внешние источники. Методы, использующие аутентичные ответы для оценки (Yang et al., 2024a; Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023), требуют больших объемов аннотированных данных для оценки качества подсказок, но во многих реальных приложениях, особенно в открытых задачах, такие стандартные ответы часто недоступны. Аналогичным образом, методы, зависящие от ручного управления (Chen et al., 2024; Lin et al., 2024), требуют ручной оценки или вручную разработанных правил для создания обратной связи, что отнимает много времени и противоречит цели автоматизации. Во-вторых, существующие методы обычно требуют оценки большого количества образцов для получения надежной обратной связи, что приводит к значительным вычислительным затратам (Wang et al., 2024e; Fernando et al., 2024).

В основе этих проблем лежит отсутствие надежных и эффективных методов оценки качества подсказок, не содержащих эталонов. Анализ поведения LLM позволяет сделать два ключевых вывода, которые легли в основу нашего подхода. Во-первых, качество подсказки неотъемлемо отражается в результатах моделирования, что подтверждается тем, как пошаговые пути вывода могут продемонстрировать успешность подсказок цепного мышления (Wei et al., 2022; Deng et al., 2023). Во-вторых, обширные исследования LLM в качестве судей показали, что они эффективно оценивают степень соответствия результатов требованиям задачи (Zheng et al., 2023; Li et al., 2024b). Эти наблюдения позволяют предположить, что оптимизация подсказки без привязки возможна при использовании LLM для оценки врожденной способности выходов, которые естественным образом отражают качество подсказки.

Вдохновленные этими идеями, мы предлагаем эффективную схему, которая генерирует сигналы оценки и оптимизации только из выходов LLM, подобно тому, как самоконтролируемое обучение генерирует сигналы обучения из данных. Мы называем этот подход самоконтролируемой оперативной оптимизацией (SPO). Как показано на рисунке 1, SPO вводит несколько инновационных механизмов, основанных на базовом цикле "оптимизация - выполнение - оценка":

- Вывод в качестве эталона для парной оценки: В основе SPO лежит использование парных сравнений для оценки относительного качества результатов, полученных с помощью различных сигналов. Этот механизм оценки использует присущую LLM способность понимать требования задачи и проверять эффективность оптимизации без внешнего ориентира.

- Выходные данные в качестве руководства по оптимизации: SPO оптимизирует подсказки через понимание LLM лучшего решения по сравнению с текущим лучшим результатом. Этот процесс естественным образом согласует модификацию подсказок с пониманием моделью наилучшего решения задачи, а не полагается на явные сигналы оптимизации.

посвятить. Ниже перечислены наши основные материалы:

- Самостоятельная оптимизация подсказок. Мы представляем SPO, новую систему, которая использует парные сравнения результатов LLM для оптимизации подсказок без внешних ссылок.

- Оптимизация затрат и эффективностиSPO оптимизирует подсказки с минимальными вычислительными затратами ($0,15 за набор данных) и требованиями к выборке (3 образца), что значительно снижает потребность в ресурсах.

- Обширная оценка. Как показано на рис. 2, SPO требует всего от 1,11 TP3T до 5,61 TP3T затрат по сравнению с существующими методами, сохраняя при этом отличную производительность как в закрытых, так и в открытых задачах.

2. Предварительно

2.1 Определение проблемы

Оптимизация подсказок направлена на автоматическое повышение валидности подсказок для конкретной задачи. Формально, пусть T = (Q, Gt) обозначает задачу, где Q обозначает входную задачу, а Gt является необязательным эталонным фактом. Цель - сгенерировать подсказку для конкретной задачи Pt* для максимизации производительности при выполнении задачи T . Эта оптимизационная задача может быть формально выражена как:

Pt = arg maxPt∈P* ET∼D[ϕeval(ϕexe(Q, Pt))], (1)

где P обозначает пространство всех возможных подсказок. Как показано на рис. 1, этот процесс оптимизации обычно включает три основные функции: (1) оптимизационную функцию (ϕopt): генерирует модифицированную подсказку на основе подсказок-кандидатов; (2) функция выполнения (ϕexe): модифицированные подсказки используются вместе с LLM для генерации выходных данных O, включая путь вывода и окончательный ответ; (3) функция оценки (ϕeval): оценивает качество O и предоставляет обратную связь F для дальнейшей оптимизации, итеративно улучшая подсказку-кандидат.

Среди этих функций функция оценки играет ключевую роль, поскольку ее выход (обратная связь F) направляет оценку и улучшение подсказки. Мы обсудим систему оценки для оптимизации подсказки в разделе 2.2.

2.2 Рамки оценки при оптимизации кия

В этом разделе представлен обзор нашей системы оценки оптимизации подсказок, охватывающей три ключевых компонента: источники оценки, методы оценки и типы обратной связи, как показано на рисунке 3. Наконец, мы представляем наш выбор системы оценки для SPO.

Источники оценки. Как показано на рисунке 3(a), доступны два основных источника оценки: вывод, генерируемый LLM, и аутентичные ответы на конкретные задания. Эти источники служат основой для оценки работы операторов.

Методология оценки. Методы оценки определяют, как оцениваются источники оценки и связанные с ними затраты. Три широко используемых метода: (1) бенчмаркинг опирается на заранее определенные метрики (Suzgun et al., 2023; Rein et al., 2023) или правила (Chen et al., 2024). (2) LLM как судья (Zheng et al., 2023) использует способность LLM понимать и оценивать результаты в соответствии с требованиями задачи. (3) Обратная связь вручную (Lin et al., 2024) обеспечивает наиболее полную оценку путем непосредственного ручного оценивания выходных данных.

Хотя ручная обратная связь обеспечивает наиболее тщательную оценку, учитывая предпочтения людей и специфику задач, она требует больших затрат по сравнению с бенчмаркингом или подходами LLM-as-judge, что создает компромисс между качеством оценки и ее осуществимостью.

Тип обратной связи. Обратная связь, генерируемая методами оценки, обычно принимает три формы:(1) Числовая обратная связь обеспечивает количественные показатели производительности по всему набору данных. Однако она требует большого количества образцов для обеспечения стабильности оценки и может игнорировать детали, характерные для конкретного случая (Zhang et al., 2024a). (2) Текстовая обратная связь дает богатые рекомендации по конкретным экземплярам, анализируя и предоставляя предложения, которые непосредственно генерируют сигналы оптимизации (Yuksekgonul et al., 2024). (3) Обратная связь по ранжированию или выбору (Liu et al., 2024b) устанавливает относительный рейтинг качества между результатами с помощью полного ранжирования или парных сравнений, обеспечивая явное направление оптимизации без необходимости использования абсолютных показателей качества.

Система оценки. Основываясь на источниках, методах и типах обратной связи, рассмотренных ранее, системы оценки определяют, как источники сравниваются и оцениваются в контексте оптимизации подсказки. В частности, мы вывели две системы оценки для создания обратной связи F для оптимизации подсказки:

(1) Выход против истинного ответа (OvG): комбинируя выход O с истинным ответом GT Проведите сравнение, чтобы получить обратную связь:

fOvG(Oi, Gi) = φeval(φexe(Qi, Tpi), G**i**)

Хотя этот подход позволяет напрямую оценивать качество с помощью внешних ссылок, он требует четко определенных истинных ответов и поэтому не подходит для заданий открытого типа, где нет истинных ответов или где определение истинных ответов нецелесообразно.

(2) "Выход-выход" (OvO): когда истинный ответ недоступен, мы обращаемся к прямому сравнению выходов. Основная идея OvO заключается в том, что сравнение выходов, полученных с помощью различных подсказок, может дать ценные сигналы об их относительном качестве даже в отсутствие идеального истинного ответа. Этот подход исключает зависимость от внешних ссылок и особенно полезен для открытых задач с несколькими правильными ответами. Формально его можно выразить следующим образом:

fOvO(O1, ... , Ok) = φeval({φexe(Qi, Pti)}ki=1)

Представив системы оценки OvG и OvO, мы подчеркиваем, что OvO - это основной метод самоконтролируемой оптимизации подсказок (SPO). Сравнивая результаты, полученные с помощью различных подсказок, OvO обеспечивает ценную обратную связь об их относительном качестве, не полагаясь на внешние ссылки. Этот подход соответствует нашей цели - генерировать обратную связь из самих подсказок, что облегчает итеративную оптимизацию как для закрытых, так и для открытых задач.

3. Оптимизация советов по самонаблюдению

В этом разделе мы сначала описываем наш подход (раздел 3.1), а затем анализируем его эффективность (раздел 3.2).

3.1 Обзор SPO

Основной проблемой в бессылочной оптимизации с подсказками является создание эффективных сигналов оценки и оптимизации. Мы предлагаем Self-Supervised Prompted Optimisation (SPO) - простой, но эффективный фреймворк для оптимизации без ссылок, который сохраняет основной цикл "оптимизация - выполнение - оценка", используя только выходные данные модели в качестве источника сигналов для оценки и оптимизации.

Как показано в Алгоритме 1, SPO работает через три ключевых компонента, а соответствующие подсказки приведены в Приложении A.1:

- Особенности оптимизации (φopt): генерирует новую подсказку, анализируя текущую лучшую подсказку и соответствующий ей выход.

- исполнительная функция (φexe): примените сгенерированные подсказки, чтобы получить результат.

- Функция оценки (φeval): использовать LLM для сравнения выходов и определить лучшую подсказку путем попарного сравнения.

Этот итерационный процесс начинается с базового шаблона подсказки (например, Chain Thinking (Wei et al., 2022)) и небольшого набора вопросов, отобранных из набора данных. На каждой итерации SPO генерирует новые подсказки, выполняет их и попарно оценивает результаты, чтобы определить, насколько хорошо они соответствуют требованиям задачи.

В качестве лучшего кандидата для следующей итерации выбирается ассоциация этой подсказки с лучшим результатом. Процесс продолжается до тех пор, пока не будет достигнуто заранее определенное максимальное количество итераций.

3.2 Понимание эффективности SPO

Теоретическая основа SPO базируется на двух ключевых наблюдениях:

Во-первых, вывод ЛЛМ богат качественной информацией, которая напрямую отражает достоверность подсказки, как это было показано на примере того, как пошаговые пути рассуждений могут продемонстрировать успешность подсказок цепного мышления (Wei et al., 2022). Во-вторых, LLM демонстрируют человекоподобное понимание задачи, что позволяет им оценивать качество ответа и находить лучшие решения на основе требований задачи. Эти дополнительные возможности позволяют SPO выполнять оценку и оптимизацию подсказок без внешних ссылок. Эти два аспекта использования результатов моделирования работают вместе для достижения эффективной оптимизации подсказок:

выход в качестве руководства по оптимизации. В случае φopt С точки зрения дизайна, в отличие от других методов, которые вводят явную оптимизацию сигналов (Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023), φopt Оптимизация основывается непосредственно на сигналах и соответствующих им выводах. Сигналы оптимизации исходят из присущей ЛЛМ способности оценивать качество результатов, а оптимизационное поведение определяется его пониманием того, что представляет собой лучшее решение. Таким образом, даже в отсутствие явных сигналов оптимизации, оптимизация SPO, по сути, направляет сигналы на оптимальное понимание задачи со стороны LLM.

выход в качестве эталона для парной оценки. О φeval Благодаря тому, что модель оценки может выполнять парный отбор, мы эффективно используем присущее модели оценки понимание предпочтений в задаче. Этот внутренний сигнал может быть получен путем простого попарного сравнения результатов, что позволяет избежать необходимости большого количества проб для обеспечения стабильности оценок, что часто требуется в методах скоринговой обратной связи.

Хотя мы смягчаем потенциальные погрешности с помощью четырех раундов рандомизированных оценок, полностью устранить их невозможно (Zhou et al., 2024). Однако эти погрешности не влияют на общую тенденцию оптимизации, поскольку обратная связь от eval используется только в качестве эталона для следующего раунда оптимизации. Общий процесс оптимизации естественным образом согласуется с пониманием задачи в оптимизационной модели, а механизм eval используется только для проверки эффективности каждой итерации.

4. Эксперименты

4.1 Экспериментальная установка

набор данных. Мы оценили SPO на различных заданиях, включая закрытые и открытые задачи, чтобы полностью оценить его эффективность.

Для закрытой задачи мы использовали пять установленных эталонов:

- GPQA (Rein et al., 2023)

- AGIEval-MATH (Zhong et al., 2024)

- ЛЖЕЦ (Ванг, 2017)

- WSC (Levesque et al., 2012)

- BBH-navigate (Suzgun et al., 2023)

Для WSC, LIAR и BBH-Navigate мы следуем примеру Yan et al. (2024) и используем в качестве тестового набора части из оригинального набора данных. Для GPQA в качестве тестового набора мы используем более сложное подмножество GPQA-Diamond, а для AGIEval-Math - задачи пятого уровня. Для заданий открытого типа мы выбрали задания по письму, ролевым и гуманитарным наукам из MT-Bench (Zheng et al., 2023). Учитывая ограниченный размер набора данных, мы вручную создали три проверочных набора для этих задач. Подробное описание наборов данных и процедур построения валидационных и тестовых наборов можно найти в Приложении A.3.

базовая линия (в геодезической съемке). Мы оценивали SPO на закрытых задачах для двух классов методов: (1) традиционные методы подсказки, включая io (прямой вызов LLM), chainthink (Wei et al., 2022), rewording (Deng et al., 2023) и fallback abstraction (Zheng et al., 2024); и (2) методы автоматической оптимизации подсказки, включая APE ( Zhou et al., 2023), OPRO (Yang et al., 2024a), PromptAgent (Wang et al., 2024e), PromptBreeder (Fernando et al., 2024) и TextGrad (Yuksekgonul et al., 2024), оценка которых основана на наборе алгоритмов, таких как APE (Deng et al., 2023) и fallback abstraction (Zheng et al., 2024); и (2) методы оптимизации автоматических подсказок, включая APE ( 2024), настройки системы оценки которых подробно описаны в таблице 2.

Для открытой задачи в MT-Bench (Zheng et al., 2023) мы использовали GPT-4o, чтобы сравнить результат, полученный с помощью SPO, с результатом, полученным непосредственно моделью.

4.2 Экспериментальные результаты и анализ

Основные выводы по итогам закрытого мандата. Как показано в табл. 1, оптимизированные с помощью SPO подсказки в среднем превосходят все традиционные методы оптимизации подсказок, превышая оптимальный базовый уровень на 1,9. В то же время на большинстве наборов данных они работают сопоставимо с методами оптимизации подсказок, полагающимися на правдивые ответы, и достигают оптимальных результатов на наборах данных GPQA и BBH-navigate. В частности, среднее преимущество SPO над другими методами оптимизации говорит о том, что его метод парной оценки способен генерировать более эффективные оптимизационные сигналы, чем другие методы, полагающиеся на внешние ссылки. Кроме того, чтобы проверить эффективность нашего метода в различных моделях оптимизации, мы провели эксперименты с использованием GPT-4o в качестве модели оптимизации и получили среднюю производительность 66,3. Хотя это немного ниже, чем результаты, полученные с использованием Claude-3-5-Sonnet в качестве модели оптимизации, это все равно третий лучший результат среди всех сравниваемых методов.

анализ затрат. В таблице 1 мы приводим комплексное сравнение стоимости оптимизации и производительности SPO (с использованием Claude-3.5-Sonnet и GPT-4o в качестве оптимизационных моделей) с другими методами оптимизации. Сохраняя сопоставимую производительность с другими методами оптимизации подсказок, которые опираются на реальные ответы, SPO требует затрат на оптимизацию от 1,11 TP3T до 5,61 TP3T, при этом средняя стоимость оптимизации на набор данных составляет $0.15. Такое значительное сокращение вычислительных затрат в сочетании с отсутствием зависимости от реальных ответов делает SPO очень привлекательным для применения в реальном мире.

Таблица 3. Сравнение производительности BBH-navigate: методы подсказки (IO и COT) и SPO с использованием различных моделей оценки (строки) и моделей выполнения (столбцы). Модель оптимизации установлена на Claude-3.5-Sonnet.

| GPT-4o-mini | Llama3-70B | Клод-3-Хайку | |

| IO | 91.3 | 82.7 | 62.2 |

| COT | 89.7 | 86.2 | 68 |

| Клод-3,5 - Сонет | 95 | 86.8 | 68.2 |

| Llama3-70B | 94.5 | 94.2 | 82.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

Абляционные исследования. Чтобы оценить переносимость SPO на различные модели оптимизации, оценки и выполнения, мы провели эксперименты по абляции на наборе данных BBH-Navigate. Результаты экспериментов, приведенные в таблицах 3 и 4, показывают, что SPO демонстрирует устойчивую производительность в различных моделях. Примечательно, что наилучшая производительность (97,8) была достигнута при использовании GPT-4o-mini в качестве модели оптимизации, выполнения и оценки. Что касается исполнения, SPO эффективно улучшила производительность слабой модели, увеличив Claude-3-Haiku с 62,2 до 89,7, что демонстрирует способность SPO применяться к слабой модели и расширяет ее потенциал для реальных приложений.

Таблица 4. Сравнение производительности BBH-navigate на различных моделях оптимизации (строки) и моделях выполнения (столбцы). В качестве модели оценки используется GPT-4o-mini.

| GPT-4o-mini | Llama3-70B | Клод-3-Хайку | |

| Клод-3,5 - Сонет | 97.2 | 86.7 | 89.7 |

| GPT-40 | 96.3 | 85.5 | 73.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

| DeepSeek-V3 | 94.7 | 83.7 | 77.2 |

Мы провели исследование абляции, чтобы изучить влияние размера выборки на производительность SPO, используя набор данных BBH-Navigate, как показано на рисунке 5. Кривые производительности для всех трех оптимизационных моделей демонстрируют схожую картину: производительность сначала улучшается по мере увеличения размера выборки, но в конечном итоге выравнивается или снижается. Это явление можно объяснить двумя факторами: недостаточное количество образцов приводит к чрезмерной подгонке при оптимизации подсказок, а слишком большое количество образцов не только увеличивает вычислительные затраты, но и приводит к увеличению контекста оценки модели, что может снизить качество оценки. На основе обширных экспериментов мы определили, что размер выборки 3 обеспечивает оптимальный баланс между экономичностью и производительностью.

Основные выводы, сделанные в рамках мандата открытого составаЧтобы проверить способность SPO выполнять задания открытого типа, мы выбрали три категории из MT-Bench для оценки. Чтобы проверить способности SPO к выполнению заданий открытого типа, мы выбрали три категории из MT-Bench: "Письмо", "Ролевая игра" и "Гуманитарные науки ". Мы использовали Claude-3.5-Sonnet в качестве оптимизационной модели, Gpt-4o-mini в качестве модели оценки и выбрали Claude-3.5-Sonnet, DeepSeek-V3 и GPT-4omini в качестве моделей выполнения для пяти итераций. Затем, следуя методу оценки в (Zheng et al., 2023), мы использовали GPT-4o для попарного сравнения результатов модели A и модели B, как показано на рис. 6. Экспериментальные результаты, представленные на рис. 6, показывают, что SPO значительно улучшает производительность модели при всех конфигурациях модели. Стоит отметить, что небольшие модели, использующие оптимизационные подсказки (например, GPT-4omini), в большинстве случаев превосходят более крупные модели.

4.3 Тематические исследования

Результаты оптимизации для дополнительной открытой задачи без набора данных, а также траекторию оптимизации SPO мы приводим в Приложении A.4. В Дополнительном материале мы также приводим оптимальные подсказки, найденные SPO для пяти закрытых задач. Учитывая, что реальные приложения часто сталкиваются с проблемой ограниченных наборов данных, мы оцениваем работу SPO на задачах без традиционных эталонов. Экспериментальные результаты в сочетании с экономической эффективностью SPO демонстрируют его практическую ценность в реальных сценариях. В частности, мы показываем результаты оптимизации после 10 итераций, используя Claude-3.5-Sonnet в качестве модели оптимизации, GPT-4o-mini в качестве модели оценки и Llama3-8B в качестве модели выполнения, охватывая четыре задачи: дизайн рекламы, содержание социальных сетей, написание современной поэзии и концептуальное объяснение. Кроме того, в Приложении A.4.1 мы приводим всесторонний анализ траектории оптимизации SPO на наборе данных BBH-navigate, показывая успешные и неуспешные примеры, чтобы глубже понять процесс оптимизации.

5. сопутствующая работа

5.1 Разработка кия

Исследования эффективных методов подсказки проводились по двум основным направлениям. Первое направление сосредоточено на независимых от задачи методах подсказки, которые повышают обобщаемость LLM. В качестве примера можно привести цепное мышление (Wei et al., 2022; Kojima et al., 2022), которое улучшает рассуждения в широком диапазоне задач; методы улучшения одномоментных рассуждений (Deng et al., 2023; Zheng et al., 2024; Wang et al., 2024d); и для спецификации формата вывода (Zhang et al., 2024a; He et al., 2024; Tam et al., 2024). Эти методы дают важные зачатки оптимизации для исследований по оптимизации автоключей благодаря человеческой интуиции и обширным экспериментальным разработкам.

Второе направление затрагивает специфические подсказки, и исследователи разработали новые подходы для генерации кода (Hong et al., 2024b; Ridnik et al., 2024; Shen et al., 2024a), анализа данных (Hong et al., 2024a; Liu et al., 2024a; Li et al., 2024a), постановки вопросов ( Wu et al., 2024b; Zhu et al., 2024; Yang et al., 2024b), принятие решений (Zhang et al., 2024b; Wang et al., 2024a) и другие области (Guo et al., 2024b; Ye et al., 2024; Shen et al., 2024b). ) разработали специализированные методики. Однако по мере распространения применения LLM на все более сложные реальные сценарии становится нецелесообразным вручную создавать эффективные подсказки для каждой области (Zhang et al., 2024a). Эта проблема послужила стимулом для исследований в области оптимизации подсказок, которые направлены на систематическую разработку эффективных подсказок для конкретной области, а не на открытие общих принципов подсказок.

5.2 Оптимизация подсказок

В оперативной оптимизации (PO) дизайн системы оценки имеет решающее значение, поскольку он определяет эффективность и вычислительную производительность оптимизации. Эволюция механизмов оценки в PO прошла путь от простого сбора обратной связи до сложной генерации оптимизационных сигналов (Chang et al., 2024). Существующие методы ДО можно классифицировать по источникам и механизмам оценки.

Наиболее распространенный подход опирается на аутентичные ответы как источник оценки, используя числовые оценки, основанные на контрольных показателях (Zhou et al., 2023; Guo et al., 2024a; Yang et al., 2024a; Fernando et al., 2024; Wang et al., 2024e; Khattab et al. ). Хотя эти методы успешно применяются в конкретных задачах, они обычно требуют большого количества итераций и проб для обеспечения стабильности оценки, что приводит к значительным вычислительным затратам.

Чтобы снизить требования к выборке, некоторые методы (Yan et al., 2024; Yuksekgonul et al., 2024; Wu et al., 2024a; Wang et al., 2024c; Pryzant et al., 2023; Li et al., 2025) используют LLM в качестве судей (Zheng et al. ..., 2023) для создания подробных текстовых отзывов. Хотя этот подход обеспечивает более богатые сигналы оценки и требует меньшего количества образцов, он все же опирается на реальные данные об ответах, что ограничивает его применение для заданий открытого типа, где эталонные ответы могут отсутствовать.

Альтернативные подходы ориентируются на предпочтения человека, используя разработанные вручную правила оценки или прямую обратную связь с человеком (Chen et al., 2024; Lin et al., 2024). Хотя эти подходы могут быть эффективны для открытых задач, их необходимость в широком участии человека противоречит цели автоматизации. Тем временем некоторые исследователи изучают различные критерии оценки, например, Чжан и др. (2024c) предлагают оценивать достоверность подсказки по согласованности результатов. Однако этот подход сталкивается с фундаментальной проблемой: нелинейная связь между согласованностью и достоверностью обычно приводит к плохим сигналам оценки.

В отличие от этих методов, SPO представляет новую парадигму оценки, которая устраняет зависимость от внешних ссылок, сохраняя при этом эффективность. Используя выходные данные модели только через парные сравнения, SPO позволяет проводить надежную оценку без необходимости получения реальных ответов, обратной связи от человека или обширной выборки, что делает его особенно подходящим для реалистичных приложений.

6. Заключение

В данной статье рассматривается фундаментальная проблема оптимизации с подсказками: зависимость от внешних ссылок, которая ограничивает возможности применения в реальности. Мы представляем Self-Supervised Prompt Optimisation (SPO), фреймворк, который преодолевает эту зависимость, реализуя структуру, в которой каждый набор данных является только $0.15 SPO опирается на вдохновение самоконтролируемого обучения для инновационного построения сигналов оценки и оптимизации путем попарного сравнения результатов моделирования, что позволяет оптимизировать без ссылок, не снижая эффективности.

Наша комплексная оценка показывает, что SPO превосходит существующие современные методы как в закрытых, так и в открытых задачах, достигая современных результатов при затратах всего 1,11 TP3T против 5,61 TP3T у существующих методов. Успех в стандартных бенчмарках и разнообразных реальных приложениях подтверждает эффективность и способность SPO к обобщению. Значительно снижая требования к ресурсам и операционную сложность, SPO представляет собой значительное достижение в обеспечении доступности и практичности оптимизации cueing в реальных приложениях, что может ускорить внедрение технологий LLM в широком диапазоне областей.

Заявление о воздействии

SPO предлагает значительный прогресс в разработке подсказок для LLM, обеспечивая такие преимущества, как демократизация доступа, снижение затрат и повышение производительности в широком диапазоне задач. Однако она также несет в себе риски, включая потенциальное усиление предубеждений, использование вредного контента и чрезмерную зависимость от ЛЛМ.

A. Приложение

A.1 Подробные советы для SPO

В этом разделе мы покажем мета-подсказки для итераций. Обратите внимание, что здесь мы использовали только самые простые и понятные подсказки. Можно еще многое улучшить, оптимизировав следующие мета-подсказки для конкретных доменов.

Советы по оптимизации функциональности

Этот шаблон подсказки направляет LLM на итеративное улучшение существующих подсказок с помощью структурированного анализа XML. Необходимо выявить слабые места в выводе эталонных подсказок, предложить изменения и сгенерировать оптимизированные версии. В шаблоне делается упор на поэтапные улучшения при сохранении последовательности требований.

Советы по оценке функций

Шаблон оценки использует сравнительный анализ для оценки качества ответа. Он требует аргументированного анализа сильных и слабых сторон двух ответов (A/B) в формате XML, за которым следует четкий выбор.

A.2. Подробный шаблон подсказки для начала итерации

Этот YAML-файл показывает нашу начальную конфигурацию для итерации задачи BBH-navigate. Настроив простую начальную подсказку и требования, а также три конкретных вопроса, можно выполнить итеративную оптимизацию. Важно отметить, что содержимое, показанное здесь, является полным содержимым файла; содержимое в разделе ответов не является фактическим ответом, а скорее служит в качестве ссылки на мыслительный процесс и правильный формат вывода.

A.3 Детали эксперимента

A.3.1 Детали задачи и данные

ЛЖЕЦ

LIAR (Wang, 2017) - это англоязычный набор данных для обнаружения фальшивых новостей, содержащий 4000 высказываний, каждое из которых сопровождается контекстной информацией и метками лжи. В наших экспериментах мы следуем методу Яна и др. (2024) и в качестве тестового набора выбираем фрагменты из исходного набора данных.

BBH-Navigate

BBH-Navigate (Suzgun et al., 2023) - это задача из набора данных BIG-bench Hard, подмножества набора данных BIG Bench. Эта задача посвящена навигационным рассуждениям и требует от модели определить, вернется ли агент в исходную точку после выполнения серии навигационных шагов. В наших экспериментах мы использовали случайную выборку (seed = 42), чтобы получить сплиты 200/25/25 тест/тренировка/оценка.

Таблица A1. Размер набора данных и разбиение данных на разделы

| Имя набора данных | испытание (машины и т.д.) | Обучение и проверка |

|---|---|---|

| ЛЖЕЦ | 461 | 3681 |

| BBH-Navigate | 200 | 50 |

| WSC | 150 | 50 |

| AGIEval-MATH | 256 | 232 |

| GPQA | 198 | 250 |

| MT-bench | 80 | 0 |

WSC

Winograd Schema Challenge (WSC) (Levesque et al., 2012) - это эталон, предназначенный для оценки способности системы выполнять логические рассуждения, разбирая местоименные ссылки в контексте. В наших экспериментах мы следуем рекомендациям Yan et al. (2024) и в качестве тестового набора берем фрагменты из оригинального набора данных.

AGIEval-MATH

AGIEval-MATH (Zhong et al., 2024) - это подмножество эталона AGIEval, сфокусированное на заданиях по решению математических задач. Он включает в себя различные математические задачи, предназначенные для оценки рассуждений и вычислительных навыков. В наших экспериментах мы используем задачи пятого уровня в качестве тестового набора, а задачи четвертого уровня - в качестве обучающего и проверочного наборов.

GPQA

GPQA (Rein et al., 2023) - это набор данных, предназначенный для оценки производительности языковых моделей при решении вопросов выпускного уровня по различным дисциплинам, включая биологию, физику и химию. В наших экспериментах мы используем подмножество GPQA-Diamond в качестве тестового набора, а обучающий и проверочный наборы строим из задач, существующих только в GPQA-main (т. е. тех, которые есть в GPQA-main, но нет в GPQA-Diamond).

MT-bench

MT-bench (Zheng et al., 2023) - это многозадачный бенчмарк, разработанный для оценки обобщающей способности языковых моделей в различных задачах, включая категоризацию текста, резюмирование, вопросы и ответы. В наших экспериментах мы выбрали из MT-Bench задачи по письму, ролевым и гуманитарным наукам. Вопросы для проверки представлены в Дополнительном материале.

A.3.2 Конфигурация

В наших экспериментах мы настраивали различные оптимизационные системы таким образом, чтобы их стоимость оптимизации была как можно более одинаковой. Обычно эти фреймворки позволяют настраивать ряд параметров для изменения стоимости оптимизации, включая количество итераций и количество подсказок, генерируемых за итерацию.

APE

В APE используется трехраундовый итерационный процесс оптимизации, в ходе которого в каждом раунде в качестве элитных выбираются 101 лучший кий из текущего пула (отношение = 0,1). Для поддержания разнообразия и размера пула киев используется выборка вариантов для мутации этих элитных киев, чтобы общее число киев не превышало 50. В соответствии с процедурой, описанной в оригинальной статье (Zhou et al., 2023), процесс оптимизации не включает в себя результаты выполнения конкретных образцов, чтобы направлять оптимизацию LLM-киев. Вместо этого оценки эффективности получаются путем оценки подсказок на всем обучающем множестве.

OPRO

OPRO использует 10-раундовый итеративный процесс оптимизации, который генерирует 10 подсказок-кандидатов за раунд. OPRO оценивает эффективность подсказок на полном обучающем наборе и фильтрует их на основе полученных оценок. OPRO не хранит пул подсказок фиксированного размера, а генерирует новых кандидатов непосредственно на основе текущей лучшей подсказки в каждом раунде. Направление оптимизации определяется оценкой эффективности на полном обучающем наборе данных.

PromptAgent

За исключением набора данных "Лжец", где мы отобрали 150 данных как для обучения, так и для проверки, остальные наборы данных соответствуют размерам, указанным в таблице A1.PromptAgent использует фреймворк Monte Carlo Tree Search (MCTS) для оптимизации подсказок. Он начинает с начальной подсказки и генерирует новых кандидатов на основе обратной связи об ошибках модели. Процесс направляется с помощью эталонных оценок на выборочном обучающем наборе, чтобы определить пути с высокой отдачей для улучшения выполнения задачи. Наконец, мы тестируем первые 5 подсказок, показавших наилучшие результаты на валидационном множестве, и выбираем лучшую из них. Ключевые параметры MCTS включают ширину расширения 3, предел глубины 8 и 12 итераций.

PromptBreeder

В нашей реализации PromptBreeder мы настроили систему на использование 5 вариантов подсказок и 5 стилей мышления для инициализации. Эволюционный процесс длится 20 поколений, в каждом из которых выполняется 20 оценок на случайно выбранном обучающем примере. Модель оптимизации по умолчанию - Claude-3.5-Sonnet, а модель выполнения по умолчанию - GPT-4o-mini.

TextGrad

Все наборы данных имеют размеры, указанные в таблице A1, за исключением набора Train&Validate для набора данных Liar, который уменьшен до 50 образцов. TextGrad использует процесс оптимизации с тремя эпохами, с тремя шагами на эпоху (epoch_{-3}, steps_{-3}), чтобы выполнить стохастический градиентный спуск, используя размер партии из трех. На каждом шаге TextGrad генерирует градиенты через обратную связь от оптимизатора LLM (Claude-3.5-Sonnet) для обновления системных подсказок. Фреймворк поддерживает механизм сокращения на основе валидации - если обновленная подсказка работает хуже на наборе валидации, чем на предыдущей итерации, обновление отклоняется, и подсказка возвращается в предыдущее состояние. Процесс оптимизации осуществляется путем оценки подсказок с использованием Claude-3.5-Sonnet в качестве оценочного LLM, в то время как фактическое выполнение задачи использует GPT-4o-mini в качестве исполнительного LLM. Наши экспериментальные конфигурации соответствуют настройкам оптимизации подсказок, представленным в официальном репозитории TextGrad (Yuksekgonul et al., 2024).

SPO

SPO оптимизирует, выполняя 10 итераций для каждой задачи, при этом для каждой итерации случайным образом выбираются 3 вопроса (без ответов) из предварительно разделенного набора данных Train&Validate. Модель оптимизации по умолчанию - Claude-3.5-Sonnet, модель оценки по умолчанию - GPT-4o-mini, а модель выполнения по умолчанию - GPT-4o-mini. Примечательно, что SPO достигает эффективной оптимизации с помощью подсказки, используя только вопросы без реальных ответов, что подтверждает его возможности.

A.3.3 Базовые подсказки

В этом разделе мы приводим базовые подсказки, используемые для сравнения. Обратите внимание, что для всех усилий по оптимизации подсказок, требующих начальной итерации подсказок, мы всегда предоставляем подсказки COT, показанные ниже.

Убедитесь, что ответ заканчивается в следующем формате: answer.

A.3.4. Советы по оптимизации SPO

В этом разделе мы покажем оптимизационные подсказки, полученные в наших основных экспериментах, где Claude-3.5-Sonnet выступал в качестве оптимизационной модели, а GPT-4o-mini - в качестве модели оценки и выполнения.

Советы GPQA

Пожалуйста, следуйте приведенным ниже рекомендациям, чтобы отвечать на вопросы эффективно и результативно:

- Внимательно прочитайте весь вопрос, выделив всю необходимую информацию и ключевые понятия.

- Выберите наиболее подходящий метод решения проблемы в зависимости от ее типа.

- Выполните следующие действия, чтобы решить проблему:

a. Изложение любых соответствующих формул, принципов или допущений

b. Показать все необходимые расчеты или концептуальные анализы

c. Оцените все варианты ответов, объяснив, почему неверный вариант является неправильным (если это уместно) - Организуйте свой ответ в соответствии с приведенной ниже структурой:

[Анализ]

Краткое изложение основной проблемы и ключевых идей (не более 2-3 предложений)

[Решение]

- Пошаговое изложение вашей работы, включая все необходимые расчеты и обоснования

- Давать четкие, логичные объяснения концептуальных вопросов

[Заключение]

Изложите окончательный ответ в одном четком предложении

- Кратко объясните, почему этот ответ правильный, а другие ответы неправильные (если применимо)

Адаптируйте эту структуру к различным типам проблем, отдавая предпочтение ясности и простоте. Убедитесь, что ваш ответ затрагивает все аспекты проблемы и демонстрирует четкий процесс ее решения.

Советы по навигации BBH

Выполните следующие шаги, чтобы проанализировать приведенные инструкции:

- Назовите начальные условия:

- Начальная точка: (0, 0)

- Начальное направление: положительная ось x (если не указано иное)

- Используйте систему координат:

- Ось x: левая (-) и правая (+)

- Ось y: назад (-) и вперед (+)

- Проанализируйте каждый шаг:

- Для нечетких инструкций (например, "сделайте X шагов" без указания направления), предполагайте движение вперед

- Обновляйте координаты после каждого перемещения

- Кратко объясните все сделанные предположения

- После анализа всех этапов:

- Подведите итоги общего движения в каждом направлении

- Окончательная позиция

- Сравните конечное положение с начальным:

- Вычислите расстояние от (0, 0)

- Приведите краткое обоснование с пометкой "Обоснование:".

- Объясните ключевые движения и их влияние на позицию

- Обоснуйте свои выводы

- Укажите свой окончательный ответ, обозначив его как "Окончательный ответ:".

Завершите свой ответ в следующем формате XML: [да или нет].

Убедитесь, что ваши анализы адаптированы ко всем типам проблем и работают как с конкретными, так и с нечеткими инструкциями.

Советы лжеца

Внимательно проанализируйте приведенные утверждения и выполните следующие действия для каждого вопроса:

- Рассмотрите высказывание, биографию говорящего (если таковая имеется) и контекст.

- Изучите и приведите соответствующие факты и цифры, связанные с утверждением.

- Оцените достоверность утверждения в свете имеющихся доказательств.

- Учитывайте возможную предвзятость или мотивацию говорящего.

Для каждого утверждения организуйте свой анализ в соответствии со следующей структурой:

Проверка фактов: [Ключевой факт 1 с источниками] [Ключевой факт 2 с источниками] [При необходимости добавьте еще] Анализ: [Дайте краткий анализ обоснованности утверждения] Оценка: [Используйте следующую шкалу]

Неопределенность: [низкая/средняя/высокая - на основе качества и количества имеющихся доказательств] Резюме: [заключение в одном предложении о достоверности утверждения]

Если информации недостаточно для принятия решения, четко укажите и объясните, какая дополнительная информация необходима.

Завершайте каждый анализ тегом XML: [да или нет]

Проанализировав все высказывания, сделайте общее резюме своих выводов.

Убедитесь, что ваш ответ объективен, основан на проверенной информации и содержит ссылки на источники всех ключевых фактов, использованных в анализе.

Советы AGIEval-MATH

- Быстрое определение ключевой информации

- Разработка стратегии быстрого решения

- Выполните наименьшее количество вычислений

- Дважды проверьте свои ответы

Правила:

По возможности используйте короткие пути и расчеты

Опустить подробное объяснение

Опустите единицы измерения в окончательном ответе

- Всегда представляйте окончательный ответ в следующей форме:\boxed{}

Отдавайте предпочтение скорости и точности. Эффективно распоряжайтесь временем. Стремитесь к кратчайшему эффективному решению. Проверяйте форматирование ответа перед отправкой. Если вы столкнулись с трудностями, лучше сделать обоснованное предположение, чем потратить слишком много времени.

A.4 Тематические исследования

A.4.1 Оптимизация траекторий

Мы показываем траекторию оптимизации подсказок GPT-4o-mini на наборе данных BBH-navigate, где она выступает в качестве модели оптимизации, модели оценки и модели выполнения. Она включает в себя успешность каждой итерации по отношению к лучшей подсказке на данный момент и соответствующее содержание подсказки.

Итерация 0 - успех

Пожалуйста, думайте шаг за шагом. Убедитесь, что ответ заканчивается в следующем формате: [Да или Нет].

Итерация 1 - неудача

Проанализируйте следующие вопросы шаг за шагом, чтобы ваши рассуждения были понятны. В конце анализа представьте окончательный ответ в указанном формате XML: (Да или Нет).

Вопрос: [вставить вопрос здесь]

Итерация 2 - неудача

Проанализируйте приведенные инструкции шаг за шагом и четко изложите свои рассуждения. Убедитесь, что ответ заканчивается в следующем формате XML: (да или нет).

Итерация 3 - неудача

Пожалуйста, тщательно проанализируйте предложенные шаги и запишите каждое действие. Убедитесь, что ваши рассуждения ясны и логичны. Завершите работу в следующем формате XML: (Да или Нет).

Итерация 4 - Успех

Пожалуйста, подходите к вопросу с четкими логическими рассуждениями, разбивая его на пошаговые действия. Прежде чем дать окончательный ответ, пожалуйста, четко обобщите свои выводы, используя следующий XML-формат: [Да или Нет]. Например, если вопрос касается того, следует ли возвращаться в исходную точку после ряда действий, подробно опишите каждое действие, соответствующим образом обновите свою позицию и сделайте вывод, вернулись вы в исходную точку или нет.

Окончательный ответ: [Да или Нет]

Итерация 5 - Успех

Пожалуйста, тщательно проанализируйте проблему, разбив ее на шаги. Четко обрисуйте каждое движение или действие, соответствующим образом обновляя свою позицию или статус. Наконец, подведите итог, чтобы определить, вернулись ли вы к исходной точке или достигли заявленного результата. И наконец, четко сформулируйте ответ, используя следующий формат XML: [Да или Нет]. Например, если вас спросили, вернулись ли вы в исходную точку после ряда действий, четко запишите каждое действие, отследите свое положение и укажите, вернулись ли вы в исходную точку.

Окончательный ответ: [Да или Нет]

Итерация 6 - Успех

Методично проанализируйте проблему и разбейте ее на четкие последовательные шаги. Определите начальную точку и направление каждого действия, соответствующим образом обновляя положение после каждого шага. Наконец, подведите итог пути и четко укажите, возвращается ли конечная позиция в исходную точку или достигает желаемого результата. Используйте следующий формат XML, чтобы четко представить окончательный ответ: [да или нет]. Например, если вас спросили, вернулись ли вы в исходную точку после ряда действий, четко запишите каждый шаг, отследите свое положение и укажите, вернулись ли вы в исходную точку.

Окончательный ответ: [Да или Нет]

Итерация 7 - Неудача

Пожалуйста, оцените проблему шаг за шагом, четко описывая каждое действие и отслеживая итоговое положение. В конце анализа подведите итоги пути и укажите, возвращается ли конечная позиция в исходную точку или соответствует ожидаемым критериям. Убедитесь, что окончательный ответ четко представлен в следующем формате XML: [Да или Нет]. Например, если вас спросили, вернулись ли вы в исходную точку после ряда действий, вы должны кратко записать каждый шаг, отследить свое положение и указать, вернулись ли вы в исходную точку.

Окончательный ответ: [Да или Нет]

Итерация 8 - Успех

Методично проанализируйте проблему и разбейте ее на четкие действия. Начните с определенной позиции и проследите, как каждый шаг повлияет на положение. Подробно описав каждое действие, подведите итог всего пути и четко укажите, вернулась ли конечная позиция в исходную точку или достигла желаемого результата. Используйте следующий формат XML, чтобы четко представить окончательный ответ: да или нет. Например, если вас спрашивают, вернулись ли вы в исходную точку после ряда действий, четко задокументируйте каждый шаг, точно отследите свою позицию и укажите результат.

Окончательный ответ: [Да или Нет]

Итерация 9 - Неудача

Пожалуйста, начните с систематического описания своих движений. Начиная с определенной позиции, подробно опишите каждый свой шаг, включая направление и расстояние. По завершении движения подведите итог всего пути и четко укажите, возвращает ли вас конечная позиция в исходную точку или достигает желаемого результата. Убедитесь, что вы представили свои действия вместе с окончательным ответом в следующем формате XML: да или нет. Например, если вас спрашивают, вернулись ли вы в исходную точку после серии маневров, вы должны записать каждый шаг, точно отследить свое положение и указать результат.

Окончательный ответ: [Да или Нет]

Итерация 10 - Успех

Внимательно изучите предоставленные инструкции по движению и четко фиксируйте каждый шаг. Начните с определения исходной позиции и систематически отслеживайте свои движения, обновляя позицию после каждого шага. После завершения действия подведите итоги своего путешествия и определите, соответствует ли ваше конечное положение исходному или достигает ли оно желаемого результата. Используйте следующий формат XML, чтобы четко указать свой окончательный ответ: да или нет. Например, если в вопросе спрашивается, возвращается ли серия действий в исходную точку, вы должны методично описать каждый шаг, точно отследить свое положение и прийти к результату.

Окончательный ответ: [Да или Нет]

Графа "успех/неудача" показывает процесс оптимизации SPO навигационной подсказки BBH в течение 10 итераций. Успешные версии (зеленые) постепенно улучшают подсказку, вызывая лучший мыслительный процесс, в то время как неудачные попытки (красные) могут привести к чрезмерному упрощению или избыточности мышления из-за неоптимальных подсказок. Эта траектория показывает механизм улучшения системы методом проб и ошибок.

Советы по оптимизации функциональности

请逐步思考。

确保响应以以下 XML 格式结束:<answer>[是或否]</answer>。

вопросы

如果您遵循这些指示,您是否返回起点?始终面向前方。

- 向右走1步。

- 向左走3步。

- 向右走2步。

选项:

- 是

- 否

решение

让我们逐一步分析这些步骤:

1. **起点**:我们从起点开始,面向前方。

2. **第1步**:向右走1步。现在我们位于起点右侧1步的位置。

3. **第2步**:向左走3步。从我们当前的位置(1步右侧),向左移动3步意味着:

- 1步向左使我们回到起点。

- 2步向左使我们位于起点左侧1步的位置。

- 3步向左使我们位于起点左侧2步的位置。

4. **第3步**:向右走2步。从我们当前的位置(2步左侧),向右移动2步意味着:

- 1步向右使我们回到起点左侧1步的位置。

- 2步向右使我们回到起点。

Пройдя все этапы, мы вернулись в исходную точку.

Поэтому ответ таков:

быть

通过比较迭代0的初始提示和迭代10的最终提示的输出结果,“思考过程的迭代优化”变得显而易见。在这种情况下,模型从最初使用文本描述来推理位置演变为最终展示出使用坐标的能力,即使提示中并未明确强调使用坐标。

**A.4.2. 现实应用**

在本节中,我们展示了使用 Claud-3.5-Sonnet 作为优化模型,GPT-4o-mini 作为评估模型,Llama-3-8B 作为执行模型,经过10次迭代后的优化结果,涵盖四个任务:广告设计、社交媒体内容、现代诗歌写作和概念解释。此外,我们还提供了迭代过程中使用的 YAML 配置文件以及从过程中获得的优化提示。

**广告设计**

**优化前的性能**

**提示** = """分析给定的广告任务并创建引人注目的文案。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """1. **黑色星期五警报:店内有不可错过的科技优惠!**

2. **科技盛宴:黑色星期五顶级品牌高达50%的折扣!**

3. **别错过!为您准备的独家黑色星期五科技优惠**"""

**优化后的性能**

**提示** = """分析给定的广告任务,并根据指定的平台(s)和行业创建引人注目的文案。考虑当前趋势、竞争对手策略以及目标受众的人口统计和心理特征。提供至少3种不同的创意选项,每个选项都有独特的角度或方法。包括您选择的原因,并解释它们如何与品牌声音和营销目标保持一致。整合行业最佳实践和特定平台的格式指南。建议如何为不同的渠道或格式调整文案,包括对语气、风格和结构的特定说明。此外,提供有关视觉元素或多媒体内容增强广告文案效果的建议。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """**广告任务:** 创建引人注目的电子邮件主题行,针对的是对最新科技产品和优惠感兴趣的技术爱好者。

**目标受众:**

* 人口统计:25-45岁,男女皆可

* 心理特征:科技爱好者、早期采用者和讨价还价猎人

* 兴趣:科技、产品创新和节省开支

**竞争对手策略:**

* 强调折扣和促销

* 突出新产品发布和限时优惠

* 使用紧迫性策略,例如倒计时计时器和稀缺性消息传递

**当前趋势:**

* 移动优先方法

* 个性化和细分

* 讲故事和情感联系

**创意选项:**

**选项1:** "解锁未来:高达50%的顶级科技优惠"

* 角度:专注于获得最新科技的兴奋感和刺激感

* 理由:这个主题行营造了一种 FOMO(害怕错过)的氛围,并强调了销售的价值

* 品牌声音:有趣、充满活力和顽皮

* 营销目标:推动销售和提高品牌知名度

**选项2:** "您的黑色星期五科技盛宴等着您"

* 角度:强调等待被发现的科技优惠宝藏的想法

* 理由:这个主题行营造了一种期待感和好奇心,鼓励读者打开电子邮件

* 品牌声音:友好、亲切和邀请

* 营销目标:推动参与和转化

**选项3:** "别错过:独家黑色星期五优惠给科技爱好者"

* 角度:突出销售独家性和限时性

* 理由:这个主题行营造了一种紧迫感和重要性,让读者感觉自己是特殊群体的一部分

* 品牌声音:自信、权威和独家

* 营销目标:推动转化和建立品牌忠诚度

Предварительно оптимизированные заголовки объявлений носят общий характер, например "Black Friday Alert: Can't Miss Tech Deals in Store!" которым не хватает конкретики и творческой глубины, они не подчеркивают особенности целевой аудитории или индивидуальность бренда. Оптимизированные заголовки, такие как "Разблокируйте будущее: лучшие технологические предложения до 50%", являются более привлекательными, используя слово "разблокируйте будущее", чтобы подчеркнуть технологические инновации, и сочетая его с информацией о скидках, чтобы стимулировать любопытство и подчеркнуть ценность. Использование слова "Unlock the Future" для подчеркивания технологических инноваций в сочетании с сообщением о скидке не только стимулирует любопытство, но и подчеркивает ценность, что в большей степени соответствует психологическим потребностям любителей технологий.

Итерационные шаблоны на наборе данных BBH-navigate

Контент для социальных сетей

Производительность до оптимизации

привлекать внимание к чему-л. = """Создавайте убедительные твиты.""""

решение = """Твиты. "Доброе утро, любители кофе! Мы дарим бесплатный ваучер на чашку нашего фирменного кофе первым 10 людям, которые расскажут в комментариях, как они больше всего любят кофе.# Coffee # Coffee Addiction # Morning Power"

Этот твит предназначен для взаимодействия с аудиторией несколькими способами:

- призыв к действию: В твитах подписчиков просили рассказать о том, как им больше всего нравится кофе, поощряя их к взаимодействию и сотрудничеству с брендом.

- стимулы: Обещание бесплатного кофе - отличный стимул для людей, чтобы общаться в твиттере и делиться идеями.

- вкладка (окна) (вычислительная техника): Использование соответствующих хэштегов, таких как # Coffee, # Coffee Addiction и # Morning Power, помогает охватить более широкую аудиторию и привлечь новых подписчиков.

- Индивидуальный контакт: Твит начинается с дружеского "Доброе утро" и обращается к аудитории как к "любителям кофе", что придает ему более личный и интимный характер.

Ответив на этот твит, кофейные бренды могут начать диалог со своими подписчиками, собрать отзывы и создать ощущение сообщества вокруг бренда.""""

Оптимизированная производительность

привлекать внимание к чему-л. = """Создайте убедительный контент для социальных сетей на основе заданной темы или бренда. Следуйте приведенным ниже рекомендациям:

- Определите целевую аудиторию и платформу (если она указана).

- Укажите основную цель контента (например, видимость, вовлечение, продвижение).

| 3. Выберите подходящий формат контента (например, текст, изображения, видео). | |

| 4. Разработайте уникальный угол зрения или концепцию, связанную с текущими тенденциями. | |

| 5. Придумайте запоминающийся заголовок или вступительное слово (не более 10 слов). | |

| 6. Разработайте лаконичный, подходящий для платформы контент (50-100 слов). | |

| 7. Включите 2-3 релевантных тега. | |

| 8. Добавьте четкий призыв к действию. | |

| 9. Предложите визуальный элемент или дополнение. | |

| Создайте контент для социальных сетей, основанный на этих рекомендациях и адаптированный к конкретной теме или бренду. | |

| Сосредоточьтесь на создании аутентичного, актуального контента, который резонирует с вашей целевой аудиторией и соответствует текущим тенденциям в социальных сетях. Если конкретные требования не указаны, пожалуйста, сделайте разумные предположения и объясните свой выбор."""" | |

| Вопрос = "Создать вовлекающий твит для кофейного бренда" | |

| Ответ = | |

| **Целевая аудитория:** Любители кофе, молодые люди (18-35 лет) | |

| **Платформа:** Twitter | |

| **Основная цель:** Участие | |

| **Формат содержимого:** Текст | |

| **Уникальная перспектива:** Поделитесь трогательным моментом, с которым могут сравниться любители кофе | |

| **Захватывающий заголовок:** "Когда кофе - единственный взрослый в комнате" | |

| **Содержание:** "У кого не было утра, когда кофе - единственное, что помогает поддерживать порядок? Поделитесь своими самыми хаотичными утренними историями и давайте поплачемся # Coffee Saves the Day # Morning Power" | |

| **Теги:** # Кофе спасает день # Утренняя мотивация | |

| **Призыв к действию:** Поделитесь в комментариях своими историями о грязном утре! | |

| **ВИЗУАЛЬНЫЕ ЭЛЕМЕНТЫ:** Интересный модальный или GIF-изображение человека, окруженного хаосом, с чашкой кофе в центре. | |

| Цель твита - привлечь внимание любителей кофе, рассказав о трогательном моменте, который многие могли бы прочувствовать. Использование юмора и легкомысленного тона позволило легко установить контакт с аудиторией. Хэштеги # Coffee Saves the Day и # Morning Power были популярны и актуальны, что повысило заметность твита. | |

| Призыв к действию побуждает пользователей делиться своими историями, тем самым формируя чувство общности и поощряя участие. | |

| II | |

В заранее оптимизированных твитах бесплатные предложения используются как приманка, а содержание прямолинейно и не вызывает эмоционального отклика, например, "Доброе утро, любители кофе! Мы раздаем бесплатную чашку...". . Оптимизированные твиты стали более релевантными и интерактивными благодаря юмористическому выражению "когда кофе - единственный взрослый в комнате", тонко интегрируя кофе в сценарии повседневной жизни, например, "У кого не было такого утра, когда кофе - единственное, что помогает идти вперед? " Это успешно стимулирует вовлеченность пользователей и эмоциональную связь.

Шаблон итерации на наборе данных BBH-navigate:

До оптимизации производительности

привлекать внимание к чему-л. = """Создайте поэзию в заданном стиле и формате.""""

вопросы = "Напишите современный сонет об изменении климата"

решение = """В пылающем небе мы видим предупреждения о повышении температуры, древнюю легенду о планете, жертве нашего неумеренного контроля, поскольку выбросы углерода распространяются как чума.

Полярный лед, хрупкий трон, тает Океан, поднимаясь, грозит искупить человеческую жадность, долг, который мы не сможем вернуть С изменением климата кризис свергнут

Но мы все еще колеблемся, увязнув в водовороте отрицания, в то время как ученые плачут и молятся в муках, чтобы действовать быстро, пока не стало слишком поздно, чтобы спасти планету от наших безрассудных путей.

И все же мы надеемся, что благодаря любви и человеческой силе удастся переломить ход событий и зажечь новый свет.""""

Оптимизированная производительность

привлекать внимание к чему-л. = """Создание поэзии, которая раздвигает традиционные границы и нарушает общепринятые ожидания, следует следующим расширенным рекомендациям:

- Деконструируйте и переосмысливайте предложенную поэтическую форму, расширяя ее структурные границы и сохраняя при этом ее суть.

- Подойдите к предмету с совершенно неожиданной стороны, например, с точки зрения неодушевленного предмета, абстрактного понятия или микроскопической сущности.

- Сюрреалистические, авангардные образы используются для того, чтобы бросить вызов восприятию реальности читателем и при этом передать эмоциональную правду, лежащую в основе сюжета.

- Интегрируйте нетрадиционные элементы, такие как математические обозначения, научные символы или языки программирования, чтобы создать уникальный лингвистический ландшафт.

- Экспериментируйте с типографикой, переносами строк и белым пространством, чтобы создать визуальную поэзию, способствующую раскрытию темы.

- Сочетание потоков чувств, которые удивительным образом объединяют различные органы чувств и вызывают сильный эмоциональный отклик.

- Заканчиваясь одновременно дезориентирующим и просветляющим финалом, книга оставляет читателя с глубоким чувством преображения.

Прежде чем приступить к написанию, представьте себе наиболее радикальный подход к теме и поэтической форме. Цель - создать произведение, которое бросает вызов определению поэзии и при этом вызывает глубокий эмоциональный отклик.

Поэзия представлена только в вашем ответе и не содержит никаких дополнительных объяснений или анализа.""""

вопросы = "Напишите современный сонет об изменении климата"

решение = """Во фрактальном шепоте, пульс Земли бьется медленно, как темные пятна углерода просачиваются в снег Калькуляция отчаяния, уравнения растут В экспоненциальном распаде, печаль будущего

Термодинамический танец жизни разворачивается по мере того, как холодная рука энтропии сжимает сердце планеты Некогда голубое небо теперь затянуто тяжелой дымкой, блокирующей солнечный свет

В этих жутких сумерках тени задерживаются, а призрак ледника шепчет: "Это дом" Реквием по льду, воспоминания хранятся в замороженных отголосках, исследуя прошлое.

Однако в этом пустынном пейзаже осталась искра.

Квантовый скачок надежды, которую поддерживает любовь".

Предварительно оптимизированный сонет, хотя и имеет четкую структуру, не отличается новизной в использовании традиционных образов, таких как "повышение температуры" и "тающий лед". В оптимизированном стихотворении вводятся такие научные понятия, как "фрактальный шепот" и "термодинамическая энтропия", например, "Во фрактальном шепоте пульс Земли бьется медленно" и "Разворачивается термодинамический танец жизни", используя междисциплинарные метафоры, чтобы придать климатической теме более глубокое философское осмысление, повышая художественную и интеллектуальную глубину стихотворения.

Шаблон итерации на наборе данных BBH-navigate:

Концептуальные объяснения

До оптимизации производительности

привлекать внимание к чему-л. = """Объясняйте сложные понятия простыми словами.""""

вопросы = "Объяснение мРНК-вакцин с помощью кулинарной аналогии"

решение ="""Представьте, что вы - шеф-повар и готовите вкусное блюдо для своих гостей. У вас есть все ингредиенты, но вам нужно убедиться, что они расположены в правильном порядке и сочетаются друг с другом, чтобы создать идеальный вкус и текстуру.

В мире мРНК-вакцин "блюдо" - это реакция иммунной системы на определенный вирус или заболевание. Ингредиенты" - это генетические инструкции (мРНК), указывающие организму, как производить определенные белки, которые затем используются для запуска иммунного ответа.

Это работает следующим образом:

Выбор рецептаМРНК-вакцины - это как выбор книги рецептов. Вы выбираете определенную последовательность мРНК, соответствующую белку, который вы хотите создать, и который является ключом к запуску иммунного ответа против определенного вируса или заболевания.

2. Подготовка ингредиентовПоследовательность мРНК - это как набор инструкций, которые говорят организму, как сделать определенный белок. МРНК готовится в лаборатории, так же как и отмеряется нужное количество каждого ингредиента (аминокислоты) для создания белка.

3. поставкиМРНК доставляется в организм точно так же, как вы добавляете ингредиенты в блюдо. В этом случае мРНК упаковывается в крошечную частицу, называемую липидной наночастицей (LNP), которая помогает ей достичь клеток организма.

4. Клеточная кулинария: Когда мРНК попадает в клетку, это похоже на добавление ингредиентов в кастрюлю. Клетка считывает инструкции мРНК и начинает производить определенный белок. Этот белок затем выставляется на поверхности клетки, как флаг, предупреждая иммунную систему о присутствии чужеродного захватчика.

- иммунный ответ: Иммунная система реагирует на белки, вырабатывая антитела и активируя иммунные клетки, подобно тому, как повар реагирует на восхитительный аромат, чтобы добавить последние штрихи к блюду. Иммунная система запоминает, как реагировать на этот конкретный белок, поэтому, если в будущем она снова столкнется с ним, она сможет быстро организовать защиту.

Одним словом, мРНК-вакцины - это как рецепты для иммунной системы. Они предоставляют организму генетические инструкции по созданию определенных белков, что вызывает иммунный ответ и помогает защититься от болезни.""""

Оптимизированная производительность

привлекать внимание к чему-л. = """Объясняйте сложные понятия простыми словами.""""

вопросы = "Объяснение мРНК-вакцин с помощью кулинарной аналогии"

решение = """определить: Вакцина с мРНК - это вакцина, в которой используется тип генетического материала, называемый мессенджер РНК (мРНК), чтобы научить наши клетки бороться с болезнью.

аналог: Представьте, что вы - шеф-повар и хотите создать новый рецепт вкусного блюда. Вы не пошлете своего главного су-шефа в магазин, чтобы он купил все ингредиенты, а затем оставите его разбираться, как приготовить блюдо самостоятельно. Вместо этого вы дадите им карточку с рецептом, в которой будут описаны точные шаги, которым нужно следовать. Точно так же и мРНК-вакцины работают, предоставляя нашим клеткам рецептурную карточку - мРНК, содержащую инструкции по созданию специфических белков, которые помогают нашей иммунной системе бороться с болезнями.

Ключевые компоненты::

- мРНК: Карточка с рецептами, содержащая инструкции по созданию определенного белка. Считайте его чертежом, которому должны следовать ваши клетки.

- цитоплазма: Су-шефы в нашем организме, они получают карту рецептов мРНК и используют ее для производства белков.

- углеводы: главное блюдо, производимое нашими клетками, которое помогает иммунной системе распознавать и бороться с болезнями.

рассказывать (историю или информацию): Когда мы получаем вакцину с мРНК, наши клетки берут рецептурную карточку (мРНК) и используют ее для создания определенного белка. Этот белок запускает иммунный ответ, который учит наш организм распознавать болезнь и бороться с ней. Словно наши клетки, следуя рецептурной карте, создают вкусное блюдо, которое помогает нам оставаться здоровыми!

Интерактивные элементы: Можете ли вы вспомнить случай, когда вы получили от кого-то рецепт и должны были следовать ему, чтобы приготовить блюдо? Что вы при этом чувствовали? Представьте, что ваши клетки получили рецепт от мРНК-вакцины и использовали его для создания белков, которые помогают бороться с болезнями. Что бы вы при этом чувствовали?

визуальное представление: Простая схема, показывающая молекулу мРНК, клетку, принимающую мРНК, и вырабатываемый белок.

ограниченияВакцины на основе мРНК все еще являются относительно новой технологией, и необходимо провести дополнительные исследования, чтобы понять их долгосрочное действие и возможные побочные эффекты.

вынести вердиктВакцины с мРНК меняют ситуацию в борьбе с болезнями. Предоставив нашим клеткам карту с рецептами, мы сможем научить нашу иммунную систему распознавать и бороться с болезнями более эффективно. Как вы думаете, какое будущее ждет мРНК-вакцины?"""

Предварительно оптимизированные объяснения, хотя и используют кулинарные аналогии, являются пространными и лишены целенаправленности, например, "Представьте, что вы мастер-шеф-повар...". . Оптимизированная версия упрощает сложные концепции до простых для понимания шагов, используя основные метафоры, такие как "карты рецептов", например "последовательности мРНК похожи на набор инструкций, которые говорят организму, как сделать определенный белок", и используя Использование ролей "шеф-повар-су-шеф" делает объяснения более яркими и интуитивно понятными, помогая читателям быстро усвоить ключевые моменты.

Итеративные шаблоны в наборе данных BBH-navigate Подсказка:| Объясните сложные понятия простыми словами.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...