Частное развертывание DeepSeek + Dify: создание безопасной и контролируемой локальной системы ИИ-помощника

в общих чертах

DeepSeek это революционная модель большого языка с открытым исходным кодом, которая привносит революционный опыт в диалоговое взаимодействие ИИ благодаря своей передовой алгоритмической архитектуре и возможностям рефлексивной цепочки. При частном развертывании вы получаете полный контроль над безопасностью данных и безопасностью использования. Вы также можете гибко настраивать схему развертывания и реализовать удобную пользовательскую систему.

Dify Являясь такой же платформой разработки приложений ИИ с открытым исходным кодом, она предлагает полное решение для частного развертывания. Благодаря бесшовной интеграции локально развернутых сервисов DeepSeek в платформу Dify организации могут создавать мощные ИИ-приложения в локальной серверной среде, обеспечивая при этом конфиденциальность данных.

Ниже перечислены преимущества варианта частного развертывания:

- превосходная производительность : Обеспечить опыт диалогового взаимодействия, сопоставимый с бизнес-моделями

- экологическая изоляция : Полностью автономная работа, исключающая риск утечки данных

- Контролируемость данных Полный контроль над активами данных для соблюдения нормативных требований

предварительное размещение

Аппаратное окружение:

- Процессор >= 2 ядра

- Видеопамять/ОЗУ ≥ 16 ГБ (рекомендуется)

Программная среда:

- Docker

- Docker Compose

- Оллама

- Dify Community Edition

Начало развертывания

1. Установка Ollama

Ollama - это кроссплатформенный клиент для управления большими моделями (MacOS, Windows, Linux), предназначенный для беспрепятственного развертывания больших языковых моделей (LLM), таких как DeepSeek, Llama, Mistral и т.д. Ollama обеспечивает развертывание больших моделей одним кликом, а все данные об использовании хранятся локально на машине, обеспечивая полную конфиденциальность данных и безопасность.

Зайдите на сайт Ollama и, следуя подсказкам, загрузите и установите клиент Ollama. После установки запустите ollama -v команда выведет номер версии.

➜~ollama-v

ollamaversionis0.5.5

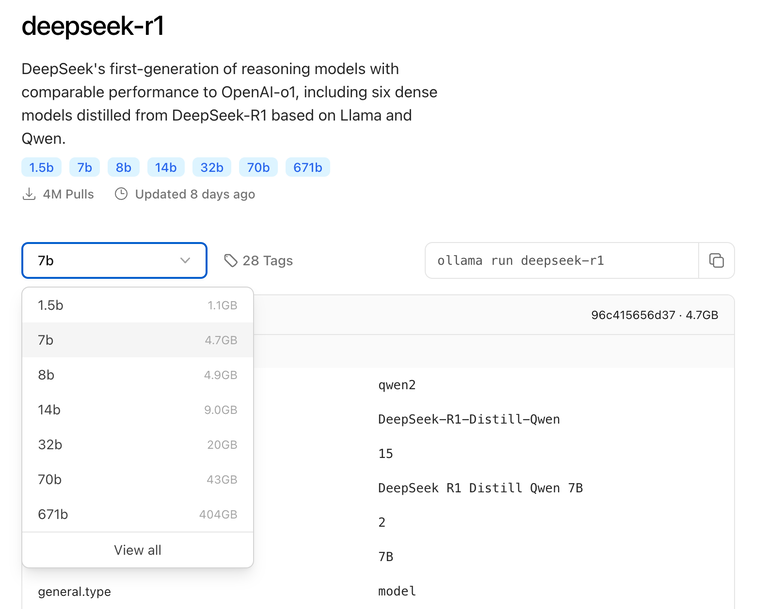

Выберите модель DeepSeek соответствующего размера для развертывания в зависимости от фактической конфигурации среды. Для первоначальной установки рекомендуется модель размера 7B.

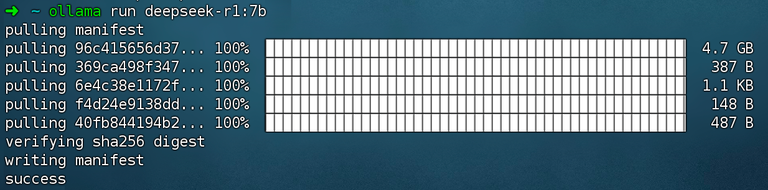

Выполнить команду ollama run deepseek-r1:7b монтаж DeepSeek R1 Модели.

2. Установите Dify Community Edition

Зайдите по адресу проекта Dify на GitHub и выполните следующие команды, чтобы завершить процесс извлечения репозитория кода и установки.

gitclonehttps://github.com/langgenius/dify.git

cddify/docker

cp.env.example.env

dockercomposeup-d# 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

После выполнения команды вы должны увидеть статус и сопоставление портов всех контейнеров. Для получения подробных инструкций обратитесь к Развертывание Docker Compose.

По умолчанию Dify Community Edition использует порт 80. http://your_server_ip Получите доступ к своей приватизированной платформе Dify.

3. Подключение DeepSeek к Dify

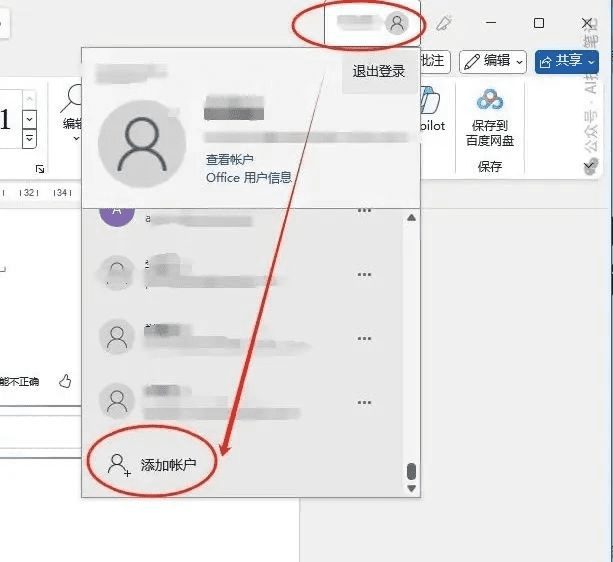

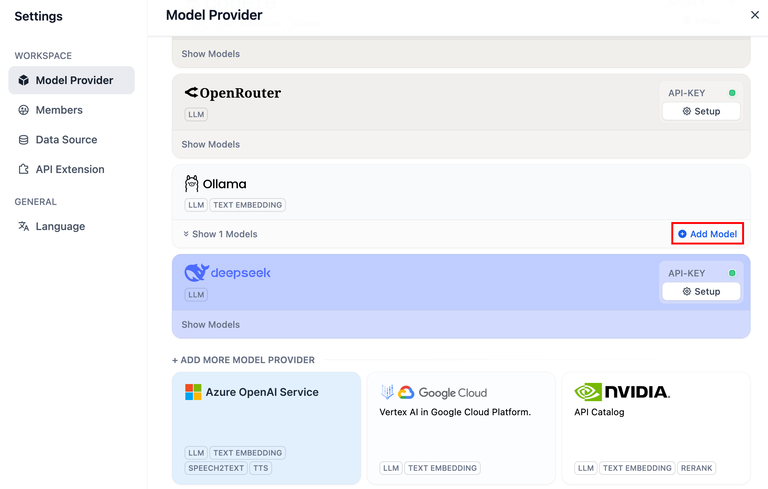

Нажмите на правый верхний угол платформы Dify Аватар → Настройки → Поставщик моделей Выберите Ollama и нажмите Добавить модель.

DeepSeek в рамках поставщика моделей соответствует онлайн-сервису API; локально развернутые модели DeepSeek соответствуют клиенту Ollama. Убедитесь, что модель DeepSeek была успешно развернута клиентом Ollama, как описано в инструкциях по развертыванию выше.

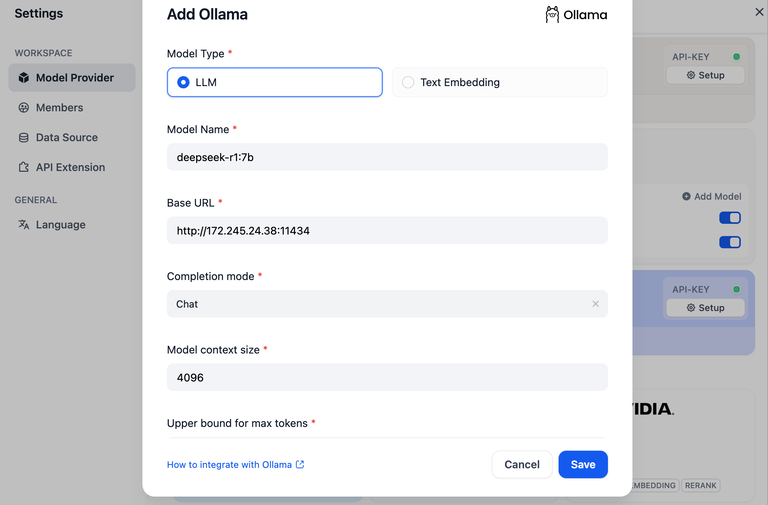

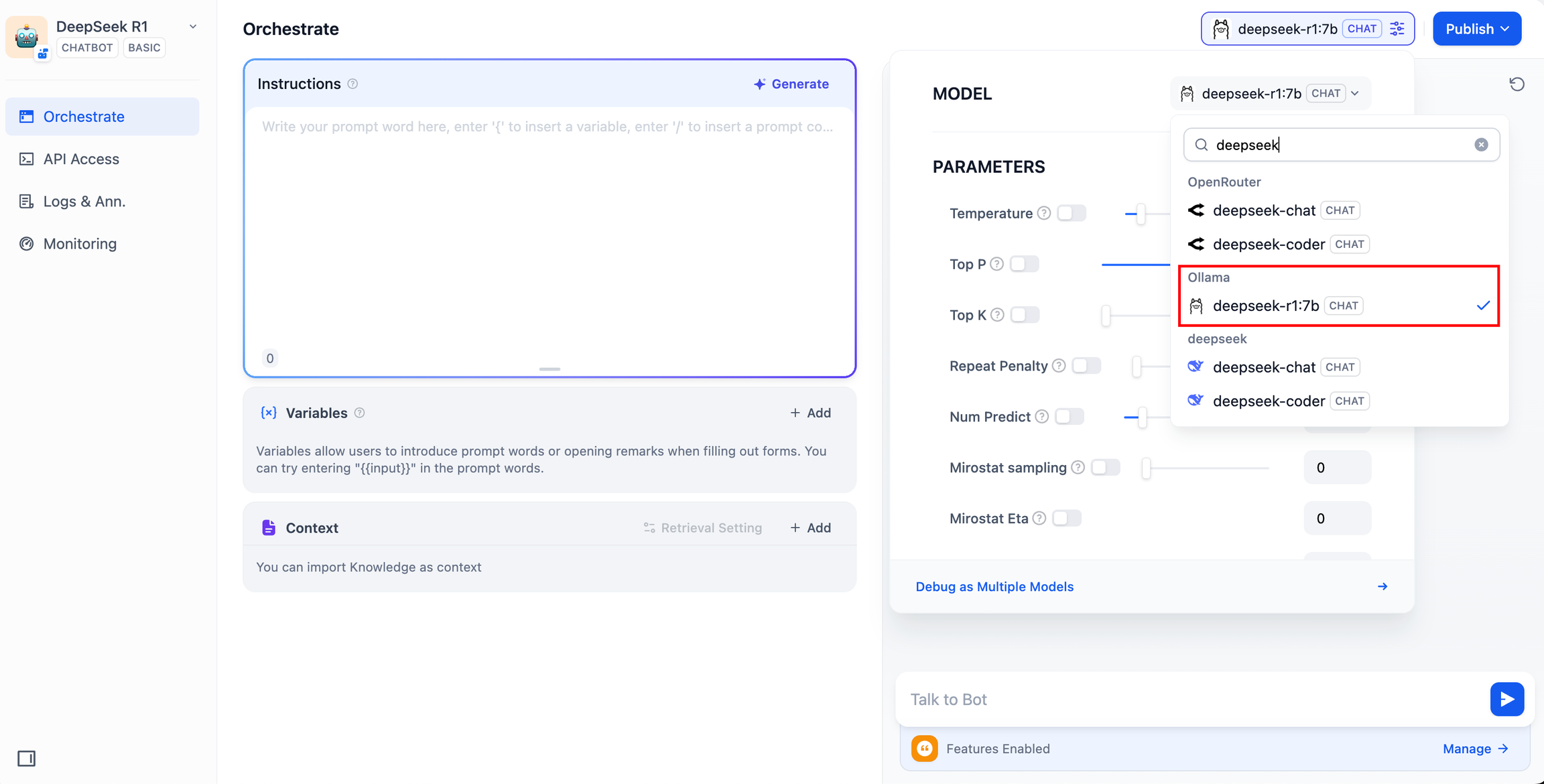

Выберите тип модели LLM.

- Model Name (Имя модели), заполните имя развернутой модели. Моделью, развернутой выше, является deepseek-r1 7b, поэтому заполните

deepseek-r1:7b - Базовый URL, адрес, на котором запущен клиент Ollama, обычно

http://your_server_ip:11434. В случае проблем с подключением, пожалуйста, прочитайте вобщие проблемы. - Остальные параметры остаются в значениях по умолчанию. В зависимости от Описание модели DeepSeekМаксимальная длина генерируемого файла составляет 32 768 токенов.

Создание приложений искусственного интеллекта

Чатбот с искусственным интеллектом DeepSeek (простое приложение)

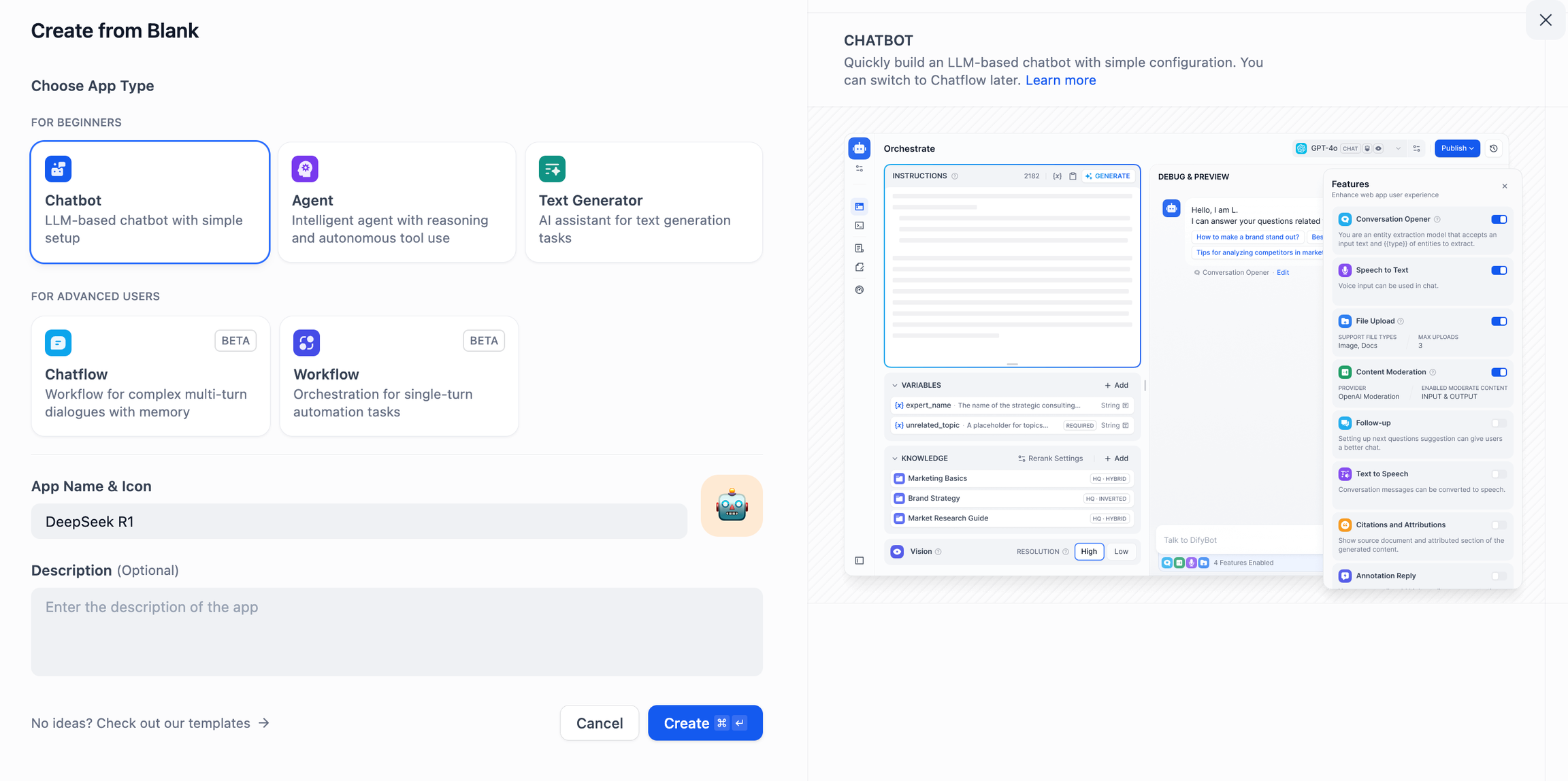

- Нажмите "Создать пустое приложение" в левой части домашней страницы платформы Dify, выберите тип приложения "Чат-помощник" и назовите его просто.

- В правом верхнем углу, в разделе Тип приложения, выберите фреймворк Ollama в списке

deepseek-r1:7bМодели.

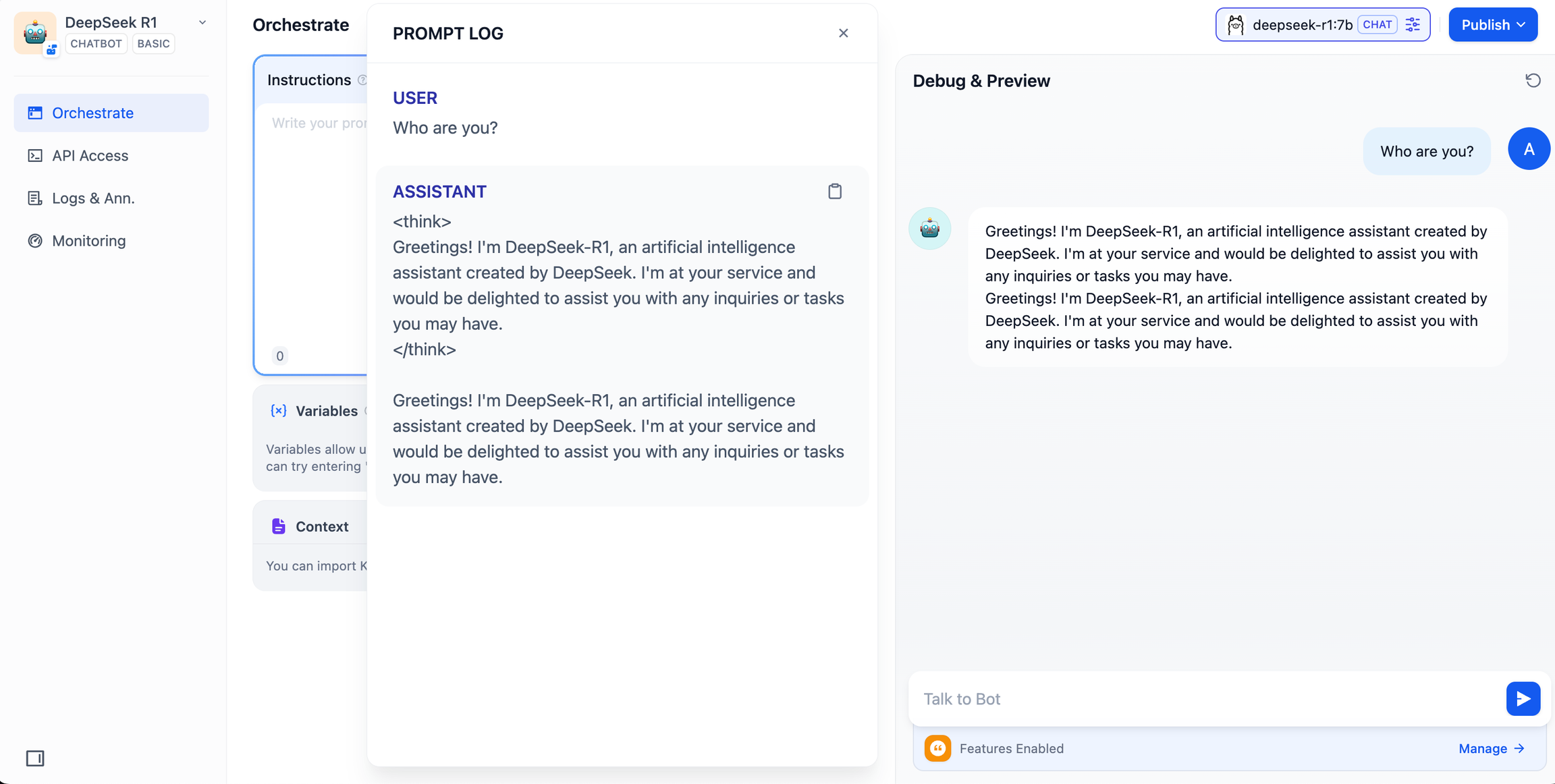

- Убедитесь, что приложение AI работает, введя содержимое в диалоговое окно предварительного просмотра. Появление ответа означает, что сборка приложения ИИ завершена.

- Нажмите кнопку "Опубликовать" в правом верхнем углу приложения, чтобы получить ссылку на приложение AI и поделиться ею с другими пользователями или вставить ее на другой сайт.

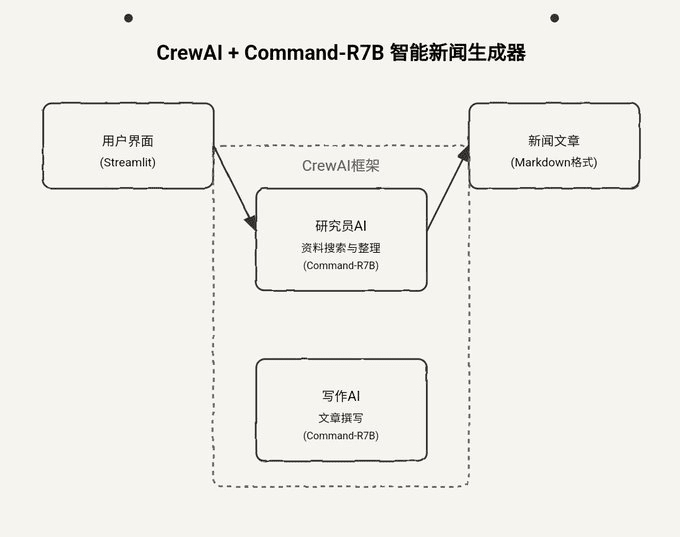

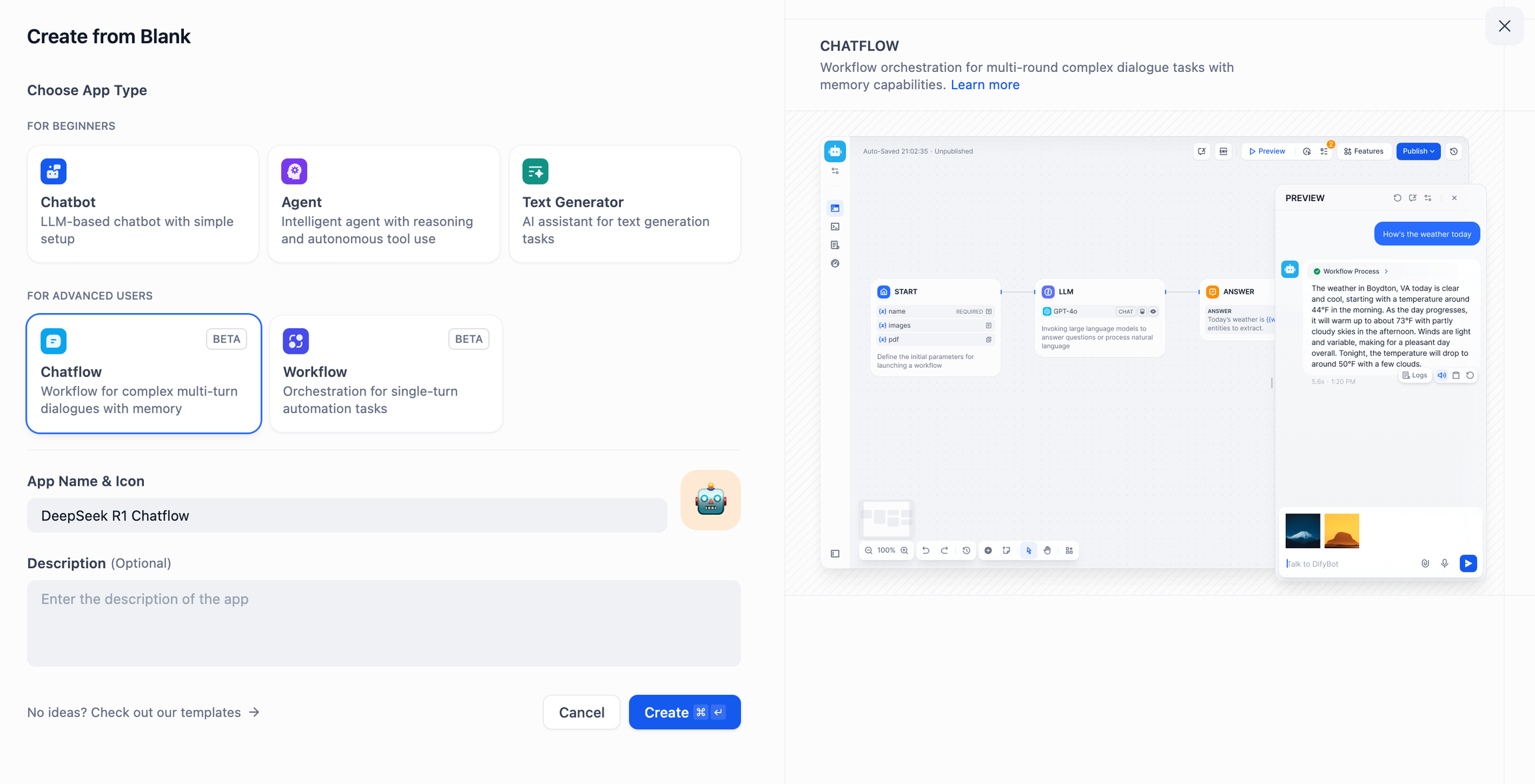

DeepSeek AI Chatflow / Workflow (расширенные приложения)

Chatflow / Рабочий процесс Приложения помогут вам создавать приложения ИИ с более сложной функциональностью, например, с возможностью распознавания документов, изображений, голоса и т. д. Для получения подробных инструкций, пожалуйста, обратитесь кДокументация по рабочим процессам.

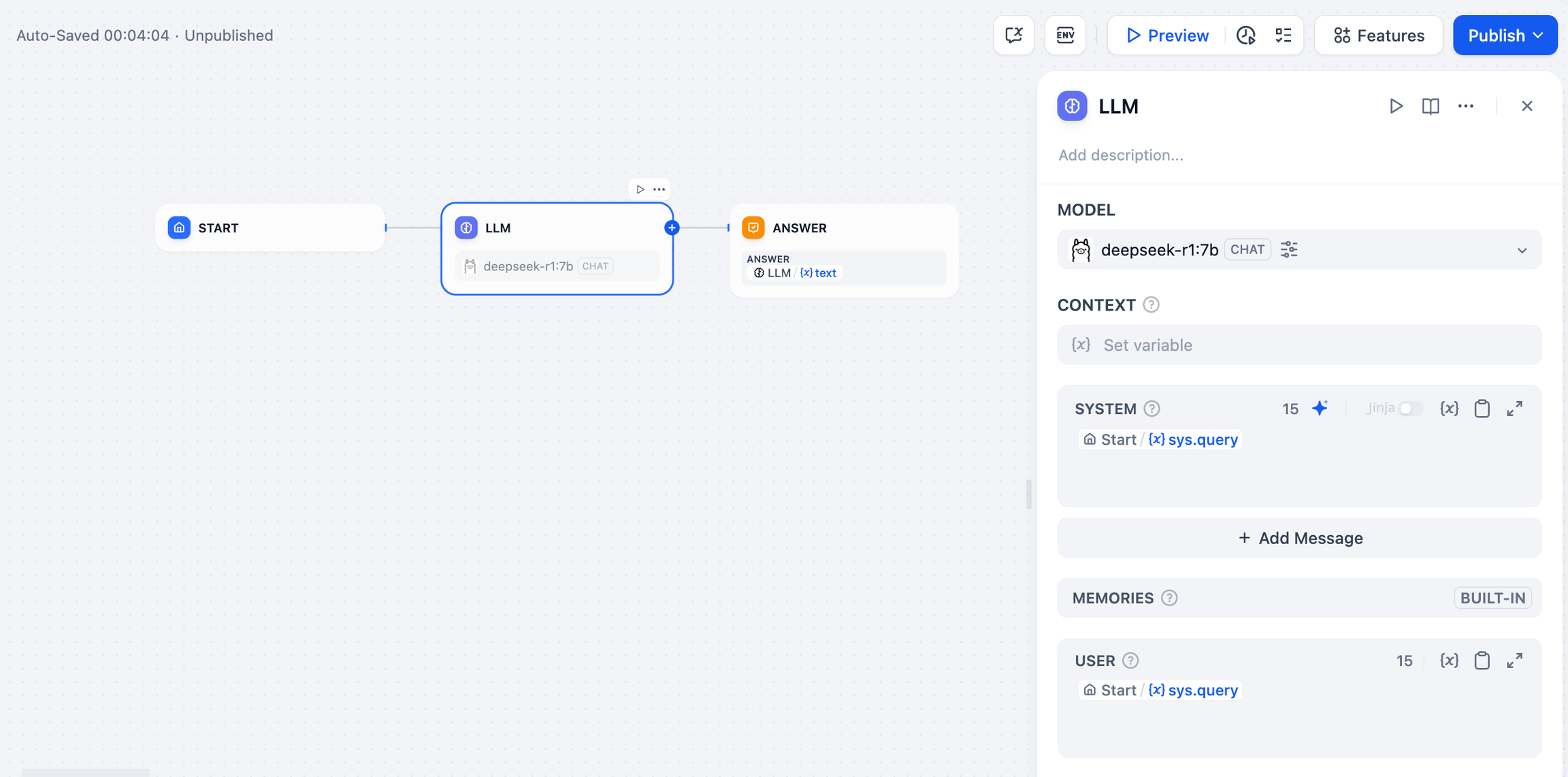

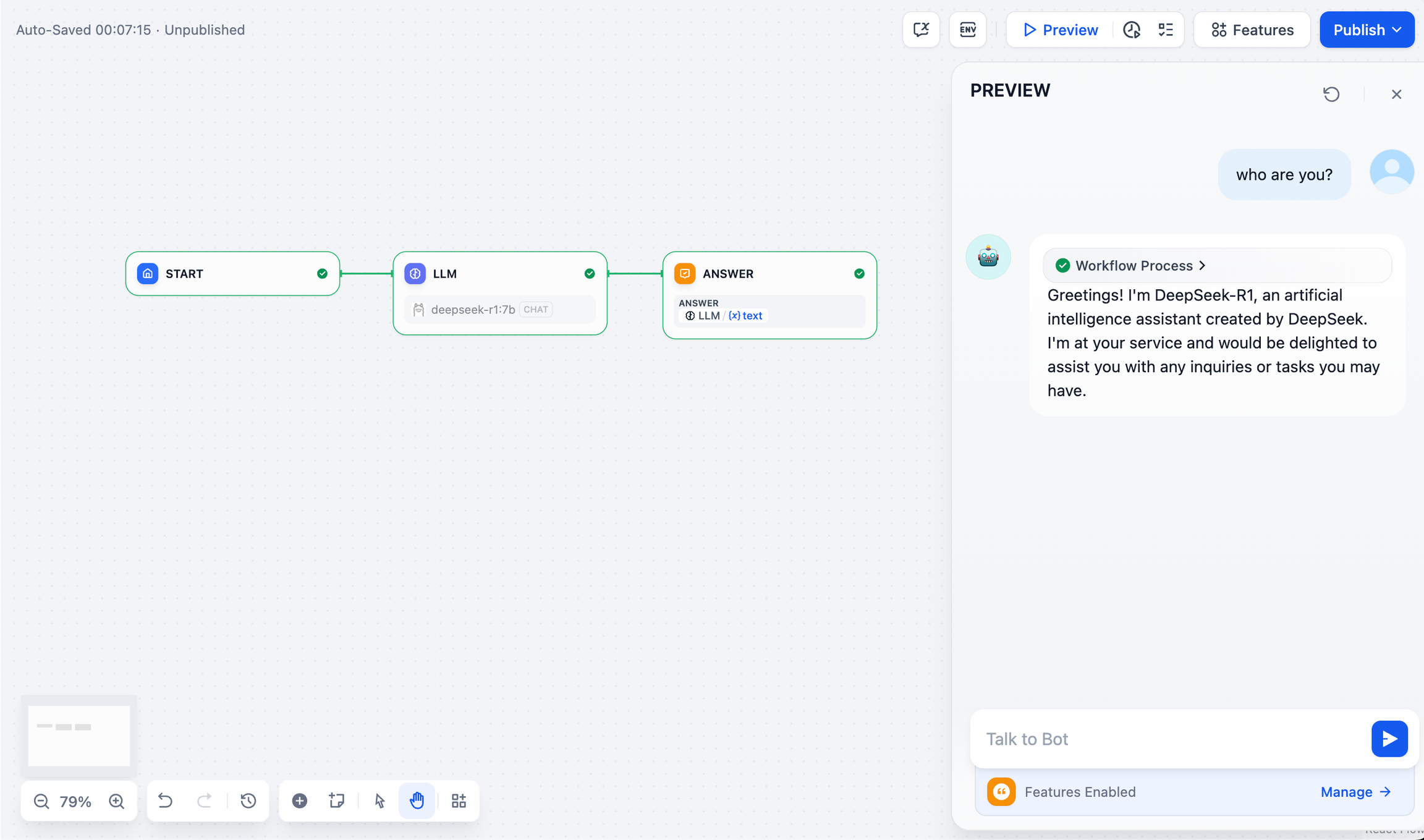

- Нажмите "Создать пустое приложение" в левой части главной страницы платформы Dify, выберите приложение типа "Chatflow" или "Workflow" и назовите его просто.

- Чтобы добавить узел LLM, выберите фреймворк Ollama в разделе

deepseek-r1:7bмодель и добавьте слово системной подсказки внутри{{#sys.query#}}переменная для подключения начального узла.

- Добавьте конечный узел, чтобы завершить конфигурацию. Вы можете ввести содержимое в поле предварительного просмотра для тестирования. Генерирование ответа означает, что сборка приложения ИИ завершена.

общие проблемы

1. Ошибки подключения при развертывании Docker

При развертывании Dify и Ollama с помощью Docker могут возникнуть следующие ошибки:

httpconnectionpool(host=127.0.0.1,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

Причина ошибки : Эта ошибка возникает из-за того, что служба Ollama недоступна в контейнере Docker. localhost обычно указывает на сам контейнер, а не на хост или другой контейнер. Чтобы решить эту проблему, необходимо открыть доступ к службе Ollama в сети.

Метод настройки среды macOS:

Если Ollama запускается как приложение для macOS, вам нужно установить переменные окружения с помощью launchctl:

- Это достигается путем вызова

launchctl setenvУстановка переменных окружения:

launchctlsetenvOLLAMA_HOST"0.0.0.0"

- Перезапустите приложение Ollama.

- Если описанные выше действия не помогли, можно воспользоваться следующим способом:

Проблема в том, что внутри докера вы должны подключиться к host.docker.internalдля доступа к хосту докера, поэтому установите localhost Заменить на host.docker.internal Сервис готов к работе:

http://host.docker.internal:11434

Метод настройки среды Linux:

Если Ollama работает как служба systemd, вам следует использовать systemctl Установка переменных окружения:

- Это достигается путем вызова

systemctl edit ollama.serviceОтредактируйте службу systemd. Откроется редактор. - Для каждой переменной окружения

[Service]Добавьте строку под разделомEnvironment::

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

- Сохраните и выйдите.

- тяжелый груз (на грузовике)

systemdи перезапустить Олламу:

systemctldaemon-reload

systemctlrestartollama

Метод настройки среды Windows:

В Windows Ollama наследует переменные окружения пользователя и системы.

- Во-первых, щелкните на Ollama на панели задач, чтобы выйти из программы.

- Редактирование переменных системного окружения с панели управления

- Отредактируйте или создайте новые переменные для вашей учетной записи пользователя, например

OLLAMA_HOST, иOLLAMA_MODELSи т.д. - Нажмите OK / Применить для сохранения

- Запустите в новом окне терминала

ollama

2. Как изменить адрес и номер порта службы Ollama?

Оллама Переплет по умолчанию 127.0.0.1 порт 11434, доступ к которому можно получить через OLLAMA_HOST Переменные окружения изменяют адрес привязки.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...