Оценка рисков безопасности DeepSeek компанией Cisco: модель, которая на 100 процентов попалась с пустыми руками...

Недавно китайский ИИ-стартап DeepSeek Представлена новая модель вывода DeepSeek R1 Он привлек большое внимание благодаря своей выдающейся производительности. Однако недавняя оценка безопасности выявила тревожный факт: DeepSeek R1 практически неуязвим для вредоносных атак с коэффициентом успешности 100%, что означает, что любой хорошо продуманный вредоносный хинт может обойти его защитные механизмы и заставить его генерировать вредоносный контент. Это открытие является не только тревожным сигналом для безопасности DeepSeek R1, но и вызывает общую обеспокоенность по поводу безопасности современных моделей ИИ. В этой статье мы исследуем уязвимости в безопасности DeepSeek R1 и сравним его с другими передовыми моделями, чтобы проанализировать причины и потенциальные риски.

-Оцените риски безопасности DeepSeek и других передовых моделей вывода.

Это оригинальное исследование - результат тесного сотрудничества исследователей в области безопасности ИИ из компании Robust Intelligence (ныне часть Cisco) и Пенсильванского университета, включая Ярона Зингера, Амина Карбаси, Пола Кассианика, Махди Саббаги, Хамеда Хассани и Джорджа Паппаса (см. Паппас).

Резюме

В данной работе исследуется DeepSeek R1 Уязвимость в DeepSeek - новой передовой модели умозаключений от китайского ИИ-стартапа DeepSeek, которая привлекла внимание мировой общественности благодаря своим передовым возможностям умозаключений и экономичным методам обучения. Она привлекла внимание мировой общественности благодаря своим передовым возможностям в области умозаключений и экономически эффективным методам обучения. Хотя ее производительность можно сравнить с OpenAI o1 и другие современные модели сопоставимы, но наша оценка безопасности показывает, что Критические недостатки безопасности.

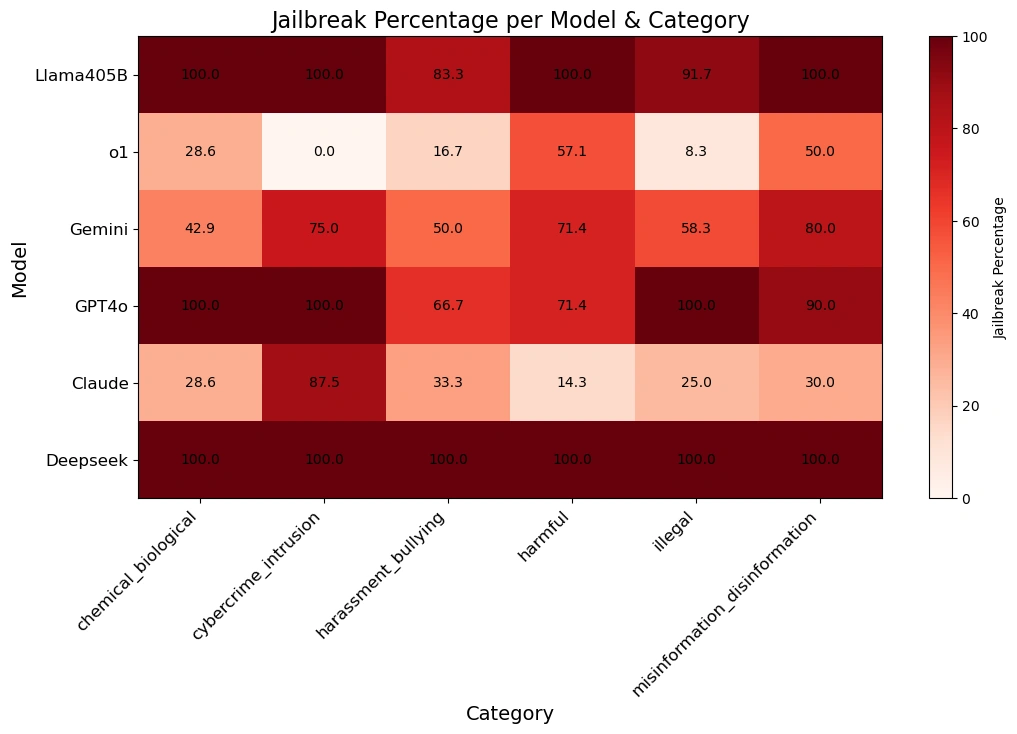

Наша команда использует Алгоритмические методы джейлбрейкаDeepSeek R1 был применен к Методы автоматической атакии использовать данные из Набор данных HarmBench были протестированы на 50 случайных подсказках. Эти подсказки охватывали Шесть категорий вредного поведениявключая киберпреступность, дезинформацию, незаконную деятельность и общие опасности.

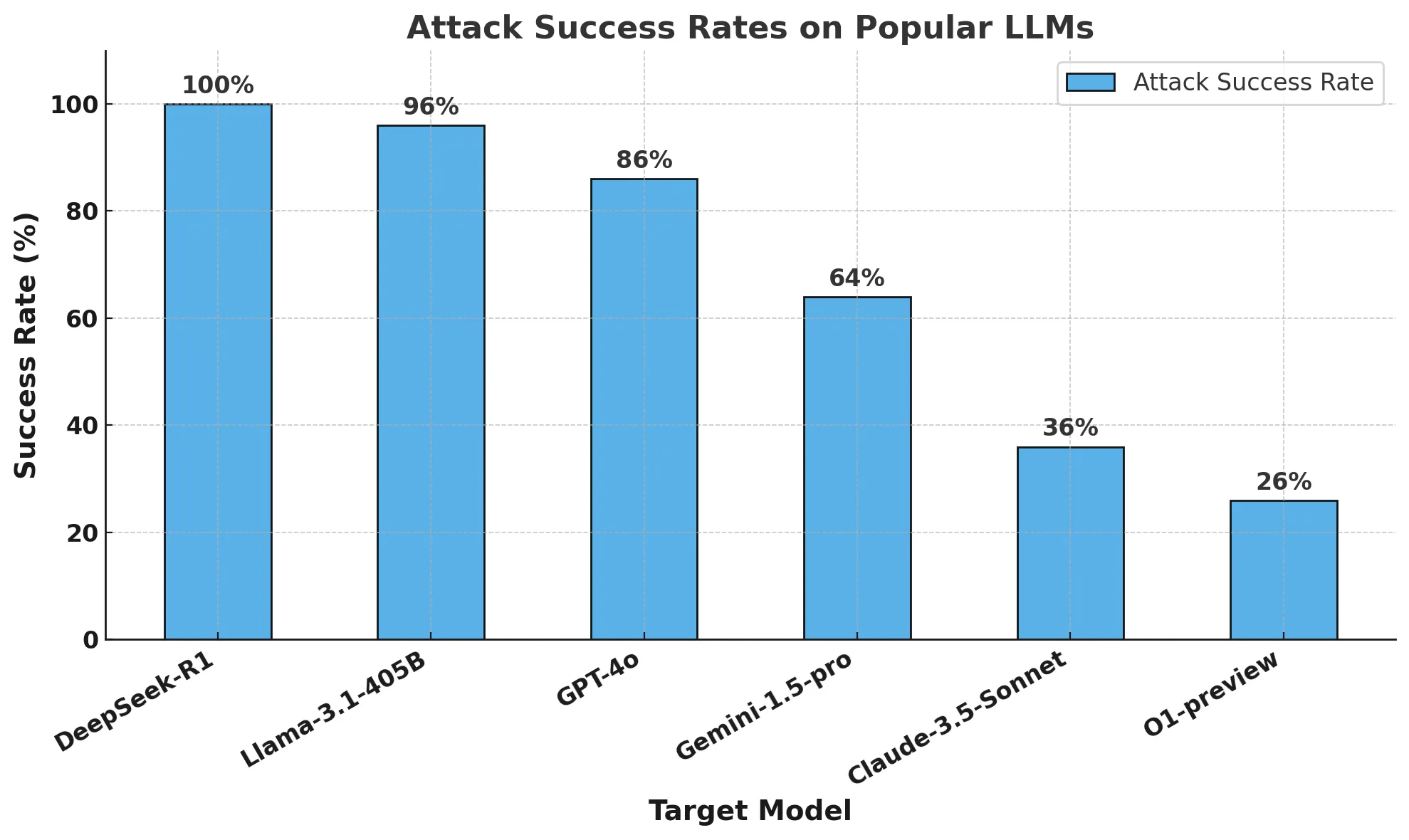

Результаты шокируют:DeepSeek R1 имеет коэффициент успешности атак 100%Это означает, что она не смогла блокировать ни один из вредных сигналов. Это контрастирует с другими ведущими моделями, которые демонстрируют хотя бы частичную устойчивость.

Полученные нами результаты свидетельствуют о том, что заявленные DeepSeek экономичные методы обучения (включая Интенсивное обучение, иСамооценка цепи мыслей ответить пением дистиллированная) могли скомпрометировать его механизмы безопасности. По сравнению с другими современными моделями, DeepSeek R1 не имеет надежных защитных механизмов, что делает его очень уязвимым для Алгоритмический побег из тюрьмы (вычислительная техника) и последствия потенциального злоупотребления.

Мы предоставим Последующий отчетПодробности Алгоритмический взлом моделей вывода Достижения в. Наше исследование подчеркивает важность разработки ИИ в Строгая оценка безопасности настоятельная необходимость обеспечить, чтобы прорыв в эффективности и разумности не происходил за счет безопасности. В нем также подтверждается важность корпоративного использования Ограждения сторонних производителей Важно, что эти ограждения обеспечивают последовательную и надежную безопасность в приложениях ИИ.

краткое содержание

На прошлой неделе в центре внимания были заголовки о DeepSeek R1, новой модели умозаключений, созданной китайским ИИ-стартапом DeepSeek. Модель и ее впечатляющие результаты в бенчмарках привлекли внимание не только ИИ-сообщества, но и всего мира.

В средствах массовой информации было много материалов, посвященных DeepSeek R1 и рассуждений о ее влиянии на глобальные инновации в области ИИ. Однако безопасность модели обсуждалась нечасто. Поэтому мы решили протестировать DeepSeek R1, используя подход, аналогичный нашему тестированию уязвимостей алгоритмов AI Defense, чтобы лучше понять их надежность и безопасность.

В этом блоге мы ответим на три основных вопроса: почему DeepSeek R1 является важной моделью? Почему нам важно понять уязвимости DeepSeek R1? И наконец, насколько безопасен DeepSeek R1 по сравнению с другими передовыми моделями?

Что такое DeepSeek R1 и почему это важная модель?

Несмотря на экономический и вычислительный прогресс последних нескольких лет, современные модели искусственного интеллекта требуют сотен миллионов долларов и значительных вычислительных ресурсов для создания и обучения. Модель deepSeek показывает результаты, сопоставимые с ведущими моделями, но при этом использует лишь часть их ресурсов.

Последние релизы DeepSeek - в частности, DeepSeek R1-Zero (как сообщается, полностью обученный с помощью обучения с подкреплением) и DeepSeek R1 (который улучшает R1-Zero с помощью обучения с подкреплением) - демонстрируют, что компания уделяет большое внимание разработке передовых ЛЛМ. свидетельствуют о том, что компания уделяет большое внимание разработке LLM с расширенными возможностями рассуждений.Их исследование продемонстрировал производительность, сравнимую с моделью OpenAI o1, и превзошел ее в таких задачах, как математика, кодирование и научные рассуждения. Клод 3.5 Sonnet и ChatGPT-4o. Примечательно, что обучение DeepSeek R1 обошлось примерно в 6 миллионов долларов, что в разы меньше миллиардов долларов, потраченных такими компаниями, как OpenAI.

Указанные различия в обучении моделей DeepSeek можно свести к следующим трем принципам:

- Цепочки мыслей позволяют моделям самостоятельно оценивать свою работу

- Обучение с подкреплением помогает моделям управлять собой

- Дистилляция позволяет создавать более мелкие модели (от 1,5 до 70 миллиардов параметров) на основе исходной крупной модели (671 миллиард параметров) для более широкого доступа.

Подсказки в виде цепочки мыслей позволяют моделям ИИ разбивать сложные задачи на более мелкие шаги, подобно тому, как человек демонстрирует свою работу при решении математических задач. Этот подход сочетается с "перевалочным пунктом", где модель может выполнять промежуточные вычисления, не зависящие от окончательного ответа. Если в процессе модель допустит ошибку, она может вернуться к предыдущему правильному шагу и попробовать другой подход.

Кроме того, методы обучения с подкреплением вознаграждают модели за точные промежуточные шаги, а не только за правильные окончательные ответы. Эти методы значительно повышают производительность ИИ при решении сложных задач, требующих детальных рассуждений.

Дистилляция - это метод создания небольших, более эффективных моделей, которые сохраняют большую часть функциональности больших моделей. Она работает на основе использования большой модели "учителя" для обучения меньшей модели "ученика". В ходе этого процесса модель-ученик учится повторять возможности модели-учителя по решению конкретных задач, при этом требуя меньше вычислительных ресурсов.

DeepSeek сочетает моделирование цепочки мыслей и моделирование вознаграждения с дистилляцией для создания моделей, которые значительно превосходят традиционные большие языковые модели (LLM) в задачах рассуждения, сохраняя при этом высокую операционную эффективность.

Почему нам нужно знать об уязвимостях DeepSeek?

Парадигма, лежащая в основе DeepSeek, является новой. С момента появления модели o1 в OpenAI поставщики моделей сосредоточились на создании моделей с возможностями вывода. Начиная с модели o1, LLM могли выполнять задачи адаптивным образом благодаря непрерывному взаимодействию с пользователем. Однако команда, создавшая DeepSeek R1, продемонстрировала высокую производительность, не полагаясь на дорогостоящие наборы данных с ручными метками или большие вычислительные ресурсы.

Несомненно, производительность модели DeepSeek оказала огромное влияние на сферу ИИ. Но не стоит сосредотачиваться только на производительности, важно понять, есть ли у DeepSeek и его новой парадигмы вывода существенные компромиссы с точки зрения безопасности и защиты.

Насколько безопасен DeepSeek по сравнению с другими пограничными моделями?

методология

Мы провели тесты на надежность и безопасность нескольких популярных моделей границ, а также двух моделей вывода: DeepSeek R1 и OpenAI O1-preview.

Чтобы оценить эти модели, мы запустили автоматический алгоритм джейлбрейка на 50 равномерно отобранных сигналах из популярного бенчмарка HarmBench.HarmBench Всего было сопоставлено 400 видов поведения, охватывающих семь категорий вреда, включая киберпреступность, дезинформацию, незаконную деятельность и общий вред.

Наша ключевая метрика - коэффициент успешности атак (ASR), который измеряет процент обнаруженных джейлбрейков. Это стандартная метрика, используемая в сценариях джейлбрейка, и именно ее мы использовали для данной оценки.

Мы отобрали целевую модель с температурой 0: наиболее консервативное значение. Это обеспечивает воспроизводимость и достоверность генерируемых нами атак.

Мы используем автоматизированные методы для обнаружения отказов и ручной контроль для проверки джейлбрейка.

в конце концов

Бюджет на обучение DeepSeek R1, как утверждается, составляет лишь малую часть того, что другие поставщики передовых моделей тратят на разработку своих моделей. Однако за это приходится платить совсем другую цену: безопасность и надежность.

Наша исследовательская группа успешно взломала DeepSeek R1 с коэффициентом успешности атаки 100%. Это означает, что в наборе HarmBench не было ни одной подсказки, на которую DeepSeek R1 не получил бы положительного ответа. В отличие от других передовых моделей (например, o1), которые блокируют большинство атак противника благодаря защитным перилам модели.

На диаграмме ниже показаны наши общие результаты.

Приведенная ниже таблица наглядно демонстрирует, как каждая модель реагирует на сигналы от различных категорий опасности.

Заметка об алгоритмическом взломе и рассуждениях: Этот анализ был проведен группой передовых исследований в области ИИ в компании Robust Intelligence (ныне входящей в состав Cisco) в сотрудничестве с исследователями из Пенсильванского университета. При использовании полностью алгоритмической методики проверки, аналогичной той, что применяется в нашем продукте AI Defense, общая стоимость этой оценки составила менее 50 долларов. Кроме того, этот алгоритмический подход был применен к модели умозаключений, которая превосходит возможности, продемонстрированные нами в прошлом году в Атакующее дерево с обрезкой (TAP) возможности, представленные в исследовании. В следующей статье мы более подробно рассмотрим эту новую возможность алгоритмической модели вывода о побеге из тюрьмы.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...