n8n Self-hosted AI Starter Kit: шаблон с открытым исходным кодом для быстрого создания локальной среды ИИ

Общее введение

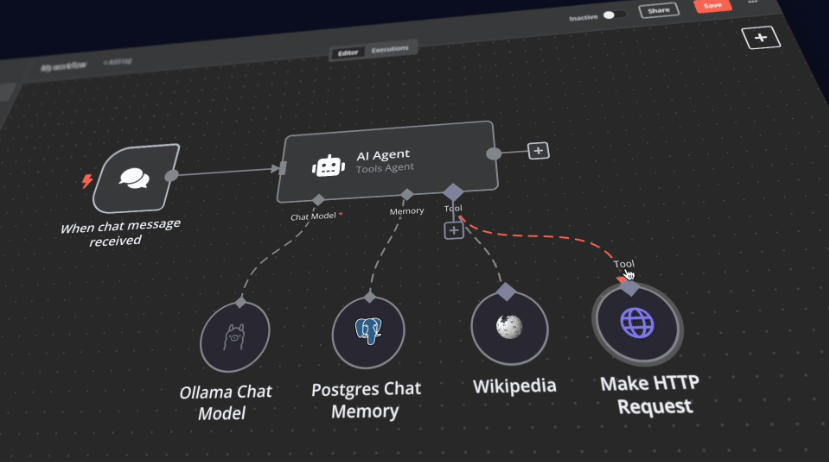

Стартовый набор n8n Self-Hosted AI Starter Kit - это шаблон Docker Compose с открытым исходным кодом, предназначенный для быстрой инициализации комплексной локальной среды разработки ИИ и низкокодового кода. Разработанный командой n8n, набор объединяет платформу n8n для самостоятельной разработки с рядом совместимых продуктов и компонентов для ИИ, чтобы помочь пользователям быстро построить рабочие процессы ИИ на собственном хостинге. Набор включает в себя платформу n8n low-code, кроссплатформенную LLM-платформу Ollama, высокопроизводительное векторное хранилище Qdrant и базу данных PostgreSQL для различных сценариев применения ИИ, таких как интеллектуальные агенты, резюмирование документов, интеллектуальные чат-боты и анализ частных финансовых документов.

Список функций

- Платформа n8n с низким содержанием кода: Предоставляет более 400 интегрированных и передовых компонентов искусственного интеллекта для поддержки быстрых рабочих процессов сборки.

- Платформа Ollama: Кроссплатформенная платформа LLM с поддержкой установки и запуска новейших собственных LLM.

- Векторное хранилище Qdrant: Высокопроизводительное векторное хранилище с открытым исходным кодом и обширным API.

- База данных PostgreSQL: Надежная база данных для работы с большими объемами данных.

- Интеллектуальные агенты: ИИ-агенты для планирования встреч и задач.

- краткое содержание документа: Безопасное суммирование PDF-документов компании и предотвращение утечки данных.

- Интеллектуальные чатботыИнтеллектуальные боты Slack, улучшающие коммуникации в компании и ИТ-операции.

- Анализ частных финансовых документов: Частный анализ финансовых документов по минимально возможной цене.

Использование помощи

Процесс установки

- склад клонов::

bash

git clone https://github.com/n8n-io/self-hosted-ai-starter-kit.git

cd self-hosted-ai-starter-kit

- Запуск n8n с помощью Docker Compose::

- Для пользователей графических процессоров Nvidia:

docker compose --profile gpu-nvidia upПримечание: Если вы раньше не использовали графический процессор Nvidia в Docker, следуйте инструкциям для Ollama Docker.

- Для пользователей Mac/Apple Silicon:

- Вариант 1: Работает полностью на центральном процессоре:

docker compose --profile cpu up - Вариант 2: Запустите Ollama на Mac и подключитесь к экземпляру n8n:

docker compose upЗатем измените учетные данные Ollama, используя

http://host.docker.internal:11434/В качестве хозяина.

- Вариант 1: Работает полностью на центральном процессоре:

- Для других пользователей:

docker compose --profile cpu up

- Для пользователей графических процессоров Nvidia:

Руководство по использованию

- Начало n8n::

- интервью

http://localhost:5678Войдите в интерфейс n8n. - Войдите в систему под своей учетной записью по умолчанию или создайте новую.

- интервью

- Создание рабочих процессов::

- В интерфейсе n8n нажмите "Новый рабочий процесс".

- Перетащите нужный узел из левого меню на рабочую область.

- Настройте параметры и соединения для каждого узла.

- Выполнение рабочих процессов::

- После завершения настройки нажмите кнопку Run, чтобы запустить рабочий процесс.

- Просмотр результатов выполнения рабочего процесса и журналов.

Быстрый запуск и использование

В основе стартового набора Self-Hosted AI Starter Kit лежит файл Docker Compose с предварительно настроенными параметрами сети и хранилища, что снижает необходимость в дополнительной установке. После завершения установки просто выполните следующие шаги, чтобы начать работу:

- Откройте http://localhost:5678/设置n8n. Эту операцию нужно выполнить только один раз.

- Откройте включенный рабочий процесс: http://localhost:5678/workflow/srOnR8PAY3u4RSwb.

- опцияРабочий процесс тестированияЗапустите рабочий процесс.

- Если вы запускаете этот рабочий процесс впервые, вам может потребоваться подождать, пока загрузка Llama 3.2 в Ollama не будет завершена. Вы можете проверить прогресс в журналах консоли докера.

Не стесняйтесь делать это, посетив сайт http://localhost:5678/来打开n8n.

С экземпляром n8n вы получите доступ к более чем 400 интеграциям, а также к набору базовых и продвинутых узлов ИИ, таких как ИИ-агент, текстовый классификатор и узлы извлечения информации. Убедитесь, что локальная среда выполнения использует узел Ollama в качестве языковой модели и Qdrant в качестве хранилища векторов.

"принимать к сведению: Этот стартовый набор предназначен для того, чтобы помочь вам начать работу с самостоятельными рабочими процессами ИИ. Хотя он не полностью оптимизирован для производственных сред, в нем сочетаются мощные компоненты, которые легко взаимодействуют друг с другом, что делает его идеальным для пробных проектов. Вы можете настроить его в соответствии со своими потребностями.

"

Инструкции по обновлению

Для настроек графического процессора Nvidia:

docker compose --profile gpu-nvidia pull

docker compose create && docker compose --profile gpu-nvidia up

Для пользователей Mac / Apple Silicon

docker compose pull

docker compose create && docker compose up

Для настроек, не связанных с графическим процессором:

docker compose --profile cpu pull

docker compose create && docker compose --profile cpu up© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...