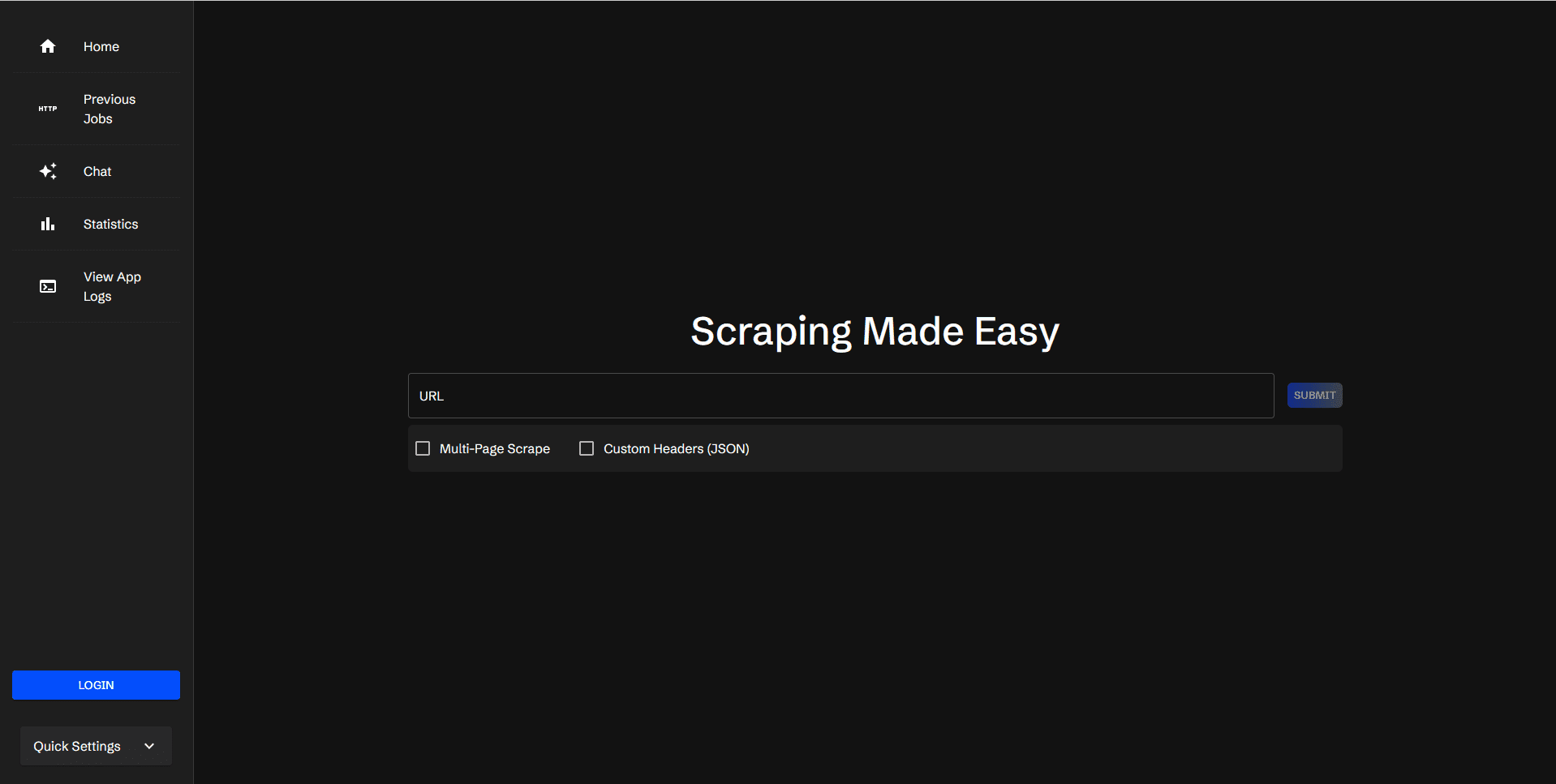

Scraperr: самостоятельный инструмент для сбора веб-данных

Общее введение

Scraperr - это инструмент для самостоятельного поиска данных в Интернете, который позволяет задавать элементы XPath для поиска данных в Интернете. Пользователи отправляют URL и соответствующие элементы, а результаты отображаются в таблице, которую можно загрузить в виде файла Excel. Scraperr поддерживает вход пользователей в систему для управления заданиями по сбору данных, а также обеспечивает просмотр журналов и статистики.

Список функций

- Отправляйте и ставьте в очередь URL-адреса для просмотра в Интернете

- Добавление и управление элементами кроула с помощью XPath

- Просматривать все страницы с одним доменным именем

- Добавьте пользовательские JSON-заголовки для отправки запросов

- Отображение результатов захвата данных

- Загрузите файл CSV с результатами

- Повторное выполнение задачи захвата

- Просмотр состояния задач, поставленных в очередь

- Создание закладок и просмотр заданий в закладках

- Вход/регистрация пользователей для организации задач

- Просмотр журналов приложений

- Просмотр статистики задач

- Интеграция искусственного интеллекта для поддержки включения результатов ползания в контекст диалога

Использование помощи

Процесс установки

- Хранилище клонирования:

git clone https://github.com/jaypyles/scraperr.git - Установка переменных окружения и тегов: В

docker-compose.ymlфайл для установки переменных окружения и меток, например:scraperr: labels: - "traefik.enable=true" - "traefik.http.routers.scraperr.rule=Host(`localhost`)" - "traefik.http.routers.scraperr.entrypoints=web" scraperr_api: environment: - LOG_LEVEL=INFO - MONGODB_URI=mongodb://root:example@webscrape-mongo:27017 - SECRET_KEY=your_secret_key - ALGORITHM=HS256 - ACCESS_TOKEN_EXPIRE_MINUTES=600 - Начните обслуживание:

docker-compose up -d

Процесс использования

- Отправить URL для просмотра::

- После входа в Scraperr перейдите на страницу "Задачи по скрапбукингу".

- Введите URL-адрес, который нужно просмотреть, и соответствующий элемент XPath.

- После отправки задания система автоматически поставит его в очередь и начнет фиксировать.

- Управление элементами кроула::

- На странице задачи ползания можно добавлять, редактировать или удалять элементы XPath.

- Поддерживает поиск всех страниц в одном домене.

- Просмотр результатов ползания::

- После завершения захвата результаты будут отображены в таблице.

- Пользователь может загрузить CSV-файл с результатами или выбрать повторный запуск задания.

- управление задачами::

- Пользователи могут проверять состояние поставленных в очередь задач, делать закладки и просматривать их.

- Предоставляет представление "Статистика задач", в котором отображается статистика запущенных задач.

- Просмотр журнала::

- На странице Журнал приложения пользователи могут просмотреть системный журнал для получения подробной информации о задаче захвата.

- Интеграция искусственного интеллекта::

- Поддержка включения результатов захвата в контекст диалога, в настоящее время поддерживается Оллама и OpenAI.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...