SAIL-VL2 - мультимодальная модель визуального языка с открытым исходным кодом от ByteHop

Что такое SAIL-VL2?

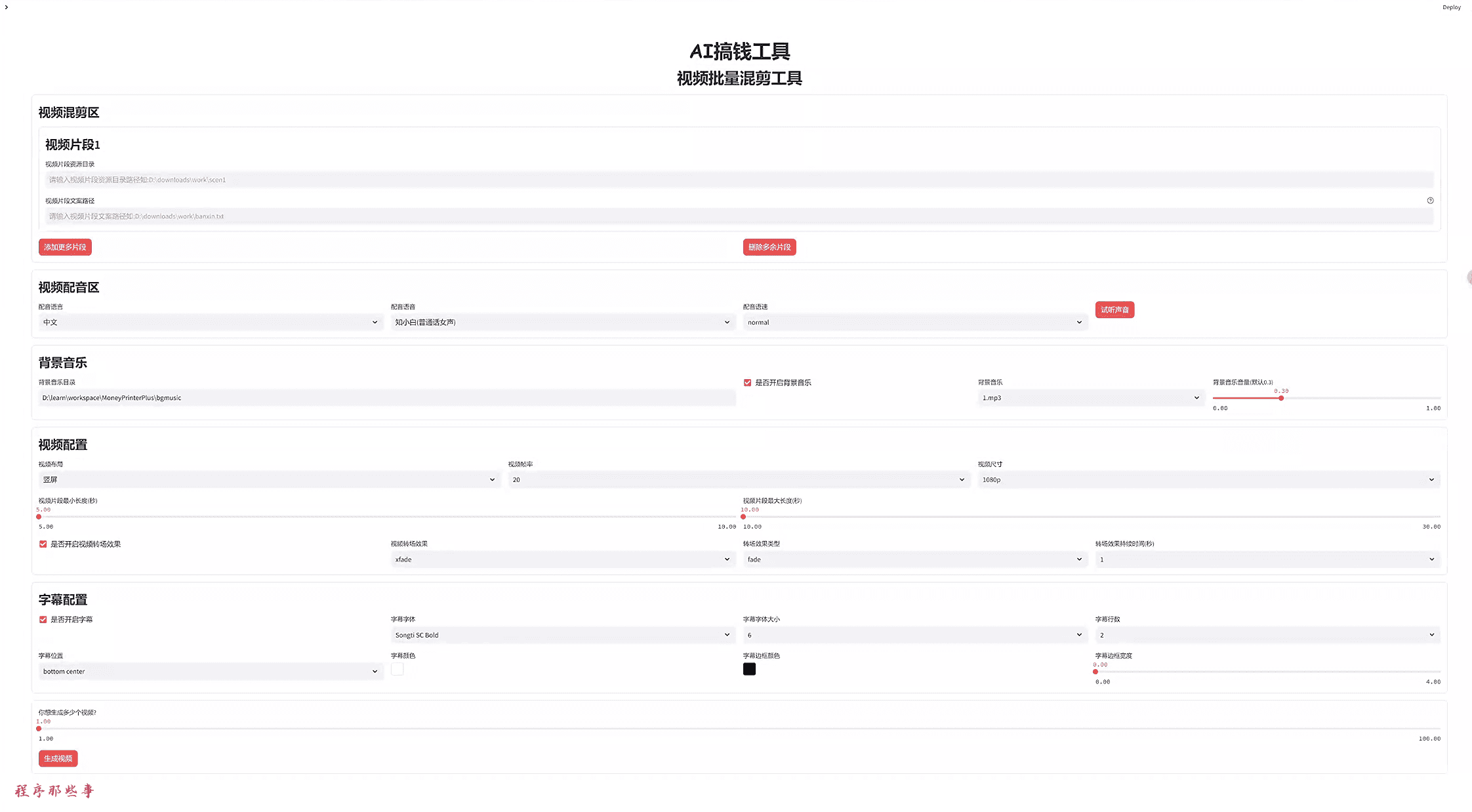

SAIL-VL2 - это мультимодальная модель визуального языка с открытым исходным кодом, разработанная командой Byte Jump и ориентированная на совместное моделирование мультимодальных входных данных, таких как изображения и текст. Используя архитектуру разреженной смеси экспертов (MoE) и стратегию прогрессивного обучения, она достигает высокой производительности при масштабах параметров от 2B до 8B, особенно в таких задачах, как понимание графики и математические рассуждения. Инновации включают контроль качества данных, дизайн визуального кодера произвольного разрешения и процесс оптимизации после обучения. Версия с открытым исходным кодом была опубликована на GitHub для использования в образовании, обработке документов и других сферах.

Функциональные особенности SAIL-VL2

- Мощное мультимодальное понимание: Способность одновременно обрабатывать несколько модальных данных, таких как изображения и текст, для точного понимания визуального контента и создания соответствующих лингвистических описаний или ответов на вопросы.

- Эффективная обработка данных и система обучения: Оптимизированные конвейеры обработки данных и прогрессивные методы обучения используются для эффективной обработки крупномасштабных мультимодальных данных, значительно повышая эффективность обучения и производительность моделей.

- Архитектура смешанной экспертизы (MoE): Преодолевая ограничения традиционных интенсивных моделей, архитектура MoE обеспечивает эффективные вычисления и масштабное масштабирование параметров для улучшения масштабируемости и эффективности модели.

- Гибкая конструкция адаптера: Бесшовное согласование визуальной информации с лингвистическими моделями с помощью визуально-лингвистических адаптеров для поддержки быстрой адаптации нескольких мультимодальных задач.

- Отличные навыки рассуждения и генерации: хорошо справляется с задачами мультимодального рассуждения и способен к сложным логическим рассуждениям и генерации контента, например, описанию изображений и визуальным викторинам.

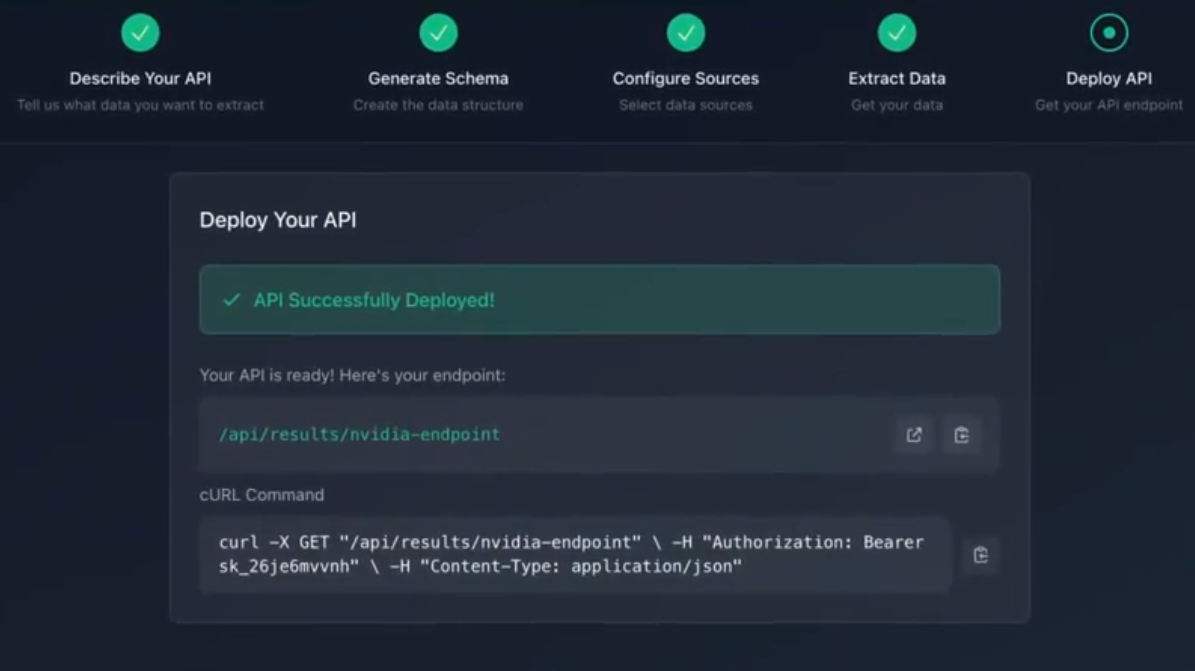

- Открытый исходный код и масштабируемость: Модель с открытым исходным кодом обеспечивает гибкие возможности расширения и настройки для облегчения вторичного развития и применения исследователями и разработчиками.

- Широкий диапазон применимостиОн поддерживает различные мультимодальные задачи, такие как описание изображений, понимание видео, интеллектуальный поиск и т.д., и применим во многих областях, таких как образование, здравоохранение и интеллектуальное вождение.

Основные преимущества SAIL-VL2

- Эффективный архитектурный дизайнАрхитектура Mixed Expert (MoE) позволяет преодолеть ограничения традиционных интенсивных моделей и достичь высокой производительности при активации только некоторых параметров, что значительно повышает эффективность вычислений и масштабируемость размера модели.

- Мощные мультимодальные возможностиОн может одновременно обрабатывать несколько модальных данных, таких как изображения и текст, точно понимать визуальный контент и генерировать соответствующие лингвистические описания или отвечать на вопросы, что подходит для широкого спектра мультимодальных задач.

- Оптимизированная обработка данных: Оптимизация качества и распределения данных с помощью стратегий скоринга и фильтрации, охватывающих широкий спектр мультимодальных типов данных для обеспечения производительности модели в различных задачах и повышения эффективности обучения.

- Прогрессивная система обучения: Начиная с предварительного обучения визуальных кодеров, постепенно переходя к мультимодальному предварительному обучению, и, наконец, оптимизируя с помощью гибридной парадигмы контролируемой тонкой настройки (SFT) и обучения с подкреплением (RL) для систематического улучшения производительности модели.

- Отличные навыки рассуждения: отлично справляется с задачами мультимодального рассуждения и способен выполнять сложные логические рассуждения и генерировать контент, например, описание изображений и визуальный опрос, для широкого спектра сценариев применения в реальном мире.

Что представляет собой официальный сайт SAIL-VL2?

- Репозиторий Github:: https://github.com/BytedanceDouyinContent/SAIL-VL2

- Библиотека моделей обнимающихся лиц:: https://huggingface.co/BytedanceDouyinContent

- Технический документ arXiv:: https://arxiv.org/pdf/2509.14033

Люди, которым показан SAIL-VL2

- Исследователи искусственного интеллекта: Исследователи, работающие в области мультимодального обучения, компьютерного зрения и обработки естественного языка, могут использовать SAIL-VL2 для улучшения моделей, оптимизации алгоритмов и поиска новых задач.

- Разработчики и инженеры: Инженеры, занимающиеся разработкой приложений ИИ, которые могут разрабатывать мультимодальные приложения на основе SAIL-VL2, такие как генерация описаний изображений, визуальные системы вопросов и ответов, интеллектуальный поиск и т.д.

- специалист по анализу данныхУченые, которым необходимо обрабатывать и анализировать мультимодальные данные, могут использовать SAIL-VL2 для поиска данных, извлечения признаков и обучения моделей, чтобы повысить эффективность и точность анализа данных.

- создатель контентаSAIL-VL2 может использоваться дизайнерами рекламы, создателями видеороликов, копирайтерами и другими специалистами для создания креативного контента, такого как описания изображений, сценарии видеороликов, пособия по копирайтингу и многое другое.

- педагог: В сфере образования преподаватели могут использовать SAIL-VL2 для поддержки преподавания и обучения, генерируя учебные материалы, объясняя сложные концепции или создавая интерактивный учебный контент.

- Практикующие специалисты медицинской отрасли: Врачи и исследователи могут использовать SAIL-VL2 для анализа медицинских изображений, помощи в диагностике, создания предварительных диагностических отчетов, повышения эффективности работы и точности диагностики.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...