Research Rabbit: веб-исследования и написание отчетов с использованием родного LLM, автоматическое изучение заданных пользователем тем и создание резюме.

Общее введение

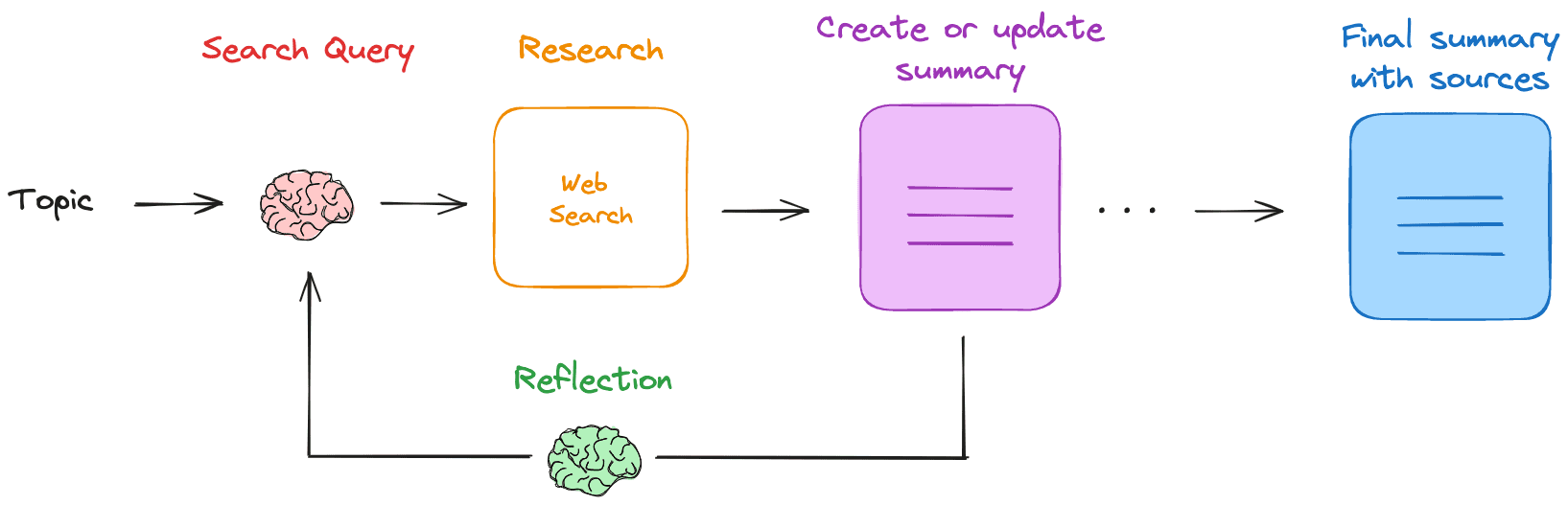

Research Rabbit - это собственный помощник по поиску и обобщению информации в Интернете на основе LLM (Large Language Model). После того как пользователь задает тему исследования, Research Rabbit формирует поисковый запрос, получает релевантные веб-результаты и обобщает их. Он повторяет этот процесс, восполняя пробелы в знаниях, и в итоге генерирует резюме в формате Markdown, включающее все источники. Инструмент работает полностью локально, обеспечивая конфиденциальность и безопасность данных.

Список функций

- Создание поисковых запросов: Генерирование поисковых запросов на основе заданных пользователем тем.

- Веб-поиск: Используйте настроенную поисковую систему (например, Tavily) для поиска нужных ресурсов.

- Краткие результаты: Обобщение результатов веб-поиска с помощью локального LLM.

- рефлексивное резюме: Выявление пробелов в знаниях и создание новых поисковых запросов.

- итеративное обновление: Повторяйте поиск и обобщение, чтобы постепенно уточнить результаты исследования.

- локальная операцияВсе операции выполняются локально для обеспечения конфиденциальности данных.

- Краткое содержание: Создайте итоговое резюме в формате Markdown со всеми источниками.

Использование помощи

Процесс установки

- Вытянуть местный LLM: Получите необходимые местные LLM от Ollama, например

ollama pull llama3.2. - Получить ключ API Tavily: Зарегистрируйте Tavily и получите ключ API, установите переменные окружения.

export TAVILY_API_KEY=<your_tavily_api_key>. - склад клонов: Беги

git clone https://github.com/langchain-ai/research-rabbit.gitХранилище клонирования. - Установка зависимостей: Перейдите в каталог проекта и выполните команду

uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph devУстановите зависимость. - Помощник стартапа: Запустите сервер LangGraph и получите доступ к

http://127.0.0.1:2024Ознакомьтесь с документацией по API и веб-интерфейсом.

Процесс использования

- Настройка LLM: Задайте имя локального LLM, которое будет использоваться в веб-интерфейсе LangGraph Studio (по умолчанию).

llama3.2). - Установление глубины исследования: Настройка глубины итераций исследования (по умолчанию 3).

- Укажите тему исследования: Запустите помощника по исследованиям, введя тему исследования на вкладке Конфигурация.

- Процесс просмотра: Ассистент формирует поисковый запрос, выполняет поиск в Интернете, обобщает результаты с помощью LLM и повторяет процесс.

- Получение сводки: По завершении исследования помощник генерирует резюме в формате Markdown со всеми источниками, которое пользователь может просматривать и редактировать.

Основные функции

- Создание поисковых запросов: После ввода темы исследования помощник автоматически сформирует поисковый запрос.

- Веб-поиск: Ассистент использует настроенную поисковую систему для поиска нужных ресурсов.

- Краткие результаты: Ассистент использует локальный LLM для обобщения результатов поиска и создания предварительного отчета.

- рефлексивное резюме: Ассистент выявляет пробелы в знаниях, содержащихся в резюме, и генерирует новые поисковые запросы для продолжения исследования.

- итеративное обновлениеАссистент будет итеративно проводить поиск и составление резюме, чтобы постепенно уточнить результаты исследования.

- Создание резюме в формате Markdown: По завершении исследования помощник создает итоговую сводку в формате Markdown со всеми источниками, которую пользователь может просматривать и редактировать.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...