Выпущен Qwen3: новое поколение больших языковых моделей для глубокого мышления и быстрого реагирования

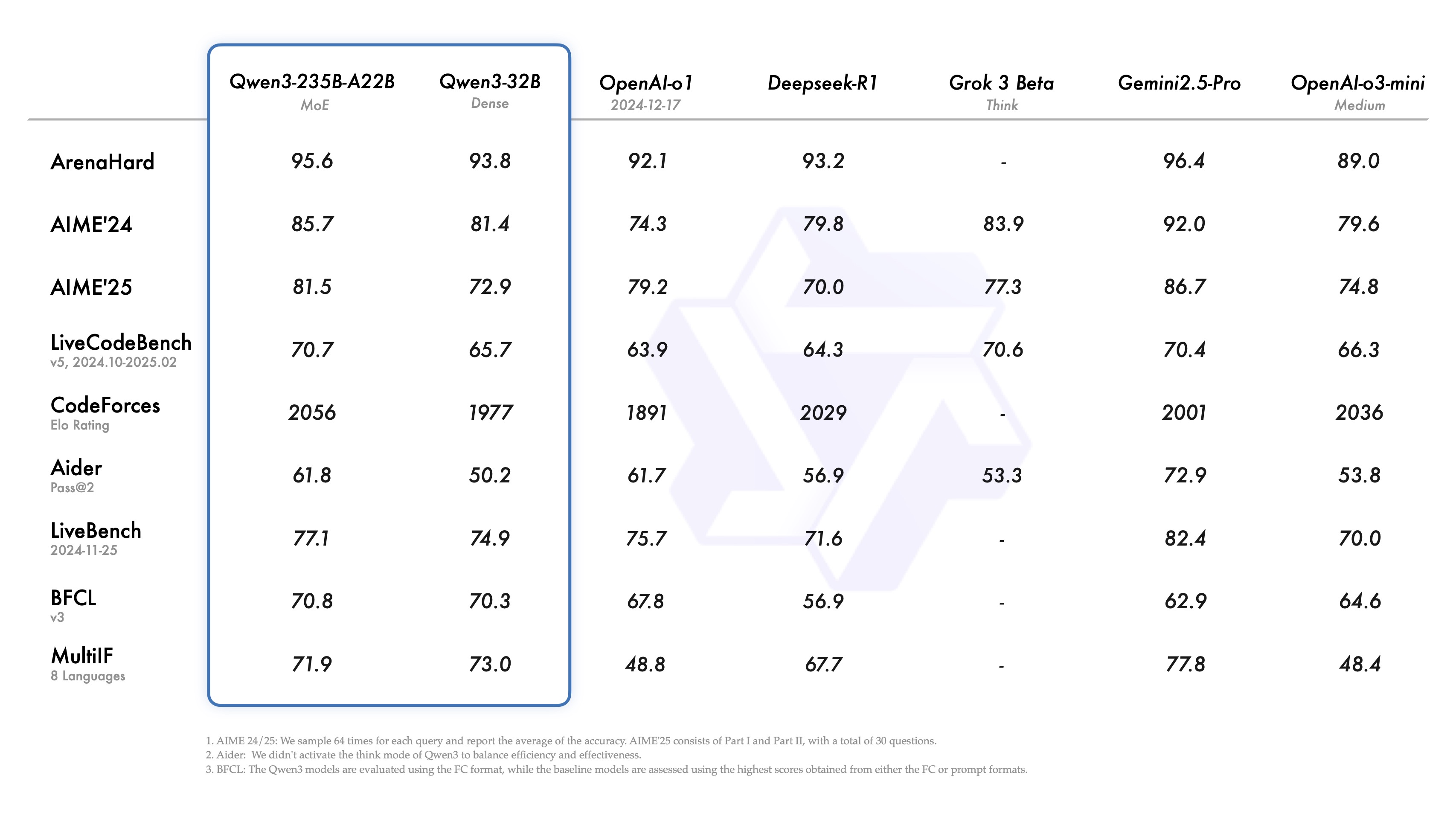

В области больших языковых моделей появился новый участник. Недавно семейство больших языковых моделей Qwen выпустило свою последнюю версию - Qwen3. По словам команды разработчиков, флагманская модель, Qwen3-235B-A22B, продемонстрировала положительные результаты в сравнении с Qwen3-235B-A22B в тестах на кодирование, математические и общецелевые способности. DeepSeek-R1 , o1 . o3-mini Qwen3 разработан для того, чтобы сравниться по производительности с лучшими моделями индустрии, такими как Grok-3 и Gemini-2.5-Pro. Выбор этих конкурентов отражает позиционирование Qwen3, поскольку он стремится к прямому диалогу с текущими эталонами производительности.

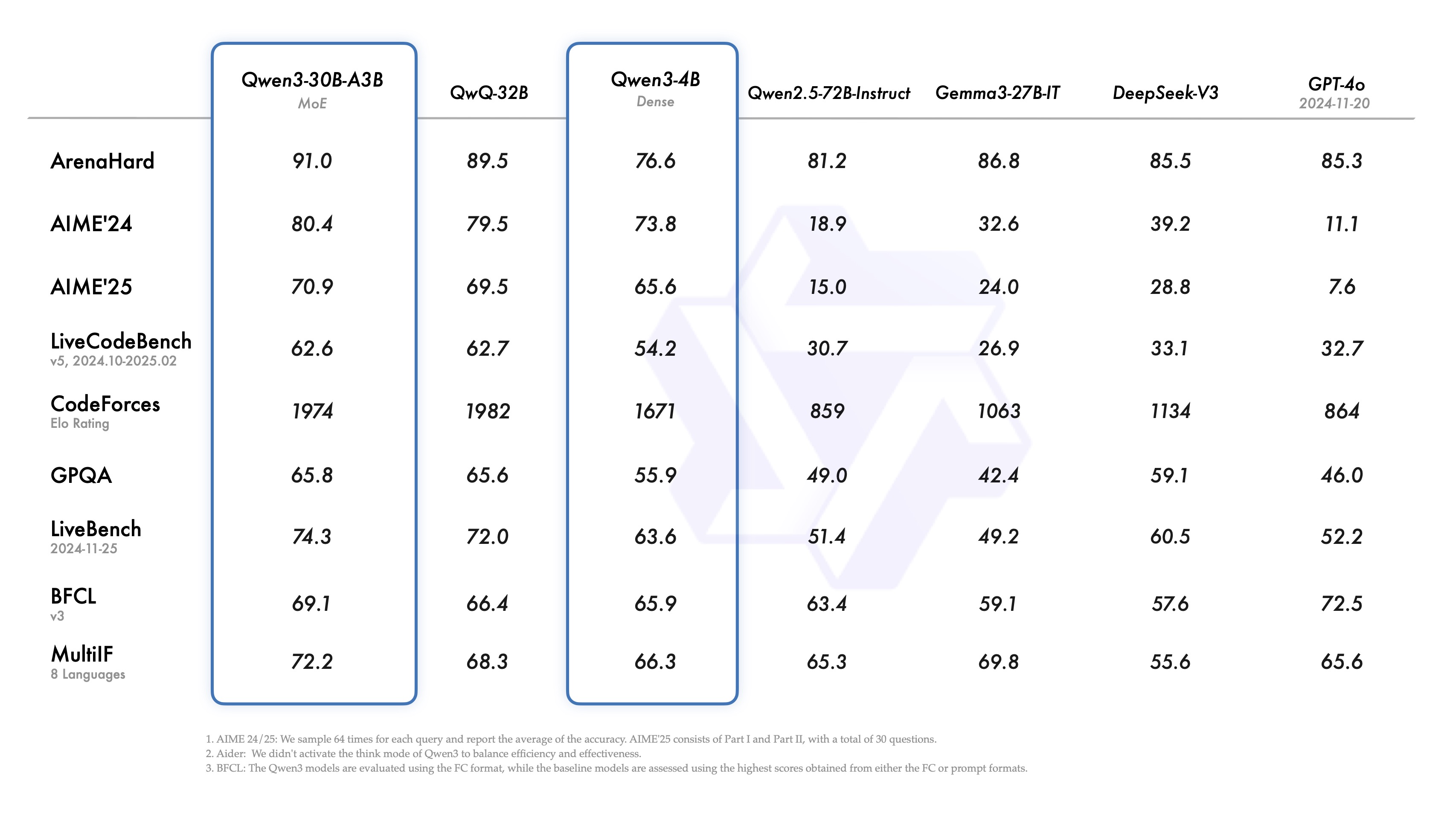

Интересно отметить, что небольшая модель смешанного эксперта (MoE) Qwen3-30B-A3B, как утверждается, превосходит QwQ-32B с большим количеством ковариаций (хотя и с одной десятой активационных параметров последней), и даже меньшая модель Qwen3-4B, как утверждается, соответствует производительности Qwen2.5-72B-Instruct. Это свидетельствует о значительном повышении эффективности благодаря оптимизированной архитектуре модели и улучшенным методам обучения.

Изюминкой релиза является открытие весов двух моделей MoE: Qwen3-235B-A22B (235 миллиардов общих параметров, 22 миллиарда активированных) и Qwen3-30B-A3B (30 миллиардов общих параметров, 3 миллиарда активированных). MoE - это техника, которая позволяет модели активировать только часть "экспертной" сети при рассуждениях. MoE - это техника, позволяющая моделям задействовать только часть "экспертной" сети при рассуждениях, что значительно снижает вычислительные требования при сохранении высокой производительности, что важно для развертывания больших моделей в более широком диапазоне сценариев.

Также, следуя лицензии Apache 2.0, команда открыла веса для шести плотных моделей с охватом параметров от 600 миллионов до 32 миллиардов, а именно Qwen3-32B, Qwen3-14B, Qwen3-8B, Qwen3-4B, Qwen3-1.7B и Qwen3-0.6B.

Обзор спецификаций моделей (плотные модели):

| Модели | Слои | Напор (Q / KV) | Вшивание галстука | Контекст Длина |

|---|---|---|---|---|

| Qwen3-0.6B | 28 | 16 / 8 | Да | 32K |

| Qwen3-1.7B | 28 | 16 / 8 | Да | 32K |

| Qwen3-4B | 36 | 32 / 8 | Да | 32K |

| Qwen3-8B | 36 | 32 / 8 | Нет | 128K |

| Qwen3-14B | 40 | 40 / 8 | Нет | 128K |

| Qwen3-32B | 64 | 64 / 8 | Нет | 128K |

Обзор спецификаций модели (модель MoE):

| Модели | Слои | Напор (Q / KV) | # Эксперты (общие / активированные) | Контекст Длина |

|---|---|---|---|---|

| Qwen3-30B-A3B | 48 | 32 / 4 | 128 / 8 | 128K |

| Qwen3-235B-A22B | 94 | 64 / 4 | 128 / 8 | 128K |

Эти модели и их предварительно обученные версии (например, Qwen3-30B-A3B-Base) уже работают на таких крупных платформах, как Hugging Face, ModelScope, Kaggle и других. Для развертывания моделей рекомендуется использовать SGLang и vLLM и другие фреймворки. Для локальных сценариев использования можно использовать Ollama, LMStudio, MLX llama.cpp, и KTransformers и другие инструменты обеспечивают легкий доступ.

Разработчики могут использовать Qwen Chat Web и мобильных приложений, чтобы испытать возможности Qwen3.

Анализ основных характеристик

В Qwen3 появилось несколько примечательных функций:

- Гибридные режимы мышленияQwen3 поддерживает два режима решения задач:

- Режим мышления. Модель выполняет пошаговые рассуждения, показывает ход мыслей, а затем выдает окончательный ответ. Это относится к сложным проблемам, требующим глубокого анализа.

- Режим бездумья. Модель обеспечивает быстрое, практически мгновенное реагирование в сценариях, где важна скорость, а проблема относительно проста.

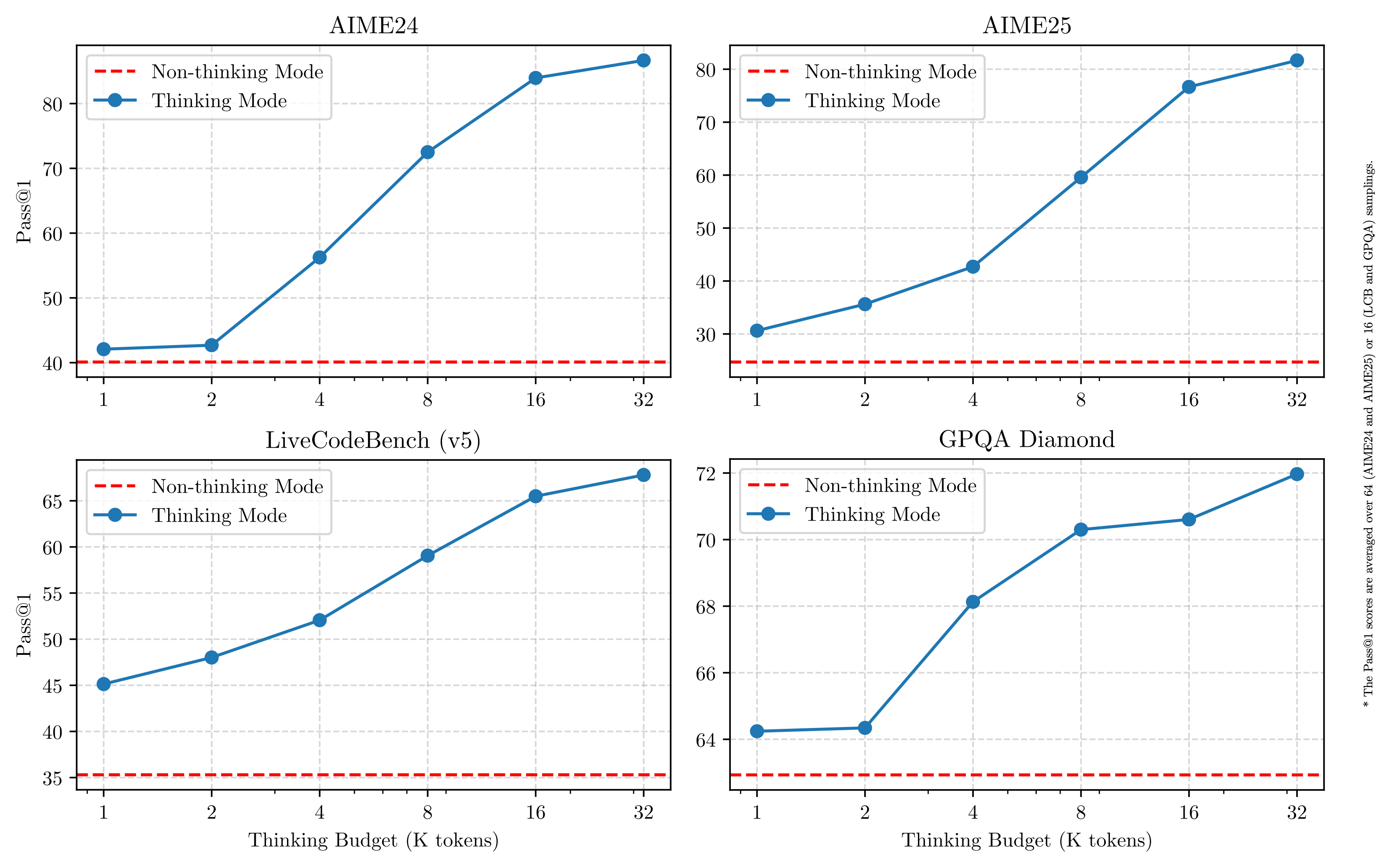

Такая конструкция дает пользователю возможность гибко управлять "глубиной мышления" модели в зависимости от потребностей задачи. Что еще более важно, эта гибридная модель позволяет стабильно и эффективно контролировать "бюджет мышления" модели. Как показано на рисунке ниже, производительность Qwen3 демонстрирует масштабируемость и плавное улучшение, напрямую зависящее от выделенного бюджета на вычислительные рассуждения. Пользователи могут легче настраивать бюджеты для конкретных задач, находя таким образом оптимальный баланс между экономичностью и качеством рассуждений. Это дает новые идеи для управления стоимостью больших моделей в реальных приложениях.

- Широкая многоязыковая поддержкаМодели Qwen3 поддерживают до 119 языков и диалектов. Эта широкая многоязыковая функциональность открывает новые возможности для интернационализированных приложений и помогает глобальным пользователям использовать преимущества моделей.

Языковая семья Языки и диалекты Индоевропейский Английский, французский, португальский, немецкий, румынский, шведский, датский, болгарский, русский, чешский, греческий, украинский, испанский, голландский, словацкий, хорватский. Польский, литовский, норвежский Bokmål, норвежский Nynorsk, персидский, словенский, гуджарати, латышский, итальянский, окситанский, непали, маратхи, белорусский. Сербский, люксембургский, венецианский, ассамский, валлийский, силезский, астурийский, чхаттисгархи, авадхи, майтхили, бходжпури, синдхи, ирландский, фарерский, хинди. Пенджаби, бенгальский, ория, таджикский, восточный идиш, ломбардский, лигурийский, сицилийский, фриульский, сардинский, галисийский, каталонский, исландский, тоскский албанский. Лимбургский, дари, африкаанс, македонский, сингальский, урду, магахи, боснийский, армянский Китайско-Тибетский Китайский (упрощенный китайский, традиционный китайский, кантонский), бирманский Афро-азиатские Арабский (стандартный, надждийский, левантийский, египетский, марокканский, месопотамский, таиззи-адени, тунисский), иврит, мальтийский Австронезийские Индонезийский, малайский, тагальский, себуано, яванский, сунданский, минангкабау, балийский, банджар, пангасинан, илоко, варай (Филиппины) Дравидийский Тамил, телугу, каннада, малаялам Тюркский Турецкий, североазербайджанский, североузбекский, казахский, башкирский, татарский Тай-Кадай Тайский, лаосский Уральский Финский, эстонский, венгерский Австроазиатский Вьетнамский, кхмерский Другие Японский, корейский, грузинский, баскский, гаитянский, папьяменто, кабувердиану, ток-писин, суахили - Расширенные возможности агентовМодель Qwen3 оптимизирована для кодирования и выполнения задач в качестве интеллектуального агента (Agent). Команда также расширила поддержку MCP, что может означать Multi-Agent Collaboration Platform. В видеоролике по ссылке ниже показано, как Qwen3 мыслит и взаимодействует с окружением (например, вызывает инструменты).Ссылка на видеопрезентацию: https://qianwen-res.oss-accelerate-overseas.aliyuncs.com/mcp.mov

Детали обучения: данные, этапы и оптимизация

Объем данных для предварительного обучения Qwen3 значительно больше, чем у Qwen2.5, который использовал 18 триллионов лексем, и Qwen3, который имеет почти вдвое больше данных для предварительного обучения - около 36 триллионов лексем, охватывающих 119 языков и диалектов.

В качестве источников данных использовались не только веб-страницы, но и документы в формате PDF. Команда использует Qwen2.5-VL Модель извлекала текст из этих документов и использовала Qwen2.5 для повышения качества извлеченного контента. Чтобы увеличить долю данных по математике и коду, с помощью Qwen2.5-Math и Qwen2.5-Coder были также сгенерированы синтетические данные, такие как учебники, пары тестов и фрагменты кода.

Процесс предварительной подготовки делится на три этапа:

- Фаза S1. Более 30 триллионов долларов жетон Предварительное обучение проводится на контексте длиной 4K лексем. Этот этап направлен на формирование у модели базовых лингвистических навыков и общих знаний.

- Фаза S2. Увеличьте долю наукоемких данных (например, STEM, кодирование, задачи на рассуждение), оптимизируйте набор данных и продолжите предварительное обучение на дополнительных 5 триллионах лексем.

- Фаза S3. Использование высококачественных длинных контекстных данных увеличивает длину контекста модели до 32 тыс. лексем (и даже 128 тыс. для некоторых моделей), гарантируя, что модель может эффективно обрабатывать длинные входные данные.

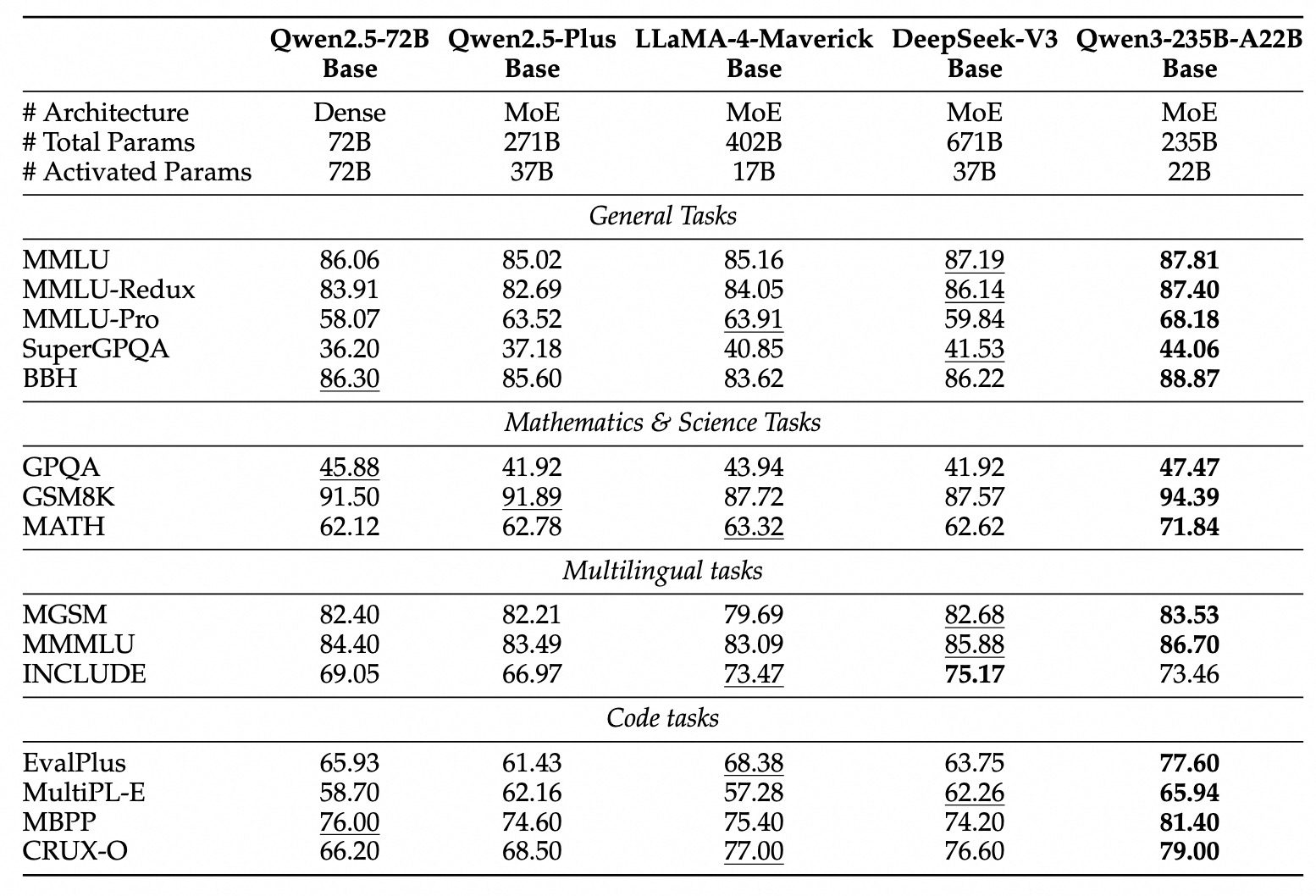

Благодаря улучшенной архитектуре модели, увеличению количества обучающих данных и более эффективным методам обучения общая производительность плотной базовой модели Qwen3 достигает уровня базовой модели Qwen2.5, которая имеет гораздо большее количество ковариатов. Например, Qwen3-1.7B/4B/8B/14B/32B-Base работает сопоставимо с Qwen2.5-3B/7B/14B/32B/72B-Base, соответственно. В частности, модель с плотной базой Qwen3 превосходит даже более крупную модель Qwen2.5 в таких областях, как STEM, кодирование и вывод.

Для базовой модели Qwen3-MoE они достигают производительности, аналогичной плотной базовой модели Qwen2.5, используя только около 10% параметров активации, что означает значительную экономию затрат на обучение и вывод.

Посттренировочный процесс

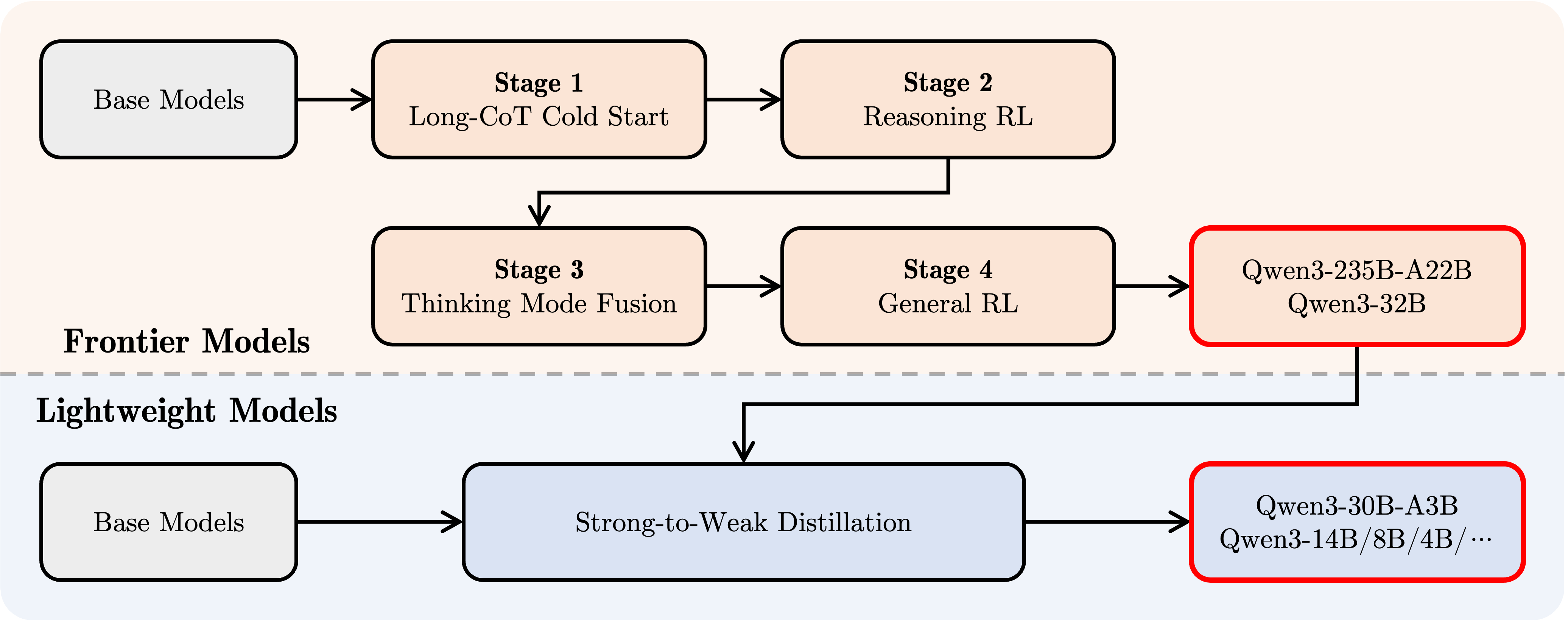

Чтобы разработать смешанную модель, сочетающую в себе пошаговое рассуждение и быстрое реагирование, команда Qwen реализовала четырехэтапный процесс посттренировочного обучения:

- Длительный холодный старт CoT. Модели оттачиваются с помощью длинных цепочек мыслительных данных, охватывающих различные задачи и области, такие как математика, кодирование, логические рассуждения, STEM и т. д., с целью развития фундаментальных навыков рассуждения.

- RL, основанный на рассуждениях. Расширение инвестиций вычислительных ресурсов в обучение с подкреплением и использование Rule-based Rewards (RBR) для улучшения исследования и использования моделей с целью дальнейшего повышения эффективности выводов.

- Мыслительные паттерны Конвергенция. Интеграция немыслительных способностей в модель мышления. Интеграция способностей к рассуждению и быстрому реагированию достигается путем точной настройки на смеси данных длительного CoT и обобщенных данных точной настройки команд (которые генерируются улучшенной моделью мышления на этапе 2).

- Общее обучение с подкреплением (General Reinforcement Learning, General RL). Обучение с подкреплением применяется на более чем 20 типовых задачах домена для дальнейшего укрепления типовых возможностей модели (например, соблюдение инструкций, соблюдение формата, возможности агента и т.д.) и исправления нежелательного поведения.

Разработка с помощью Qwen3

Здесь представлено краткое руководство по использованию Qwen3 в различных фреймворках. Первый - стандартный пример использования Qwen3-30B-A3B в библиотеке трансформаторов Hugging Face:

from modelscope import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-30B-A3B"

# 加载 tokenizer 和模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 准备模型输入

prompt = "给我简要介绍一下大型语言模型。"

messages = [

{"role": "user", "content": prompt}

]

# apply_chat_template 用于构建符合 Qwen 对话格式的输入

# enable_thinking=True 启用思考模式 (默认为 True)

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

enable_thinking=True # 在思考模式和非思考模式间切换,默认为 True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 进行文本生成

generated_ids = model.generate(

**model_inputs,

max_new_tokens=32768 # 设置最大生成 token 数

)

# 提取生成的内容部分 (去除输入部分)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

# 解析思考内容 (如果存在)

# 寻找 '</think>' 对应的 token id (151668)

try:

# rindex 从后往前查找 151668

index = len(output_ids) - output_ids[::-1].index(151668)

except ValueError:

# 如果没有找到 '</think>',说明没有思考内容

index = 0

# 分别解码思考内容和最终回复内容

thinking_content = tokenizer.decode(output_ids[:index], skip_special_tokens=True).strip("\n")

content = tokenizer.decode(output_ids[index:], skip_special_tokens=True).strip("\n")

print("思考内容:", thinking_content)

print("最终回复:", content)

Чтобы отключить режим мышления, просто установите параметр enable_thinking в значение False:

text = tokenizer.apply_chat_template( messages, tokenize=False, add_generation_prompt=True, enable_thinking=False # 默认为 True )

Для развертывания модели можно создать конечные точки, совместимые с API OpenAI, используя sglang>=0.4.6.post1 или vllm>=0.8.4:

- Использование SGLang.

python -m sglang.launch_server --model-path Qwen/Qwen3-30B-A3B --reasoning-parser qwen3

- Использование vLLM.

vllm serve Qwen/Qwen3-30B-A3B --enable-reasoning --reasoning-parser deepseek_r1

(Примечание: в оригинальной статье здесь используется парсер deepseek_r1, разработчикам необходимо проверить его совместимость с Qwen3)

В локальной среде разработки ollama можно использовать с помощью простой команды оллама запустите qwen3:30b-a3b для взаимодействия с моделью. Кроме того, такие инструменты, как LMStudio, llama.cpp и ktransformers, поддерживают создание и запуск Qwen3 локально.

Продвинутое использование: динамическое переключение режимов мышления

Qwen3 предоставляет механизм "мягкого переключения", который позволяет пользователю динамически управлять поведением модели, когда enable_thinking=True. В частности, вы можете добавить теги /think или /no_think в вопросы пользователя или системные сообщения, чтобы переключать режим мышления модели от раунда к раунду. В многораундовом диалоге модель будет следовать самой последней инструкции.

Ниже приведен пример многораундового диалога:

from transformers import AutoModelForCausalLM, AutoTokenizer

class QwenChatbot:

def __init__(self, model_name="Qwen/Qwen3-30B-A3B"):

self.tokenizer = AutoTokenizer.from_pretrained(model_name)

# 注意:实际运行时需要确保有足够的 GPU 显存加载模型

# device_map="auto" 可能需要根据实际硬件调整

self.model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto", # 自动选择合适的精度

device_map="auto" # 自动分配模型到可用设备

)

self.history = [] # 用于存储对话历史

def generate_response(self, user_input):

# 将当前用户输入加入历史记录

messages = self.history + [{"role": "user", "content": user_input}]

# 使用 apply_chat_template 构建输入

# 注意:这里没有显式设置 enable_thinking,会使用模型的默认行为或最近的 /think /no_think 指令

text = self.tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

inputs = self.tokenizer(text, return_tensors="pt").to(self.model.device)

# 生成回复

response_ids = self.model.generate(

**inputs,

max_new_tokens=32768 # 设置最大生成 token 数

)[0][len(inputs.input_ids[0]):].tolist() # 提取生成内容

# 解码回复文本

response = self.tokenizer.decode(response_ids, skip_special_tokens=True).strip()

# 更新对话历史

self.history.append({"role": "user", "content": user_input})

# 注意:此处仅添加解码后的纯文本回复,未处理思考内容

# 如果需要保留或展示思考过程,需要像之前的例子一样解析 output_ids

self.history.append({"role": "assistant", "content": response})

# 返回解码后的回复文本

return response

# 示例用法

if __name__ == "__main__":

# 确保在有足够资源的机器上运行

try:

chatbot = QwenChatbot()

# 第一次输入 (默认启用思考模式)

user_input_1 = "strawberries 这个单词里有多少个 'r'?"

print(f"用户: {user_input_1}")

response_1 = chatbot.generate_response(user_input_1)

print(f"助手: {response_1}")

print("----------------------")

# 第二次输入,使用 /no_think 禁用思考模式

user_input_2 = "那么,blueberries 这个单词里有多少个 'r'? /no_think"

print(f"用户: {user_input_2}")

response_2 = chatbot.generate_response(user_input_2)

print(f"助手: {response_2}")

print("----------------------")

# 第三次输入,使用 /think 再次启用思考模式

user_input_3 = "真的吗?请再想想。 /think"

print(f"用户: {user_input_3}")

response_3 = chatbot.generate_response(user_input_3)

print(f"助手: {response_3}")

except Exception as e:

print(f"运行出错: {e}")

print("请确保已安装所需依赖,并拥有足够的计算资源(如 GPU 显存)。")

Использование агента: вызов инструмента

Qwen3 превосходит всех по возможностям вызова инструментов. Рекомендуется использовать Qwen-Agent Qwen-Agent инкапсулирует шаблоны и парсеры для внутренних вызовов инструментов, что упрощает разработку.

Это можно сделать с помощью MCP Файлы конфигурации, использование инструментов интеграции Qwen-Agent или самостоятельная интеграция других инструментов для определения набора доступных инструментов.

import os

from qwen_agent.agents import Assistant

# 定义 LLM 配置

llm_cfg = {

'model': 'Qwen3-30B-A3B', # 指定使用的 Qwen3 模型

# 如果使用阿里云 ModelScope 提供的 DashScope API:

# 'model_type': 'qwen_dashscope',

# 'api_key': os.getenv('DASHSCOPE_API_KEY'), # 需要设置环境变量

# 如果使用兼容 OpenAI API 的自定义端点 (例如 VLLM 或 SGLang 部署的):

'model_server': 'http://localhost:8000/v1', # 替换为你的 API 地址

'api_key': 'EMPTY', # 对于本地部署或不需要 key 的情况

# 可选:其他生成参数配置

# 'generate_cfg': {

# # 如果模型的原始输出将思考过程 <think>...</think> 包含在最终内容里,设为 True

# # 如果 VLLM/SGLang 等框架已分离 reasoning_content 和 content,则设为 False 或不设置

# 'thought_in_content': False,

# },

}

# 定义工具列表

tools = [

{'mcpServers': { # 可以指定 MCP 配置文件或直接定义服务

'time': { # 定义一个名为 'time' 的工具

'command': 'uvx', # 使用 uvx 启动

# 启动参数,运行 mcp-server-time,并设置时区

'args': ['mcp-server-time', '--local-timezone=Asia/Shanghai']

},

"fetch": { # 定义一个名为 'fetch' 的工具,用于访问网页

"command": "uvx",

"args": ["mcp-server-fetch"]

}

}

},

'code_interpreter', # 使用 Qwen-Agent 内置的代码解释器工具

# 可以继续添加其他自定义或内置工具

]

# 初始化 Agent

# 需要确保 uvx 和相应的 mcp-server-* 已安装并配置好

bot = Assistant(llm=llm_cfg, function_list=tools)

# 流式生成调用示例

messages = [{'role': 'user', 'content': '访问 https://qwenlm.github.io/blog/ 页面,并介绍一下 Qwen 的最新进展。'}]

responses = None # 初始化 responses 变量

# bot.run 返回一个生成器,用于流式输出

for responses in bot.run(messages=messages):

# 可以在这里处理中间步骤的输出,例如工具调用和观察结果

# print(responses) # 打印每个中间步骤或最终回复

pass # 循环结束后,responses 将包含最终的完整回复

# 打印最终的回复内容

if responses:

print(responses)

else:

print("未能获取到回复。")

(Примечание: Чтобы запустить пример с агентом, необходимо установить библиотеку qwen-agent и связанные с ней зависимости, а также убедиться, что инструменты uvx и mcp-server-* доступны).

прогноз на будущее

Qwen3 рассматривается как важная веха на пути к общему искусственному интеллекту (AGI) и сверхискусственному интеллекту (ASI). Благодаря расширению возможностей предварительного обучения и обучения с подкреплением модель достигает более высокого уровня интеллекта. Объединение гибридных моделей мышления дает пользователям гибкость в управлении своим мыслительным бюджетом, а широкая языковая поддержка повышает глобальную доступность.

В дальнейшем команда Qwen планирует продолжать совершенствовать возможности моделей по многим направлениям, включая оптимизацию архитектуры моделей и методов обучения для масштабирования данных, увеличение размера модели, увеличение длины контекста, расширение поддержки модальностей и развитие обучения с подкреплением через обратную связь с окружающей средой для обеспечения рассуждений с большим временным горизонтом. Команда считает, что индустрия переходит от эры обучения "моделей" к эре обучения "интеллектов" (Agents). Следующая итерация обещает принести еще больше значимых достижений в работе и жизни.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...