Qwen2.5-Coder Full Series: Мощный, универсальный и практичный.

краткое содержание

Сегодня мы рады открыть исходный код мощного, разнообразного и полезного семейства моделей Qwen2.5-Coder, и мы намерены продолжать развивать Open CodeLLMs.

- грозный: Qwen2.5-Coder-32B-Instruct становится текущей моделью с открытым исходным кодом для SOTA, с возможностями кода, превосходящими GPT-4o, демонстрируя сильные и всеобъемлющие возможности кода, а также хорошие общецелевые и математические возможности.

- коллекторQwen2.5-Coder охватывает шесть основных размеров модели для удовлетворения потребностей различных разработчиков: в прошлом месяце мы открыли доступ к моделям размером 1,5 и 7 ББ, а в этом - к моделям размером 0,5, 3, 14 и 32 ББ.

- прагматик: Мы исследуем полезность Qwen2.5-Coder в сценариях Code Assistant и Artifacts, а также используем некоторые примеры, чтобы продемонстрировать потенциал Qwen2.5-Coder в реальных сценариях.

Мощный: возможность кодирования вплоть до модели SOTA с открытым исходным кодом

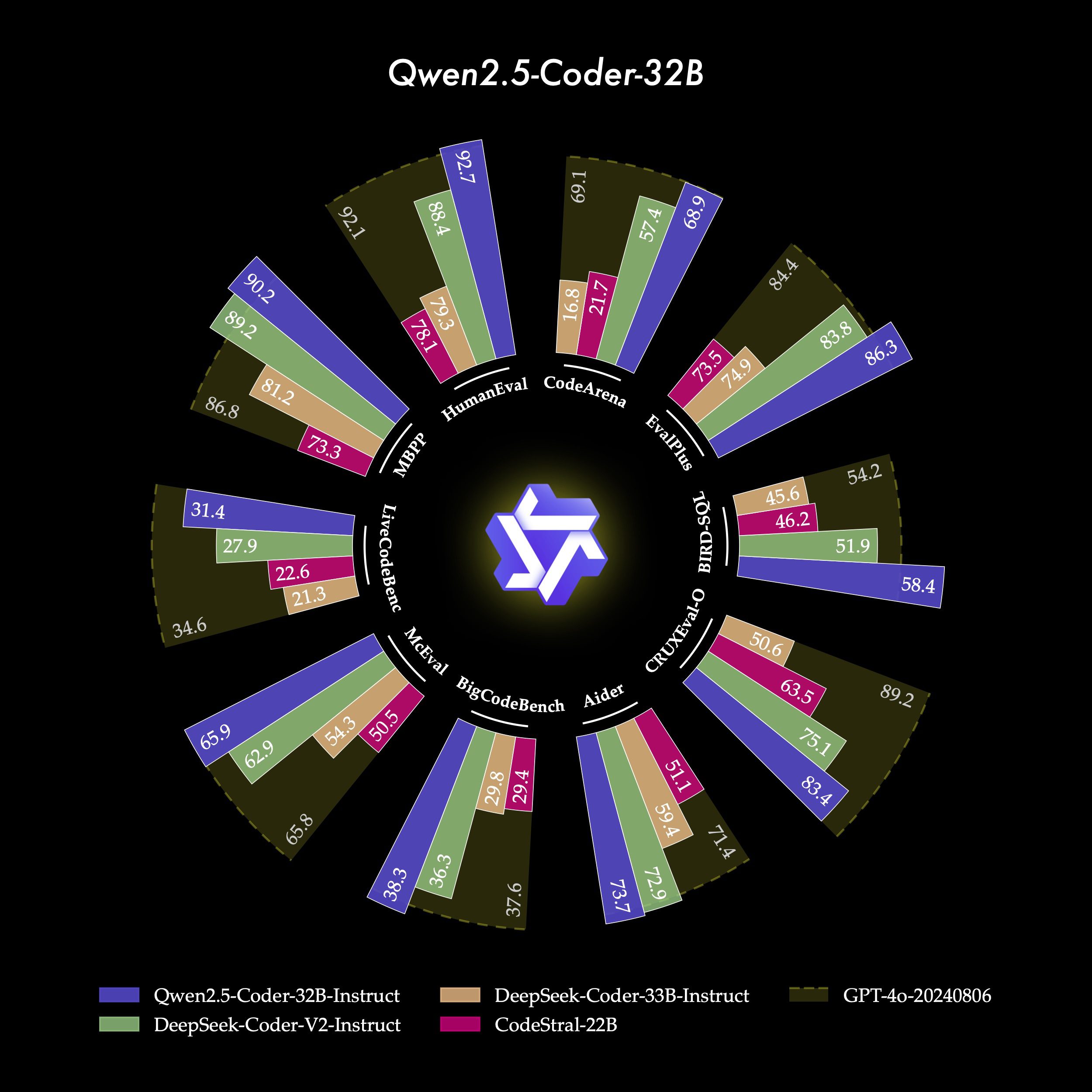

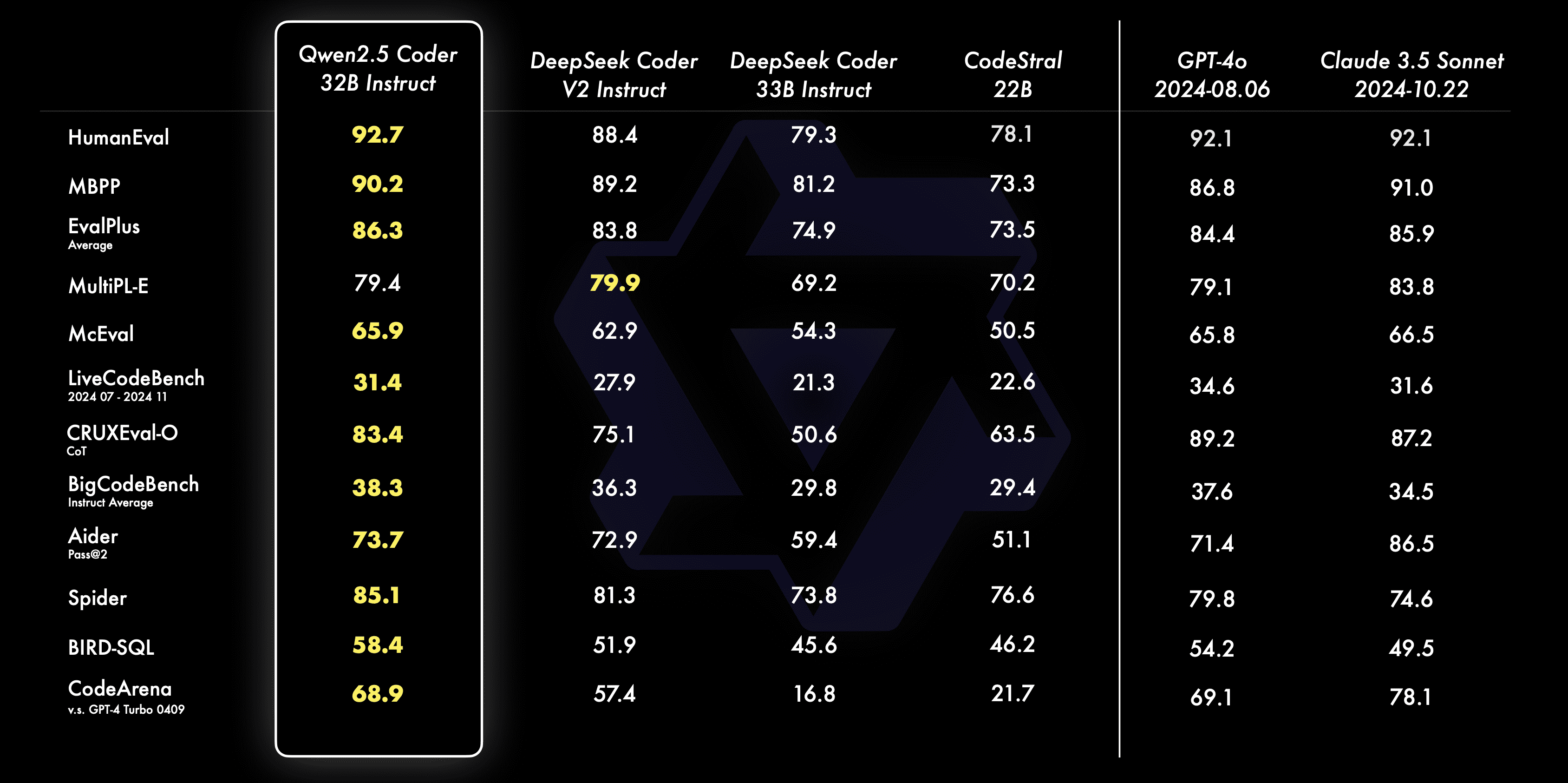

- генерация кода: Qwen2.5-Coder-32B-Instruct, флагманская модель этого открытого источника, достигла лучшей производительности среди открытых моделей на нескольких популярных бенчмарках для генерации кода (например, EvalPlus, LiveCodeBench и BigCodeBench), а также достигла конкурентоспособной производительности с GPT-4o.

- Исправления в кодеQwen2.5-Coder-32B-Instruct поможет пользователям исправить ошибки в коде и сделать программирование более эффективным. Aider - популярный бенчмарк для исправления кода, и Qwen2.5-Coder-32B-Instruct получил оценку 73.7, что сравнимо с GPT на Aider. Qwen2.5-Coder-32B-Instruct получил 73,7 балла на Aider и показал результат не хуже GPT-4o.

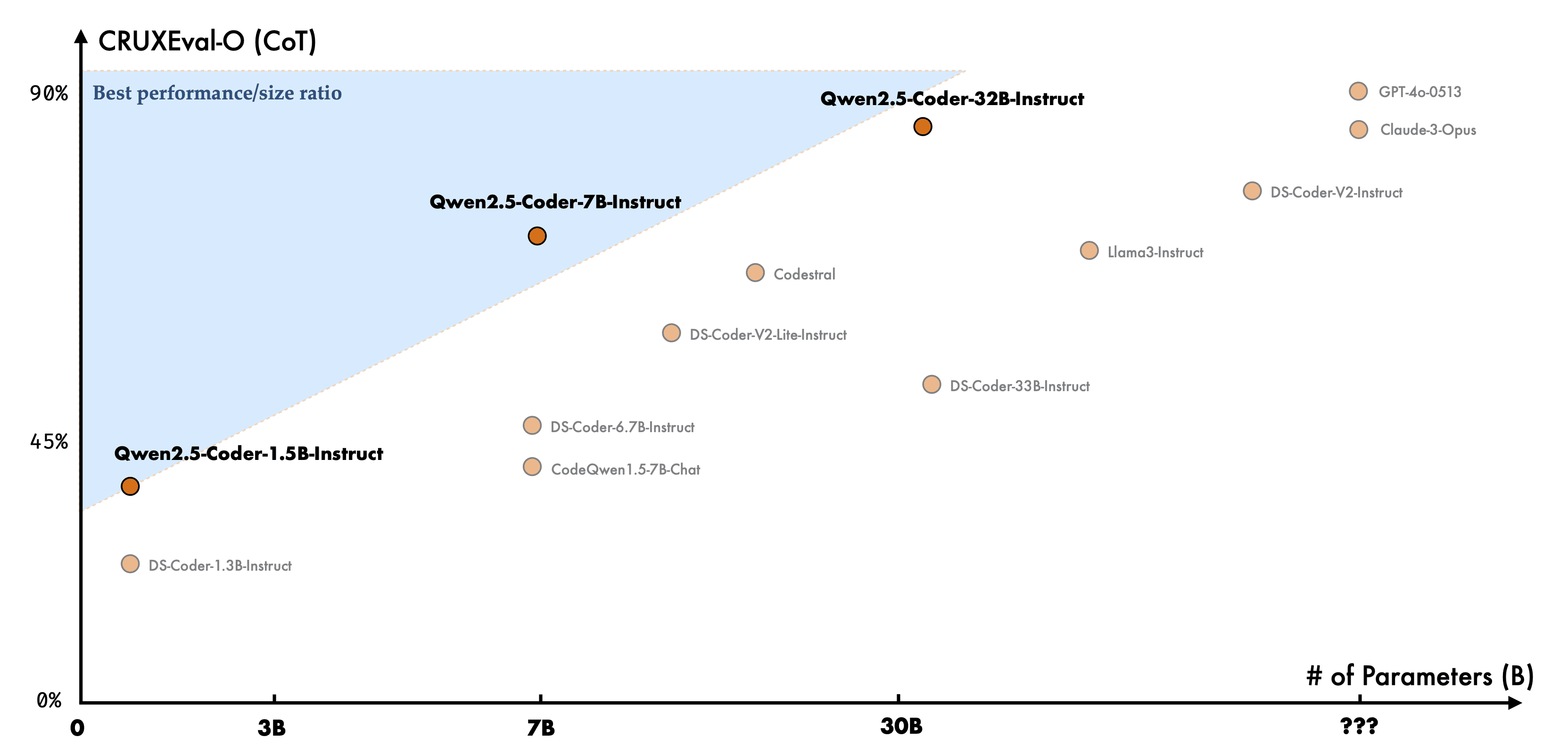

- закодированные рассужденияПод умозаключением по коду понимается способность модели изучать процесс выполнения кода и точно предсказывать входы и выходы модели. Qwen2.5-Coder-7B-Instruct, выпущенная в прошлом месяце, уже показала хорошие результаты в способности к анализу кода, а модель 32B пошла еще дальше.

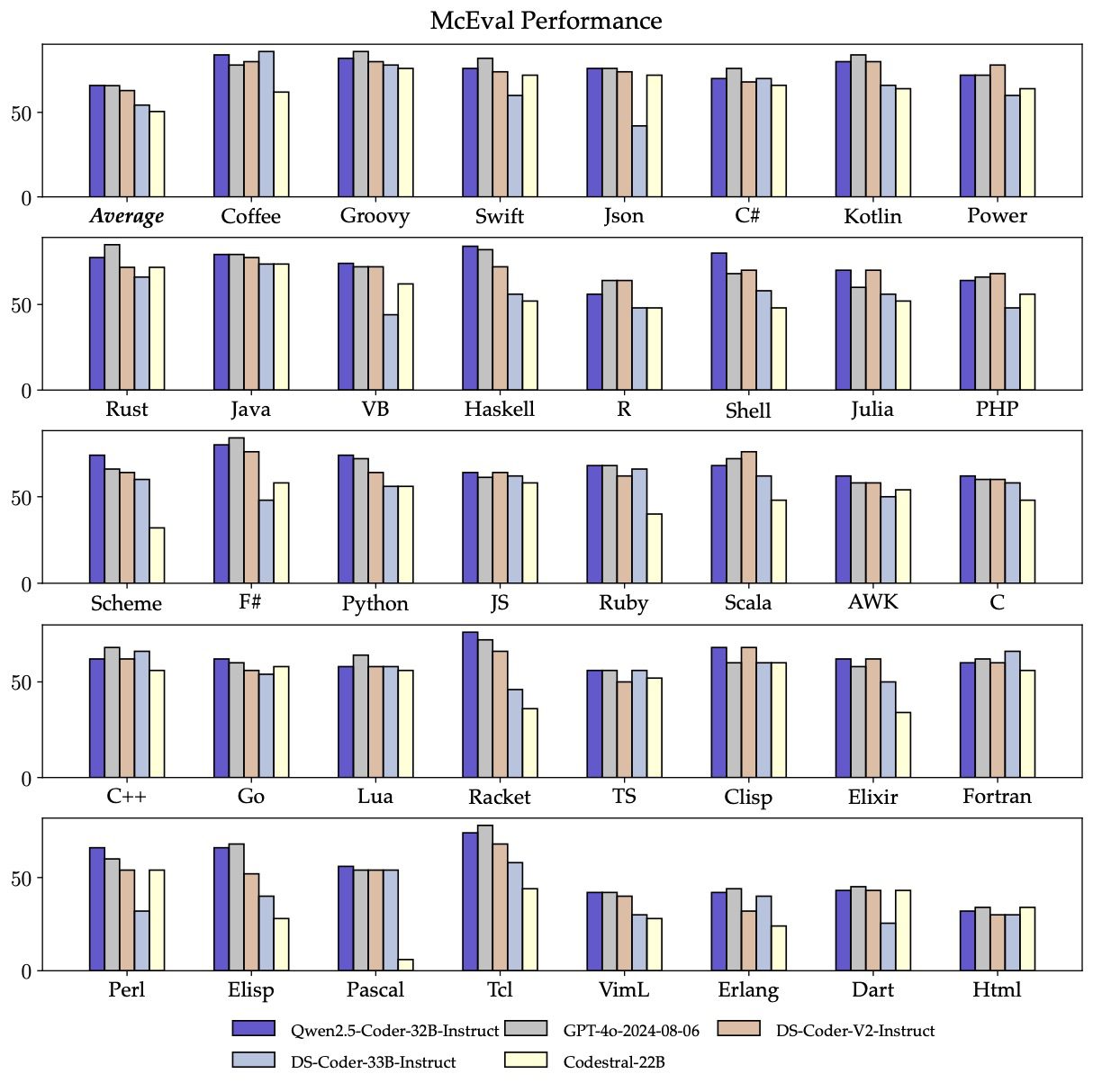

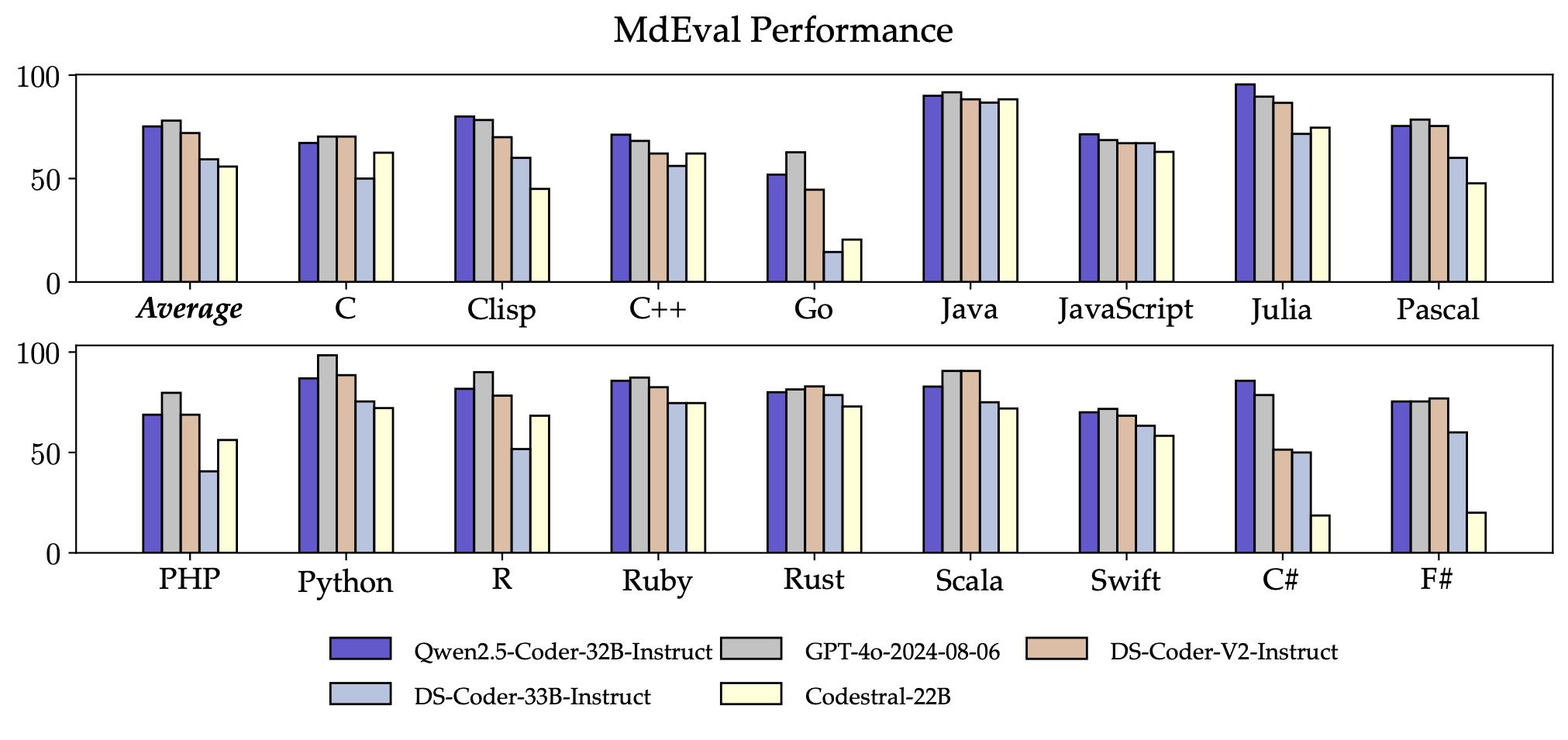

- многоязычный: Интеллектуальные помощники программиста должны знать все языки программирования, и Qwen2.5-Coder-32B-Instruct отлично справляется с более чем 40 языками программирования, получив 65,9 балла по McEval, с впечатляющими показателями по Haskell, Racket и другим, благодаря нашей уникальной очистке и нормированию данных на этапе предварительного обучения.

Кроме того, удивляет возможность Qwen2.5-Coder-32B-Instruct исправлять коды на нескольких языках программирования, что поможет пользователям понять и модифицировать знакомые языки программирования, а также значительно облегчить изучение незнакомых языков.

Как и McEval, MdEval - это бенчмарк для исправления кода на нескольких языках программирования, и Qwen2.5-Coder-32B-Instruct получил в MdEval 75,2 балла, что является лучшим результатом среди всех моделей с открытым исходным кодом.

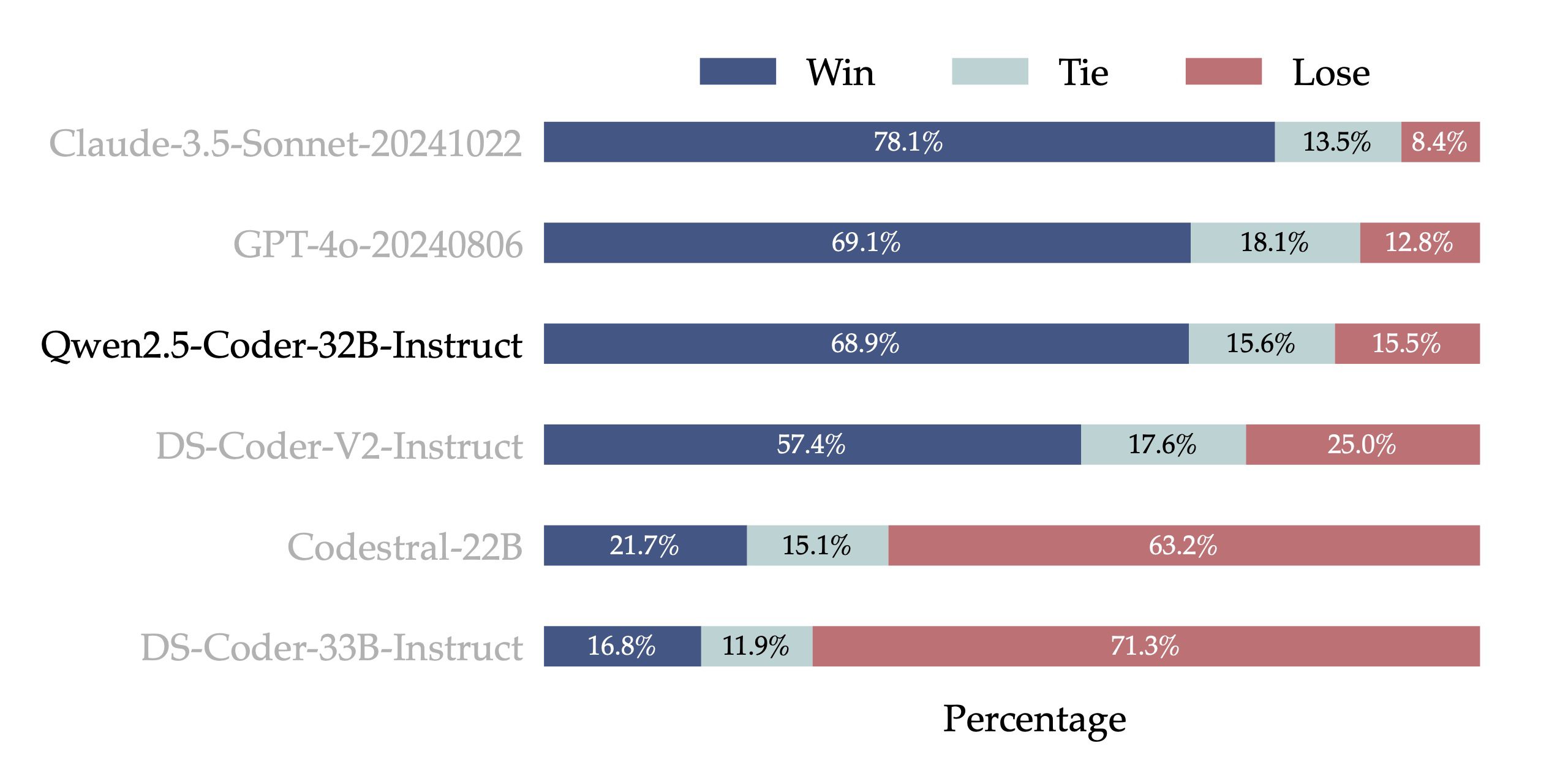

- Выравнивание предпочтений человека: Чтобы проверить эффективность выравнивания Qwen2.5-Coder-32B-Instruct на человеческих предпочтениях, мы создали Code Arena (аналогичный Arena Hard), эталон оценки предпочтений кода на основе внутренних аннотаций. Мы используем GPT-4o в качестве модели оценки для выравнивания предпочтений, с оценкой "победа A против B" - т.е. процент, на который модель A выигрывает у модели B в тестовом наборе экземпляров. Результаты, представленные на следующем рисунке, показывают преимущество Qwen2.5-Coder-32B-Instruct в выравнивании предпочтений.

Универсальность: богатый выбор размеров моделей

Семейство моделей Qwen2.5-Coder с открытым исходным кодом состоит из шести размеров: 0.5B, 1.5B, 3B, 7B, 14B и 32B, что не только удовлетворяет потребности разработчиков в различных ресурсных сценариях, но и предоставляет хорошую экспериментальную базу для исследовательского сообщества. Подробная информация о модели приведена в следующей таблице:

| Модели | Params | Параметры без эмбарго | Слои | Наконечники (KV) | Вшивание галстука | Контекст Длина | Лицензия |

|---|---|---|---|---|---|---|---|

| Qwen2.5-Coder-0.5B | 0.49B | 0.36B | 24 | 14 / 2 | Да | 32K | Apache 2.0 |

| Qwen2.5-Coder-1.5B | 1.54B | 1.31B | 28 | 12 / 2 | Да | 32K | Apache 2.0 |

| Qwen2.5-Coder-3B | 3.09B | 2.77B | 36 | 16 / 2 | Да | 32K | Qwen Research |

| Qwen2.5-Coder-7B | 7.61B | 6.53B | 28 | 28 / 4 | Нет | 128K | Apache 2.0 |

| Qwen2.5-Coder-14B | 14.7B | 13.1B | 48 | 40 / 8 | Нет | 128K | Apache 2.0 |

| Qwen2.5-Coder-32B | 32.5B | 31.0B | 64 | 40 / 8 | Нет | 128K | Apache 2.0 |

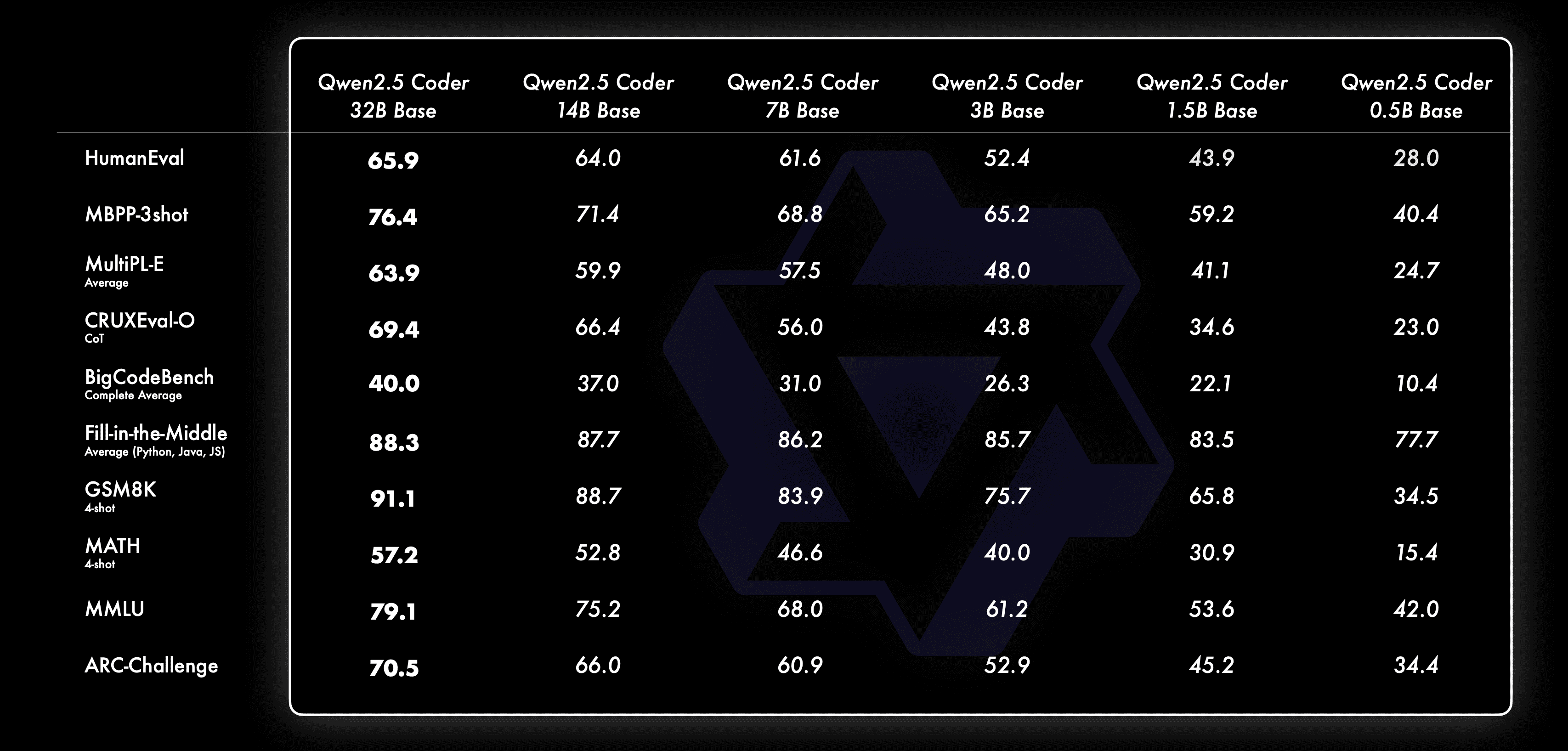

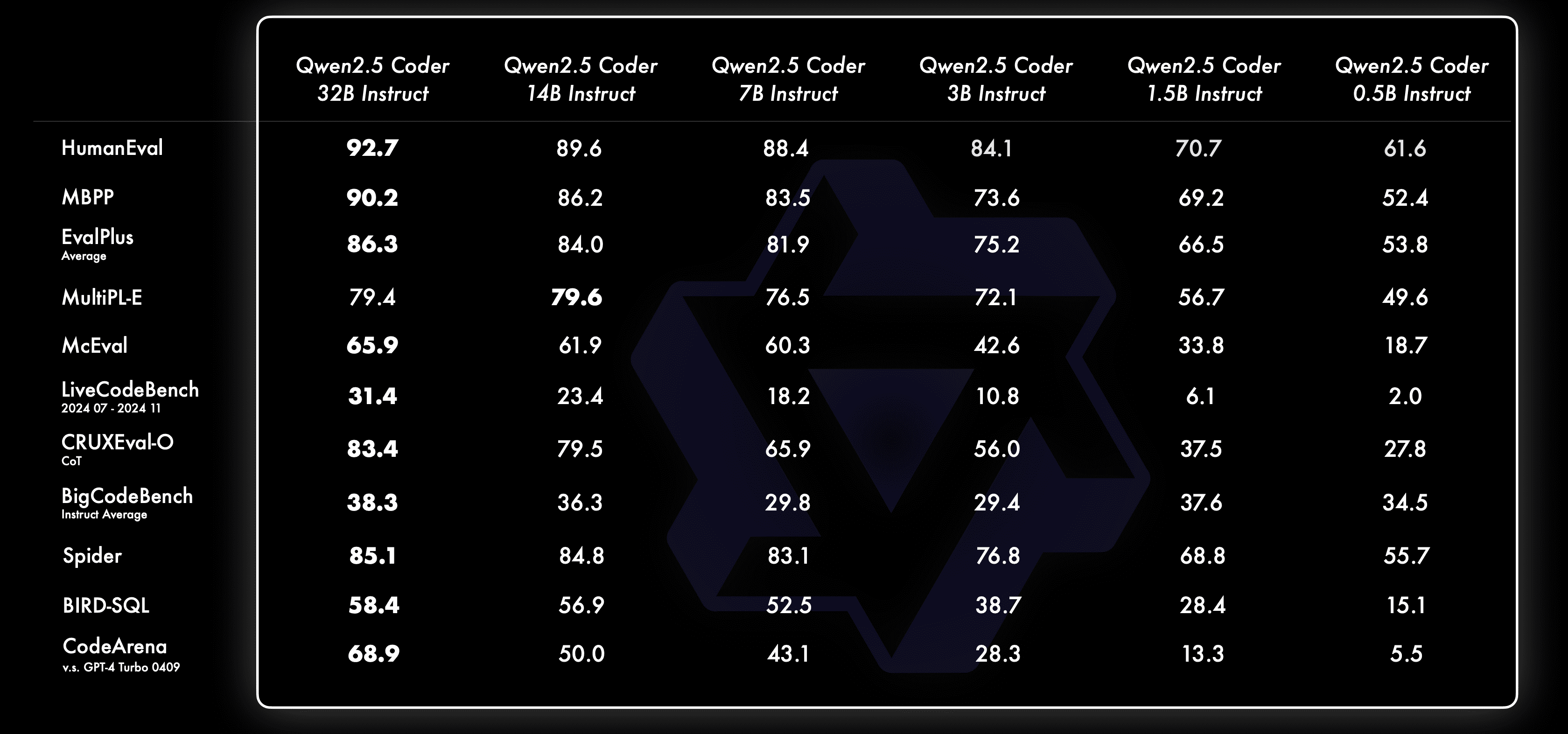

Мы всегда верили. Закон масштабирования Философия. Мы оцениваем производительность моделей Qwen2.5-Coder разных размеров на всех наборах данных, чтобы убедиться в эффективности масштабирования на кодовых LLM.

Для каждого размера у нас есть модели Base и Instruct с открытым исходным кодом, где модель Base служит базой для разработчиков, которые могут дорабатывать свои модели, а модель Instruct - это официальная модель выравнивания, доступная для прямого общения.

Вот как ведет себя модель Base при разных размерах:

Вот как ведет себя модель Instruct при разных размерах:

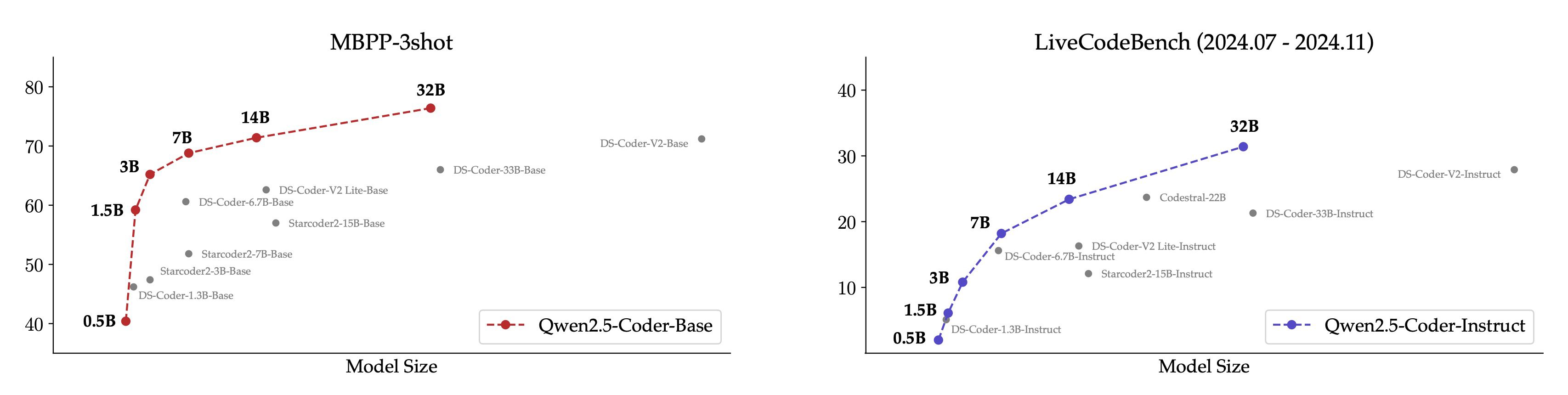

Для большей наглядности мы приводим сравнение различных размеров модели Qwen2.5-Coder и других моделей с открытым исходным кодом на основном наборе данных.

- Для базовой модели мы выбрали MBPP-3shot в качестве индекса оценки, и наши обширные эксперименты показали, что MBPP-3shot больше подходит для оценки базовой модели и может хорошо коррелировать с реальным эффектом модели.

- Для модели Instruct мы выбрали для оценки темы LiveCodeBench за последние 4 месяца (2024.07 - 2024.11), и эти недавно опубликованные темы, которые вряд ли просочатся в обучающий набор, отражают возможности модели по OOD.

Ожидаемая положительная корреляция между размером модели и ее эффективностью, а также тот факт, что Qwen2.5-Coder достиг производительности SOTA при всех размерах, побуждает нас продолжить исследование более крупных моделей Coder.

Практика: Знакомство с курсором и артефактами

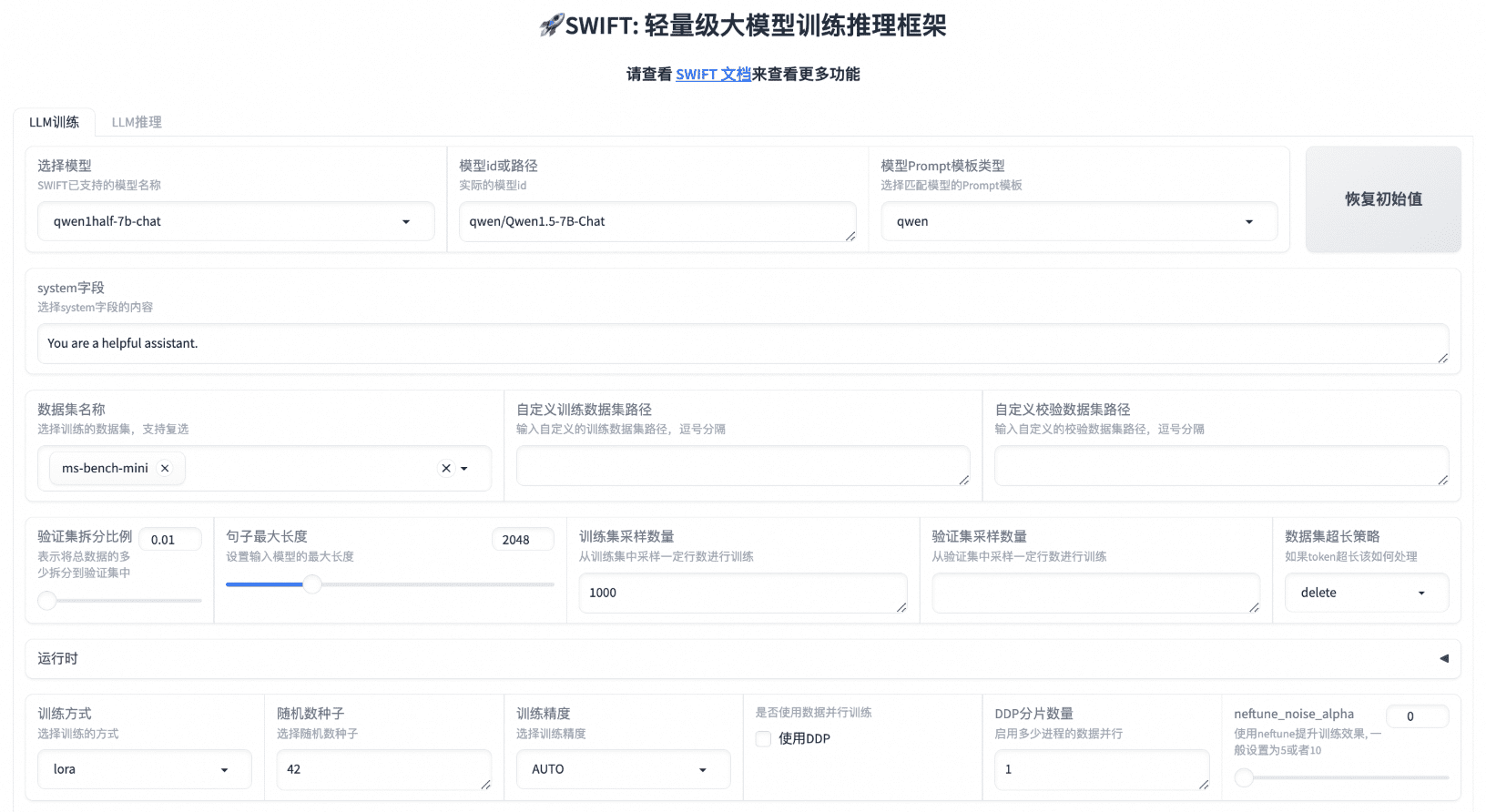

Практичный кодер всегда был нашим видением. Для этого мы изучили практическое применение модели Qwen2.5-Coder в контексте кодовых помощников и артефактов.

Qwen2.5-Coder 🤝 Курсор

Интеллектуальные помощники по работе с кодом уже широко используются, но в настоящее время в основном опираются на модели с закрытым исходным кодом, и мы надеемся, что появление Qwen2.5-Coder предоставит разработчикам дружественную и мощную альтернативу.

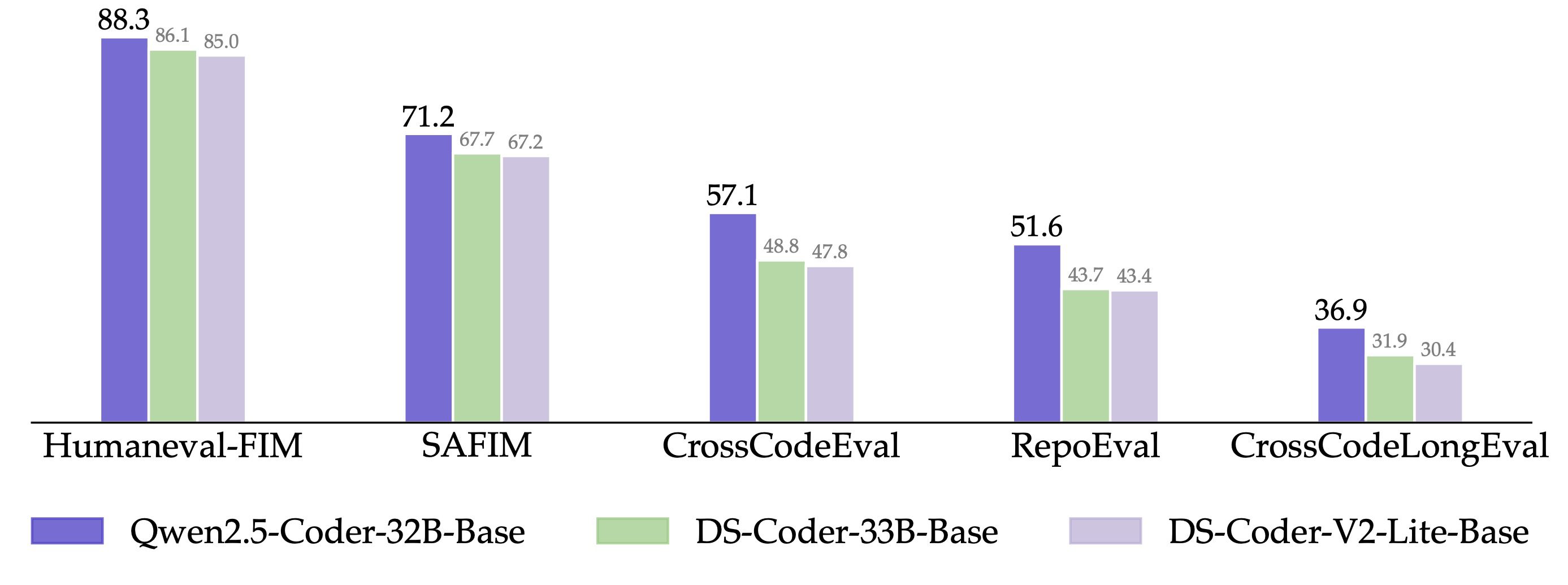

Кроме того, Qwen2.5-Coder-32B продемонстрировал высокую способность к завершению кода на предварительно обученной модели и достиг показателей SOTA на пяти наборах оценок, включая Humaneval-Infilling, CrossCodeEval, CrossCodeLongEval, RepoEval и SAFIM.

Чтобы сравнение было справедливым, мы контролируем максимальную длину последовательности в 8k и используем режим Fill-in-the-Middle для тестирования. В 4 наборах тестов CrossCodeEval, CrossCodeLongEval, RepoEval и Humaneval-Infilling мы оценивали абсолютное соответствие сгенерированного контента реальным меткам (точное соответствие), а в SAFIM мы использовали для оценки 1-кратный коэффициент успешности выполнения (Pass@1). оценки.

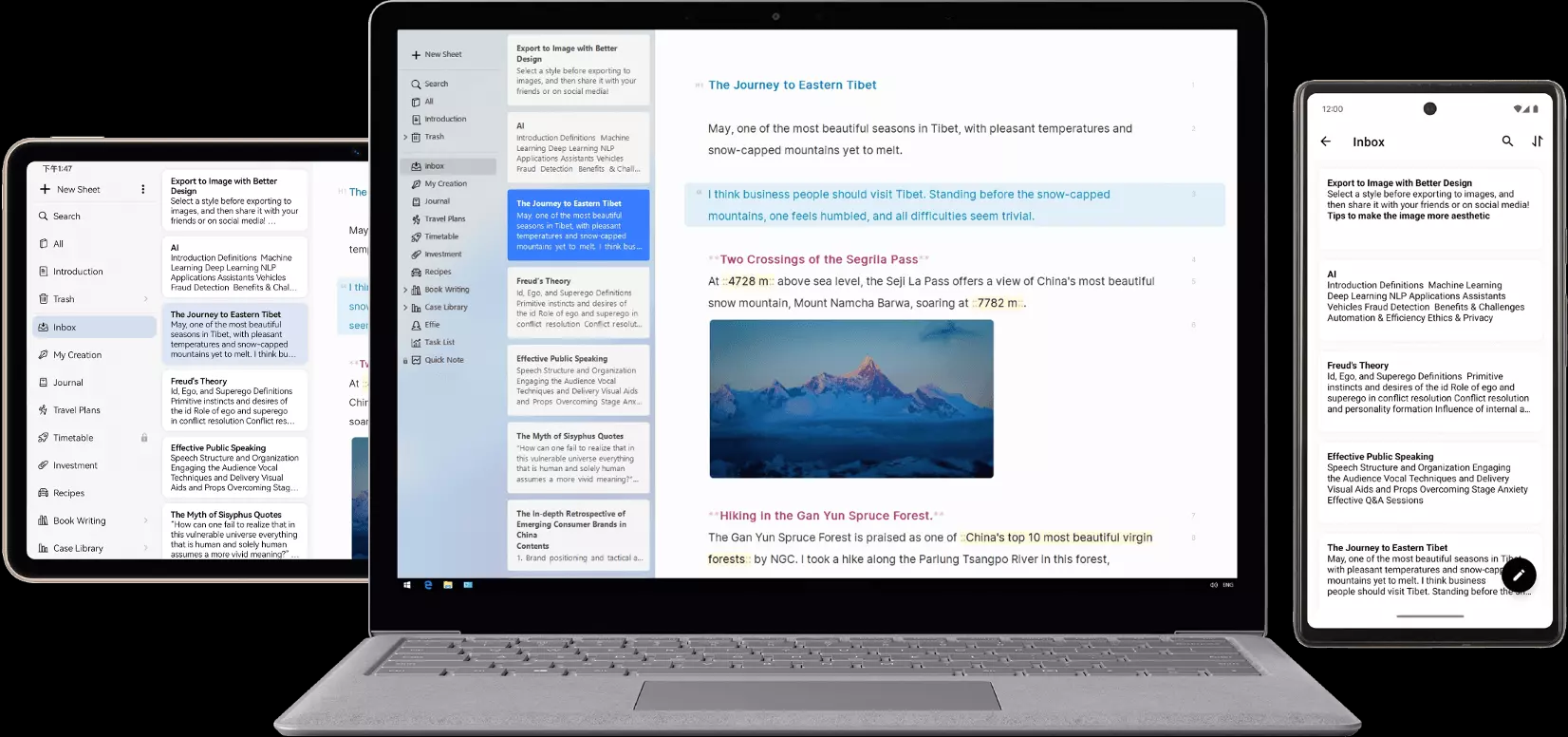

Qwen2.5-Coder 🤝 Артефакты

Artifacts - одно из самых важных приложений для генерации кода, которое помогает пользователям создавать что-то подходящее для визуализации, и мы выбрали Откройте WebUI Изучите возможности Qwen2.5-Coder в сценариях с артефактами, вот несколько конкретных примеров:

Скоро мы запустим режим кода на официальном сайте Tongyi https://tongyi.aliyun.com, который поддерживает всевозможные приложения для визуализации, такие как сайты, созданные из одного предложения, мини-игры и графики данных. Приглашаем вас испытать это!

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...