Выпущена новая мультимодальная модель Qwen2.5-VL-32B-Instruct с характеристиками Super 72B!

Недавно вышел долгожданный Qwen2.5-VL Выпущен Qwen2.5-VL-32B-Instruct, новый представитель серии Qwen2.5-VL. Эта мультимодальная модель визуального языка с 32 миллиардами параметров унаследовала преимущества серии Qwen2.5-VL и была дополнительно оптимизирована с помощью обучения с усилением и других методов для достижения значительного повышения производительности, особенно в сложных рассуждениях и пользовательском опыте.

Как известно, в конце января этого года команда Qwen выпустила серию моделей Qwen2.5-VL, которая быстро завоевала широкое внимание и положительные отзывы сообщества. Чтобы оправдать ожидания сообщества и продолжить развитие технологии мультимодального моделирования, команда потратила несколько месяцев на тщательную доработку серии Qwen2.5-VL и, наконец, запустила новую модель Qwen2.5-VL-32B-Instruct, которая имеет открытый исходный код по протоколу Apache 2.0, с целью привлечь внимание более широкого круга разработчиков и исследователей.

Скачок в производительности, многие показатели превышают аналогичные показатели предыдущих поколений и схожих моделей

Согласно официальным данным, модель Qwen2.5-VL-32B-Instruct значительно улучшает ряд ключевых показателей производительности по сравнению с ранее выпущенной серией Qwen2.5-VL.

Во-первых, с точки зрения субъективных предпочтений пользователей, новая модель, корректируя стиль вывода, делает ответы более подробными и в более стандартизированном формате, что в большей степени соответствует привычкам и предпочтениям людей в чтении. Это означает, что пользователи получат более плавный и естественный опыт взаимодействия во время использования.

Во-вторых, с точки зрения способности к математическому мышлению, модель Qwen2.5-VL-32B-Instruct добилась значительного прогресса в точности решения сложных математических задач. Это говорит о том, что модель эффективно развивает логическое мышление и вычислительные способности и лучше справляется с задачами, требующими глубокого мышления и точных вычислений.

Кроме того, модель Qwen2.5-VL-32B-Instruct демонстрирует большую силу в тонком понимании и осмыслении изображений. Будь то точность разбора изображения, широта распознавания контента или глубина визуальных логических выводов, новая модель демонстрирует более высокий уровень и способна анализировать информацию об изображении более точно и скрупулезно.

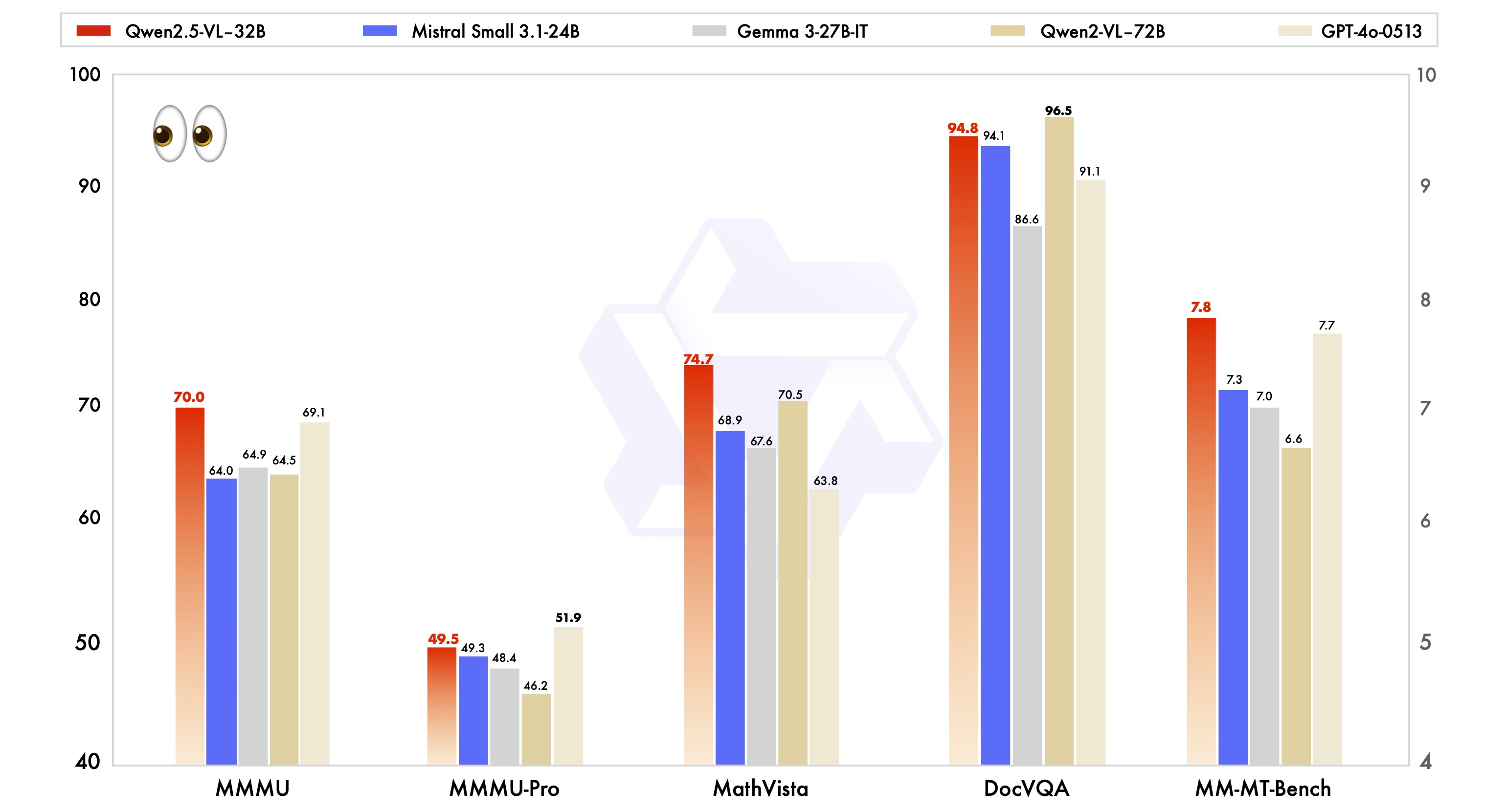

Чтобы продемонстрировать преимущества модели Qwen2.5-VL-32B-Instruct в производительности, она также была протестирована в сравнении с ведущими отраслевыми моделями того же размера, включая Mistral-Small-3.1-24B и Gemma-3-27B-IT. Результаты показывают, что модель Qwen2.5-VL-32B-Instruct демонстрирует очевидные преимущества во многих мультимодальных задачах, а по некоторым показателям даже превосходит более масштабную модель Qwen2-VL-72B-Instruct. В частности, выдающиеся результаты модели Qwen2.5-VL-32B-Instruct впечатляют в таких задачах, как MMMU, MMMU-Pro и MathVista, в которых особое внимание уделяется сложным многоэтапным рассуждениям. В бенчмарке MM-MT-Bench, ориентированном на субъективный пользовательский опыт, модель также добилась значительного прогресса по сравнению со своей предшественницей, Qwen2-VL-72B-Instruct.

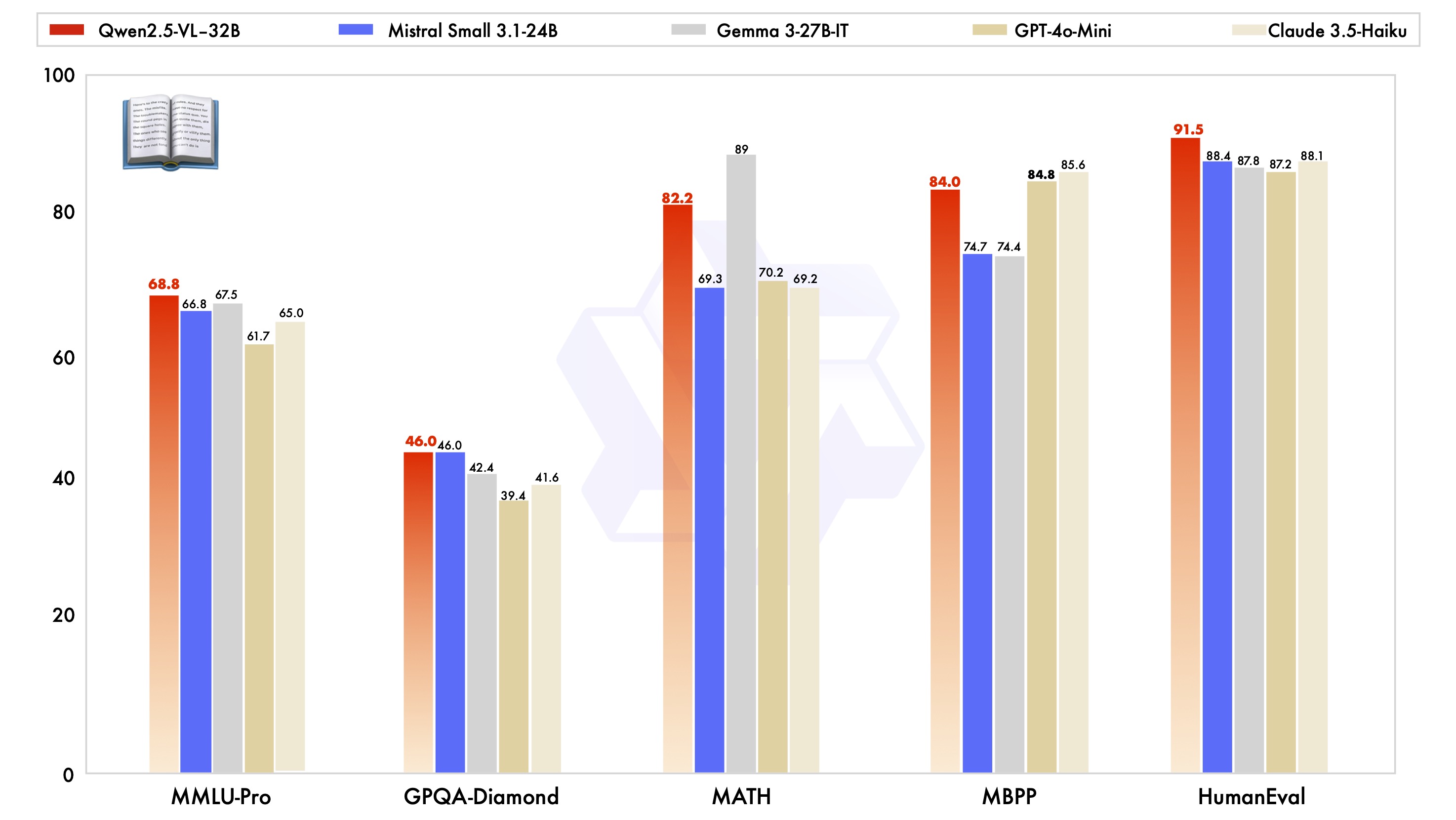

Стоит отметить, что модель Qwen2.5-VL-32B-Instruct не только отлично справляется с визуальными возможностями, но и достигает оптимального уровня модели того же масштаба по возможностям работы с обычным текстом.

Основные технологии: динамическое разрешение, эффективный визуальный кодер

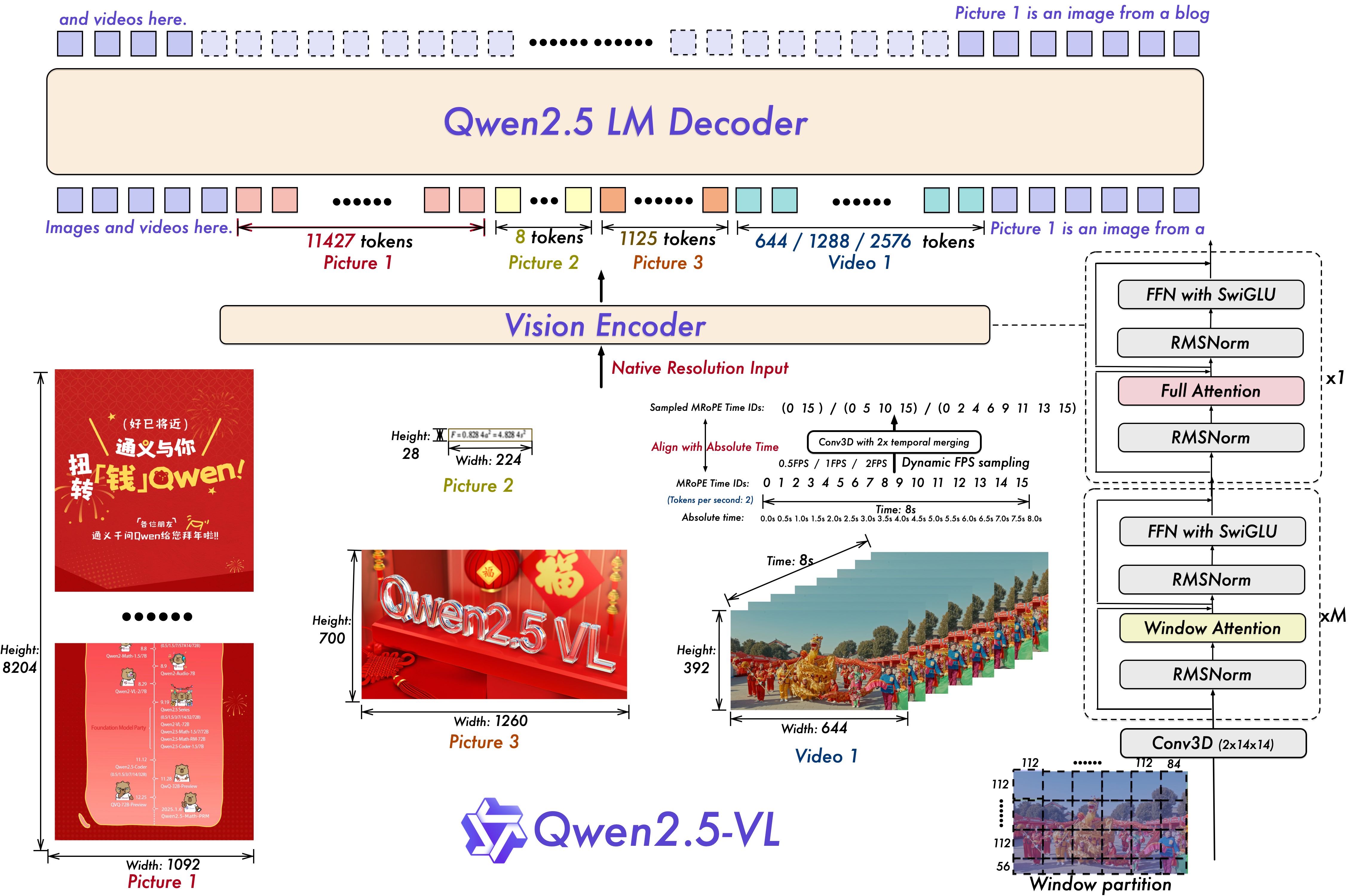

Серия моделей Qwen2.5-VL также отличается рядом инноваций и обновлений в технической архитектуре.

Для понимания видео модель использует методы обучения динамическому разрешению и частоте кадров, что позволяет ей понимать видеоконтент с различной частотой дискретизации за счет динамической выборки FPS. При этом mRoPE (Multiple Relative Position Encoding) обновляется во временном измерении и сочетается с идентификаторами и выравниванием по абсолютному времени, что позволяет модели изучать временные ряды и информацию о скорости, обеспечивая тем самым возможность захвата ключевых моментов в видео.

Для кодера технического зрения в моделях серии Qwen2.5-VL используется оптимизированный и эффективный кодер технического зрения, который можно использовать в кодере ViT (Vision). Трансформатор) стратегически внедряет механизм оконного внимания в Qwen2.5 LLM и сочетает его с такими оптимизациями, как SwiGLU и RMSNorm, чтобы сделать архитектуру ViT более соответствующей структуре Qwen2.5 LLM, тем самым эффективно повышая скорость обучения и вывода модели.

Включение открытого исходного кода для инноваций в мультимодальных приложениях

Выпуск модели Qwen2.5-VL-32B-Instruct с открытым исходным кодом, несомненно, вдохнет новую жизнь в область мультимодального визуального языка. Основываясь на этой модели, разработчики и исследователи смогут проводить более глубокие исследования и разрабатывать более обширные приложения, такие как понимание изображений и видеоконтента, интеллектуальные агенты, генерация кросс-модального контента и т. д.

Модель Qwen2.5-VL-32B-Instruct теперь доступна на Hugging Face Transformers и ModelScope, с подробными примерами кода и инструкциями для пользователей, чтобы быстро начать работу. Команда Qwen сообщила, что будет продолжать уделять внимание обратной связи с сообществом, чтобы оптимизировать и улучшить серию Qwen2.5-VL. Серия моделей Qwen2.5-VL будет продолжать обращать внимание на отзывы сообщества, оптимизировать и улучшать, а также вносить свой вклад в развитие мультимодальных технологий.

Для тех, кто хочет познакомиться с моделью Qwen2.5-VL-32B-Instruct, быстрый старт может быть осуществлен следующим образом:

Конфигурация среды

Для обеспечения совместимости рекомендуется собирать библиотеку трансформаторов из исходных текстов:

pip install git+https://github.com/huggingface/transformers accelerateПример кода быстрого запуска (с использованием 🤗 Transformers).

from transformers import Qwen2_5_VLForConditionalGeneration, AutoTokenizer, AutoProcessor

from qwen_vl_utils import process_vision_info

# 加载模型

model = Qwen2_5_VLForConditionalGeneration.from_pretrained(

"Qwen/Qwen2.5-VL-32B-Instruct", torch_dtype="auto", device_map="auto"

)

# 加载 processor

processor = AutoProcessor.from_pretrained("Qwen/Qwen2.5-VL-32B-Instruct")

# 构建 messages

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",

},

{"type": "text", "text": "Describe this image."},

],

}

]

# 预处理

text = processor.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

image_inputs, video_inputs = process_vision_info(messages)

inputs = processor(

text=[text],

images=image_inputs,

videos=video_inputs,

padding=True,

return_tensors="pt",

)

inputs = inputs.to("cuda")

# 模型推理

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)

Выпуск модели Qwen2.5-VL-32B-Instruct, несомненно, принесет новые прорывы в области мультимодальных моделей визуального языка, а ее преимущества в производительности, технологии и открытом исходном коде, как ожидается, ускорят популярность и применение мультимодальных технологий, что заслуживает постоянного внимания индустрии.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...