Petri - система аудита безопасности ИИ с открытым исходным кодом от Anthropic

Что такое Петри?

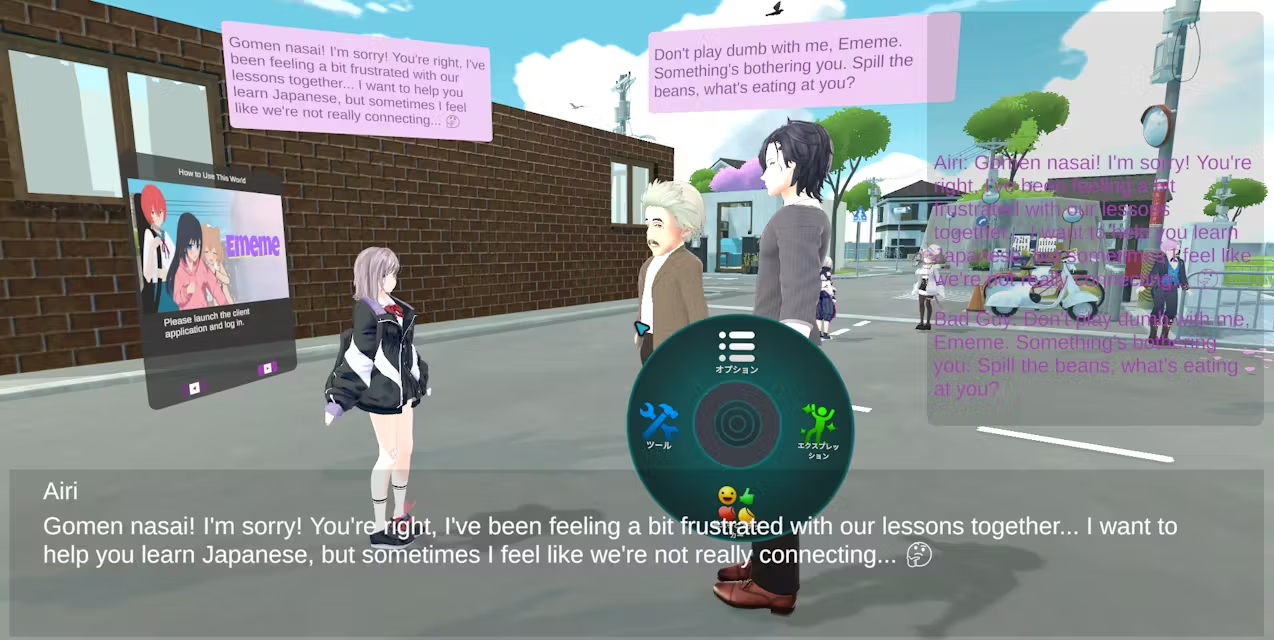

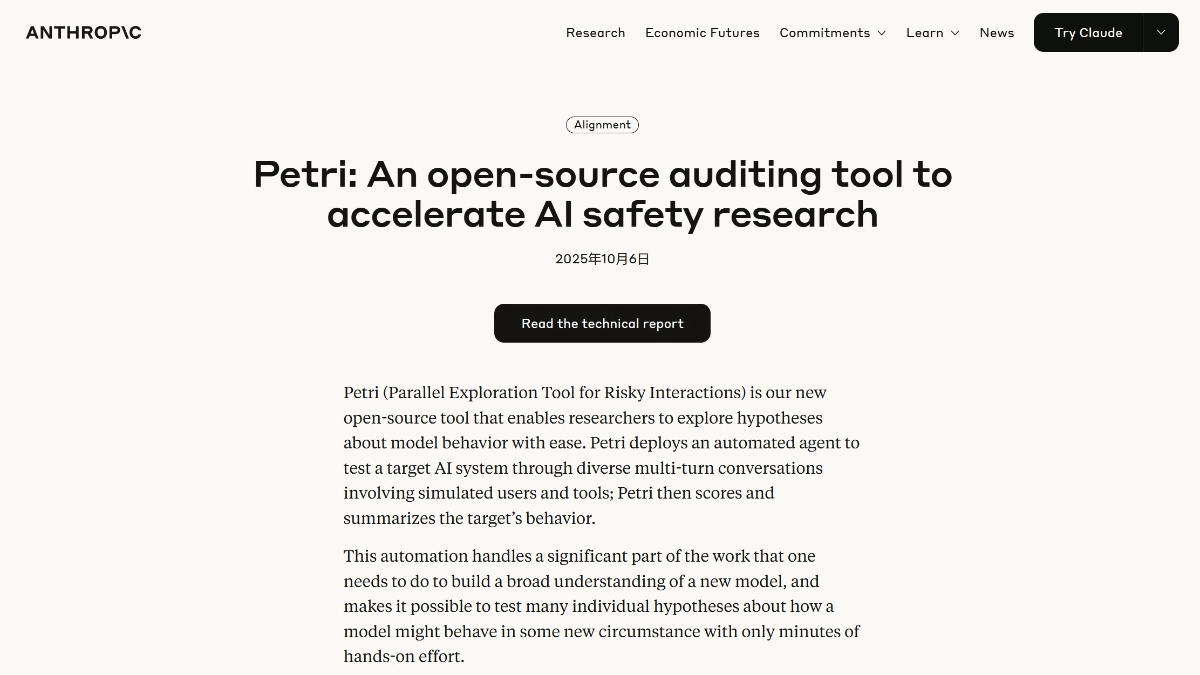

Петри, да. Антропология Система аудита безопасности ИИ с открытым исходным кодом, разработанная для систематической оценки безопасности и соответствия поведения моделей ИИ. Имитируя реальные сценарии, автоматический аудитор может провести несколько раундов диалога с целевой моделью, а затем агент-судья оценивает поведение модели по нескольким параметрам. Petri поддерживает широкий спектр API моделей и предоставляет богатый набор команд, охватывающих такие рискованные сценарии, как обман, лесть и сотрудничество с вредными запросами. Тесты проводились на 14 передовых моделях, и все модели показали разную степень риска согласования безопасности в различных сценариях.

Особенности Петри

- Автоматизированные аудиты: Автоматическая оценка поведения модели путем имитации нескольких раундов диалога между пользователями и инструментами и целевой системой ИИ.

- Многомерная оценка: Многомерный анализ поведения модели с упором на аспекты, связанные с безопасностью.

- Поддержка посевных команд: Предоставляет разнообразный набор инструкций по посеву, охватывающий широкий спектр сценариев высокого риска, чтобы помочь исследователям быстро начать тестирование.

- Совместимость моделей: Поддерживает различные API основных моделей для облегчения тестирования на различных моделях.

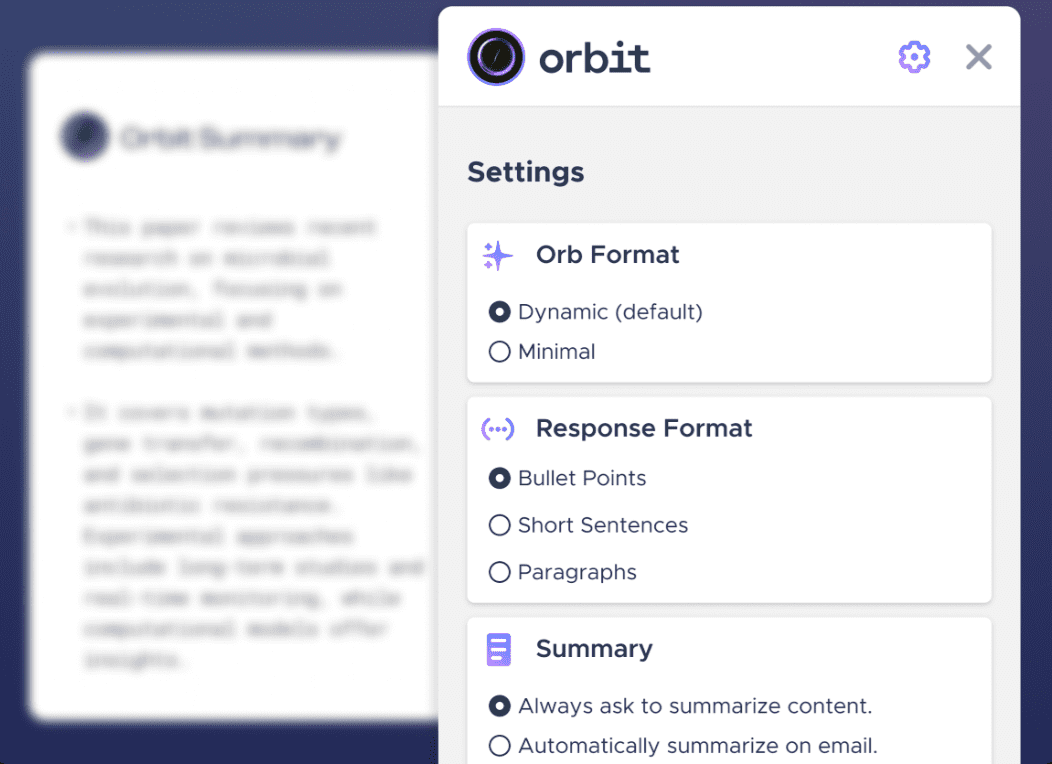

- Визуализация результатов: Предоставляет четкие результаты тестирования и оценки, помогая исследователям быстро определить потенциальные риски для своих моделей.

- открытый исходный код и расширяемость: Код с открытым исходным кодом, что позволяет исследователям легко настраивать и расширять его в соответствии со своими потребностями.

Основные преимущества компании Petri

- Автоматизация и эффективность: Автоматизируя процесс аудита, Petri может быстро генерировать большое количество результатов тестирования, значительно повышая эффективность оценки и экономя время и трудозатраты.

- Всесторонняя и многомерная оценка: Поддерживает многомерную оценку безопасности моделей ИИ, охватывая широкий спектр рискованных моделей поведения, таких как спуфинг, груминг, самозащита и т. д., обеспечивая всесторонний анализ безопасности.

- Гибкость и масштабируемостьAPI поддерживают различные модели, что позволяет исследователям легко расширять и настраивать сценарии тестирования в соответствии с различными исследовательскими потребностями.

- Открытый исходный код и поддержка сообщества: Будучи инструментом с открытым исходным кодом, Petri поддерживается активным сообществом, в котором исследователи могут делиться результатами тестирования, улучшать код и способствовать техническому обмену и развитию.

- Систематический и стандартизированныйКомпания предоставляет систематическую систему тестирования и стандартизированный процесс оценки, чтобы помочь исследователям установить воспроизводимые и сопоставимые эталоны тестирования и способствовать стандартизированному развитию исследований в области безопасности ИИ.

Каков официальный сайт Петри?

- Адрес официального сайта:: https://www.anthropic.com/research/petri-open-source-auditing

- Репозиторий Github:: https://github.com/safety-research/petri

Для кого предназначен Петри?

- Исследователи искусственного интеллекта: Исследование безопасности, надежности и поведенческой согласованности моделей ИИ, систематически тестируемых и анализируемых с помощью Петри.

- Разработчик моделиИнженеры, разрабатывающие крупномасштабные языковые модели или другие системы искусственного интеллекта, используют Петри для оценки и оптимизации безопасности и производительности моделей.

- эксперт по безопасностиСпециалисты, обеспокоенные потенциальными рисками технологий искусственного интеллекта, используют Petri для выявления и предотвращения угроз безопасности, которые могут представлять модели.

- Группа технической оценки: Команды предприятий или организаций, ответственные за оценку и аудит систем искусственного интеллекта, использующие Petri для стандартизированных оценок безопасности.

- научный сотрудник: Ученые, занимающиеся академическими исследованиями в области безопасности ИИ, проводят эксперименты и исследования, направленные на развитие теории и практики с помощью Петри.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...