Инвентаризация LLM-фреймворков, подобных Ollama: несколько вариантов для локального развертывания больших моделей

Появление фреймворка Ollama, безусловно, привлекло большое внимание в области искусственного интеллекта и больших языковых моделей (LLM). Этот фреймворк с открытым исходным кодом нацелен на упрощение развертывания и эксплуатации LLM на локальном уровне, что позволяет большему числу разработчиков ощутить привлекательность LLM. Однако, если посмотреть на рынок, Ollama не одинока, и существует множество других инструментов того же типа, которые в совокупности предоставляют разработчикам более разнообразный выбор. В этой статье мы подробно рассмотрим некоторые из инструментов, которые работают с Оллама Несколько подобных инструментов для построения крупных моделей, как мы надеемся, помогут читателям получить более полное представление об экосистеме технологий в этой области и найти наиболее подходящий для них инструмент.

Введение в систему Ollama Framework

Ollama предназначена для упрощения развертывания и эксплуатации больших языковых моделей (LLM) в локальных средах. Она поддерживает широкий спектр основных LLM, таких как Llama 2, Code Llama, Mistral, Gemma и т. д., и позволяет пользователям настраивать и создавать собственные модели в соответствии со своими потребностями. ChatGPT Чат-интерфейс позволяет пользователям напрямую взаимодействовать с моделью без дополнительной разработки. Кроме того, чистый код Ollama и низкое потребление ресурсов во время выполнения делают ее идеальной для работы на локальном компьютере.

Инструменты, похожие на Ollama

Введение в vLLM

vLLM Vectorised Large Language Model Serving System (VLLM) - это эффективный механизм вывода и обслуживания больших моделей, специально разработанный для LLM. vLLM значительно повышает производительность вывода LLM благодаря инновационной технологии PagedAttention, непрерывной пакетной обработке, оптимизации ядра CUDA и поддержке распределенного вывода. Производительность выводов.

особенности

vLLM vLLM поддерживает различные форматы моделей, включая PyTorch, TensorFlow и т. д., что позволяет пользователям гибко выбирать модели в соответствии со своими потребностями. В то же время vLLM имеет высокопроизводительный механизм вывода, поддерживающий онлайн и пакетный вывод, способный быстро реагировать на большое количество одновременных запросов и сохранять высокую производительность в сценариях с высокой нагрузкой.

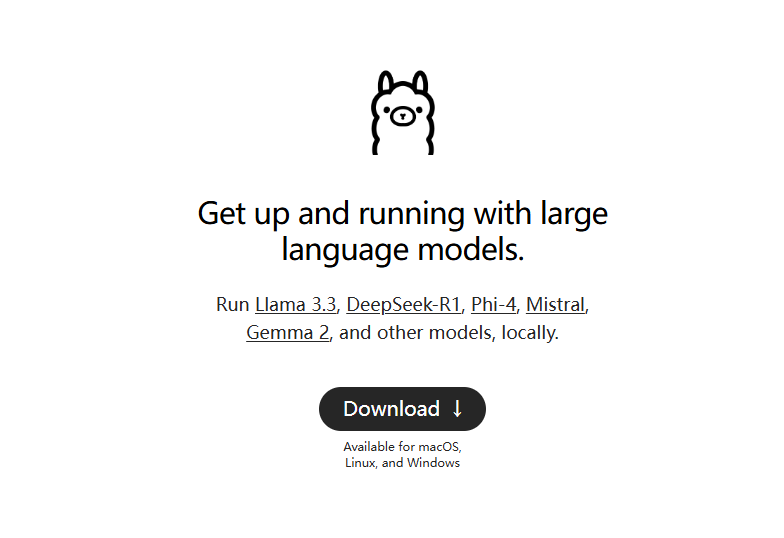

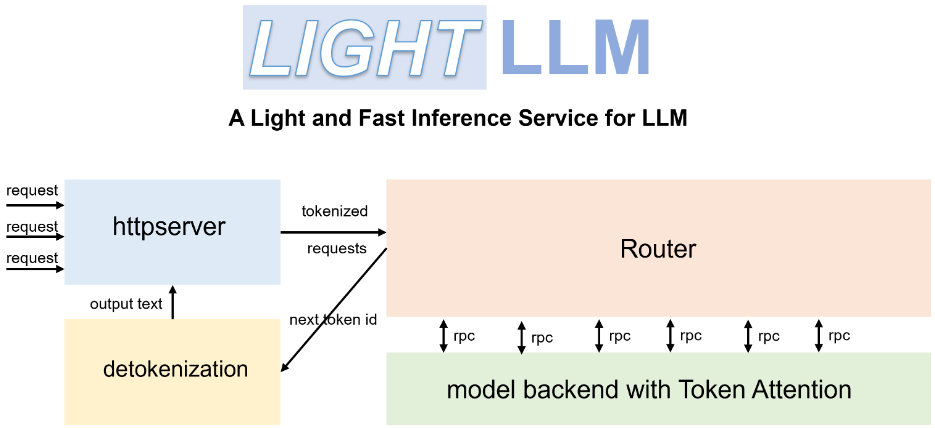

Введение в LightLLM

LightLLM это легкий высокопроизводительный фреймворк для рассуждений и сервисов LLM на базе Python. Он опирается на сильные стороны различных открытых реализаций, таких как FasterTransformer, TGI, vLLM и FlashAttention, и предоставляет пользователям новую модель LLM-сервисов.

особенности

LightLLM Уникальная трехпроцессная архитектура разделяет три основных этапа - токенизацию, вывод модели и детокенизацию - и выполняет их параллельно с помощью механизма асинхронного взаимодействия. Такая конструкция значительно повышает загрузку GPU и снижает задержки, связанные с передачей данных, эффективно повышая эффективность вычислений. Кроме того, LightLLM поддерживает операцию Nopad no-fill, которая позволяет более эффективно обрабатывать запросы с большой разницей в длине и избегать недействительного заполнения, тем самым повышая эффективность использования ресурсов.

Введение в llama.cpp

llama.cpp это движок для вычислений LLM, разработанный на языках C и C++. Он глубоко оптимизирован по производительности для кремниевых чипов Apple и способен эффективно запускать модель Llama 2 из Meta на устройствах Apple.

особенности

Основная цель llama.cpp - реализовать вывод LLM на широком спектре аппаратных платформ, обеспечивая высочайшую производительность при минимальной конфигурации. Для дальнейшего повышения производительности llama.cpp предоставляет различные варианты квантования, такие как 1,5-битное, 2-битное, 3-битное, 4-битное, 5-битное, 6-битное и 8-битное квантование целых чисел, предназначенные для ускорения вычислений и уменьшения занимаемой памяти. Кроме того, llama.cpp поддерживает смешанные вычисления на CPU/GPU, что еще больше повышает гибкость и эффективность вычислений.

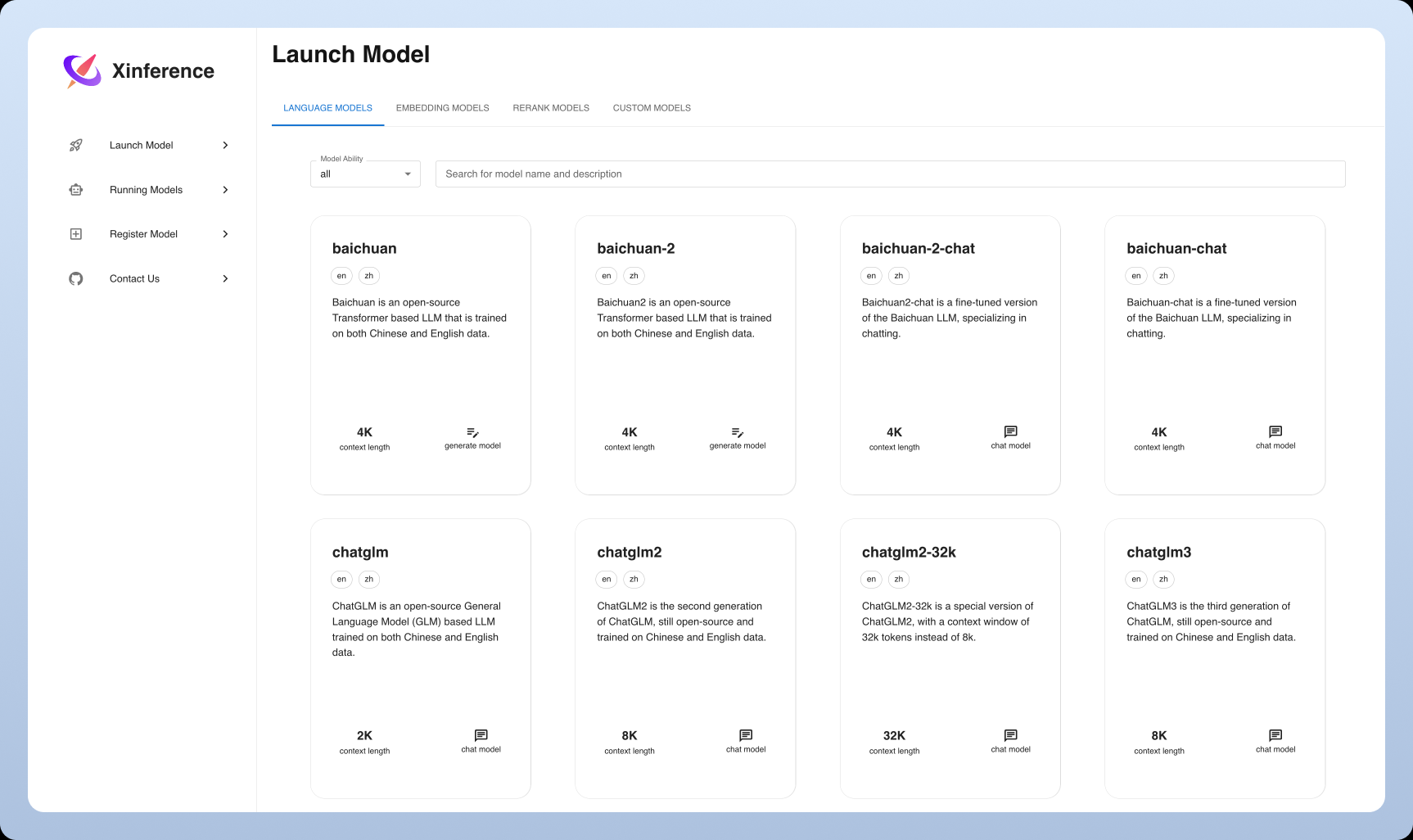

Введение в Xinference

Xinference это развивающийся фреймворк для выводов общего назначения, который поддерживает не только LLM, но и модели в различных модальностях, включая изображения и речь. Его цель - снизить порог развертывания и использования моделей, обеспечить унифицированный интерфейс и дружелюбный пользовательский опыт.

особенности

Xinference Изюминкой Xinference является широкая поддержка мультимодальных моделей, которая позволяет пользователям легко развертывать и использовать различные типы моделей на одной платформе. В то же время Xinference уделяет особое внимание простоте использования, предоставляя различные методы взаимодействия, такие как веб-интерфейс, клиент Python и т. д., а также поддерживая унифицированное управление и гибкое расширение моделей.

Сравнение и анализ инструментов

Установка и развертывание

Оллама. Процесс установки очень прост, Ollama предоставляет четкое и краткое руководство по установке и поддерживает многие основные операционные системы. Пользователи могут легко запустить большую языковую модель, выполнив всего несколько простых операций в командной строке.

vLLM. В отличие от этого, установка vLLM немного сложнее, требуя от пользователязаранееНастройка среды Python и установка набора зависимых библиотек. Однако после развертывания эффективная работа vLLM с выводами даст пользователям значительный прирост, особенно в сценариях, критичных к производительности.

LightLLM. Процесс установки LightLLM относительно прост, а подробные руководства по установке и настройке помогут пользователям быстро приступить к работе. Пользователи могут гибко выбирать подходящий формат модели для развертывания в соответствии со своими потребностями.

llama.cpp. Установка llama.cpp требует определенного уровня технических знаний, и пользователю необходимо иметьбезвременноНастроить среду разработки C++. Однако для энтузиастов технологий и разработчиков после настройки высокопроизводительный механизм вывода llama.cpp обеспечивает максимальный пользовательский опыт с глубоким контролем над каждым аспектом вывода модели.

Ксинференция. Xinference также относительно легко установить и развернуть, предоставляя образы Docker и пакеты Python для быстрой настройки окружения. В то же время Xinference предоставляет обширный интерфейс Web UI, что снижает порог использования.

Поддержка и совместимость моделей

Оллама. В плане поддержки моделей Ollama демонстрирует хорошую открытость, поддерживая широкий спектр моделей с открытым исходным кодом, включая Llama 2, Code Llama и т. д., и позволяя пользователям загружать собственные модели. Кроме того, Ollama предоставляет библиотеку готовых моделей, чтобы пользователи могли быстро начать работу с различными моделями.

vLLM. vLLM отличается совместимостью форматов моделей, поддерживая PyTorch, TensorFlow и многие другие основные форматы моделей.работоспособный Пользователь получает максимально гибкий выбор модели. Стоит отметить, что vLLM также поддерживает распределенный вывод, который может полностью использовать арифметическую мощь нескольких GPU для параллельного запуска моделей, что еще больше повышает эффективность вывода.

LightLLM. LightLLM также обладает отличной совместимостью с форматами моделей, поддерживая множество широко используемых форматов моделей. В то же время LightLLM предоставляет богатые API и инструменты для глубокой настройки и удовлетворения потребностей широкого круга пользователей.специальныйНеобходимость в сценариях применения.

llama.cpp. llama.cpp ориентирован на оптимизацию модели Llama для экстремальных выводов, но также поддерживает и другие модели. Эффективный механизм вывода позволяет llama.cpp сохранять отличную производительность при работе с большими наборами данных.

Ксинференция. Одной из главных особенностей Xinference является поддержка моделей, которая поддерживает не только различные LLM, но и модели генерации изображений, такие как Stable Diffusion и Шепот и других речевых моделей, демонстрируя сильную совместимость мультимодальных моделей и предоставляя пользователям более широкое пространство для применения.

Производительность и оптимизация

Оллама. Ollama известна своим чистым API и эффективной работой с выводами, но в сценариях с большим количеством одновременных запросов могут возникать проблемы с производительностью. Тем не менее, Ollama - это хороший выбор для пользователей, стремящихся к простоте использования и быстрому развертыванию.

vLLM. vLLM создан для экстремальной производительности. Он значительно повышает производительность рассуждений LLM благодаря таким техникам, как PagedAttention, особенно при работе с большим количеством одновременных запросов, и способен удовлетворить сценарии приложений с жесткими требованиями к производительности сервиса.

LightLLM. LightLLM также уделяет много внимания оптимизации производительности. Благодаря уникальной трехпроцессной архитектуре и механизму асинхронного взаимодействия LightLLM эффективно повышает загрузку GPU и скорость вычислений. Кроме того, LightLLM поддерживает операцию Nopad no-fill, что еще больше повышает эффективность использования ресурсов. Вносит вклад в общую производительность.

llama.cpp. llama.cpp также отличается высокой производительностью. Он не только обладает эффективным механизмом вывода, но и предлагает множество вариантов квантования, что позволяет гибко выбирать между скоростью вывода и занимаемой памятью.равновесиеКроме того, llama.cpp поддерживает смешанные рассуждения CPU/GPU. Более того, llama.cpp также поддерживает смешанные умозаключения CPU/GPU, что еще больше повышает гибкость и эффективность умозаключений, позволяя пользователям выполнятьлучший (спортсмен, фильм и т.д.)Конфигурация.

Ксинференция. Xinference также оптимизирован с точки зрения производительности, поддерживая такие методы, как квантование и обрезка моделей для повышения эффективности выводов и снижения потребления ресурсов. Кроме того, Xinference итеративно оптимизируется для повышения производительности мультимодального вывода моделей.

Резюме и перспективы

Инструменты, подобные Ollama, имеют свои особенности и преимущества, и пользователи могут выбрать подходящий фреймворк в зависимости от сценариев применения и реальных потребностей. Благодаря постоянному развитию искусственного интеллекта и технологий масштабного языкового моделирования, эти инструменты будут продолжать совершенствоваться и модернизироваться, предлагая пользователям более эффективные и удобные решения. В будущем эти инструменты будут играть все большую роль в обработке естественного языка, интеллектуальном обслуживании клиентов, создании текстов и других областях, способствуя дальнейшему развитию и применению технологии искусственного интеллекта, и в конечном итогереализуйте Прекрасное видение искусственного интеллекта для всех.

Рекомендации и предложения

Ollama может стать хорошим выбором для начинающих и индивидуальных пользователей. Ollama предоставляет простой API и дружественный пользовательский интерфейс, что позволяет пользователям напрямую взаимодействовать с моделями без дополнительной разработки. Более того, Ollama поддерживает широкий спектр моделей с открытым исходным кодом, что позволяет пользователям быстро начать работу и опробовать различные сценарии применения, а также быстро ощутить удовольствие от развертывания LLM локально.

Для бизнес-пользователей, которым необходимо обрабатывать высокопоточные запросы, vLLM может оказаться лучшим выбором. Эффективная производительность рассуждений и поддержка распределенных рассуждений в vLLM могут удовлетворить требования сценариев с высокой интенсивностью запросов и предоставить пользователям более стабильное и надежное решение для обеспечения непрерывности бизнеса.Стабильность и непрерывность.

LightLLM и llama.cpp больше подходят для пользователей с определенной технической базой для индивидуальной разработки и глубокой оптимизации. Эти два инструмента предоставляют разработчикам большую гибкость и больший контроль над базовыми допустимо Пользователь несет ответственность заспецификация Создавайте более персонализированные и высокопроизводительные приложения для LLM.

Xinference - это также вариант для тех, кто хочет поэкспериментировать с мультимодальными моделями и ищет нестандартный опыт. Xinference снижает барьеры для использования мультимодальных моделей, позволяя пользователям испытать возможности широкого спектра моделей ИИ на одной платформе.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...