Open WebUI: локально размещаемый веб-интерфейс чата ИИ

Общее введение

Open WebUI (ранее известный как Ollama WebUI) - это дружественный интерактивный пользовательский интерфейс AI, разработанный для LLM (Large Language Models). Он масштабируемый, многофункциональный и работает полностью в автономном режиме. Выдающиеся особенности Open WebUI включают в себя болтливый дизайн интерфейса, высокую отзывчивость, легкую настройку с помощью Docker или Kubernetes, подсветку кода, поддержку Markdown и LaTeX, локальную и удаленную интеграцию RAG, функцию голосового/видеовызова, интеграцию генерации изображений и многое другое! и многое другое.

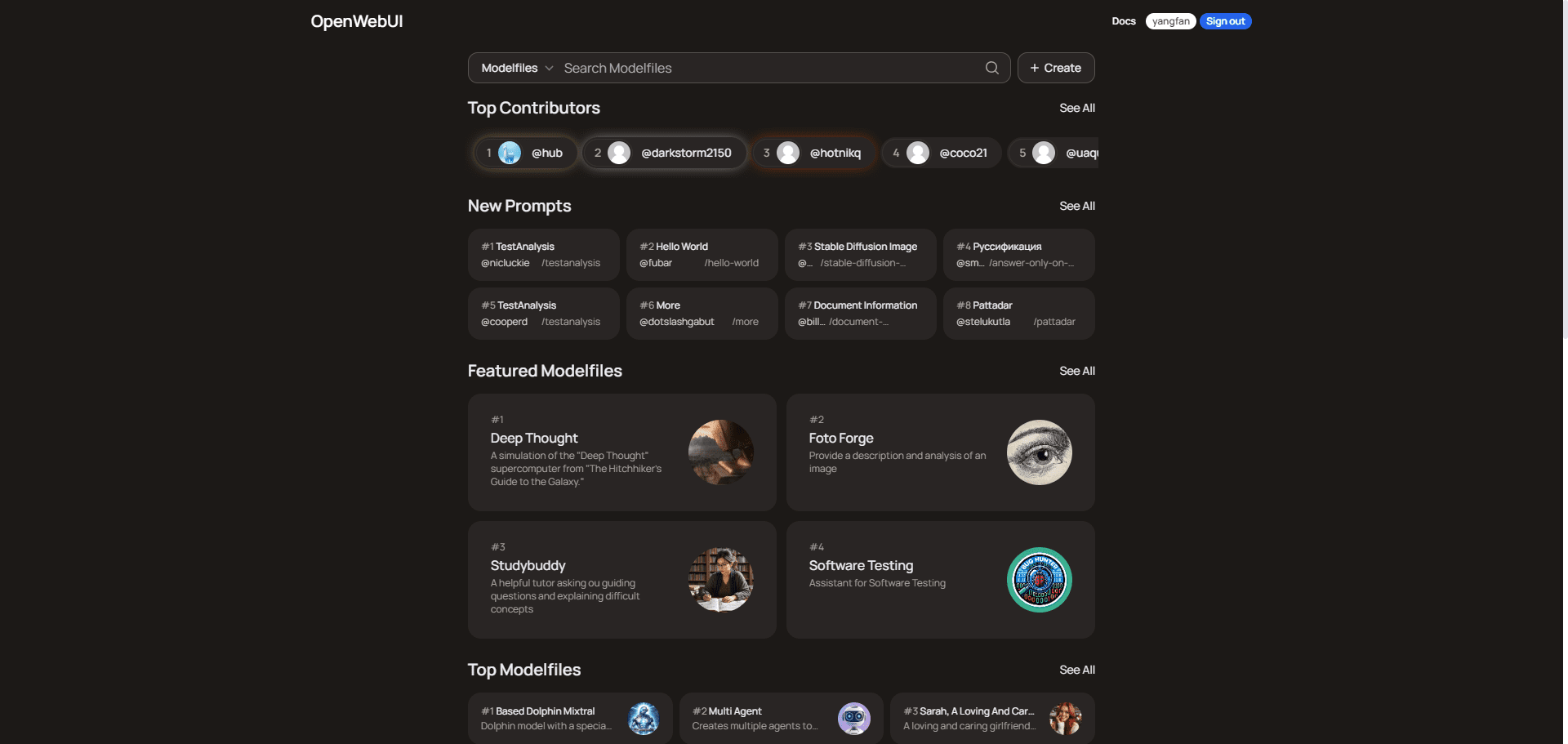

Об OpenWebUI:

OpenWebUI - это платформа для сообщества пользователей, которая предоставляет многоцелевые файлы моделей для программирования, письма, производительности, образования, бизнеса и анализа данных. Пользователи могут изучать и загружать эти файлы моделей для повышения эффективности своих задач и проектов. Платформа насчитывает более 15 000 пользователей и основана на рейтингах участников и общих журналах смарт-чата для общения и обучения.

О методе бесплатного развертывания облака см. Развертывание персонализированного набора миниатюрных инструментов для общения на низкопрофильных компьютерах Ниже приводится описание развертывания Open WebUI в компании Koyeb.

Список функций

- Бесшовная установка: Простая установка через Docker или Kubernetes, с поддержкой Ollama и образов с метками CUDA.

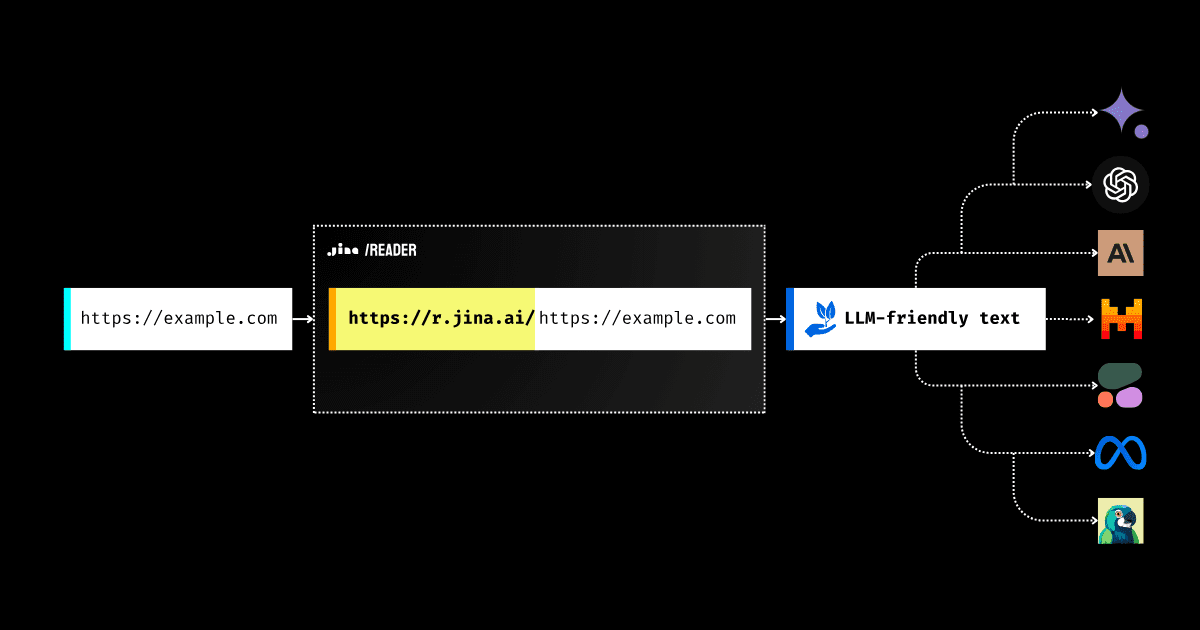

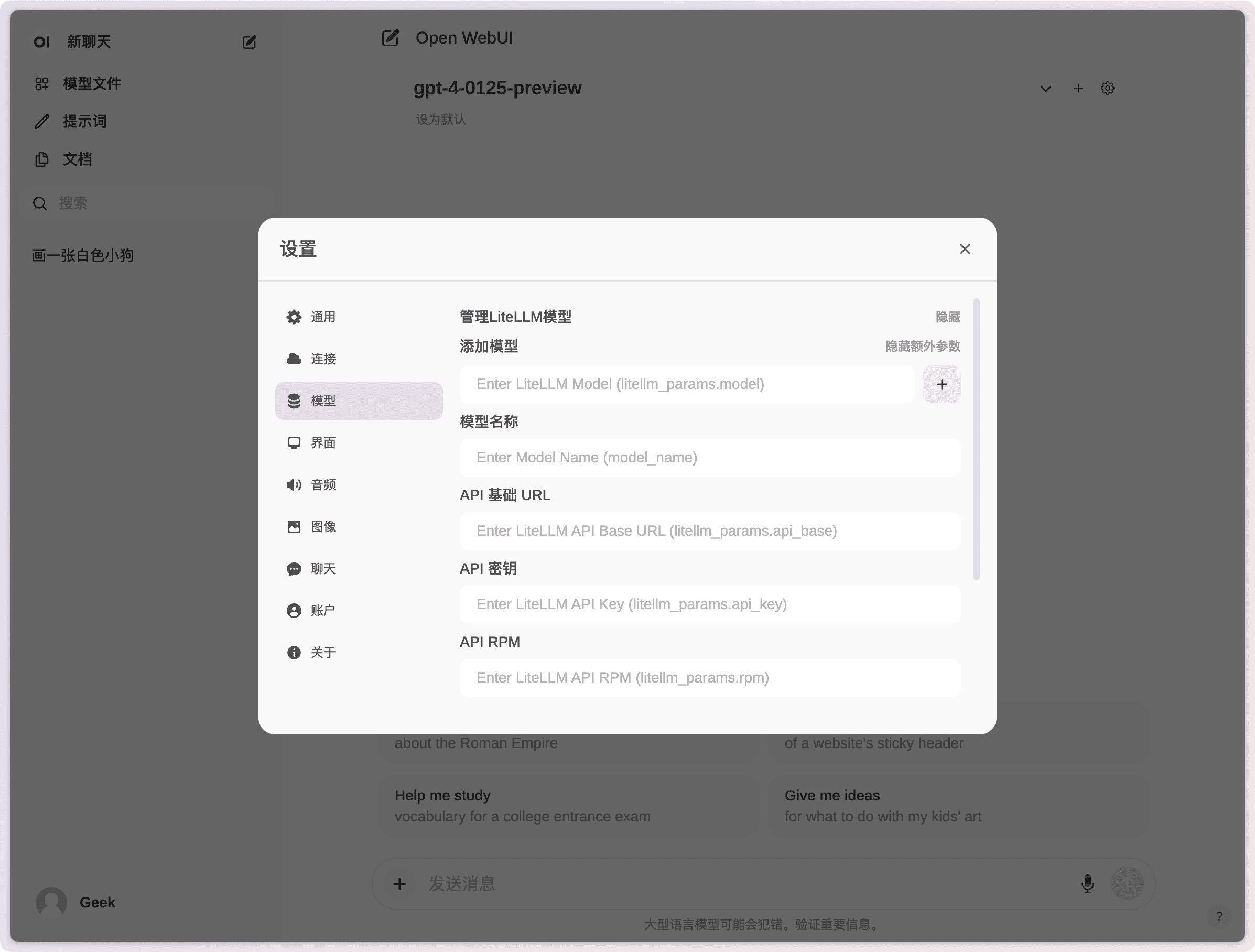

- Интеграция API: Легкая интеграция с OpenAI-совместимыми API и поддержка нескольких моделей диалогов.

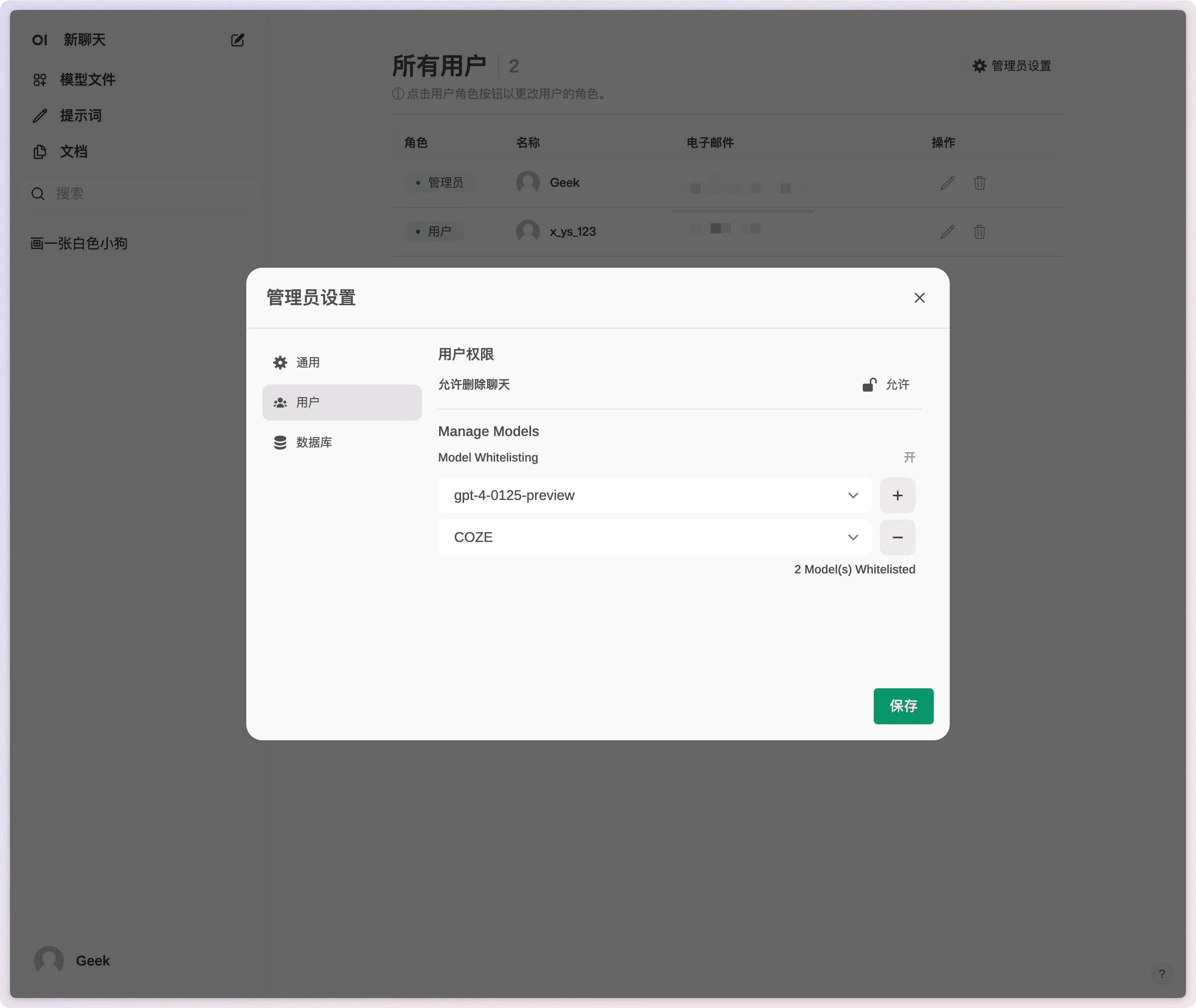

- Тонкие разрешения и группы пользователей: Администраторы могут создавать подробные роли и разрешения для пользователей, чтобы обеспечить безопасность среды.

- отзывчивый дизайн: Наслаждайтесь бесперебойной работой на настольных компьютерах, ноутбуках и мобильных устройствах.

- Прогрессивные веб-приложения (PWA): Обеспечьте работу с нативными приложениями на мобильных устройствах с поддержкой автономного доступа.

- Поддержка Markdown и LaTeX: Обеспечьте всестороннюю функциональность Markdown и LaTeX для улучшения интерактивного опыта.

- Голосовые/видеозвонки: Интеграция громкой голосовой связи и видеозвонков для более динамичного общения.

- конструктор моделей: Легкое создание моделей Ollama и добавление пользовательских ролей/агентов через веб-интерфейс.

- Местная интеграция RAG: Поддержка технологии Retrieval Augmented Generation (RAG), позволяющей легко интегрировать взаимодействие с документами в чат.

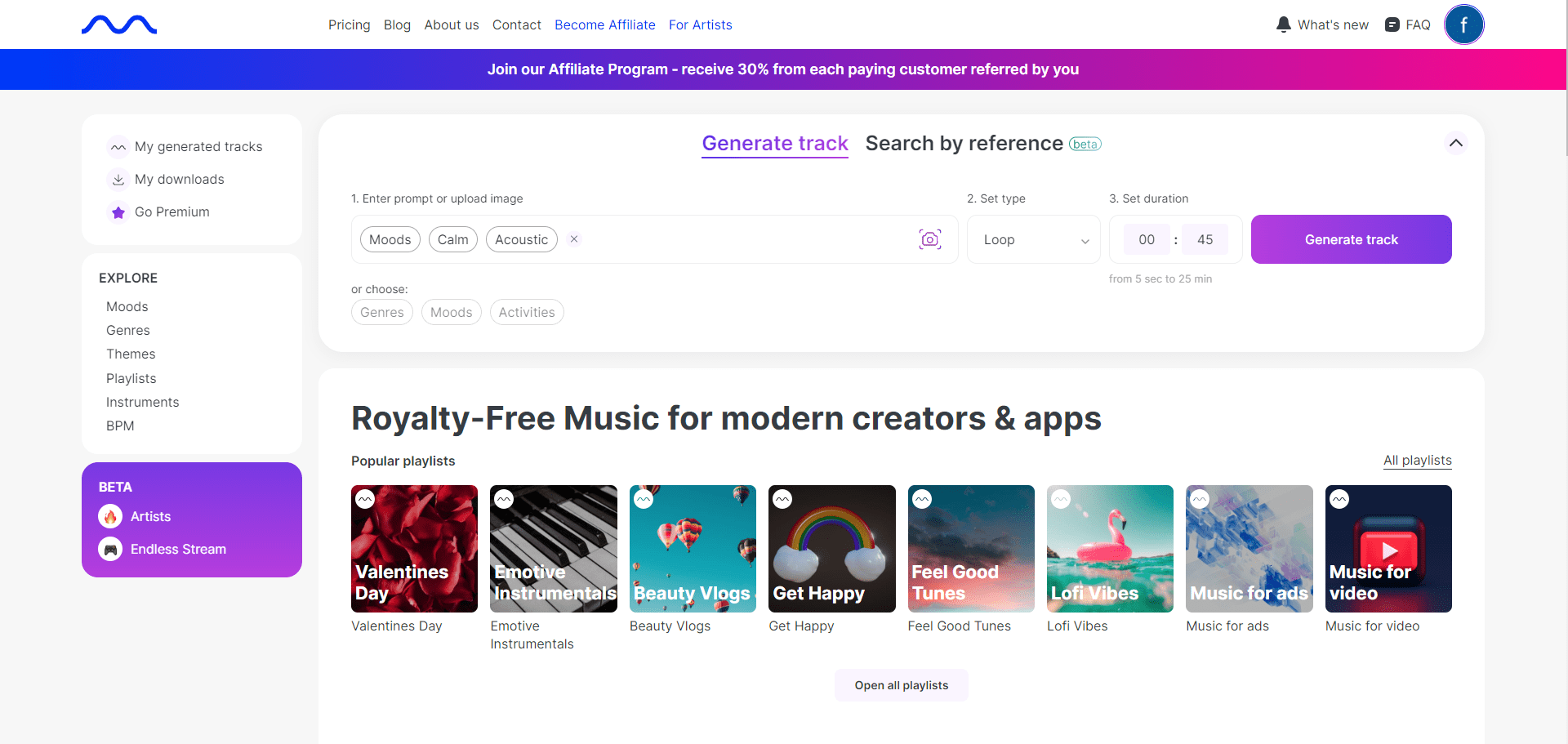

- Интеграция генерации изображений: Поддержка API AUTOMATIC1111, ComfyUI и OpenAI's DALL-E для обогащения опыта общения.

- многомодельный диалог: Взаимодействует с несколькими моделями одновременно, используя их уникальные преимущества для обеспечения наилучшего ответа.

- Управление доступом на основе ролей (RBAC): Обеспечьте безопасный доступ, чтобы только авторизованный персонал имел доступ к Ollama и разрешения на создание/подбор моделей.

- Поддержка нескольких языков: Предусмотрена поддержка интернационализации, чтобы пользователи могли выбрать предпочтительный язык.

- Поддержка плагинов: Бесшовная интеграция пользовательской логики и библиотек Python с помощью фреймворка плагинов Pipelines.

Использование помощи

Процесс установки

Установка с помощью Docker

- Вытягивание зеркал: Выполните следующую команду в терминале, чтобы извлечь последний образ Open WebUI Docker из реестра контейнеров GitHub:

docker pull ghcr.io/open-webui/open-webui:main - Запуск контейнеров: Запустите контейнер с настройками по умолчанию, чтобы обеспечить постоянное хранение данных:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main- отображение объёмов: Обеспечьте постоянное хранение данных, чтобы предотвратить их потерю при перезапуске контейнера.

- отображение портов: Открыть WebUI для порта 3000 на локальной машине.

Установка с помощью Python

- Установка Open WebUI: Убедитесь, что используете Python 3.11, чтобы избежать проблем с совместимостью. Выполните следующую команду в терминале:

pip install open-webui - Запуск Open WebUI: После завершения установки выполните следующую команду, чтобы запустить Open WebUI:

open-webui serveЭто запустит сервер Open WebUI, который вы можете найти по адресу http://localhost:8080访问.

Руководство по эксплуатации функций

Голосовые/видеозвонки

- инициировать звонок: Нажмите кнопку голосового или видеовызова на экране чата, чтобы выбрать контакт и начать вызов.

- управление вызовами: Во время разговора вы можете использовать кнопки управления на интерфейсе, чтобы отключить звук и повесить трубку.

Генерация изображений

- Выберите инструмент Генератор изображений: Выберите API AUTOMATIC1111, ComfyUI или OpenAI's DALL-E на экране чата.

- Описание ввода: Введите описание изображения в поле ввода и нажмите кнопку Generate.

- Посмотреть результаты: Созданное изображение будет отображаться в чате и может быть сохранено или передано пользователю.

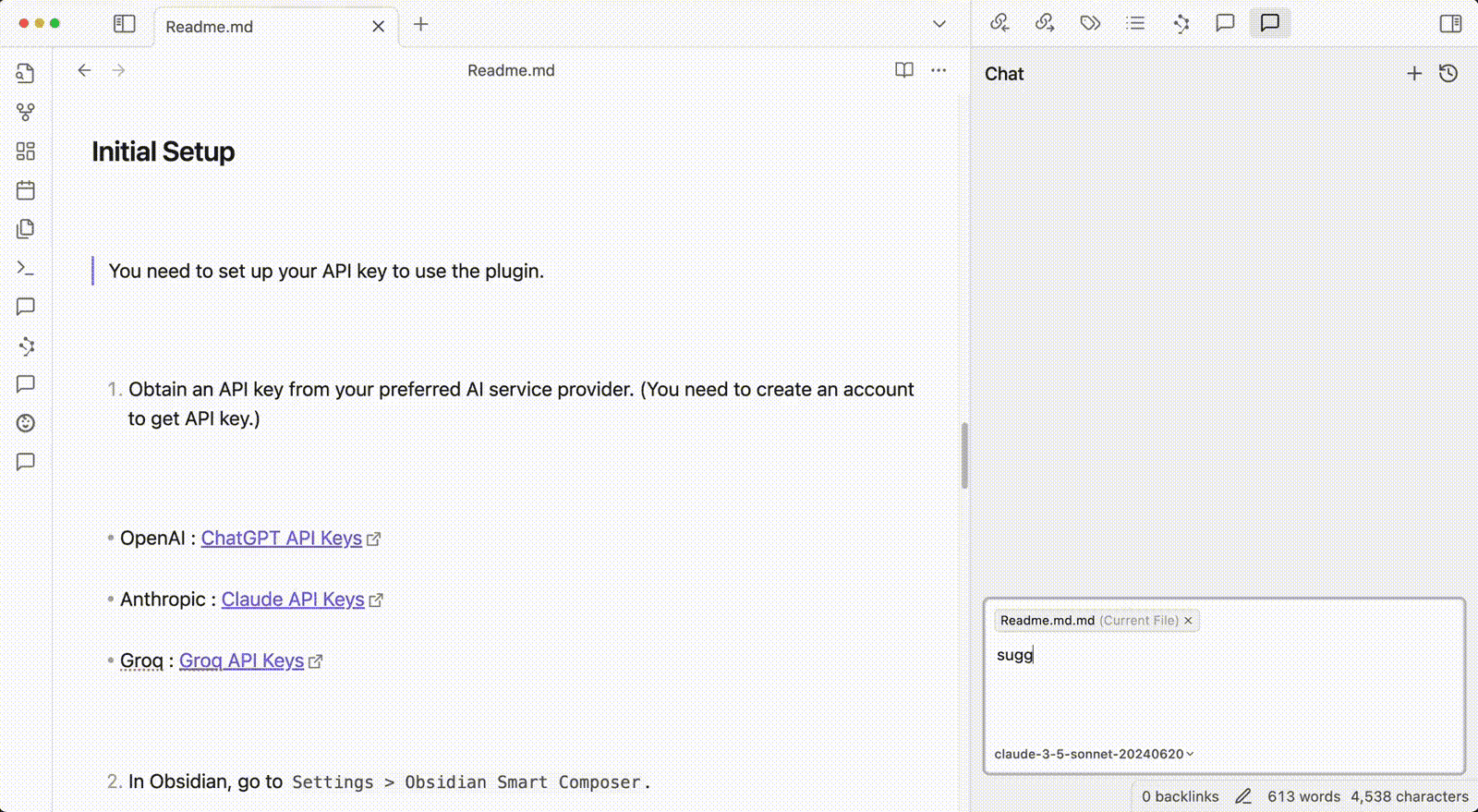

Местная интеграция RAG

- Загрузка документов: Используйте команду # в интерфейсе чата, чтобы загрузить документы или добавить файлы в библиотеку документов.

- получить: Введите запрос в чат, и система автоматически извлечет необходимую информацию из загруженных документов и сгенерирует ответ.

общие проблемы

- проблема подключения: Если у вас возникли проблемы с подключением, убедитесь, что контейнер Docker имеет доступ к серверу Ollama. Для решения проблемы используйте следующую команду:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main - Обновление установки Docker: Используйте Watchtower для обновления локальной установки Docker до последней версии:

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui

Развертывание Open WebUI в один клик в Cuddleface

https://codeberg.org/fossandroid/Open-WebUI.git

https://linux.do/t/topic/274417

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...