Руководство по настройке нового WebUI и отечественной поисковой системы OpenManus

Практические уроки по искусственному интеллектуОпубликовано 11 месяцев назад Круг обмена ИИ 68.5K 00

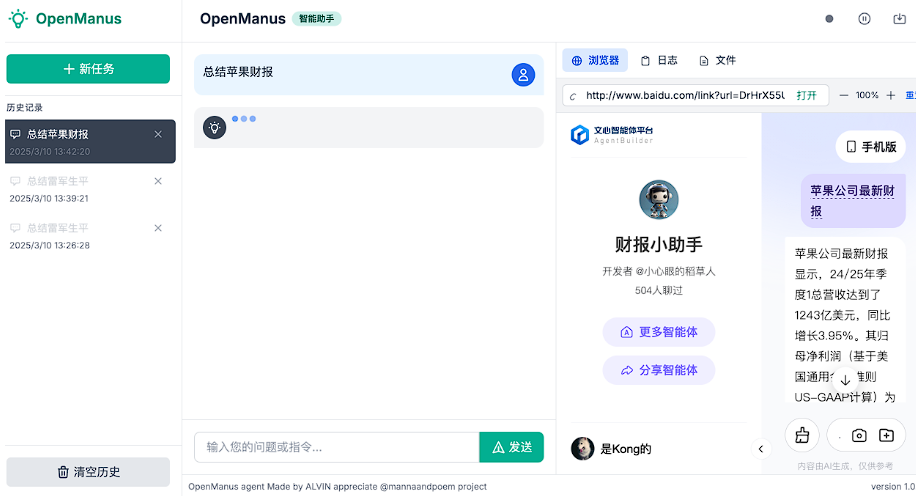

В последнее время OpenManus был сильно обновлен, в дополнение к поддержке локальных Оллама и веб-провайдеров API, а также добавили поддержку отечественных поисковых систем и несколько адаптаций WebUI. В этой статье мы расскажем о нескольких WebUI OpenManus, созданных сообществом, и о том, как настроить их для отечественных поисковых систем.

Введение в веб-интерфейс OpenManus

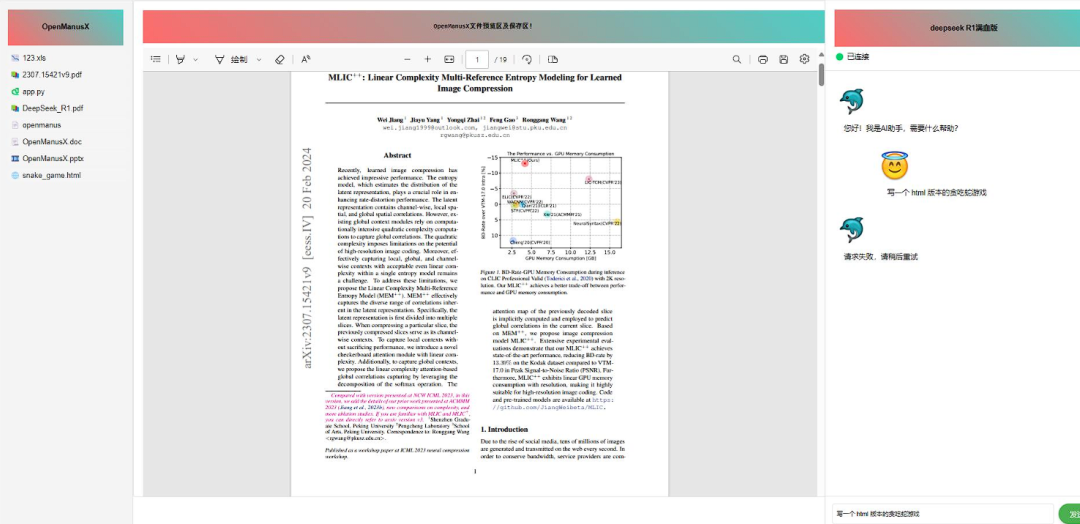

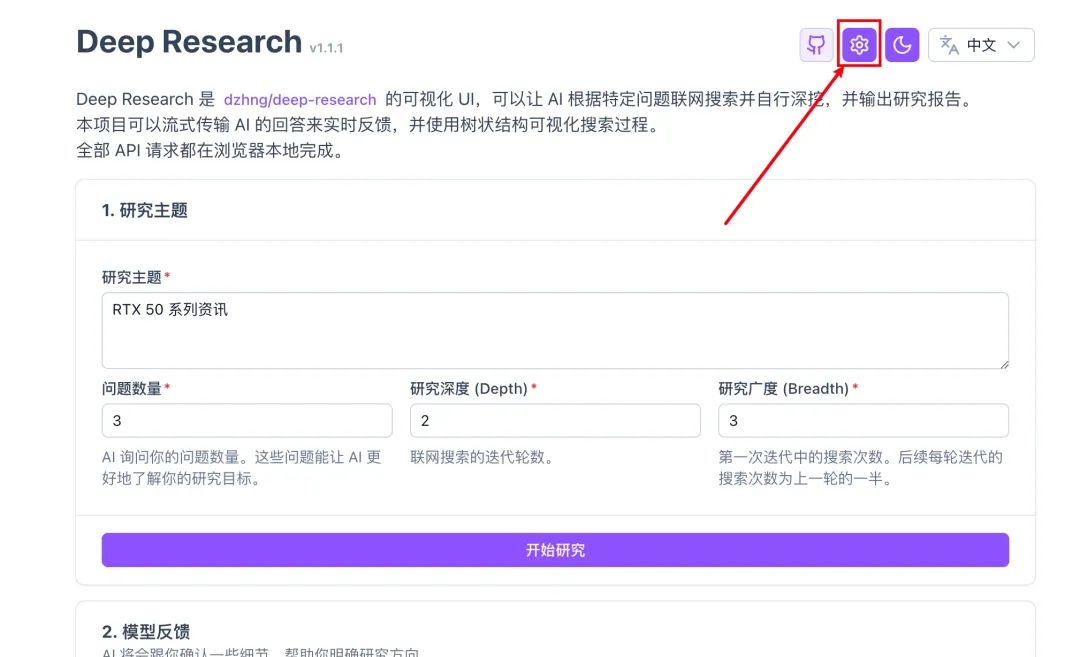

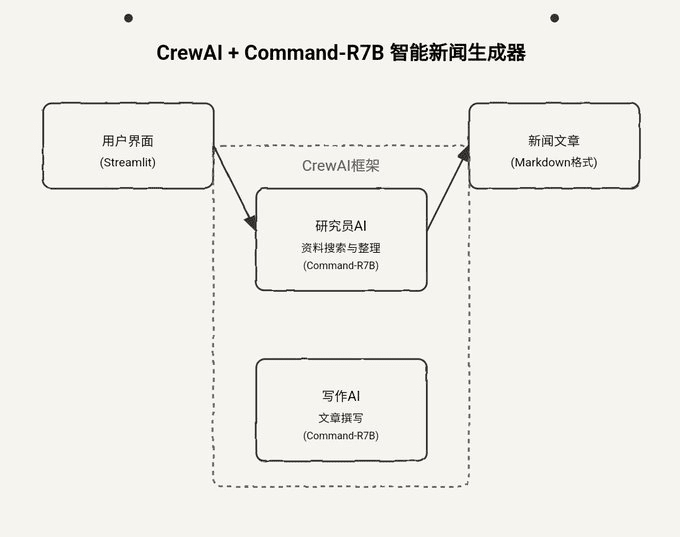

В сообществе существует ряд проектов WebUI, адаптированных к OpenManus, некоторые из них перечислены ниже для справки:

Каждый из этих элементов WebUI имеет свои особенности, поэтому вы можете использовать их в соответствии со своими предпочтениями.

Официальный сайт OpenManus также был обновлен (https://openmanus.github.io/). Однако при переходе с правой стороны репозитория GitHub на официальный сайт, а затем по ссылке на документацию происходит переход обратно в репозиторий GitHub, что немного сбивает с толку.

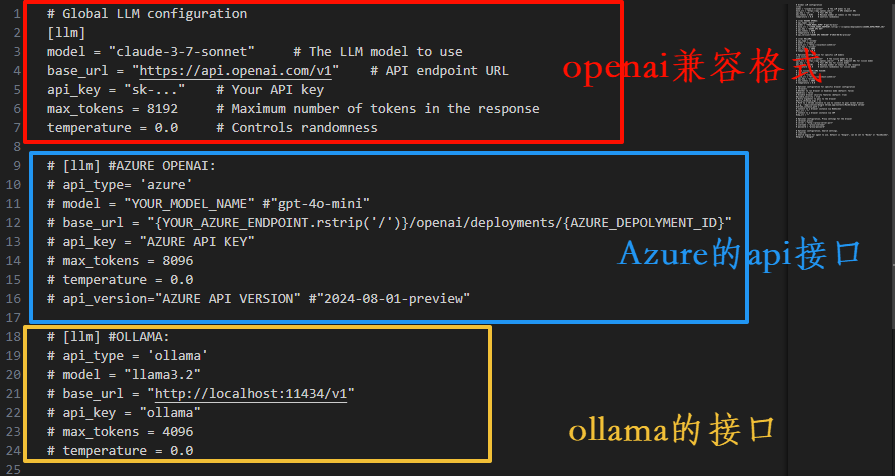

Обновление интерфейса конфигурации

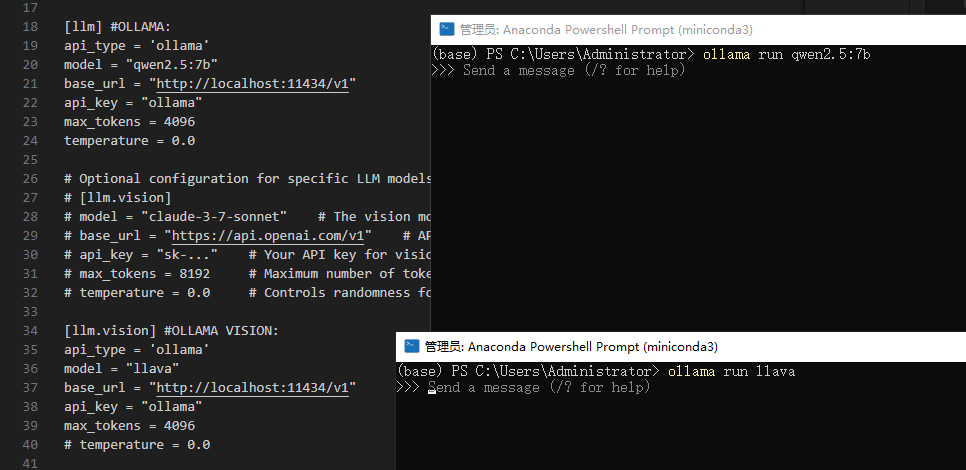

В новой версии интерфейса конфигурации увеличено количество аннотаций, пользовательский интерфейс, URL, поисковая система и другие элементы конфигурации более четко объяснены, более дружелюбны к начинающим пользователям.

Конфигурация визуальной модели аналогична и не будет повторяться здесь.

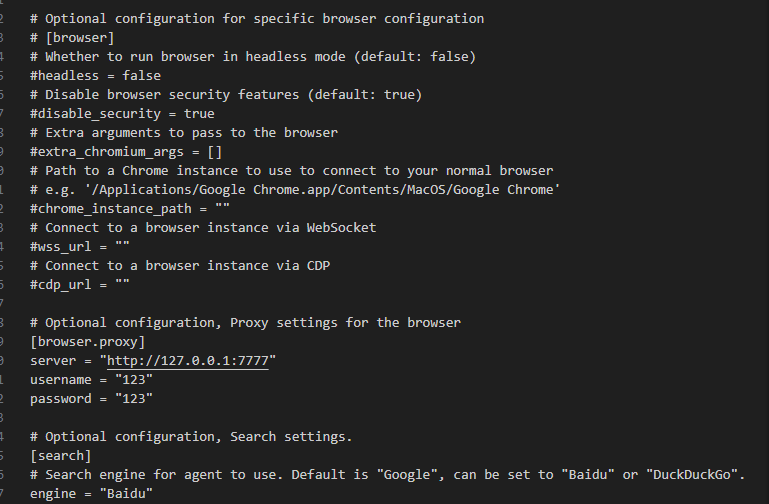

Настройка поисковых систем и браузеров

OpenManus теперь поддерживает настройку поисковых систем и браузеров. Пользователи могут выбирать их в соответствии со своими потребностями. Если вы не знакомы с английскими опциями, вы можете воспользоваться инструментом перевода для облегчения понимания.

Использование WebUI

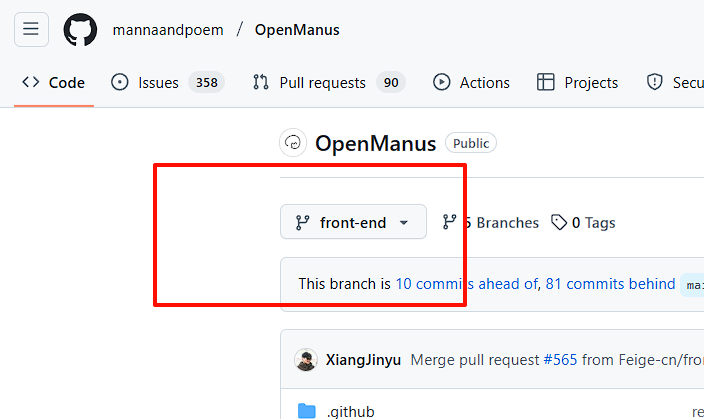

Чтобы использовать WebUI, необходимо выбрать хранилище front-end Разветвление.

Конфигурация среды

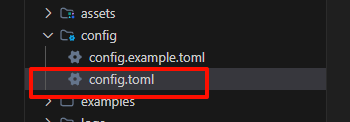

Перед началом работы необходимо настроить переменные окружения. Вот пример локальной Ollama. Сначала создайте копию config Документация:

Затем внесите изменения в скопированный файл. Удалите оригинальную конфигурацию API и настройте ее в соответствии с портом Ollama:

Внимание:api_key Не может быть null и может быть заполнен произвольным значением.

Выбирая модель, остановитесь на той, которая поддерживает функциональные инструменты; на сайте Ollama есть список моделей, поддерживающих вызов инструментов.

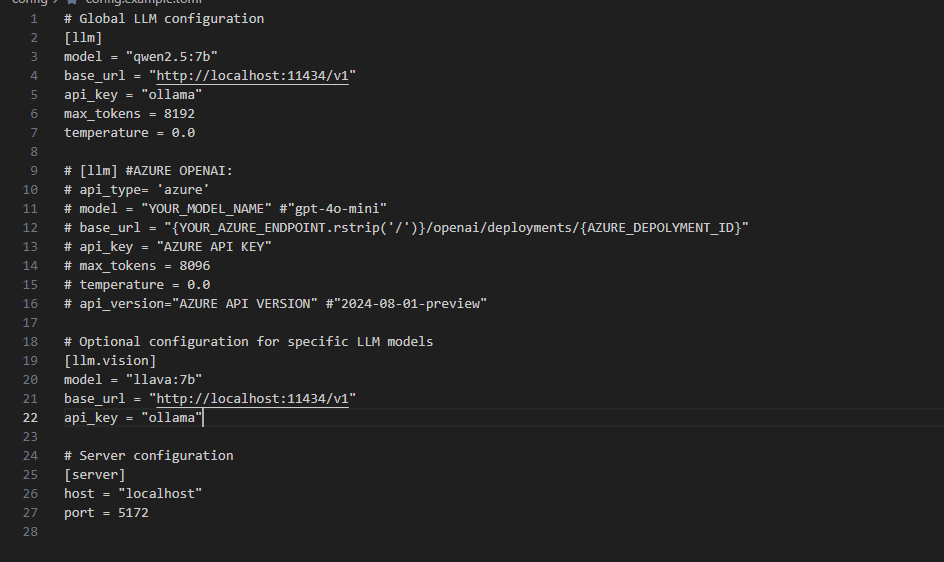

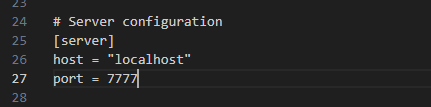

Установите порт и поисковую систему (ветка UI еще не полностью адаптирована под отечественные поисковые системы). Возьмем, к примеру, Baidu, заполним Baidu.

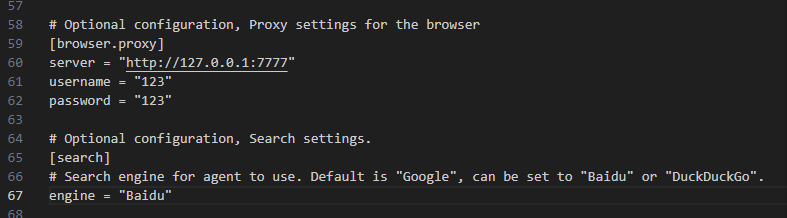

Конфигурация версии Black Window:

Настройка версии пользовательского интерфейса:

Сохраните файл конфигурации.

Запуск Олламы

Чтобы запустить Ollama из командной строки, в примере используется команда qwen2.5:7b ответить пением llava Две модели:

Установка зависимостей

Установите добавленные пакеты зависимостей, такие как fastapi, иduckduckgo ответить пением baidusearch. Запустите в корневом каталоге проекта:

pip install -r requirements.txt

Начало реализации проектов

После завершения установки запустите проект.

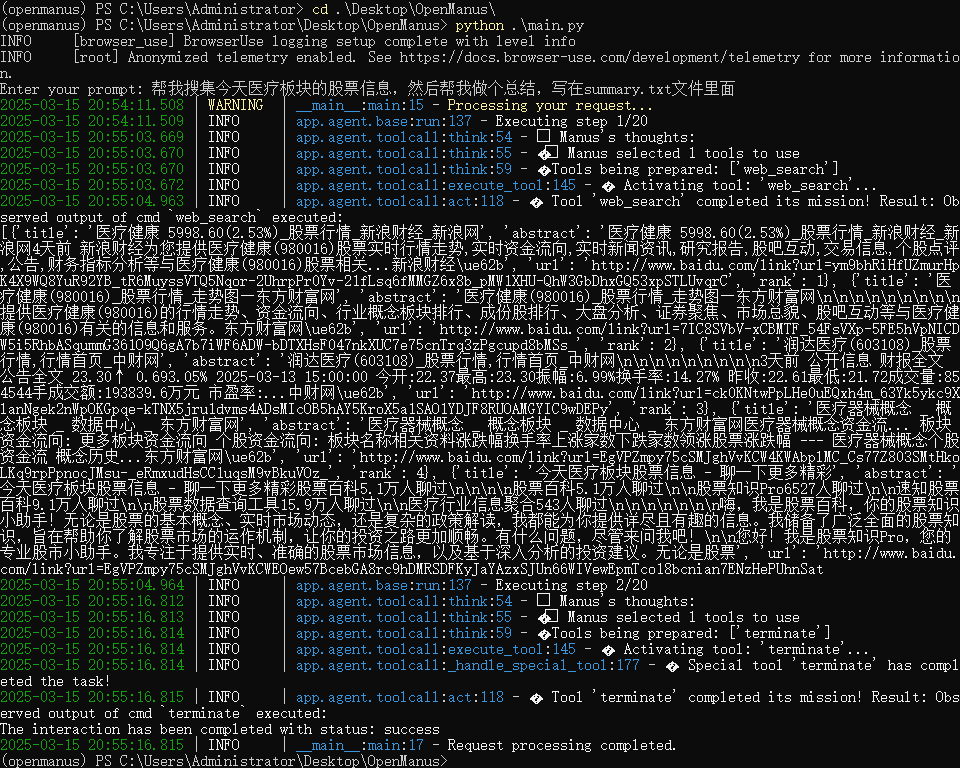

Версия "Черное окно" может быть использована run_flow.py возможно main.py Документация:

python run_flow.py

# 或者

python main.py

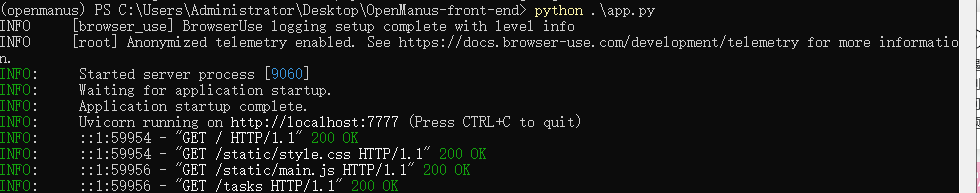

Версия UI запускается с помощью следующей команды:

python app.py

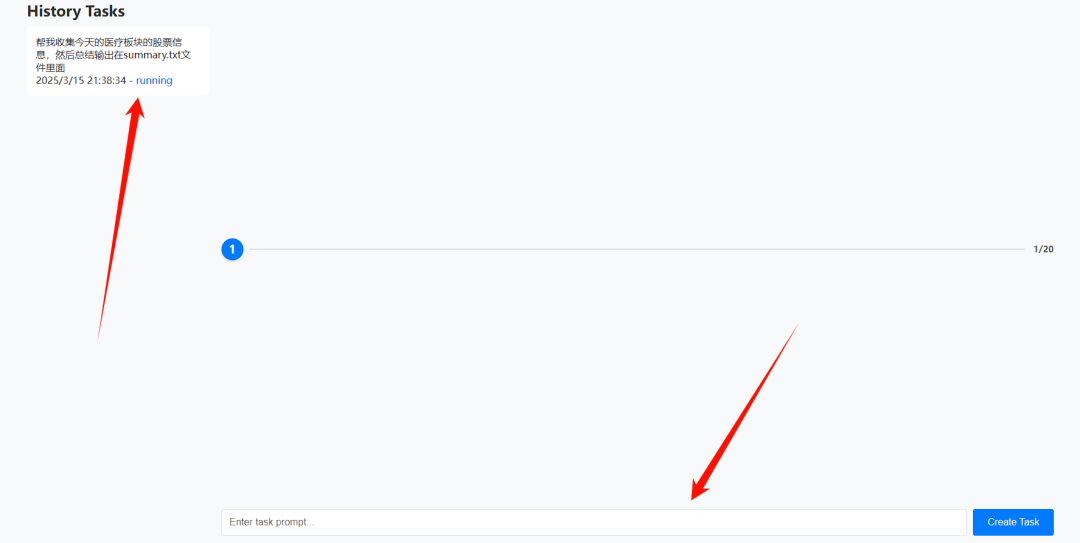

Начало миссии

В версии с черным окном эффект работает:

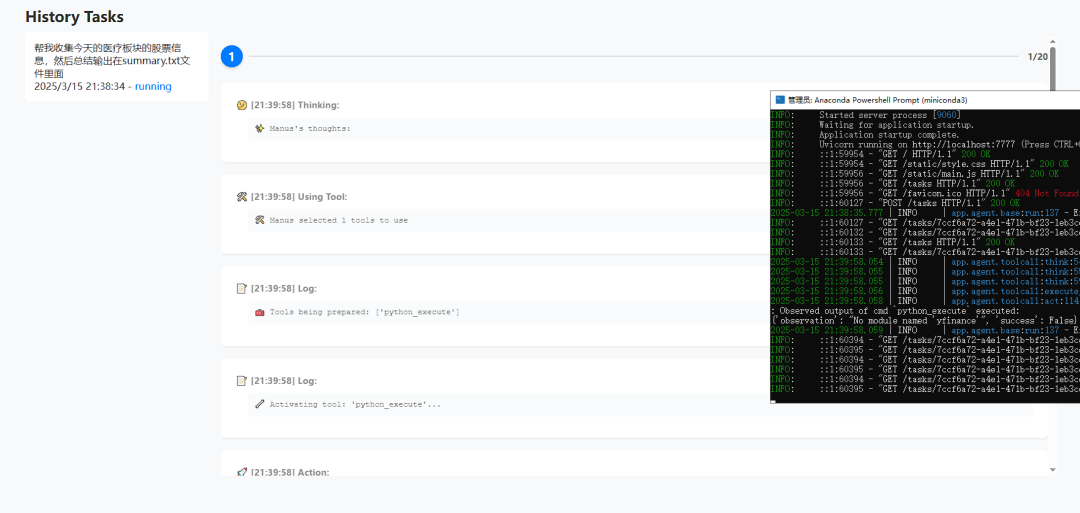

При запуске версии пользовательского интерфейса происходит автоматический переход на веб-страницу:

Введите задачу в поле ввода и нажмите кнопку "Создать задачу", чтобы создать задачу.

Выполнение заданий можно просматривать как в внутреннем, так и во внешнем интерфейсе:

Поддержка поиска в WeChat (экспериментально)

Разработчик подал Pull Request для WeChat Search:https://github.com/mannaandpoem/OpenManus/pull/483

Эта функция реализована на основе технологии поиска и краулера Sogou WeChat. В связи с оптимизацией поискового интерфейса OpenManus первоначальный путь может потребовать изменения конфигурации. Заинтересованные пользователи могут попробовать адаптировать его самостоятельно.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...