OpenAI-o3 с идеями Монте-Карло

o3 здесь, чтобы поделиться некоторыми личными соображениями. О времени испытаний Закон масштабирования прогресс, причем гораздо быстрее, чем мы думали. Но я бы сказал, что путь на самом деле немного запутанный - это способ OpenAI взять кривой шар в своем стремлении к AGI.

Интенсивное обучение и ускоренное мышление

Почему это так? Давайте разберемся в этом на двух примерах.

Первый пример связан с обучением с подкреплением. В RL ключевую роль играет фактор дисконтирования, который подразумевает, что полученное вознаграждение будет постепенно уменьшаться, чем дальше будут продвигаться шаги принятия решения. Поэтому цель обучения с подкреплением обычно состоит в том, чтобы максимизировать вознаграждение за кратчайшее время и за минимальное количество шагов. В основе этой стратегии лежит акцент на "коротких путях", то есть на получении вознаграждения как можно быстрее.

Второй пример - процесс тонкой настройки больших моделей. Предварительно обученная модель, которая не подвергалась тонкой настройке, часто не имеет четкого направления и контроля. Когда мы спрашиваем модель "Где находится столица Китая?" она может сначала сказать "Хороший вопрос", а затем пойти по касательной, прежде чем дать ответ "Пекин". Однако когда тот же вопрос задается точно настроенной модели, ответ будет прямым и ясным: "Пекин".

Эта отлаженная модель демонстрирует способ получения коротких путей с помощью оптимизационных стратегий - подобно эволюционному пути человека, всегда стремящегося к наименьшему потреблению энергии и кратчайшему пути.

Почему именно рассуждения?

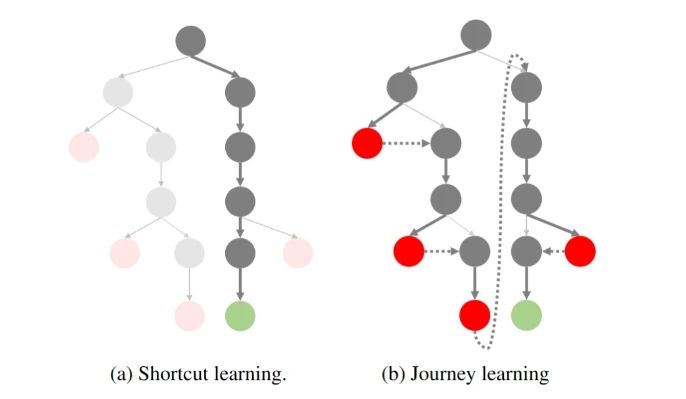

Если представить себе процесс отбора проб на рассуждения в виде дерева:

Путешествие по репликации O1: часть 1

Слева - ускоренное обучение, которого мы придерживались в прошлом: наименьшее количество шагов для достижения нужного результата. Справа - "рефлексивная, ретроспективная" парадигма, представленная OpenAI o1.

Мы знаем, что во время поиска o1 модель постоянно размышляет и возвращается назад, и этот процесс часто сопровождается дополнительными накладными расходами. Проблема в том, что кто захочет тратить время и деньги на сложный поиск, если модель на самом деле может давать правильный ответ снова и снова? OpenAI не глуп, и мы все знаем, что короткие пути лучше!

Чем сложнее задача, тем шире потенциальное дерево идей, тем больше пространства для поиска на каждом шаге и тем меньше вероятность того, что короткий путь приведет к правильному ответу. Так что же делать? Интуитивный способ подумать об этом - сделать обрезку! Отрезать те узлы дерева, которые вряд ли достигнут конечной точки раньше времени, сжимая пространство поиска - превращая дерево обратно в узкое. Именно это пытаются сделать многие современные разработчики, например:

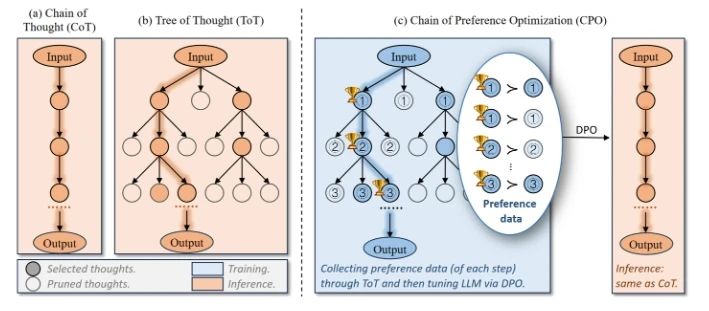

Оптимизация цепочки предпочтений (CPO)

Оптимизация цепочки предпочтений - это естественное построение данных о предпочтениях на основе дерева мышления, а затем использование DPO для его оптимизации, чтобы модель с большей вероятностью выбрала узел дерева, который достигнет конечной точки.

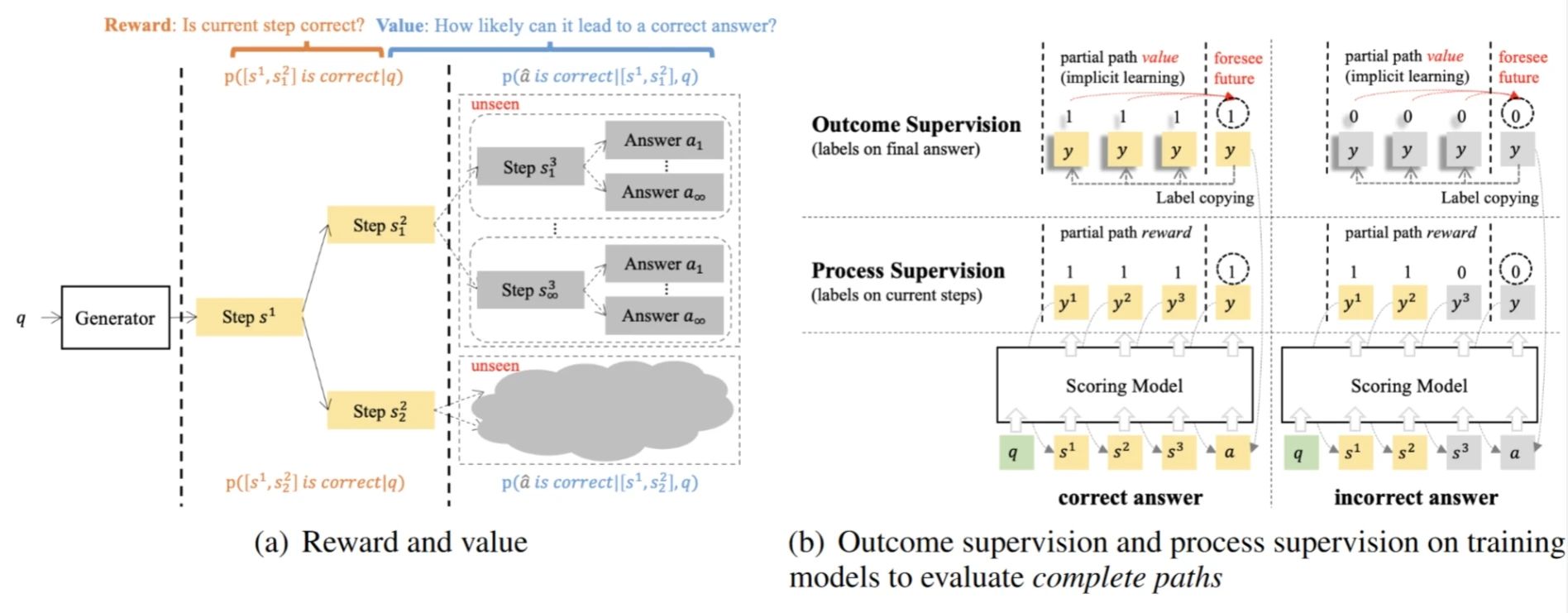

Модели стоимости с контролем результатов (OVM)

Ценностные модели с контролем результата - это моделирование рассуждений как MDP-процесса, где вероятность получения правильного ответа на текущем шаге (Value) используется для оптимизации стратегии.

Почему OpenAI решила отойти от традиционных путей?

Возвращаясь к o1, почему вы решили отказаться от традиционной идеи короткого пути и пойти по "обходному пути" Tree Search?

Если в прошлом мы стремились использовать базовые возможности моделей (Exploit), то можно предположить, что существующие модели GPT-4 способны удовлетворить большинство потребностей в диалоге и простых рассуждениях. И эти задачи могут быть хорошо проанализированы, оценены предпочтения и оптимизированы итеративно.

Но эта точка зрения игнорирует необходимость более сложных задач - таких, как математические рассуждения (AIME, Frontier Math), генерация кода (SWE-Bench, CodeForce) и т. д., которые часто трудно вознаградить в краткосрочной перспективе-. -Их вознаграждение очень редкое, и оно становится очевидным только после получения правильного ответа.

Следовательно, традиционное сокращенное обучение уже не подходит для решения такой сложной задачи: как можно говорить об оптимизации вероятности того, что модель выберет правильный путь, если вы даже не можете сделать выборку правильного пути?

Возвращаясь к "идее Монте-Карло" в названии этой статьи, мы видим, что это фактически одно и то же: суть подхода Монте-Карло к обучению с подкреплением заключается в оценке ценности политики путем многократной выборки и, таким образом, оптимизации модели. Однако у этого подхода есть естественное ограничение - если сэмплируемые политики не могут выбирать оптимальные пути, то оптимизация модели всегда будет заканчиваться локальным оптимумом. Поэтому в MC Learning мы выбираем более исследовательскую стратегию.

Таким образом, OpenAI решила сломать чашу весов обучения с подкреплением, перейдя от традиционного менталитета короткого пути к исследованию подкрепления (Explore).

o1 Прорыв: от разведки до оптимизации

В связи с этим OpenAI предложила парадигму o1. Это изменение позволяет модели постепенно получать редкие вознаграждения при решении сложных задач! И благодаря этим вознаграждениям стратегия может постоянно оптимизироваться. Хотя этот процесс исследования может показаться громоздким и неэффективным, он закладывает основу для дальнейшей оптимизации модели.

Так откуда же взялся o1? В последнее время также появилось много работ по воспроизведению o1, что же они делают? Если поведенческая политика, используемая для разведки, - это подход On-Policy, то она сэмплируется с текущей моделью (например, GPT-4o), которая все еще слишком неэффективна.

Поэтому ребята единогласно выбрали метод "вне политики":

OpenAI тратит много денег, чтобы нанять аспирантов для аннотирования данных Long CoT; Нет денег? Что мы можем сделать, если у нас нет денег? Тогда мы можем сотрудничать с людьми и машинами для аннотирования данных (ручная дистилляция o1), и снизить требования к аннотаторам; У нас даже нет денег, чтобы найти аннотаторов? Тогда нам придется дистиллировать R1 / QwQ, или придумать другие способы (Critique, PRM и т.д.). Я также хотел бы напомнить крупным производителям и лабораториям, которые активно воспроизводят o1, не забывать, что конечной целью исследований все еще является оптимизация!

插一句题外话,虽然大家都在骂 o1 隐藏了真正的思维链,只展示 Summary 的捷径版本。殊不知这个 Summary 才是优化策略的关键数据!但 OpenAI 并不害怕其他人蒸馏这些 Summary,因为蒸馏这些数据还有一个前提——基础模型的能力足够强大,不然步子迈太大还容易闪了腰。

并且 OpenAI 还将探索的成本转嫁给了用户。虽然在初期花很多钱来标注探索型数据,但现在有了 o1 后,用户使用的过程中又无形地为他标注了更多数据。OpenAI 再次实现了伟大的数据飞轮!

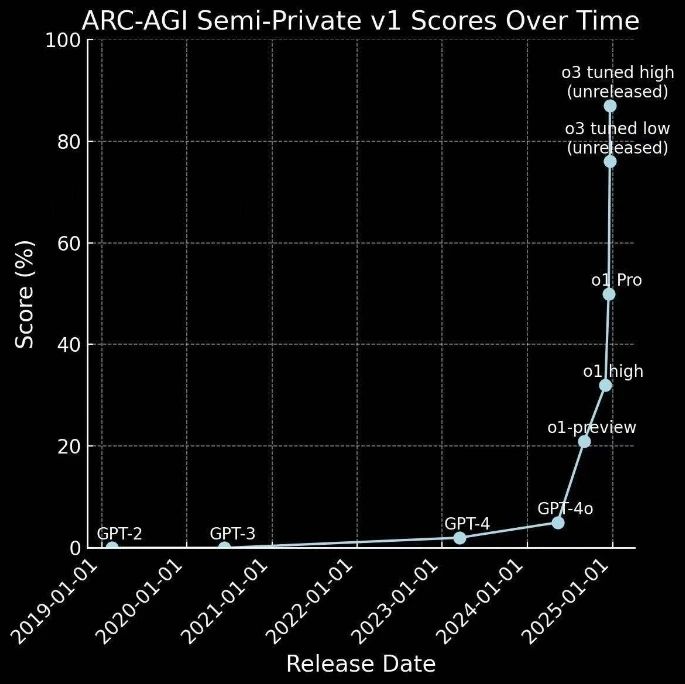

Быстрая эволюция от o1 к o3

Модель o1 была выпущена всего несколько месяцев назад, и вот уже выходит o3.

Фактически, это перечеркивает предыдущую гипотезу: если GPT-4 представляет собой прогрессию от 0 до 1 - то есть от простых задач к получению вознаграждений, то o1 представляет собой скачок от 1 до 10 - изучение сложных задач и получение редких и получения редких наград, предоставляя беспрецедентное количество высококачественных данных для дальнейшей оптимизации стратегии.

Поэтому она развивается быстрее, чем кто-либо ожидал:

Это не только успешное применение стратегии разведки, но и важный шаг в развитии технологий ИИ на пути к AGI.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...