Введение в макромодель OpenAI o1-mini

Продвижение экономически эффективных методов рассуждений.

Мы запустили OpenAI o1-mini, экономичную модель вывода. o1-mini демонстрирует превосходство в STEM, особенно в математике и программировании, и по производительности почти не уступает OpenAI o1 Сопоставимая производительность на обзорных бенчмарках, таких как AIME и Codeforces. Мы ожидаем, что o1-mini станет более быстрым и доступным вариантом для сценариев приложений, требующих рассуждений, но не опирающихся на обширные знания о мире.

Сегодня мы предлагаем OpenAI o1-preview для 80% дешевле, чем OpenAI o1-preview. Пользователи API 5-го уровня (открывается в новом окне) Запуск o1-mini. Пользователи ChatGPT Plus, Team, Enterprise и Edu могут использовать o1-mini в качестве альтернативы o1-preview, наслаждаясь более высокими лимитами использования и более низкой задержкой, см.

Оптимизировано для STEM-рассуждений

Крупные языковые модели, такие как o1, обычно предварительно обучаются на больших текстовых массивах данных. Несмотря на обширные знания о мире, эти высокопроизводительные модели могут быть дорогими и медленными в реальных приложениях. В отличие от них, o1-mini - это небольшая модель, которая на этапе предварительного обучения специально оптимизирована для вывода STEM. После обучения с использованием того же высокопроизводительного конвейера обучения с подкреплением (RL), что и o1, o1-mini демонстрирует сопоставимые результаты во многих практических задачах рассуждений, при этом являясь значительно более экономичной.

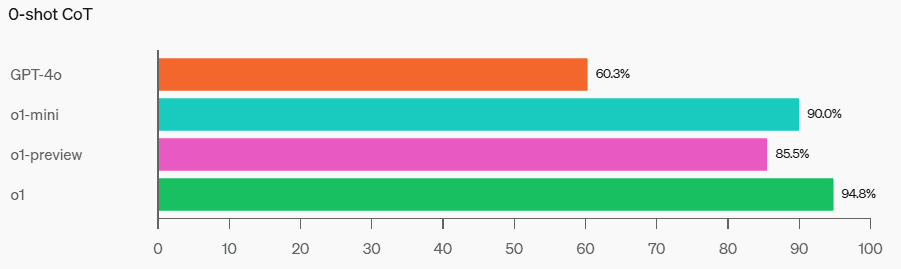

В эталонных тестах, требующих интеллекта и рассуждений, o1-mini превосходит o1-preview и o1. Однако o1-mini плохо справляется с заданиями, требующими фактических знаний, не относящихся к области STEM, см. раздел [Ограничения].

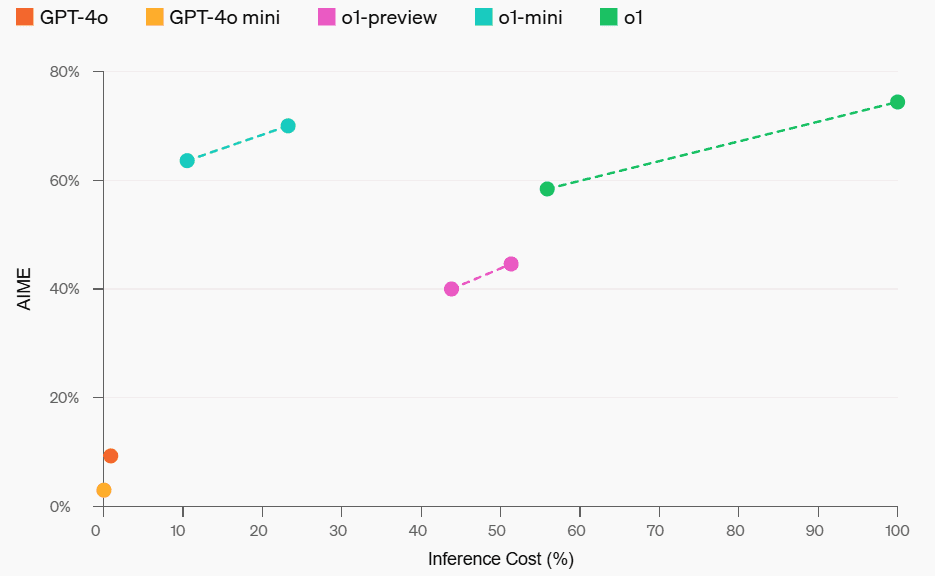

Затраты на математическую деятельность и рассуждения

Математика: В математическом конкурсе AIME для старшеклассников o1-mini (70,0%) показал результаты не хуже, чем o1 (74,4%) - и значительно дешевле - и лучше, чем o1-preview ( 44,6%). По результатам o1-mini (примерно 15 из 11 вопросов отвечены правильно) он примерно входит в 500 лучших американских школьников.

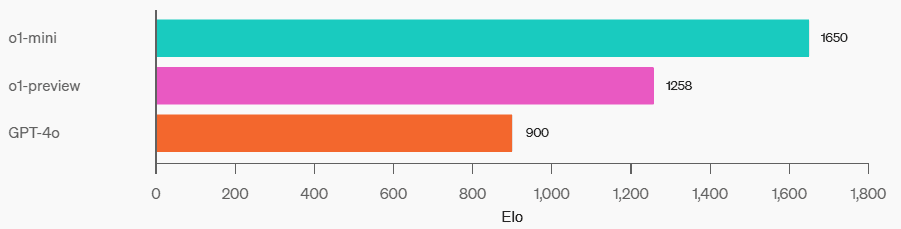

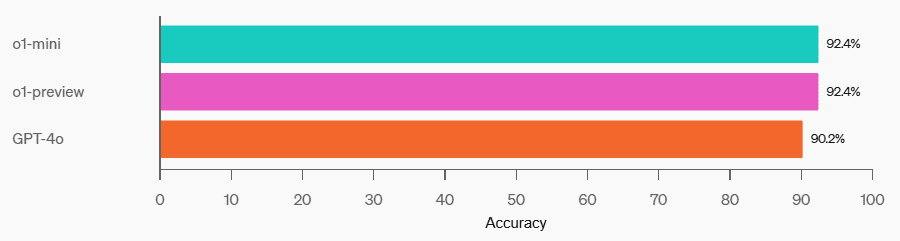

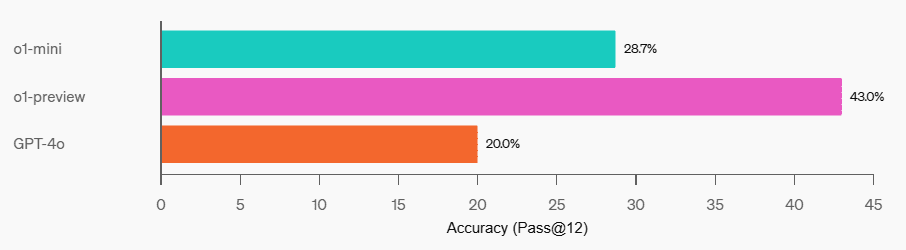

Программирование: На сайте соревнований Codeforces o1-mini имеет оценку Elo 1650, что сравнимо с o1 (1673) и выше, чем у o1-preview (1258). По этому показателю Elo o1-mini входит в 86-й процентиль программистов на платформе Codeforces. o1-mini также показал отличные результаты в эталонных тестах по программированию HumanEval и в заданиях по кибербезопасности на уровне средней школы (CTFs).

Codeforces

HumanEval

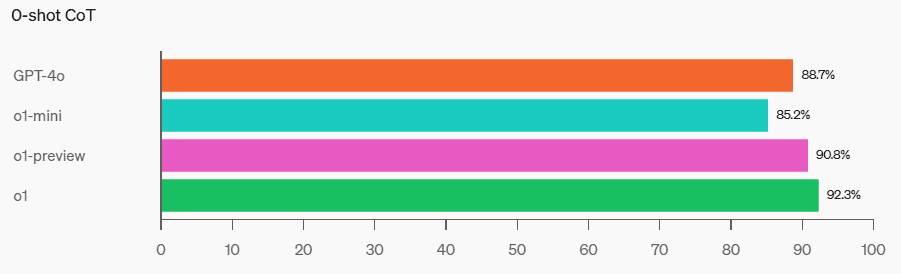

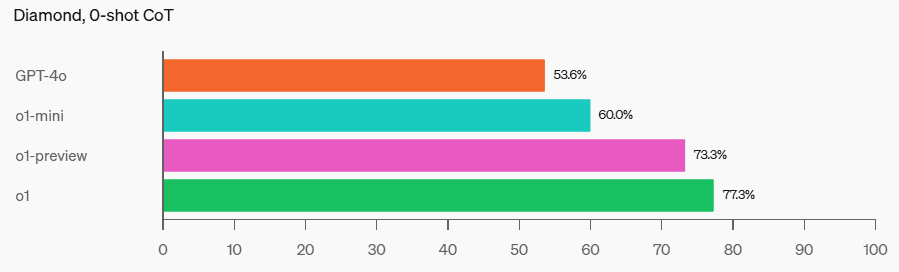

CTF по кибербезопасности

STEM: В некоторых академических тестах, требующих рассуждений, таких как GPQA (естественные науки) и MATH-500, o1-mini превосходит GPT-4o. o1-mini не справляется с заданием MMLU так же хорошо, как GPT-4o, и отстает от o1-preview в GPQA, поскольку ему не хватает обширных знаний о мире.

MMLU

GPQA

MATH-500

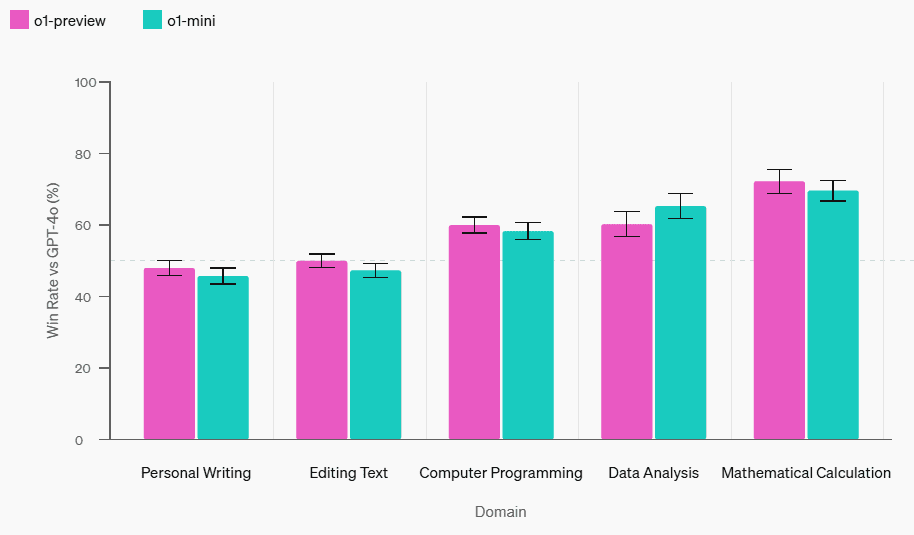

Оценка предпочтений человека: Мы попросили экспертов сравнить o1-mini и GPT-4o с головоломками открытого типа в различных областях, используя ту же методику, что и в [o1-preview compared to GPT-4o](https://openai.com/index/learning-to-reason-with-llms/). Как и в o1-preview, o1-mini популярнее GPT-4o в областях, требующих рассуждений, но менее популярна, чем GPT-4o, в областях, ориентированных на язык.

Оценка человеческих предпочтений в сравнении с chatgpt-4o-latest

скорость модели

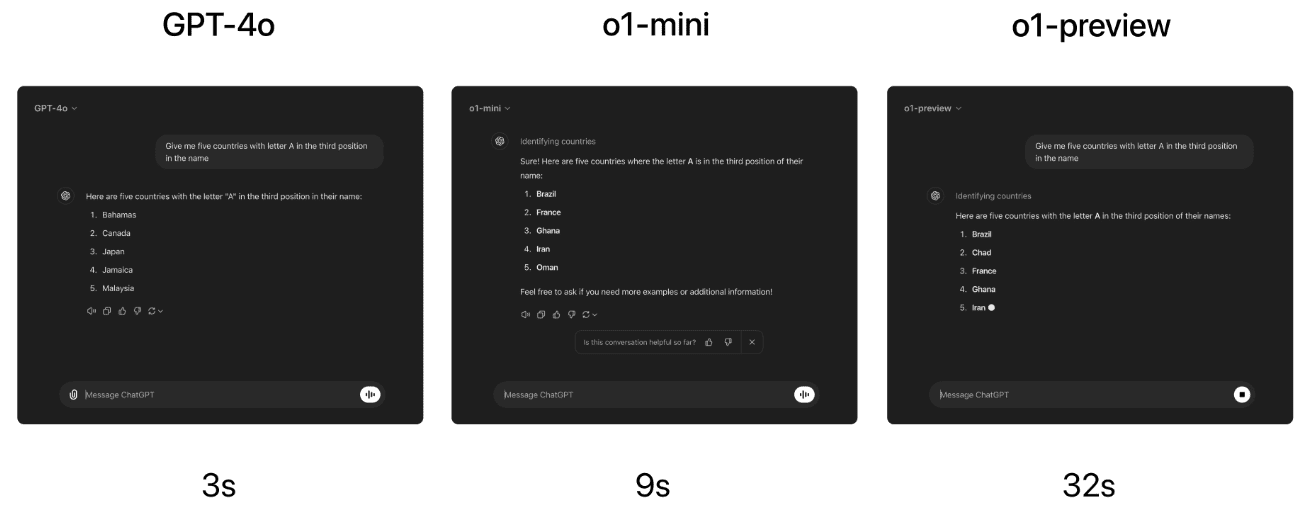

В качестве конкретного примера сравним ответы GPT-4o, o1-mini и o1-preview на задачу о лексических рассуждениях. В то время как GPT-4o дал неправильный ответ, и o1-mini, и o1-preview дали правильный ответ, причем o1-mini ответил примерно в 3-5 раз быстрее.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...