OpenAI выпускает новое поколение API-интерфейсов для аудиомоделей, что является значительным обновлением технологии голосового взаимодействия

Недавно компания OpenAI объявила о запуске нового поколения API для моделирования звука, призванных помочь разработчикам создать более мощные и интеллектуальные голосовые помощники. Эта инициатива рассматривается как крупное достижение в области технологий голосового взаимодействия, сигнализирующее о том, что голосовое взаимодействие между человеком и компьютером вступит в новую фазу, которая будет более естественной и эффективной.

Релиз включает два ключевых обновления: более совершенную модель преобразования речи в текст и более выразительную модель преобразования текста в речь, которые, по утверждению OpenAI, устанавливают новую планку точности и надежности, особенно в сложных сценариях со сложным акцентом, шумным окружением и различной скоростью речи. Улучшение производительности особенно заметно в сложных сценариях, таких как сложные акценты, шумное окружение и различная скорость речи. Это означает, что новая модель позволит значительно повысить качество и эффективность транскрипции в таких приложениях, как центры обработки вызовов клиентов и расшифровка протоколов совещаний.

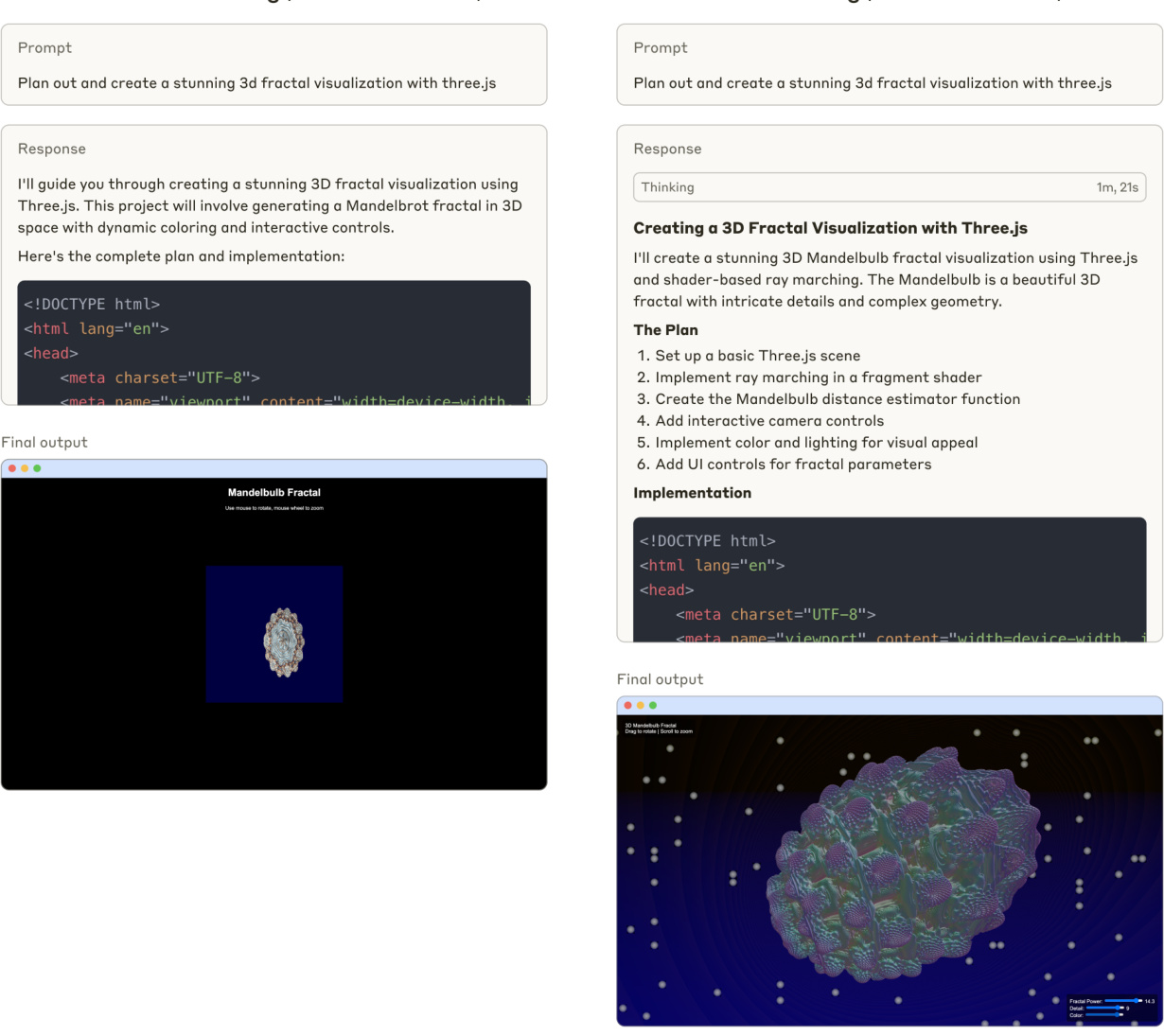

Примечательно, что впервые OpenAI позволяет разработчикам инструктировать модели преобразования текста в речь, чтобы они говорили определенным образом. Например, разработчики могут задать модели "говорить как сочувствующий агент по обслуживанию клиентов", что дает голосовым помощникам беспрецедентные возможности для персонализации. Эта возможность открывает новые двери для различных сценариев, от более гуманного обслуживания клиентов до более выразительного творческого повествования.

OpenAI запустил свою первую аудиомодель, Whisper, еще в 2022 году и с тех пор продолжает инвестировать в улучшение интеллектуальности, точности и надежности модели. Выпуск новой аудиомодели стал кульминацией этих многолетних усилий. Теперь разработчики могут создавать более точные системы преобразования речи в текст, а также более выразительные и яркие звуки преобразования текста в речь с помощью API.

Новое поколение моделей преобразования речи в текст: gpt-4o-transcribe и gpt-4o-mini-transcribe

OpenAI выпустила две новые модели, gpt-4o-transcribe и gpt-4o-mini-transcribe, которые являются более новыми, чем предыдущие. Шепот Модели демонстрируют значительное улучшение коэффициента ошибок в словах (WER), распознавания языка и точности.

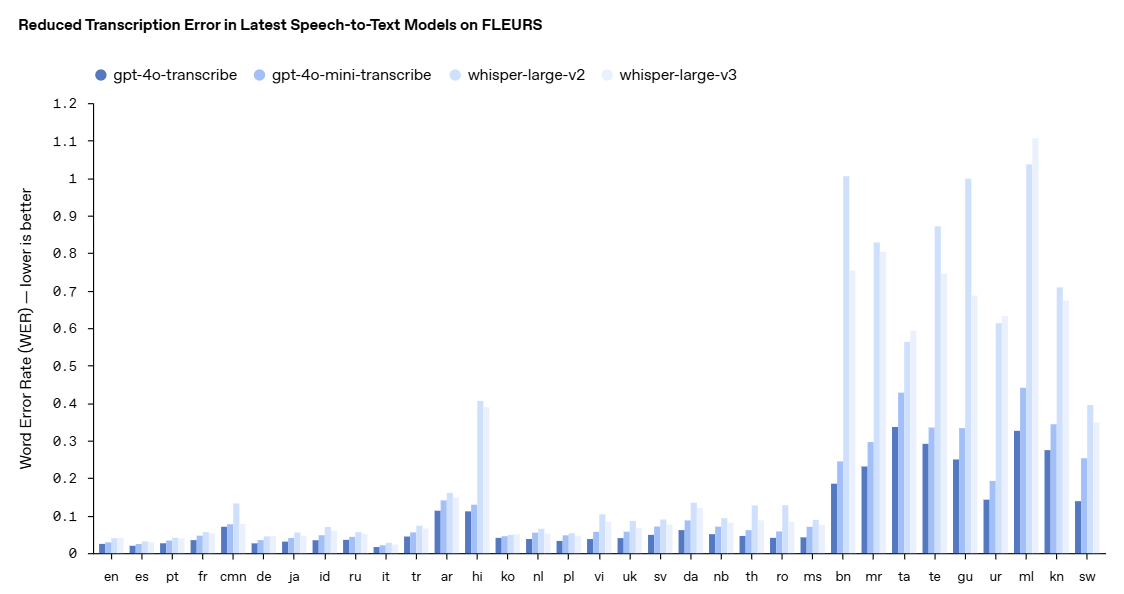

- Коэффициент ошибок слов (WER) измеряет точность модели распознавания речи, вычисляя процент неправильно транскрибированных слов по сравнению с эталонным транскриптом - чем ниже WER, тем лучше, тем меньше ошибок. Наша новейшая модель преобразования речи в текст достигла низкого показателя WER в различных бенчмарках, включая FLEURS (Learning Evaluation of Speech Universal Representation with Small Samples) - многоязычный бенчмарк, который охватывает более 100 языков, используя расшифрованные вручную аудиообразцы. Эти результаты демонстрируют более высокую точность транскрипции и более широкий языковой охват. Как показано здесь, наша модель стабильно превосходит Whisper v2 и Whisper v3 во всех языковых оценках.

gpt-4o-transcribe продемонстрировал превосходство модели Whisper по коэффициенту ошибок слов в ряде авторитетных бенчмарков. Коэффициент ошибок в словах является ключевым показателем точности модели распознавания речи, при этом более низкие значения означают меньшее количество ошибок. По словам OpenAI, эти улучшения стали результатом целенаправленных инноваций в обучении с подкреплением и масштабного промежуточного обучения с использованием различных высококачественных аудиоданных.

В результате новые модели преобразования речи в текст лучше улавливают нюансы речи, уменьшают количество ошибок распознавания и повышают надежность транскрипции, особенно в сложных ситуациях, таких как акцент, шумное окружение и разная скорость речи. В настоящее время эти модели открыты для использования в API преобразования речи в текст.

Чтобы наглядно продемонстрировать улучшение производительности, OpenAI приводит пример FLEURS (Few-shot Learning Evaluation of Универсальный Результаты бенчмарка Representations of Speech (FLEURS), многоязычного бенчмарка речи, охватывающего более 100 языков и использующего расшифрованные вручную аудиообразцы. Результаты показывают, что новая модель OpenAI имеет более низкий уровень ошибок в словах, чем Whisper v2 и Whisper v3 в межъязыковых оценках, демонстрируя большую точность транскрипции и более широкий языковой охват.

Новое поколение моделей преобразования текста в речь: gpt-4o-mini-tts

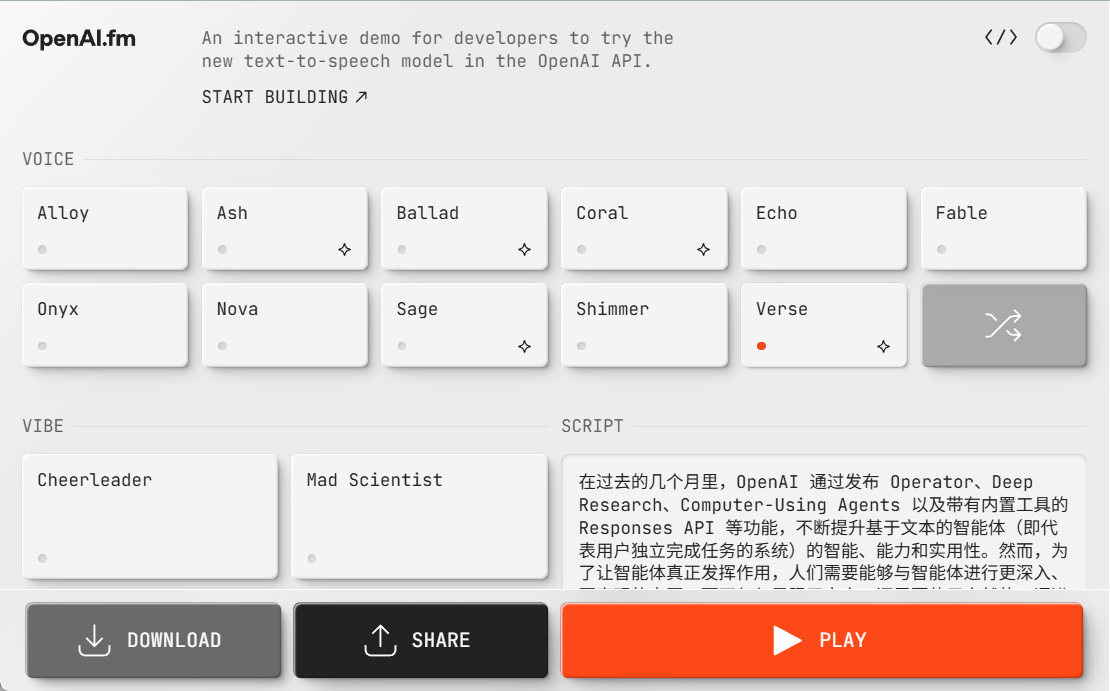

В дополнение к модели преобразования речи в текст OpenAI также представила новую модель преобразования речи в текст gpt-4o-mini-tts, изюминкой которой является большая управляемость. Разработчики могут не только управлять тем, что говорит модель, но и указывать ей, как это говорить. Эта возможность позволяет более гибко настраивать пользовательский опыт, причем в самых разных областях - от обслуживания клиентов до творческого контента. Модель также доступна в API Text-to-Speech. Обратите внимание, что в настоящее время эти модели преобразования текста в речь ограничены предустановленными синтезированными голосами, которые OpenAI отслеживает, чтобы они соответствовали синтезированным предустановкам.

Ознакомьтесь с gpt-4o-mini-tts здесь!

https://www.openai.fm/

Технологическая инновация, лежащая в основе модели

OpenAI сообщает, что новые аудиомодели построены на базе архитектур GPT-4o и GPT-4o-mini и прошли предварительное масштабное обучение на наборах данных, специально предназначенных для аудио, что очень важно для оптимизации производительности моделей. Такой целенаправленный подход позволяет моделям глубже понимать тонкости речи и лучше справляться с различными задачами, связанными с аудио.

Кроме того, OpenAI усовершенствовал свои методы уточнения знаний, чтобы обеспечить передачу знаний от больших аудиомоделей к небольшим эффективным моделям. Используя передовые методы самостоятельной игры, набор данных для уточнения эффективно передает реальную динамику диалога и воспроизводит реальные сценарии взаимодействия пользователя с ассистентом. Это помогает маленькой модели обеспечивать превосходное качество диалога и быстроту реакции.

Для моделирования речи в текст OpenAI использует парадигму обучения с подкреплением (RL), чтобы поднять точность транскрипции на новый уровень. Этот подход значительно повышает точность и уменьшает количество галлюцинаций, делая решение для преобразования речи в текст более конкурентоспособным в сложных сценариях распознавания речи.

Эти технологические достижения представляют собой новейший прогресс в области моделирования звука, где OpenAI сочетает инновационные подходы с практическими улучшениями, направленными на повышение производительности речевых приложений.

Открытость API и перспективы на будущее

Эти новые звуковые модели теперь доступны всем разработчикам. Для разработчиков, которые уже используют текстовые модели для создания диалогов, интеграция моделей "речь-текст" и "текст-речь" - самый простой способ создания голосовых помощников. OpenAI также выпустил интеграцию с Agents SDK, чтобы упростить процесс разработки. Разработчикам, желающим создать голосовые помощники с низкой задержкой, OpenAI рекомендует использовать речевые модели в Realtime API.

В дальнейшем OpenAI планирует продолжать инвестировать в интеллектуальность и точность своих аудиомоделей и изучать способы, позволяющие разработчикам внедрять собственные звуки для создания более персонализированного опыта, обеспечивая при этом соблюдение стандартов безопасности. Кроме того, OpenAI ведет активный диалог с политиками, исследователями, разработчиками и творческими людьми о проблемах и возможностях, которые может предоставить синтезированный звук. OpenAI с нетерпением ждет инновационных приложений, которые разработчики будут создавать, используя эти расширенные аудиовозможности, и говорит, что продолжит инвестировать в другие модальности, включая видео, чтобы поддержать разработчиков в создании мультимодальных интеллектуальных возможностей.

Выпуск OpenAI нового поколения API для аудиомоделей, несомненно, привнес новый импульс в развитие технологий голосового взаимодействия. Благодаря непрерывному прогрессу технологий и все более богатым сценариям применения, у нас есть основания полагать, что будущее цифрового мира станет более "способным слушать и говорить", а взаимодействие человека и компьютера будет более естественным и плавным.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...