Как боты OpenAI "действовали как DDoS-атака", чтобы уничтожить сайт компании, состоящей из семи человек

В субботу генеральный директор Triplegangers Александр Томчук получил уведомление о том, что сайт его компании не работает. Это было похоже на какую-то распределенную атаку типа "отказ в обслуживании".

Вскоре он обнаруживает, что виновником является один из ботов OpenAI, который неустанно пытается прочесать весь его огромный сайт.

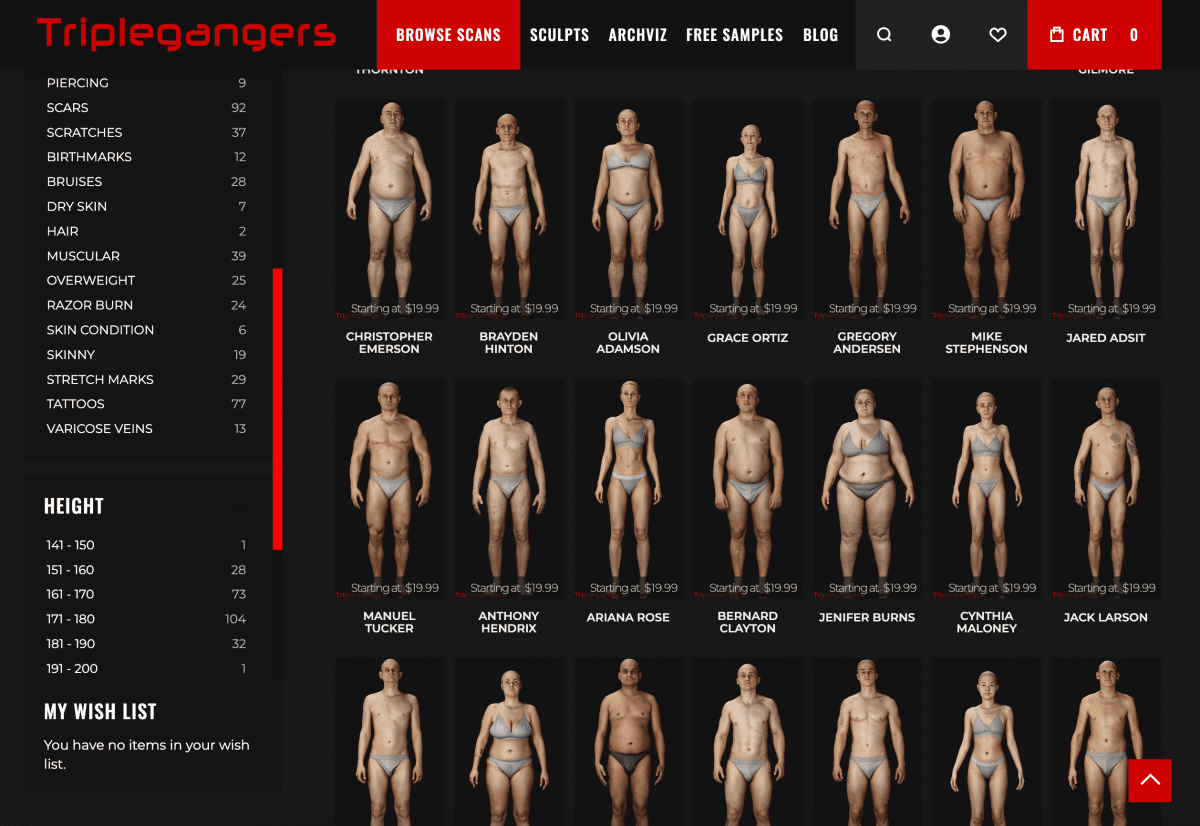

"У нас более 65 000 товаров, и у каждого продукта есть своя страница, - рассказал Томчук в интервью TechCrunch. - На каждой странице есть как минимум три фотографии".

OpenAI отправил "десятки тысяч" запросов на сервер, пытаясь загрузить весь этот контент, включая сотни тысяч фотографий и их подробные описания.

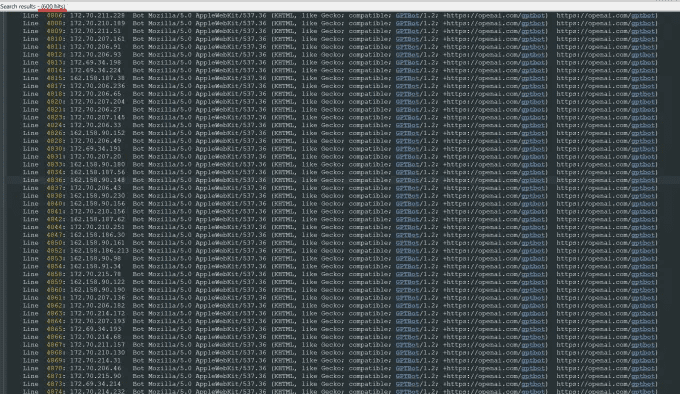

"OpenAI использовал 600 IP-адресов для сбора данных, и мы все еще анализируем журналы за прошлую неделю, так что, возможно, их число еще больше", - сказал он об IP-адресах, которые бот использовал для доступа к его сайту.

"Их краулеры уничтожали наш сайт", - говорит он, - "По сути, это была DDoS-атака".

Сайт компании Triplegangers - это ее бизнес. Компания, состоящая из семи сотрудников, потратила более десяти лет на то, чтобы собрать самую большую в Сети базу данных "цифровых двойников человека", то есть 3D-изображений, отсканированных с настоящих манекенов.

Она продает файлы 3D-объектов и фотографии 3D-художникам, производителям видеоигр и всем, кому необходимо воссоздать в цифровом виде черты реального человеческого тела - от рук до волос, кожи и всего тела.

Команда Томчука базируется в Украине, но также имеет лицензию в Тампе, штат Флорида, США, а на ее сайте есть страница с условиями предоставления услуг, запрещающая ботам получать доступ к изображениям без разрешения. Но это само по себе ничего не дает. Сайт должен использовать правильно настроенный файл robot.txt, содержащий теги, которые явно указывают роботу OpenAI, GPTBot, не заходить на сайт. (У OpenAI есть несколько других роботов, ChatGPT-User и OAI-SearchBot, которые имеют свои собственные теги, основанные на их информационных страницах о краулере).

Robot.txt, также известный как Robots Exclusion Protocol, предназначен для указания сайтам поисковых систем, что не следует просматривать, поскольку они индексируют веб-страницы. openAI на своей информационной странице утверждает, что он будет соблюдать такие файлы, если настроит собственный тег no-crawl, но также предупреждает, что его роботы могут может потребоваться до 24 часов, чтобы распознать обновленный файл robot.txt.

По опыту Томчука, если сайт не использует robot.txt правильно, OpenAI и другие компании воспринимают это как то, что они могут ползать по контенту по своему усмотрению. Это не система, основанная на отказе.

Что еще хуже, бот OpenAI не только отключает ботов Triplegangers в рабочее время в США, но и ожидает значительного увеличения счетов AWS из-за активности процессора и загрузок бота.

Robot.txt также не является надежной защитой. ai компании добровольно соблюдают его. Другой ИИ-стартап, Perplexity, получил известность прошлым летом в результате расследования журнала Wired, когда некоторые доказательства указывали на то, что Недоумение Времени на соблюдение правил нет.

Невозможно определить, к чему осуществляется доступ

К среде, через несколько дней после возвращения бота OpenAI, Томчук правильно настроил файл robot.txt и создал учетную запись Cloudflare, чтобы заблокировать GPTBot и несколько других найденных им ботов, таких как Barkrowler (SEO-краулер) и Bytespider (краулер TikTok). Томчук также надеется, что ему удалось заблокировать ботов других компаний, занимающихся моделированием искусственного интеллекта. Он сказал, что сайт не падал в четверг утром.

Но у Томчука все еще нет разумного способа узнать, что именно удалось OpenAI, чтобы получить доступ или удалить материал. OpenAI не ответила на просьбу TechCrunch о комментарии. OpenAI не ответила на просьбу TechCrunch о комментарии, и OpenAI до сих пор не предоставила давно обещанный инструмент отказа от использования, как недавно сообщал TechCrunch.

Для Triplegangers это особенно сложный вопрос. "Права - серьезный вопрос в нашем бизнесе, потому что мы сканируем реальных людей", - говорит он. В соответствии с такими законами, как европейский GDPR, "они не могут просто взять фотографию любого человека в Интернете и использовать ее".

Сайт Triplegangers - особенно лакомая находка для ИИ-краулеров. Основаны многомиллиардные стартапы, такие как Scale AI, в которых люди кропотливо маркируют изображения для обучения искусственного интеллекта. Сайт triplegangers содержит подробные маркированные фотографии: раса, возраст, татуировки и шрамы, все типы тела и многое другое.

По иронии судьбы, именно жадность бота OpenAI напоминает Тройняшке о том, насколько он подвержен опасности. Он говорит, что если бы он царапался более аккуратно, Томчук никогда бы об этом не узнал.

"Это страшно, потому что эти компании, похоже, используют лазейку для сбора данных и говорят: "Если вы обновите свой robot.txt с нашими тегами, то сможете отказаться", - говорит Томчук, но это возлагает ответственность на владельцев бизнеса, как их остановить".

Он хочет, чтобы другие малые онлайн-компании знали, что единственный способ узнать, получает ли бот ИИ доступ к защищенному авторским правом контенту на сайте, - это активно искать его. Он, конечно, не единственный, кого они терроризируют. Другие владельцы сайтов недавно рассказали Business Insider о том, как боты OpenAI разрушают их сайты и увеличивают счета за AWS.

В 2024 году эта проблема будет расти в геометрической прогрессии. Новое исследование, проведенное компанией DoubleVerify, специализирующейся на цифровой рекламе, показало, что краулеры и инструменты искусственного интеллекта приведут к увеличению "общего недействительного трафика" на 861 TP3T в 2024 году - то есть трафика, который не исходит от реальных пользователей.

Тем не менее, "большинство сайтов все еще не знают, что по ним ползают эти боты", - предупреждает Томчук. "Теперь нам приходится ежедневно отслеживать активность журналов, чтобы обнаружить этих ботов".

Если подумать, вся эта модель работает примерно так же, как мафиозное вымогательство: если вы не защищены, боты ИИ возьмут то, что им нужно.

"Они должны спрашивать разрешения, а не просто собирать данные", - говорит Томчук.

Похожие статьи.

1. OpenAI запустил новый веб-краулер под названием GPTBot для решения проблем конфиденциальности и интеллектуальной собственности, возникающих при сборе данных на публичных сайтах. Технология направлена на прозрачный сбор публичных веб-данных и их использование для обучения своих моделей искусственного интеллекта, и все это под знаменем OpenAI.

2. OpenAI использует веб-краулеры ("боты") и пользовательские агенты для выполнения действий для своих продуктов, которые либо автоматизированы, либо инициированы запросами пользователей. openAI использует следующий тег robots.txt, чтобы позволить веб-мастерам управлять тем, как их сайты и контент работают с искусственным интеллектом. . Каждая настройка не зависит от других - например, администратор сайта может разрешить OAI-SearchBot появляться в результатах поиска и при этом отключить GPTbot, чтобы указать, что найденный контент не должен использоваться для обучения базовой модели генеративного ИИ OpenAI. Для результатов поиска, пожалуйста, обратите внимание, что на внесение изменений в robots.txt сайта в нашу систему может уйти около 24 часов.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...