Open-Reasoner-Zero: платформа для обучения с открытым исходным кодом для крупномасштабного обучения с применением подкрепления

Общее введение

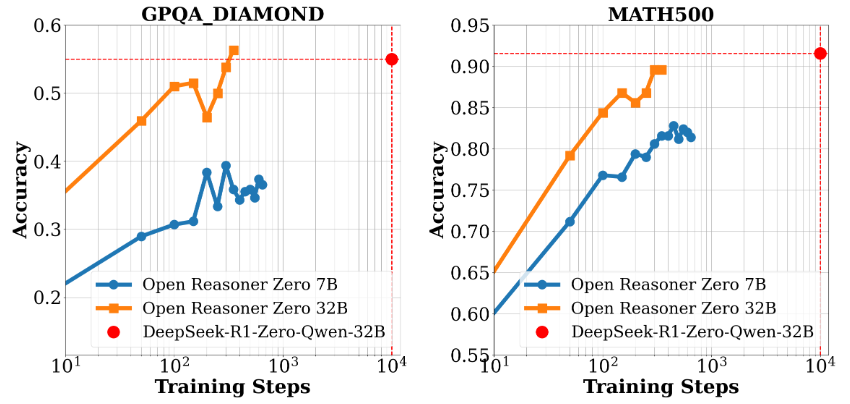

Open-Reasoner-Zero - это проект с открытым исходным кодом, ориентированный на исследования в области обучения с подкреплением (RL), разработанный командой Open-Reasoner-Zero на GitHub. Его цель - ускорить процесс исследований в области искусственного интеллекта (ИИ), особенно в направлении общего искусственного интеллекта (ОИИ), путем предоставления эффективного, масштабируемого и простого в использовании обучающего фреймворка. Проект основан на модели Qwen2.5 (версии с 7 и 32 параметрами) и объединяет такие технологии, как OpenRLHF, vLLM, DeepSpeed и Ray, предоставляя полный исходный код, данные для обучения и веса модели. Модель отличается тем, что достигает аналогичного уровня производительности менее чем за 1/30 часть шагов обучения DeepSeek-R1-Zero, демонстрируя эффективность использования ресурсов. Проект находится под лицензией MIT и свободен для использования и модификации пользователями, что делает его идеальным для сотрудничества исследователей и разработчиков.

Список функций

- Эффективное интенсивное обучение: Поддерживает обучение и генерацию на одном контроллере, максимально используя GPU.

- полный ресурс с открытым исходным кодомМодель представляет собой простой и удобный в использовании инструмент, предоставляющий 57 тыс. единиц высококачественных обучающих данных, исходный код, настройки параметров и веса модели.

- Поддержка высокопроизводительных моделей: Основан на Qwen2.5-7B и Qwen2.5-32B, обеспечивая отличную производительность при проведении выводов.

- Гибкая система исследованийМодульная конструкция позволяет исследователям легко адаптировать и расширять свои эксперименты.

- Поддержка Docker: Предоставьте Dockerfile для обеспечения воспроизводимости учебной среды.

- Инструменты оценки эффективности: Содержит данные бенчмаркинга и презентации результатов оценки, такие как сравнение производительности GPQA Diamond.

Использование помощи

Процесс установки

Использование Open-Reasoner-Zero требует определенных технических знаний. Ниже представлено подробное руководство по установке и эксплуатации, подходящее для работы в Linux или Unix-подобных системах.

Подготовка к защите окружающей среды

- Установка основных зависимостей::

- Убедитесь, что в вашей системе установлены Git, Python 3.8+ и драйвер NVIDIA GPU (требуется поддержка CUDA).

- Установите Docker (рекомендуется версия 20.10 или выше) для быстрого развертывания учебной среды.

sudo apt update sudo apt install git python3-pip docker.io

- Клонирование хранилища проектов::

- Выполните следующую команду в терминале, чтобы загрузить проект локально:

git clone https://github.com/Open-Reasoner-Zero/Open-Reasoner-Zero.git cd Open-Reasoner-Zero - Настройка среды с помощью Docker::

- Проект предоставляет Dockerfile для облегчения создания учебных сред.

- Запустите его в корневом каталоге проекта:

docker build -t open-reasoner-zero -f docker/Dockerfile .- После завершения сборки запустите контейнер:

docker run -it --gpus all open-reasoner-zero bash- Это приведет к созданию контейнерного окружения с поддержкой GPU, предварительно установленного с необходимыми зависимостями.

- Установка зависимостей вручную (необязательно)::

- Если вы не используете Docker, вы можете установить зависимости вручную:

pip install -r requirements.txt- Убедитесь, что OpenRLHF, vLLM, DeepSpeed и Ray установлены, обратитесь к документации по проекту для получения информации о конкретных версиях.

Функции Поток операций

1. обучающие модели

- Подготовка данных для обучения::

- Проект поставляется с 57 тыс. высококачественных учебных данных, расположенных в

dataпапка. - Если требуются пользовательские данные, организуйте формат в соответствии с инструкциями документации и замените его.

- Проект поставляется с 57 тыс. высококачественных учебных данных, расположенных в

- обучение грунтовке::

- Выполните следующую команду в контейнере или локальном окружении:

python train.py --model Qwen2.5-7B --data-path ./data- Описание параметра:

--model: Выберите модель (например, Qwen2.5-7B или Qwen2.5-32B).--data-path: Указывает путь к обучающим данным.

- Журнал обучения отображается на терминале главного узла, что позволяет легко отслеживать прогресс.

2. Оценка эффективности

- Выполнение эталонных тестов::

- Сравните производительность модели с помощью прилагаемых сценариев оценки:

python evaluate.py --model Qwen2.5-32B --benchmark gpqa_diamond- В результате будет показана точность модели на эталонах, таких как GPQA Diamond.

- Просмотреть отчет об оценке::

- Проект включает графики (например, Рисунок 1 и Рисунок 2), показывающие масштабирование производительности и времени обучения, которые можно найти в

docsпапку, чтобы найти его.

- Проект включает графики (например, Рисунок 1 и Рисунок 2), показывающие масштабирование производительности и времени обучения, которые можно найти в

3. Модификации и расширения

- Параметры настройки::

- компилятор

config.yamlфайл, изменяя гиперпараметры, такие как скорость обучения, размер партии и т.д.

learning_rate: 0.0001 batch_size: 16 - компилятор

- Добавить новую функцию::

- Проект имеет модульную конструкцию и может быть

srcпапку для добавления новых модулей. Например, добавьте новый скрипт предварительной обработки данных:

# custom_preprocess.py def preprocess_data(input_file): # 自定义逻辑 pass - Проект имеет модульную конструкцию и может быть

Меры предосторожности при обращении

- требования к оборудованию: Для поддержки обучения Qwen2.5-32B рекомендуется использовать GPU с объемом видеопамяти не менее 24 ГБ (например, NVIDIA A100).

- Мониторинг журналов: Не выключайте терминал во время обучения и проверяйте журнал в любое время для устранения неполадок.

- Поддержка общества: Вопросы можно задавать через GitHub Issues или связавшись с командой по адресу hanqer@stepfun.com.

Практические примеры

Предположим, вы хотите обучить модель на основе Qwen2.5-7B:

- Введите контейнер Docker.

- быть в движении

python train.py --model Qwen2.5-7B --data-path ./data. - Подождите несколько часов (в зависимости от оборудования) и запустите по окончании.

python evaluate.py --model Qwen2.5-7B --benchmark gpqa_diamond. - Просмотрите выходные данные, чтобы убедиться в улучшении производительности.

Выполнив эти шаги, пользователи смогут быстро и эффективно приступить к работе с Open-Reasoner-Zero, будь то воспроизведение экспериментов или разработка новых функций.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...