Open-LLM-VTuber: Live2D-анимированный виртуальный компаньон ИИ для голосового взаимодействия в реальном времени

Последние ресурсы по искусственному интеллектуОпубликовано 12 месяцев назад Круг обмена ИИ 183.7K 00

Общее введение

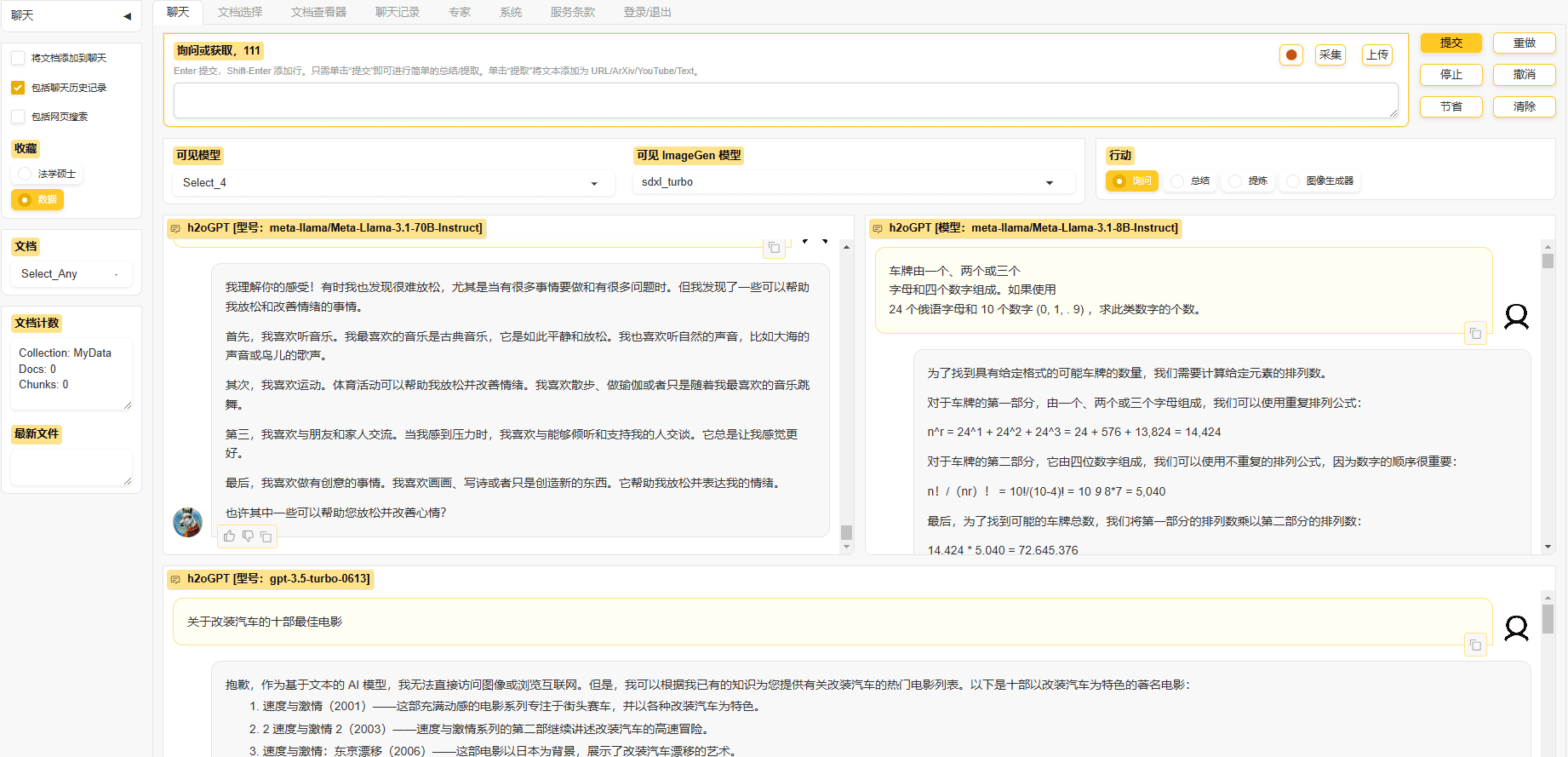

Open-LLM-VTuber - это проект с открытым исходным кодом, который позволяет пользователям взаимодействовать с большими языковыми моделями (LLM) через речь и текст, а также использует технологию Live2D для представления динамических виртуальных персонажей. Он поддерживает Windows, macOS и Linux, работает полностью в автономном режиме и имеет как веб-клиент, так и настольный клиент. Пользователи могут использовать его в качестве виртуальной подруги, домашнего питомца или настольного помощника, создавая персонального ИИ-компаньона, настраивая его внешность, характер и голос. Проект начинался как реплика виртуального якоря ИИ с закрытым исходным кодом "нейро-сама" и превратился в многофункциональную платформу, поддерживающую множество языковых моделей, распознавание речи, преобразование текста в речь и визуальное восприятие. Текущая версия была рефакторингована в v1.0.0 и находится в стадии активной разработки, а в будущем будут добавлены новые функции.

Список функций

- голосовое взаимодействие: Поддерживая голосовой диалог в режиме громкой связи, пользователи могут в любой момент прервать работу искусственного интеллекта для беспрепятственного общения.

- Live2D-анимация: Встроенные динамические аватары, которые генерируют выражения и действия на основе содержания диалога.

- Поддержка кросс-платформыСовместим с Windows, macOS и Linux, поддерживает работу с графическими процессорами NVIDIA/non-NVIDIA и CPU.

- автономная работа: Все функции могут работать без сети, что обеспечивает конфиденциальность и безопасность.

- Режим домашнего питомца на рабочем столе: Поддерживаются прозрачный фон, глобальный верх и проникновение мыши, а символы можно перетаскивать в любую позицию на экране.

- визуальное восприятие: Видеовзаимодействие с ИИ через распознавание содержимого камеры или экрана.

- Поддержка нескольких моделей: Совместим с широким спектром LLM, такими как Ollama, OpenAI, Claude, Mistral, и другими речевыми модулями, такими как sherpa-onnx и Whisper.

- Персонализация персонажей: Модели Live2D могут быть импортированы для настройки характера и голоса.

- тактильная обратная связь: Щелкните или перетащите персонажа, чтобы вызвать интерактивную реакцию.

- Ведение записей в чате: Поддержка переключения исторических диалогов с сохранением интерактивного контента.

Использование помощи

Процесс установки

Open-LLM-VTuber должен быть развернут локально, вот подробные шаги:

1. предварительные условия

- программное обеспечение: Поддержка компьютеров под управлением Windows, macOS или Linux с рекомендованными графическими процессорами NVIDIA (можно запускать без GPU).

- оборудование: Установите Git, Python 3.10+ и uv (рекомендуемый инструмент управления пакетами).

- ретикуляция: Для первоначального развертывания требуется подключение к Интернету для загрузки зависимости, поэтому китайским пользователям рекомендуется использовать прокси-ускорение.

2. Загрузка кода

- Клонируйте проект через терминал:

git clone https://github.com/Open-LLM-VTuber/Open-LLM-VTuber --recursive cd Open-LLM-VTuber

- Или загрузите последний ZIP-файл с GitHub Release и распакуйте его.

- Примечание: Если не используется

--recursiveТребуется для выполненияgit submodule update --initПолучите внешний субмодуль.

3. Установка зависимостей

- Установите uv:

- Windows (PowerShell):

irm https://astral.sh/uv/install.ps1 | iex - macOS/Linux:

curl -LsSf https://astral.sh/uv/install.sh | sh

- Windows (PowerShell):

- Запустите в каталоге проекта:

uv syncАвтоматически устанавливает FastAPI, onnxruntime и другие зависимости.

4. среда конфигурации

- При первом запуске создается файл конфигурации:

uv run run_server.py - Отредактируйте сгенерированный

conf.yamlНастройте следующие параметры:- LLM: Выберите модель (например. Оллама (для llama3 или OpenAI API необходимо заполнить ключ).

- ASR: Модуль распознавания речи (например, sherpa-onnx).

- TTS: Модули преобразования текста в речь (например, Edge TTS).

- Пример:

llm: provider: ollama model: llama3 asr: provider: sherpa-onnx tts: provider: edge-tts

5. активация услуг

- Бег:

uv run run_server.py - интервью

http://localhost:8000Используйте веб-версию или загрузите клиент для настольных компьютеров.

6. клиент для настольных компьютеров (необязательно)

- Загрузить с GitHub Release

open-llm-vtuber-electron(.exe для Windows, .dmg для macOS). - Запустите клиент и убедитесь, что внутренняя служба запущена, чтобы испытать режим домашних животных на рабочем столе.

7. обновление и деинсталляция

- обновление: после версии 1.0.0

uv run update.pyОбновления, более ранние версии должны быть развернуты с последней документацией. - деинсталляция: Удалите папку проекта, проверьте

MODELSCOPE_CACHEвозможноHF_HOMEфайлы моделей, удалите такие инструменты, как uv.

Функции Поток операций

голосовое взаимодействие

- Включить голос: Нажмите на значок "Микрофон" на веб-странице или в клиенте.

- диалоги: Говорите напрямую, и ИИ отвечает в реальном времени; нажмите кнопку "прервать", чтобы прервать ИИ.

- оптимизация: в

conf.yamlНастройте модули ASR и TTS, чтобы улучшить распознавание и произношение.

Персонализация персонажей

- Импортная модель: Поместите файл .moc3 в папку

frontend/live2d_modelsКаталог. - Корректировка личности:: Редакция

conf.yaml(используется в форме номинального выражения)promptКак "нежная старшая сестра". - Настройка звука: Записывайте сэмплы с помощью таких инструментов, как GPTSoVITS, чтобы генерировать уникальные голоса.

Режим домашнего питомца на рабочем столе

- Открытый режим: В клиенте выберите "Животные рабочего стола", отметьте "Прозрачный фон" и "Верх".

- движущееся изображение: Перетащите в любое место на экране.

- интерактивность: Нажмите на персонажа, чтобы вызвать тактильную обратную связь и просмотреть внутренний монолог или изменение выражения лица.

визуальное восприятие

- Активируйте камеру: Нажмите на "Видеочат", чтобы разрешить доступ.

- распознавание на экране: Выберите "Screen Sense" для искусственного интеллекта, анализирующего содержимое экрана.

- типичный примерСпросите "что на экране", и ИИ опишет изображение.

предостережение

- браузер (программное обеспечение)Рекомендуется использовать браузер Chrome, другие браузеры могут влиять на отображение Live2D.

- спектаклиУскорение на GPU требует правильно настроенных драйверов и может работать медленнее на CPU.

- лицензия: Встроенная модель образца Live2D подлежит отдельной лицензии, для коммерческого использования обращайтесь в Live2D Inc.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие посты

Нет комментариев...