Руководство по установке и использованию Ollama

Ранее выходило много выпусков, посвященных Оллама Информация в руководствах по установке и развертыванию довольно разрозненна, поэтому в этот раз мы собрали полное одношаговое руководство по использованию Ollama на локальном компьютере. Это руководство предназначено для новичков, чтобы избежать подводных камней при использовании Ollama, а для тех, кто в состоянии это сделать, мы рекомендуем прочитать официальную документацию Ollama. Далее я представлю пошаговое руководство по установке и использованию Ollama.

Почему стоит выбрать Ollama для локальной установки больших моделей

Многие новички, как и я, не понимают, что для развертывания больших моделей в сети есть и другие, более эффективные инструменты, например:Инвентаризация LLM-фреймворков, подобных Ollama: несколько вариантов для локального развертывания больших моделей Почему вы рекомендуете устанавливать Ollama в конце?

Прежде всего, конечно, она легко устанавливается на персональные компьютеры, но один из самых важных моментов заключается в том, что производительность модели при автономном развертывании лучше оптимизирована по параметрам, а сама установка не подвержена ошибкам. Например, при установке на компьютер той же конфигурации QwQ-32B Используйте Ollama для возможной плавности использования, измените на "более мощный". llama.cpp Он может застрять и даже вывести неправильный ответ. Этому есть много причин, и я не могу объяснить их ясно, поэтому не буду, просто знайте, что Ollama содержит llama.cpp в самом низу, и из-за лучшей оптимизации она работает стабильнее, чем llama.cpp.

Какие большие файлы моделей может обрабатывать Ollama?

Ollama поддерживает файлы моделей в следующих двух форматах с различными механизмами вывода:

- Формат GGUF: через

llama.cppРассуждения. - формат safetensors: через

vllmРассуждения.

Это значит:

- Если используется модель в формате GGUF, Ollama вызовет программу

llama.cppВыполняйте эффективные выводы на CPU/GPU. - Если используется модель в формате safetensors, Ollama использует

vllmПомимо графических процессоров, на них часто полагаются для высокопроизводительных выводов.

Конечно, вам не нужно заботиться об этом, просто знайте, что большинство файлов, которые вы устанавливаете, имеют формат GGUF. Почему вы подчеркиваете GGUF?

Поддержка GGUF Количественные (например, Q4, Q6_K)СпособностьПоддерживает высокую производительность вычислений при очень низких затратах графики и памятиХотя безопасные датчики обычно являются полноценными моделями FP16/FP32, они гораздо больше и занимают больше ресурсов. Подробнее об этом можно узнать здесь:Что такое квантование моделей: объяснение типов данных FP32, FP16, INT8, INT4.

Минимальные требования к конфигурации Ollama

Операционная система: Linux: Ubuntu 18.04 или более поздняя версия, macOS: macOS 11 Big Sur или более поздняя версия.

ОПЕРАТИВНАЯ ПАМЯТЬ: 8 ГБ для работы с моделями 3B, 16 ГБ для работы с моделями 7B, 32 ГБ для работы с моделями 13B

Дисковое пространство: 12 Гб для установки Ollama и базовой модели, дополнительное пространство, необходимое для хранения данных модели, зависит от используемой модели. 6 Гб пространства рекомендуется зарезервировать на диске C.

ПРОЦЕССОР: Рекомендуется использовать любой современный процессор с не менее чем 4 ядрами, а для работы модели 13B - процессор с не менее чем 8 ядрами.

Графический процессор (опционально): Для работы Ollama не нужен GPU, но он может повысить производительность, особенно при работе с большими моделями. Если у вас есть GPU, вы можете использовать его для ускорения обучения пользовательских моделей.

Установите Ollama

Перейти на сайт: https://ollama.com/download

Просто выберите в соответствии с окружением компьютера, установка очень проста, единственное, на что следует обратить внимание, это то, что сетевое окружение может привести к невозможности правильной установки.

Установка macOS: https://ollama.com/download/Ollama-darwin.zip

Установка Windows: https://ollama.com/download/OllamaSetup.exe

Установка Linux:curl -fsSL https://ollama.com/install.sh | sh

Образ Docker: (пожалуйста, изучите самостоятельно на официальном сайте)

Процессор или графический процессор Nvidia:docker pull ollama/ollama

Графические процессоры AMD:docker pull ollama/ollama:rocm

После завершения установки вы увидите значок Ollama в правом нижнем углу рабочего стола. Если на значке есть зеленый сигнал, это означает, что вам нужно обновиться.

Настройка Олламы

Ollama очень легко устанавливается, но большинство настроек требуют изменения "переменных окружения", что очень недружелюбно для новичков, я перечисляю все переменные для тех, кому нужно обратиться к ним (не нужно запоминать):

| параметры | Маркировка и конфигурация |

|---|---|

| OLLAMA_MODELS | Указывает каталог, в котором хранятся файлы модели, по умолчанию это каталогТекущий каталог пользователяпредположить (офис) C:\Users%username%.ollama\modelsСистема Windows Не рекомендуется размещать его на диске C.Диски можно помещать на другие диски (например. E:\ollama\models) |

| OLLAMA_HOST | сетевой адрес, по которому прослушивается служба ollama, по умолчанию -127.0.0.1 Если вы хотите разрешить другим компьютерам доступ к Ollama (например, другим компьютерам в локальной сети), то в менюРекомендуемые настройкибыть в порядке 0.0.0.0 |

| ОЛЛАМА_ПОРТ | Указывает порт по умолчанию, на котором прослушивается служба ollama, который по умолчанию равен11434 Если существует конфликт портов, вы можете изменить настройки на другие порты (например.8080и т.д.) |

| OLLAMA_ORIGINS | Указывает источник запроса HTTP-клиента, используя список полуколонок, разделенных запятыми. Если локальное использование не ограничено, можно установить звездочку * |

| OLLAMA_KEEP_ALIVE | Указывает время выживания большой модели после ее загрузки в память, по умолчанию -5mЭто 5 минут. (например, простое число 300 означает 300 секунд, 0 означает, что модель будет удалена, как только будет обработан ответ на запрос, а любое отрицательное число означает, что она была сохранена) Рекомендуется установить 24h Модель остается в памяти в течение 24 часов, что повышает скорость доступа. |

| OLLAMA_NUM_PARALLEL | Указывает количество одновременно обрабатываемых запросов, по умолчанию -1 (т.е. одновременная последовательная обработка запросов) Рекомендации корректируются в соответствии с реальными потребностями |

| OLLAMA_MAX_QUEUE | Указывает длину очереди запросов, значение по умолчанию -512 Рекомендуется подстраиваться под реальные потребности, запросы, превышающие длину очереди, будут отклонены |

| OLLAMA_DEBUG | обозначает вывод журнала отладки, который может быть установлен на этапе разработки приложения на1 (например, вывод подробной информации из журнала для поиска и устранения неисправностей) |

| OLLAMA_MAX_LOADED_MODELS | Указывает максимальное количество моделей, загружаемых в память одновременно, по умолчанию1 (т.е. в памяти может находиться только 1 модель) |

1. изменение каталога загрузки больших файлов моделей

В системах Windows файлы моделей, загружаемые Ollama, по умолчанию хранятся в определенном каталоге в папке пользователя. В частности, по умолчанию обычно используется путьC:\Users\<用户名>\.ollama\models. Вот.<用户名>обозначает текущее имя пользователя для входа в систему Windows.

Например, если имя пользователя для входа в системуyangfan, то путь хранения файла модели по умолчанию может быть следующимC:\Users\yangfan\.ollama\models\manifests\registry.ollama.ai. В этой директории пользователи могут найти все файлы моделей, загруженные через Ollama.

Примечание: Пути установки новых систем, как правило, совпадают:C:\Users\<用户名>\AppData\Local\Programs\Ollama

Объем загружаемых моделей может составлять несколько гигабайт, поэтому, если на диске C мало места, первым делом измените каталог загрузки больших файлов моделей.

1. Найдите точку входа для переменных окружения

Самый простой способ: Win+R, чтобы открыть окно "Выполнить", введите sysdm.cplЕсли вы хотите использовать эту опцию, откройте "Свойства системы", выберите вкладку "Дополнительно" и щелкните на "Переменные среды".

Другие методы:

1. Пуск->Настройки->Общие->Дополнительные системные настройки->Свойства системы->Переменные окружения.

2. Этот компьютер -> Правый щелчок -> Свойства -> Дополнительные параметры системы -> Переменные среды.

3. Пуск->Панель управления->Система и безопасность->Система->Дополнительные параметры системы->Свойства системы->Переменные окружения.

4. Окно поиска в нижней части рабочего стола->Ввод->Переменные окружения

После ввода вы увидите следующий экран:

2. Изменение переменных окружения

Найдите переменную OLLAMA_MODELS в разделе Системные переменные, если ее там нет, нажмите кнопку Создать.

Если OLLAMA_MODELS уже существует, выделите ее и дважды щелкните левой кнопкой мыши, или выделите ее и нажмите "Изменить".

Значение переменной изменяется на новый каталог, здесь я переместил его с диска C на диск E, где больше места на диске.

После сохранения рекомендуется запустить компьютер с новой загрузки и использовать его снова для более надежного результата.

2. Измените адрес и порт доступа по умолчанию.

В браузере введите URL: http://127.0.0.1:11434/ , вы увидите следующее сообщение, указывающее на то, что он запущен, вот некоторые риски безопасности, которые необходимо изменить, еще в переменных окружения.

1.Изменить OLLAMA_HOST

Если нет, добавьте новый, если это 0.0.0.0, чтобы разрешить доступ к экстрасети, измените его на 127.0.0.1.

2.Изменить OLLAMA_PORT

Если у вас его нет, добавьте его и измените 11434 на любой порт, например:11331(Диапазон изменения портов - от 1 до 65535), во избежание конфликта портов начните с 1000. Обратите внимание, что используется английское ":".

Не забудьте перезагрузить компьютер, чтобы получить рекомендации по безопасности Ollama:DeepSeek поджигает Олламу, безопасно ли ваше локальное развертывание? Опасайтесь "украденной" арифметики!

Установка больших моделей

Перейти на URL: https://ollama.com/search

Выбор модели, выбор размера модели, команда копирования

Доступ к инструментам командной строки

Вставьте команду для автоматической установки

Он загружается здесь, так что если он медленный, подумайте о том, чтобы переключиться на более счастливую среду Интернета!

Если вы хотите скачать большие модели, которые Ollama не предлагает, вы, конечно, можете это сделать, подавляющее большинство из них - файлы GGUF на huggingface, и я взял специальную квантизированную версию DeepSeek-R1 В качестве примера для демонстрации установки используется 32B.

1. Установка базового формата команд количественной модели версионирования huggingface

Запомните следующий формат команд установки

ollama run hf.co/{username}:{reponame}

2. Выбор количественной версии

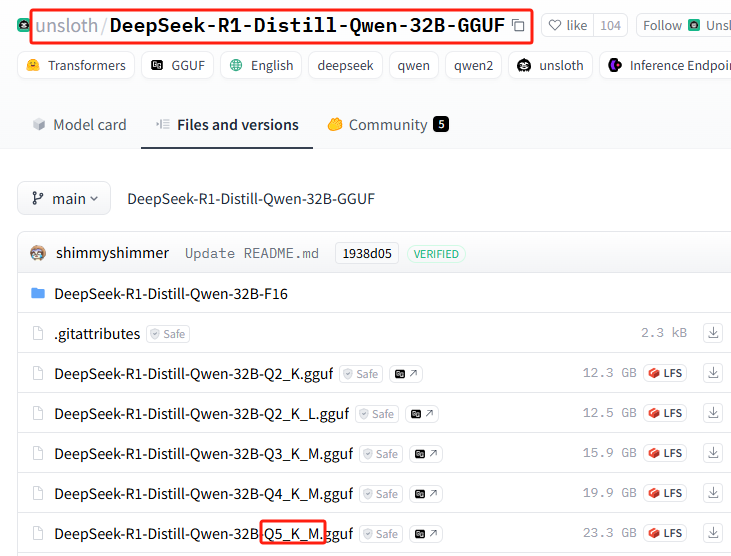

Список всех количественных версий: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

В этой установке используется: Q5_K_M

3. Команда установки сплитов

{имя пользователя}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

Соедините их вместе, чтобы получить полную команду установки:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

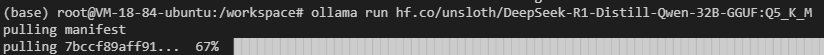

4. Выполните установку в Ollama

Выполните команду установки

У вас могут возникнуть сбои в сети (удачи вам), повторите команду установки еще несколько раз...

Все еще не работает? Попробуйте выполнить следующую команду.hf.co/Изменить раздел следующим образомhttps://hf-mirror.com/(переключение на внутренний адрес зеркала), окончательный вариант команды установки выглядит следующим образом:

ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

Полное руководство по этому разделу доступно:Частное развертывание без локальных графических процессоров DeepSeek-R1 32B

Основные команды Ollama

| команда | описания |

|---|---|

ollama serve | Запуск Олламы |

ollama create | Создание моделей из файла Modelfile |

ollama show | Отображение информации о модели |

ollama run | операционная модель |

ollama stop | Остановка работающей модели |

ollama pull | Извлечение моделей из реестра |

ollama push | Передача моделей в реестр |

ollama list | Список всех моделей |

ollama ps | Список ходовых моделей |

ollama cp | Модели репликации |

ollama rm | Удалить модель |

ollama help | Отображение справочной информации для любой команды |

| символизирует | описания |

|---|---|

-h, --help | Показать справочную информацию для Ollama |

-v, --version | Отображение информации о версии |

При вводе команд в нескольких строках можно использовать """ Выполните перевод строки.

пользоваться """ Конечная подача строки.

Чтобы завершить работу службы вывода моделей Ollama, вы можете воспользоваться командой /bye.

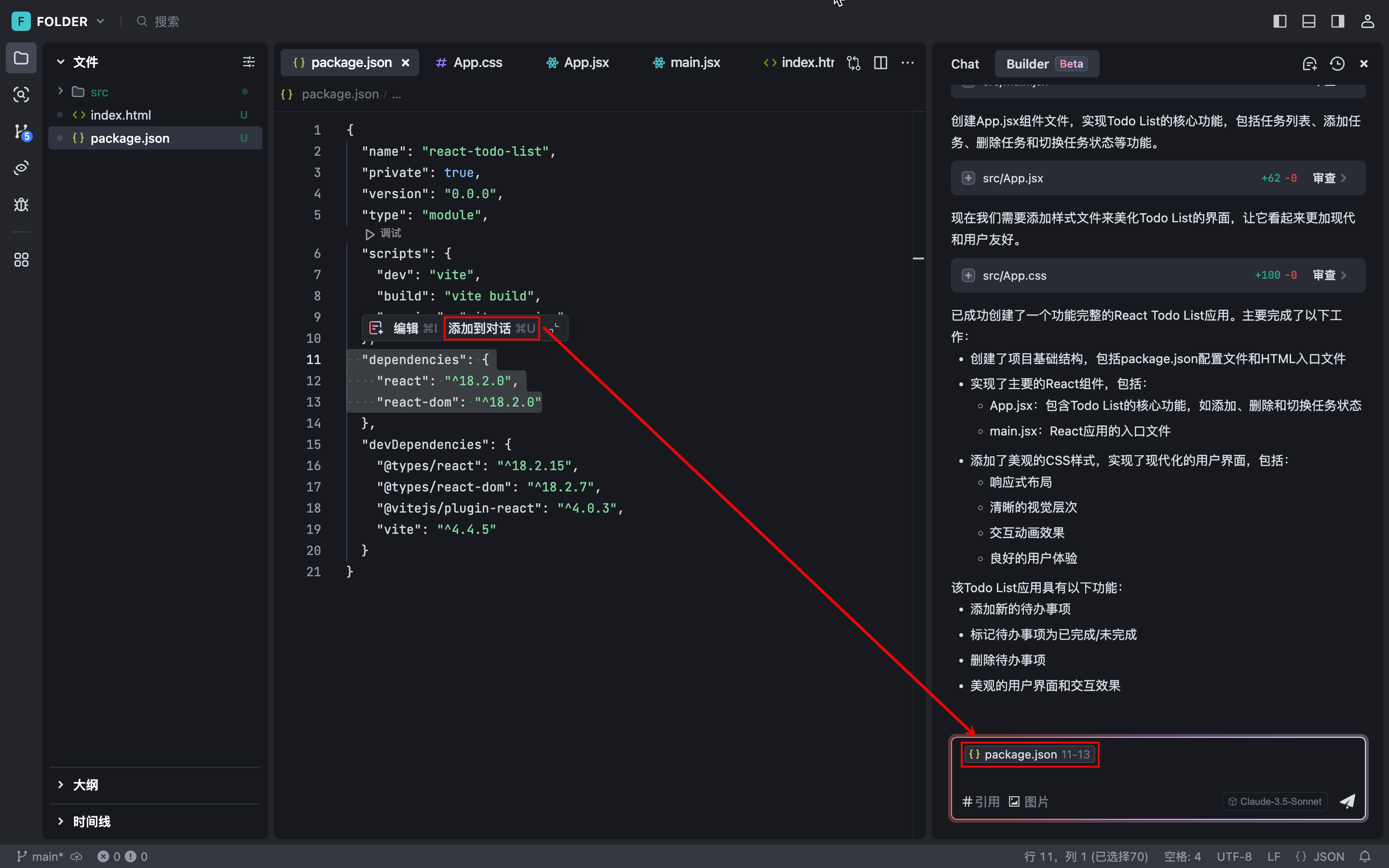

Использование Ollama в собственном диалоговом инструменте ИИ

Большинство основных отечественных инструментов для ведения диалога с искусственным интеллектом уже адаптированы к Ollama по умолчанию и не требуют никаких настроек. Например Помощник страницы OpenwebUI.

Однако некоторые инструменты локального ИИ-диалога требуют, чтобы вы сами ввели адрес API.http://127.0.0.1:11434/: (обратите внимание, если порт изменен)

Некоторые веб-инструменты для ведения диалога ИИ, безусловно, поддерживают конфигурацию, например СледующийЧат :

Если вы хотите, чтобы Ollama, запущенная на вашем локальном компьютере, была полностью открыта для внешнего использования, изучите cpolar или ngrok самостоятельно, что выходит за рамки использования для новичков.

Статья кажется очень длинной, на самом деле, внутри 4 очень простых пунктов знаний, узнать будущее использование Ollama в основном беспрепятственно, давайте рассмотрим еще раз:

1. Установка переменных окружения

2. Два способа установки большой модели

3. запомните основные команды запуска и удаления модели

4. использование в различных клиентах

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...