Ollama+LangGraph Локально развернутый помощник для создания отчетов об академических исследованиях

Общее введение

Оллама Deep Researcher - это полностью нативный помощник для веб-исследований и создания отчетов, разработанный командой LangChain. Он использует произвольную большую языковую модель (LLM), размещенную в Ollama, чтобы позволить пользователям ввести тему исследования, а затем автоматически генерировать поисковые запросы, собирать информацию, обобщать контент и генерировать отчеты в формате Markdown с источниками. Весь процесс происходит без необходимости подключения к Интернету для вызова внешней модели, что обеспечивает защиту конфиденциальности и не требует дополнительных затрат. Поддерживаются DuckDuckGo, Tavily или Недоумение и другие инструменты поиска, пользователь может настроить количество циклов исследования, что подходит для пользователей, которым нужны глубокие исследования и создание структурированных отчетов. Простота установки, открытый исходный код и бесплатность.

Список функций

- локальная оперативная языковая модель (LOLM): Используйте родной LLM через Ollama без внешних API.

- Автоматическое создание поисковых запросов: Генерирование точных поисковых запросов на основе пользовательских тем.

- Коллекция веб-информации: Поддерживает поиск DuckDuckGo (по умолчанию), Tavily или Perplexity.

- Обобщение и оптимизация контента: Анализ результатов поиска, выявление недостатков и улучшение резюме.

- Создание отчетов в формате уценки: Выходной структурированный отчет со всеми ссылками на источники.

- Индивидуальный подход к глубине исследования: Пользователь может задать количество циклов и контролировать уровень детализации исследования.

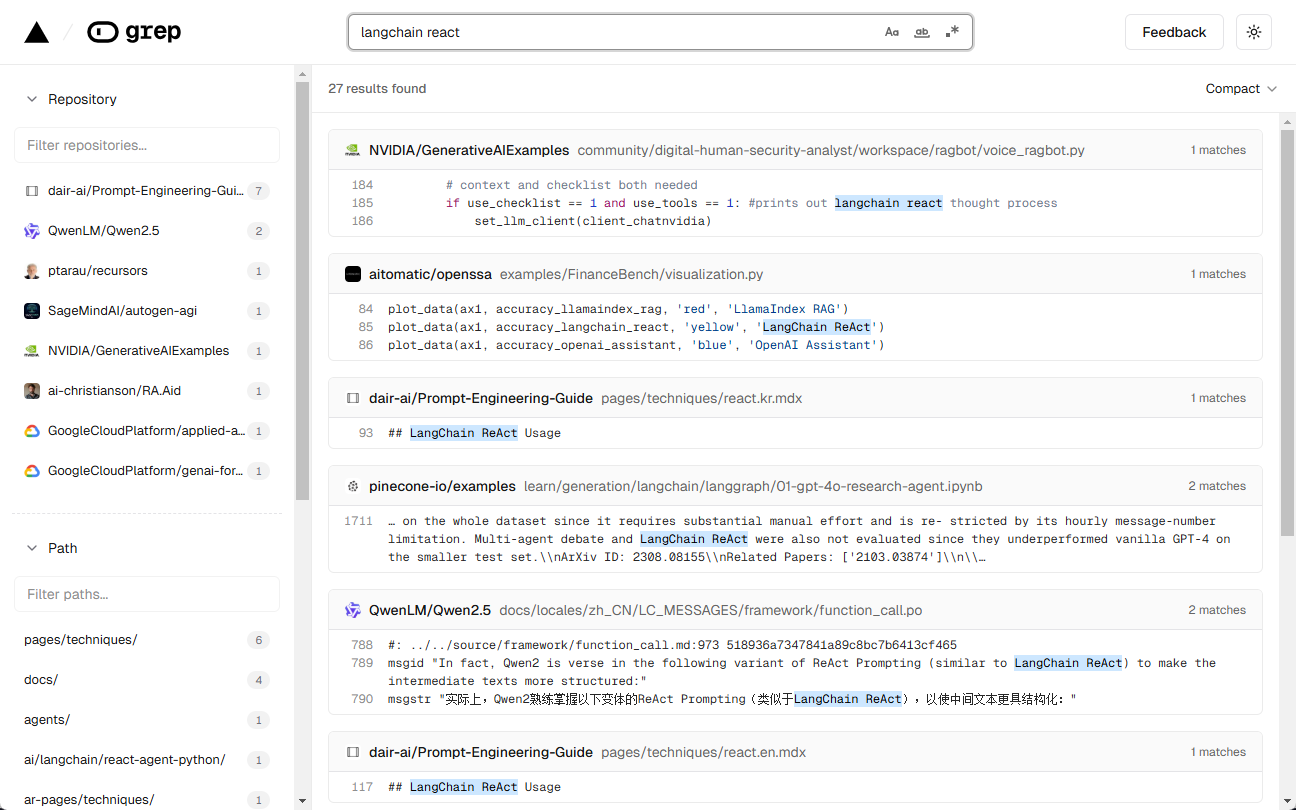

- Визуализация рабочих процессов: через LangGraph Studio Просматривайте каждый шаг операции.

- Поддержка нескольких моделейСовместимость DeepSeek R1, Llama 3.2 и другие модели.

Использование помощи

Процесс установки

Ollama Deep Researcher требует поддержки локального окружения. Ниже приведены подробные шаги для пользователей Mac и Windows.

Пользователи Mac

- Установите Ollama

- Посетите веб-сайт Ollama, чтобы загрузить версию программы установки для Mac.

- После установки запустите терминал

ollama --versionПроверьте версию.

- модель тяги

- Введите его в терминал:

ollama pull deepseek-r1:8bСкачать Рекомендуемые модели. - Также в наличии

ollama pull llama3.2.

- Введите его в терминал:

- проект клонирования

- Выполните следующую команду:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- Выполните следующую команду:

- Создание виртуальной среды (рекомендуется)

- Убедитесь, что установлен Python 3.9+. Запустите его:

python -m venv .venv source .venv/bin/activate

- Убедитесь, что установлен Python 3.9+. Запустите его:

- Установите зависимости и запустите

- Вход:

curl -LsSf https://astral.sh/uv/install.sh | sh uvx --refresh --from "langgraph-cli[inmem]" --with-editable . --python 3.11 langgraph dev - При запуске браузера открывается LangGraph Studio (по умолчанию).

http://127.0.0.1:2024).

- Вход:

Пользователь Windows

- Установите Ollama

- Загрузите версию для Windows с сайта Ollama.

- После установки в командной строке запускается

ollama --versionВалидация.

- модель тяги

- Вход:

ollama pull deepseek-r1:8b.

- Вход:

- проект клонирования

- Бег:

git clone https://github.com/langchain-ai/ollama-deep-researcher.git cd ollama-deep-researcher

- Бег:

- Создание виртуальной среды

- Установите Python 3.11 (установив флажок "Добавить в PATH") и запустите его:

python -m venv .venv .venv\Scripts\Activate.ps1

- Установите Python 3.11 (установив флажок "Добавить в PATH") и запустите его:

- Установите зависимости и запустите

- Вход:

pip install -e . pip install -U "langgraph-cli[inmem]" langgraph dev - доступ после запуска

http://127.0.0.1:2024.

- Вход:

Инструмент поиска конфигурации (опционально)

- DuckDuckGo используется по умолчанию, и ключ API не требуется.

- если Tavily или недоумение:

- сделать копию

.env.exampleиз-за.env. - компилятор

.envДобавьте ключ:TAVILY_API_KEY=your_tavily_key PERPLEXITY_API_KEY=your_perplexity_key - Дополнительная конфигурация:

OLLAMA_BASE_URL(По умолчанию)http://localhost:11434).MAX_WEB_RESEARCH_LOOPS(по умолчанию 3).

- сделать копию

Как использовать

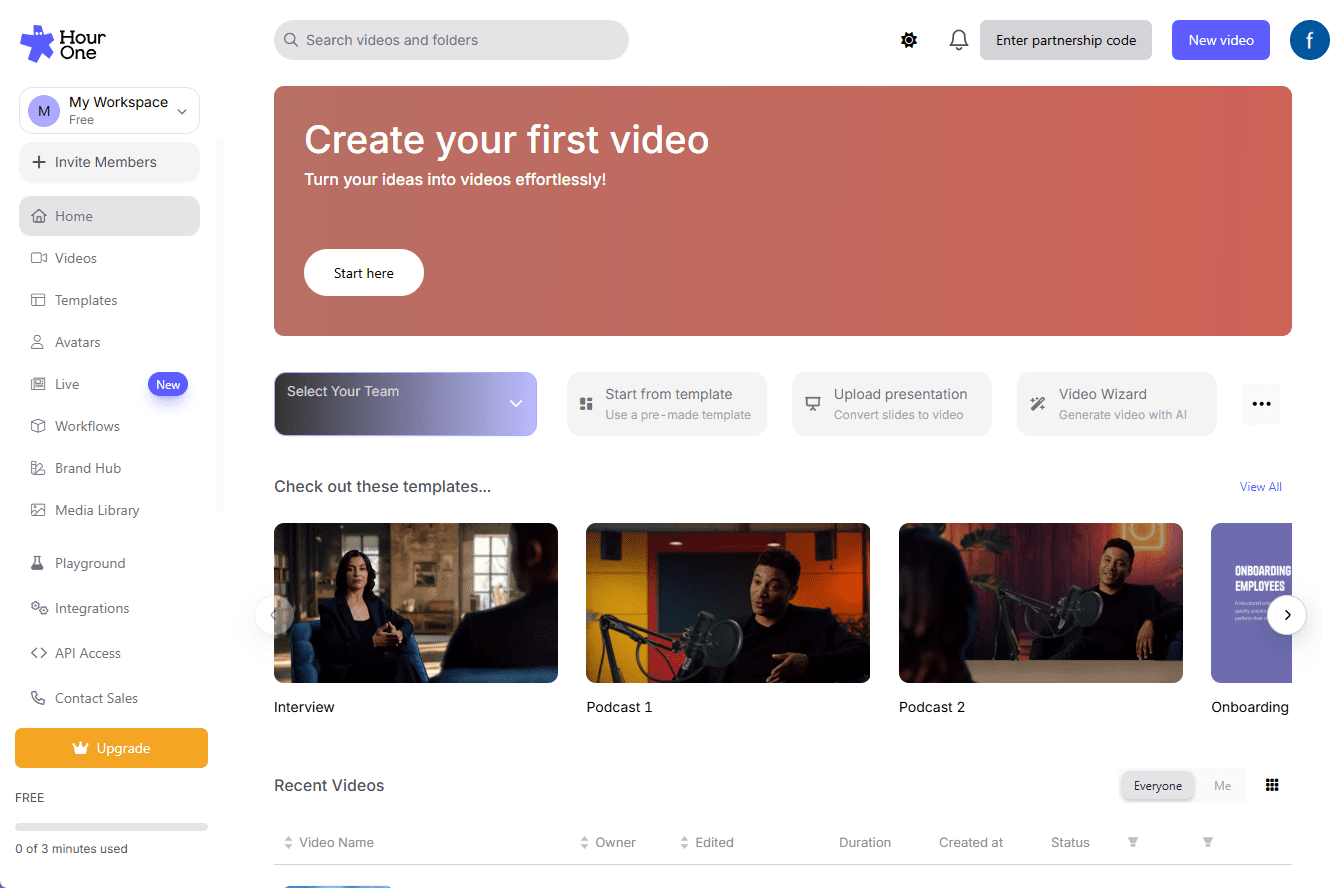

- Откройте LangGraph Studio

- После запуска службы зайдите в

http://127.0.0.1:2024. - Интерфейс разделен на левую и правую колонки: слева - конфигурация, справа - ввод и результаты.

- После запуска службы зайдите в

- Параметры конфигурации

- Инструменты поиска: Выберите один из вариантов: DuckDuckGo, Tavily или Perplexity.

- моделирование: Введите имя загруженной модели (например.

deepseek-r1:8b). - Количество циклов: Установите глубину изучения, по умолчанию 3 раза.

- Сохраните конфигурацию.

- Введите тему

- Введите тему исследования, например "Будущее машинного обучения", в поле ввода справа.

- Нажмите "Запустить", чтобы начать исследование.

- Просмотр процесса и результатов

- Studio отображает каждый этап: создание запросов, поиск, сводки и так далее.

- После завершения работы отчет в формате Markdown сохраняется в папке проекта в состоянии "Граф".

Функциональное управление

- Регулирование глубины исследования

- Изменение конфигурации

MAX_WEB_RESEARCH_LOOPSЕсли установить число раз равным 5, результаты будут более полными, но потребуют больше времени.

- Изменение конфигурации

- Переключить инструмент поиска

- DuckDuckGo Бесплатный, но с ограниченными результатами, Tavily Более подробный (требуется ключ). Перезапустите сервис после переключения.

- Проверка совместимости моделей

- Если сообщается об ошибке (например.

KeyError: 'query'), что указывает на то, что модель не поддерживает вывод JSON. Переключение на DeepSeek R1 (8B) или Llama 3.2.

- Если сообщается об ошибке (например.

предостережение

- требования к оборудованиюДля модели 8B требуется 8 ГБ памяти, а для модели 13B - 16 ГБ.

- Совместимость с браузерамиРекомендуется использовать Firefox, в Safari могут быть предупреждения о безопасности.

- обнаружение ошибок: Если вы застряли, проверьте журналы терминала, возможно, вам нужно обновить зависимости или изменить модели.

сценарий применения

- научные исследования

- Описание сценыСтуденты набирают "методы нейросетевой оптимизации", и инструмент выполняет поиск и генерирует отчет с цитатами, экономя время на поиск информации.

- Анализ отрасли

- Описание сценыAI Market Trends to 2025" - инструмент, предоставляющий подробную сводку для принятия решений.

- Техническое обучение

- Описание сценыРазработчики вводят "Асинхронное программирование на Python", и инструмент генерирует обучающий отчет для самостоятельного изучения.

QA

- Нужно ли мне работать в сети?

- Локальная модель не требует подключения к Интернету, но для поиска в сети оно необходимо. В автономном режиме можно использовать только существующие данные.

- Поддерживает ли он китайский язык?

- Поддержка. При вводе китайских тем инструмент выдает результаты на китайском языке, но эффект зависит от инструмента поиска.

- Можно ли внести поправки в отчет?

- Файлы в формате Markdown можно редактировать напрямую.

- Что делать, если возникла ошибка JSON?

- Это означает, что модель не поддерживает структурированный вывод. Повторите попытку с помощью DeepSeek R1 (8B) или Llama 3.2.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...