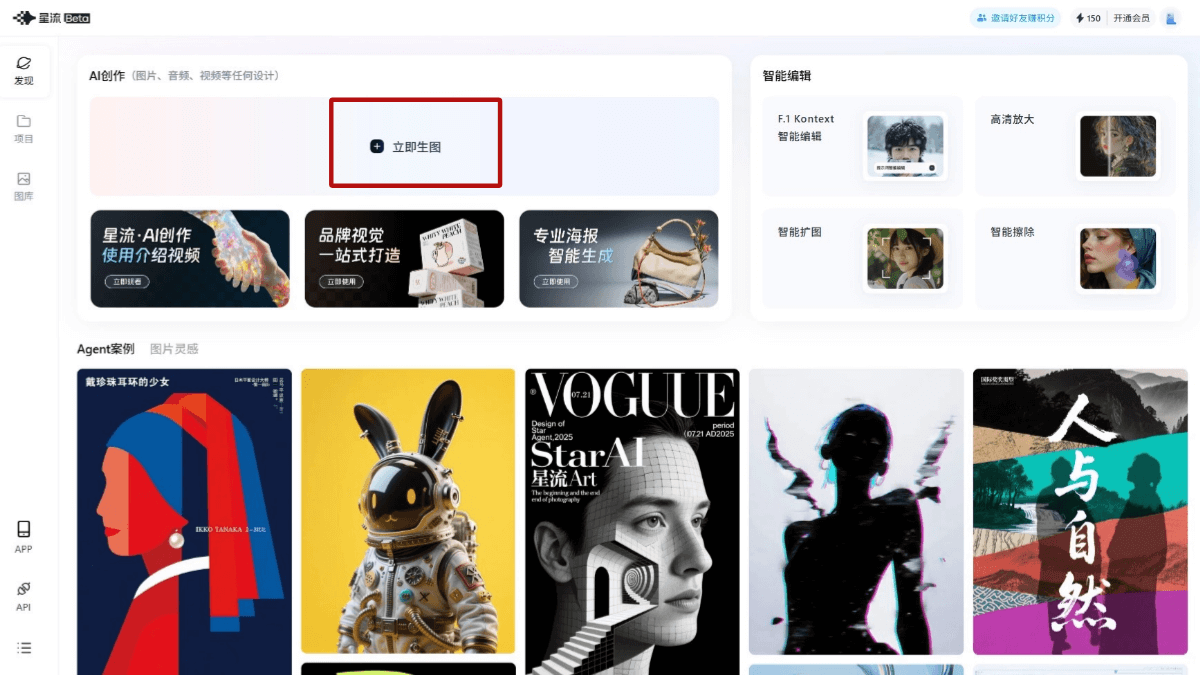

MOFA Video: технология адаптации поля движения преобразует неподвижные изображения в видео

Общее введение

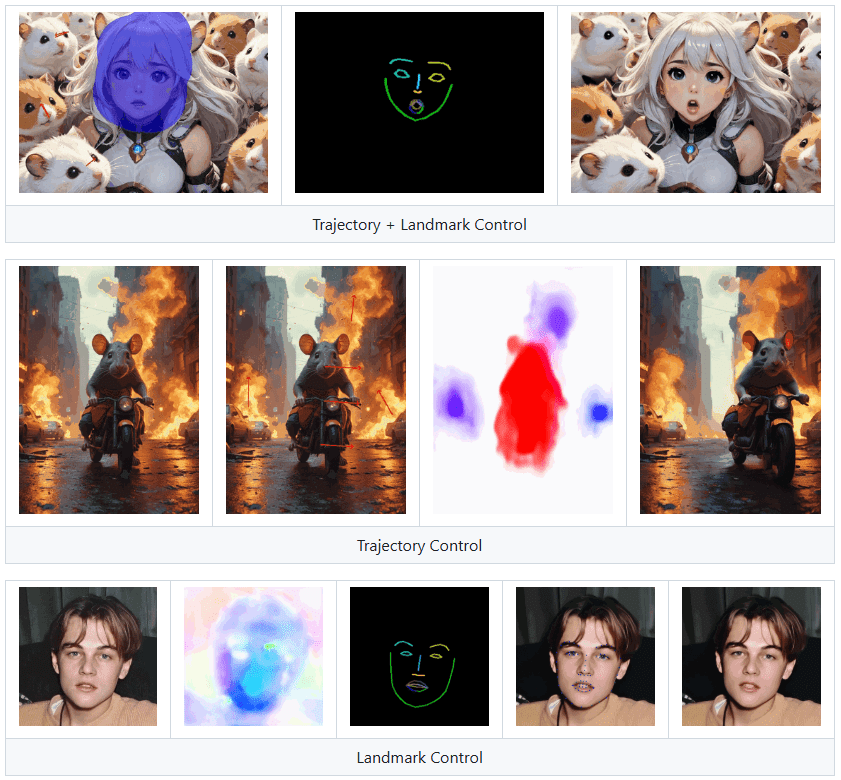

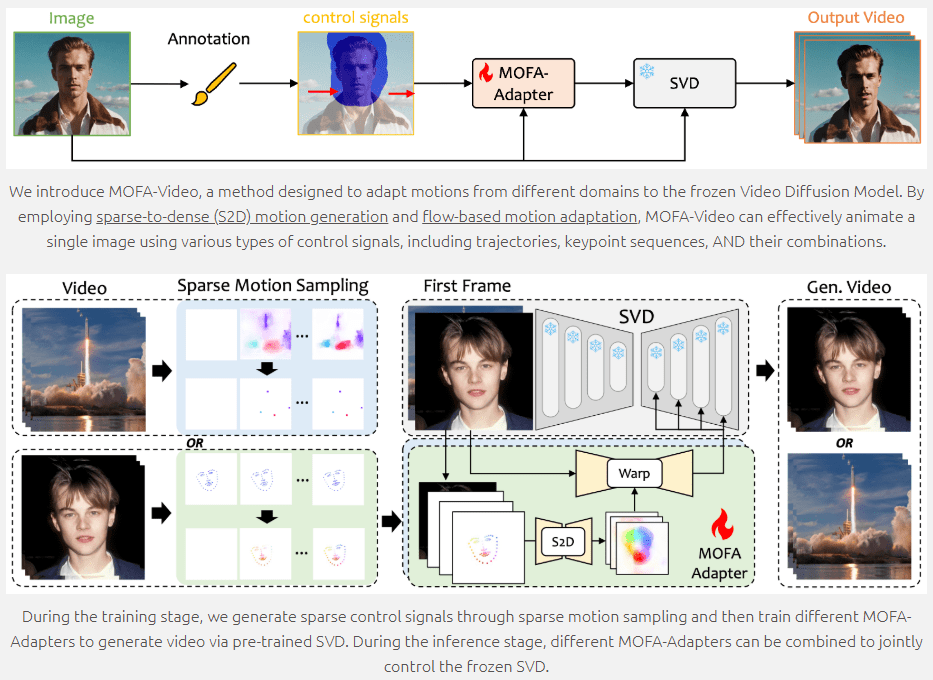

MOFA-Video - это современный инструмент для создания анимации изображений, который использует генеративные методы адаптации поля движения для преобразования статичных изображений в динамичное видео. Разработанный в сотрудничестве с Токийским университетом и Tencent AI Lab и представленный на ECCV 2024, MOFA-Video поддерживает различные управляющие сигналы, включая траектории, последовательности ключевых точек и их комбинации, обеспечивая высококачественную анимацию изображений. Пользователи могут получить доступ к коду и сопутствующим ресурсам через репозиторий GitHub, чтобы легко начать работу.

Landmark Control может заставить людей на изображениях говорить, но не подходит для использования в качестве клона цифрового человека.

Список функций

- Генерация анимации: преобразование неподвижных изображений в движущееся видео

- Множественные управляющие сигналы: траектории опор, последовательности ключевых точек и их комбинации

- Адаптация поля движения: анимация с помощью перехода от разреженного к плотному движению и адаптации движения на основе потока

- Скрипты обучения и вывода: предоставление полного кода для обучения и вывода

- Демонстрация Gradio: онлайн-демонстрация и загрузка контрольной точки

- Открытый исходный код: публичный доступ к коду и ресурсам на GitHub

Использование помощи

Параметры окружающей среды

- склад клонов

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

- Создание и активация среды Conda

conda create -n mofa python==3.10

conda activate mofa

- Установка зависимостей

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

- Загрузка контрольных точек Загрузите контрольные точки из репозитория HuggingFace и поместите их в

./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpointsКаталог.

Демо-версия с Gradio

- Использование звука для анимации лица

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

- Анимация лица с помощью справочного видео

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

Интерфейс Gradio отобразит соответствующие инструкции, поэтому следуйте указаниям интерфейса для выполнения операции обоснования.

Обучение и рассуждения

MOFA-Video предоставляет полные скрипты обучения и вывода, которые можно настроить по своему усмотрению. За подробными инструкциями обращайтесь к файлу README в репозитории GitHub.

Основные функции

- Генерация анимации: загрузите статичное изображение, выберите управляющие сигналы (траекторию, последовательность ключевых точек или их комбинацию) и нажмите кнопку Generate, чтобы сгенерировать динамическое видео.

- Несколько сигналов управления: пользователи могут выбирать различные комбинации сигналов управления для достижения более богатых анимационных эффектов.

- Адаптация поля движения: Обеспечьте плавность и естественность анимационных эффектов с помощью технологий генерации движений от разреженных до плотных и адаптации движений на основе потока.

MOFA-Video предоставляет богатый функционал и подробные инструкции, позволяющие пользователям создавать анимацию изображений и настраивать обучение в соответствии со своими потребностями, а также легко добиваться высококачественных эффектов анимации изображений.

© заявление об авторских правах

Авторское право на статью Круг обмена ИИ Пожалуйста, не воспроизводите без разрешения.

Похожие статьи

Нет комментариев...